NVIDIA представила самый мощный чип в мире — Blackwell B200, который откроет путь к гигантским нейросетям

Компания Nvidia в рамках конференции GTC 2024 представила ИИ-ускорители следующего поколения на графических процессорах с архитектурой Blackwell. По словам производителя, грядущие ИИ-ускорители позволят создавать ещё более крупные нейросети, в том числе работать с большими языковыми моделями (LLM) с триллионами параметров, и при этом будут до 25 раз энергоэффективнее и экономичнее в сравнении с Hopper.

Источник изображений: Nvidia

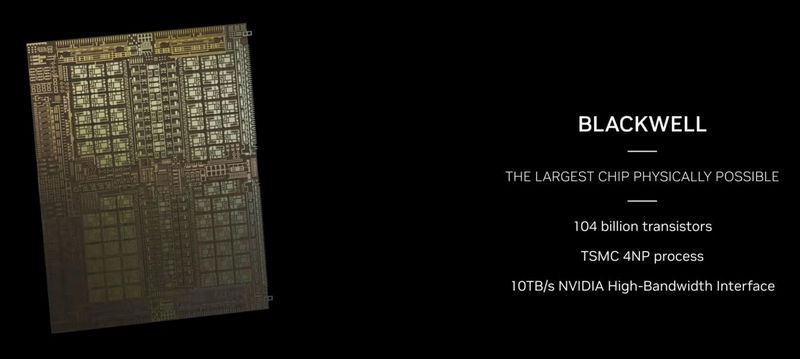

Архитектура GPU Blackwell получила название в честь американского математика Дэвида Блэквелла (David Harold Blackwell) и включает в себя целый ряд инновационных технологий для ускорения вычислений, которые помогут совершить прорыв в обработке данных, инженерном моделировании, автоматизации проектирования электроники, компьютерном проектировании лекарств, квантовых вычислениях и генеративном ИИ. Причём на последнем в Nvidia делают особый акцент: «Генеративный ИИ — это определяющая технология нашего времени. Графические процессоры Blackwell — это двигатель для новой промышленной революции», — подчеркнул глава Nvidia Дженсен Хуанг (Jensen Huang) в рамках презентации.

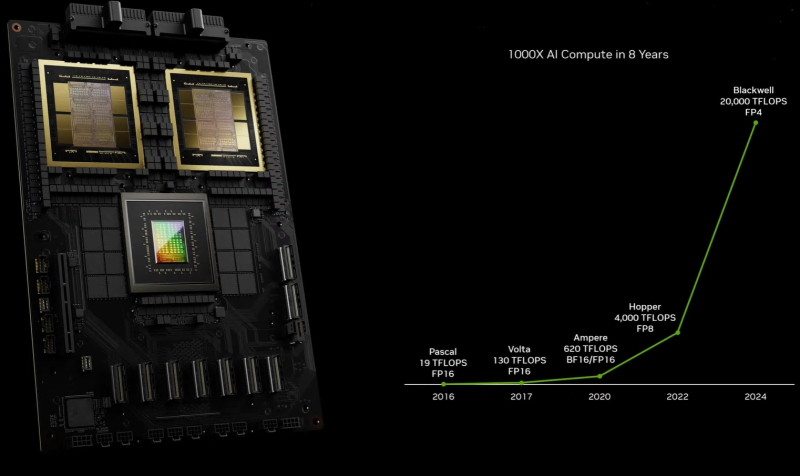

Графический процессор Nvidia B200 производитель без лишней скромности называет самым мощным чипом в мире. В вычислениях FP4 и FP8 новый GPU обеспечивает производительность до 20 и 10 Пфлопс соответственно. Новый GPU состоит из двух кристаллов, которые произведены по специальной версии 4-нм техпроцесса TSMC 4NP и объединены 2,5D-упаковкой CoWoS-L. Это первый GPU компании Nvidia с чиплетной компоновкой. Чипы соединены шиной NV-HBI с пропускной способностью 10 Тбайт/с и работают как единый GPU. Всего новинка насчитывает 208 млрд транзисторов.

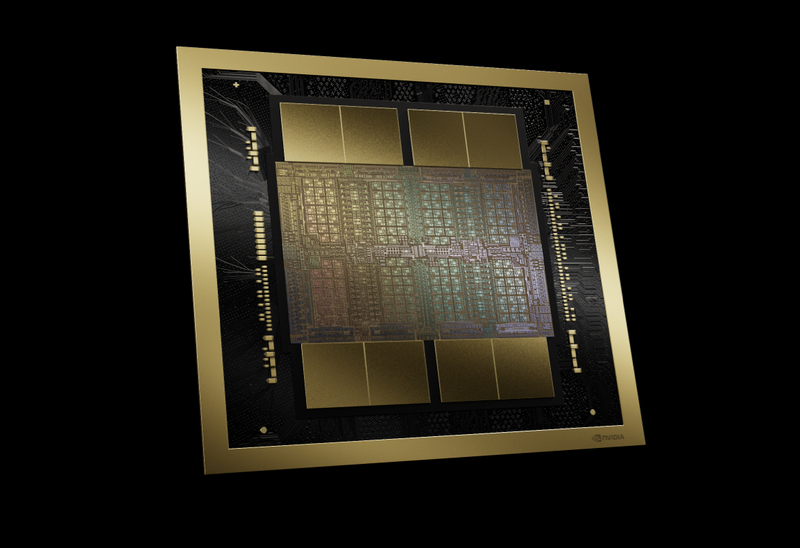

Один из кристаллов Blackwell — в GPU таких кристаллов два

По сторонам от кристаллов GPU расположились восемь стеков памяти HBM3E общим объёмом 192 Гбайт. Её пропускная способность достигает 8 Тбайт/с. А для объединения нескольких ускорителей Blackwell в одной системе новый GPU получил поддержку интерфейса NVLink пятого поколения, которая обеспечивает пропускную способность до 1,8 Тбайт/с в обоих направлениях. С помощью данного интерфейса (коммутатор NVSwitch 7.2T) в одну связку можно объединить до 576 GPU.

Одними из главных источников более высокой производительности B200 стали новые тензорные ядра и второе поколение механизма Transformer Engine. Последний научился более тонко подбирать необходимую точность вычислений для тех или иных задач, что влияет и на скорость обучения и работы нейросетей, и на максимальный объём поддерживаемых LLM. Теперь Nvidia предлагает тренировку ИИ в формате FP8, а для запуска обученных нейросетей хватит и FP4. Но отметим, что Blackwell поддерживает работу с самыми разными форматами, включая FP4, FP6, FP8, INT8, BF16, FP16, TF32 и FP64. И во всех случаях кроме последнего есть поддержка разреженных вычислений.

Флагманским ускорителем на новой архитектуре станет Nvidia Grace Blackwell Superchip, в котором сочетается пара графических процессоров B200 и центральный Arm-процессор Nvidia Grace с 72 ядрами Neoverse V2. Данный ускоритель шириной в половину серверной стойки обладает TDP до 2,7 кВт. Производительность в операциях FP4 достигает 40 Пфлопс, тогда как в операциях FP8/FP6/INT8 новый GB200 способен обеспечить 10 Пфлопс.

Как отмечает сама Nvidia, новинка обеспечивает 30-кратный прирост производительности по сравнению с Nvidia H100 для рабочих нагрузок, связанных с большими языковыми моделями, а она до 25 раз более экономична и энергетически эффективна.

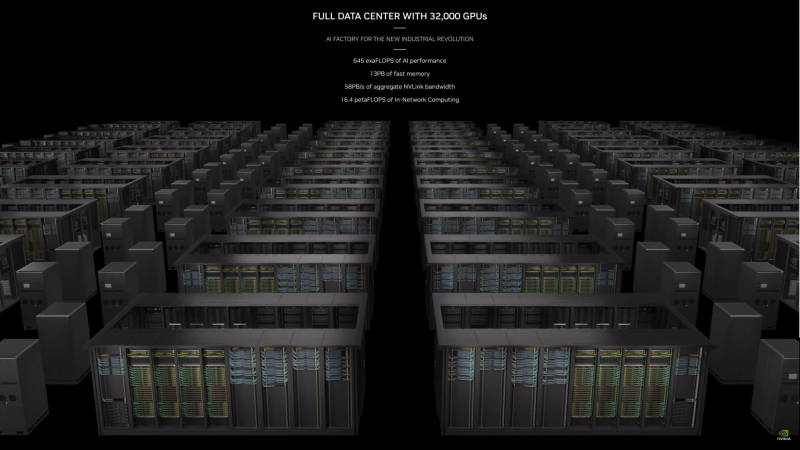

Ещё Nvidia представила систему GB200 NVL72 — фактически это серверная стойка, которая объединяет в себе 36 Grace Blackwell Superchip и пару коммутаторов NVSwitch 7.2T. Таким образом данная система включает в себя 72 графических процессора B200 Blackwell и 36 центральных процессоров Grace, соединенных NVLink пятого поколения. На систему приходится 13,5 Тбайт памяти HBM3E с общей пропускной способностью до 576 Тбайт/с, а общий объём оперативной памяти достигает 30 Тбайт.

Платформа GB200 NVL72 работает как единый GPU с ИИ-производительностью 1,4 эксафлопс (FP4) и 720 Пфлопс (FP8). Эта система станет строительным блоком для новейшего суперкомпьютера Nvidia DGX SuperPOD.

Наконец, Nvidia представила серверные системы HGX B100, HGX B200 и DGX B200. Все они предлагают по восемь ускорителей Blackwell, связанных между собой NVLink 5. Системы HGX B100 и HGX B200 не имеют собственного CPU, а между собой различаются только энергопотреблением и как следствие мощностью. HGX B100 ограничен TDP в 700 Вт и обеспечивает производительность до 112 и 56 Пфлопс в операциях FP4 и FP8/FP6/INT8 соответственно. В свою очередь, HGX B200 имеет TDP в 1000 Вт и предлагает до 144 и 72 Пфлопс в операциях FP4 и FP8/FP6/INT8 соответственно.

Наконец, DGX B200 копирует HGX B200 в плане производительности, но является полностью готовой системой с парой центральных процессоров Intel Xeon Emerald Rapids. По словам Nvidia, DGX B200 до 15 раз быстрее в задачах запуска уже обученных «триллионных» моделей по сравнению с предшественником.

Для создания наиболее масштабных ИИ-систем, включающих от 10 тыс. до 100 тыс. ускорителей GB200 в рамках одного дата-центра, компания Nvidia предлагает объединять их в кластеры с помощью сетевых интерфейсов Nvidia Quantum-X800 InfiniBand и Spectrum-X800 Ethernet. Они также были анонсированы сегодня и обеспечат передовые сетевые возможности со скоростью до 800 Гбит/с.

Свои системы на базе Nvidia B200 в скором времени представят многие производители, включая Aivres, ASRock Rack, ASUS, Eviden, Foxconn, GIGABYTE, Inventec, Pegatron, QCT, Wistron, Wiwynn и ZT Systems. Также Nvidia GB200 в составе платформы Nvidia DGX Cloud, а позже в этом году решения на этом суперчипе станут доступны у крупнейших облачных провайдеров, включая AWS, Google Cloud и Oracle Cloud.