Выход Nvidia Blackwell увеличит спрос на передовую упаковку чипов TSMC CoWoS более чем на 150 % в 2024 году

В этом году Nvidia выпустит семейство ускорителей вычислений нового поколения Blackwell, в котором будут представлены решения как с одними лишь графическими процессорами, например B100 и B200, так и решения, сочетающие графический процессор и центральный Arm-процессор собственной разработки — Blackwell GB200. Выход новых чипов Nvidia значительно увеличит спрос на упаковку чипов по передовой технологии TSMC CoWoS, уверены аналитики TrendForce.

Источник изображения: nvidia.com

Если на долю ускорителей GH200 приходились лишь 5 % поставок высокопроизводительных GPU Nvidia, то с GB200 этот показатель к 2025 году вырастет до 40–50 %. Nvidia планирует наладить выпуск GB200 и B100 во второй половине года, для упаковки чипов потребуется сложная и высокоточная технология CoWoS-L, которая сделает процесс тестирования трудоёмким. Потребуется дополнительное время для оптимизации серии Blackwell для серверных систем искусственного интеллекта в таких аспектах как сетевое соединение и показатели охлаждения. Как ожидается, производство продуктов GB200 и B100 в значительных объемах начнётся не раньше IV квартала 2024 или I квартала 2025 года.

Выпуск ускорителей GB200, B100 и B200 потребует увеличения ёмкости линий по упаковке чипов CoWoS. Ожидается, что TSMC к концу года увеличит их производительность до почти 40 тыс. чипов в месяц — это рост на 150 % по сравнению с прошлым годом. К 2025 году запланированная общая мощность может почти удвоиться, при этом, как ожидается, спрос со стороны Nvidia составит более половины от этой мощности. Другие поставщики, такие как Amkor и Intel, в настоящее время сосредоточены на технологии CoWoS-S, в первую очередь ориентированной на H-серию Nvidia.

Источник изображения: trendforce.com

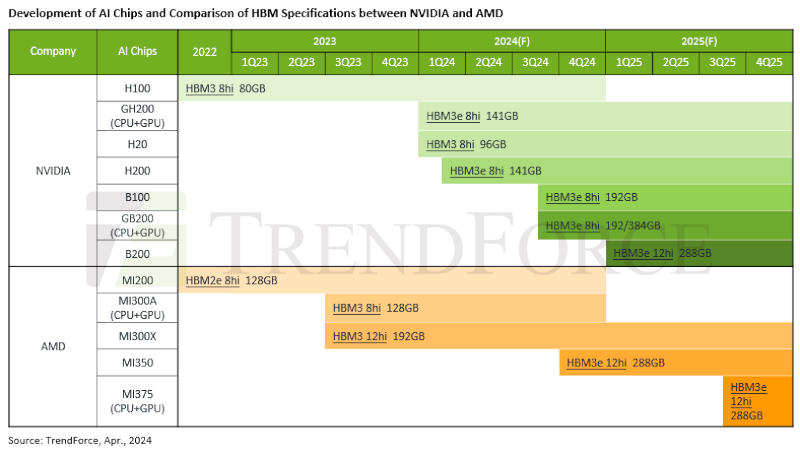

Аналитики TrendForce также определили три основные тенденции развития направления памяти HBM для продуктов Nvidia и AMD после 2024 года. Во-первых, ожидается переход от HBM3 к HBM3e. Во второй половине 2024 года Nvidia начнёт наращивать поставки ускорителей H200, оснащённых HBM3e, которые заменят H100 в качестве основного продукта. Далее последуют модели GB200 и B100 также с HBM3e. AMD же к концу года выпустит новый ускоритель MI350, который могут предварять промежуточные модели, такие как MI32x, направленные на конкуренцию с H200 — все они получат HBM3e.

Во-вторых ёмкость HBM будет расти. Сегодня используются преимущественно ускорители Nvidia H100 с 80 Гбайт памяти — к концу 2024 года будут уже 192–288 Гбайт. Ускоритель AMD MI300A получил 128 Гбайт памяти, но и «красные» нарастят ёмкость до 288 Гбайт. В-третьих, память HBM3e сменит конфигурацию со стеков 8Hi (8 кристаллов DRAM уложенных друг на друга) до 12Hi. Модели Nvidia B100 и GB200 в настоящее время оснащаются HBM3e 8Hi ёмкостью 192 Гбайт, а к 2025 году модель B200 получит HBM3e 12Hi ёмкостью 288 Гбайт. Ускоритель AMD MI350, который появится к концу этого года, и ожидаемая в 2025 году серия MI375, как ожидается, получат HBM3e 12Hi также объёмом 288 Гбайт.