OpenAI представила ИИ-модель GPT-4o — она гораздо умнее старых версий и будет доступна бесплатно

OpenAI представила мощную мультимодальную модель генеративного искусственного интеллекта (ИИ) GPT-4o, которая будет внедрена в её решения для разработчиков и потребителей в течение следующих нескольких недель. Буква «о» в названии GPT-4o означает omni (всесторонний), что указывает на мультимодальность GPT-4o.

Источник изображений: OpenAI

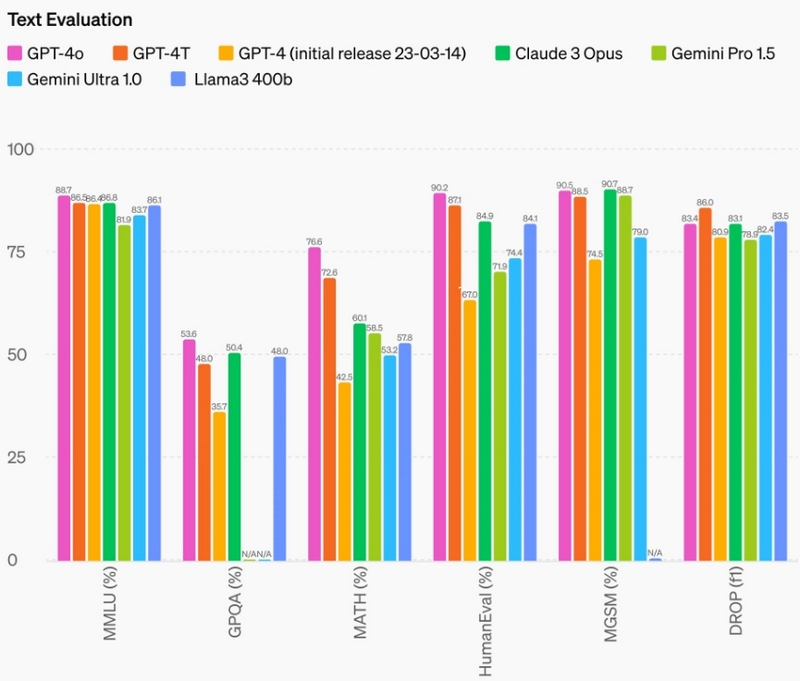

Технический директор OpenAI Мира Мурати (Mira Murati) сообщила в ходе презентации продукта в офисе OpenAI в Сан-Франциско (США), что GPT-4o имеет интеллект «уровня GPT-4», но более высокие возможности в работе с текстом и изображениями, а также с аудио. «GPT-4o воспринимает голос, текст и визуальные образы, — сообщила Мурати. — И это невероятно важно, поскольку мы думаем о будущем взаимодействии между нами и машинами».

Её предшественница — GPT-4 Turbo — обучалась на сочетании изображений и текста. Она способна анализировать изображения и текст для выполнения таких задач, как извлечение текста из изображений и даже описание содержимого этих изображений. В свою очередь, в GPT-4o к этим возможностям добавили речь. GPT-4o получил контекстное окно в 128 тысяч токенов.

Сообщается, что GPT-4o позволит значительно улучшить работу ИИ-чат-бота ChatGPT. Последний уже давно поддерживает голосовой режим, в котором ответы чат-бота расшифровываются с использованием модели преобразования текста в речь, но GPT-4o усилит эту функцию, позволяя пользователям взаимодействовать с чат-ботом больше как с помощником. Например, ему можно будет задать вопрос и прервать его, когда он отвечает. По словам OpenAI, модель GPT-4o обеспечивает реагирование «в реальном времени» и может даже улавливать эмоции в голосе пользователя, генерируя в ответ голос «в различных эмоциональных стилях» в соответствии с текущей ситуацией.

GPT-4o также улучшит визуальные возможности ChatGPT. Исходя из предложенной фотографии или экрана рабочего стола, ChatGPT теперь сможет быстро отвечать на сопутствующие вопросы: от «Что происходит в этом программном коде» до «Какую рубашку какого бренда носит этот человек?».

В дальнейшем возможности модели будут расширяться. Если сейчас GPT-4o позволяет, например, переводить сфотографированное меню на другой язык, то в будущем с её помощью ChatGPT сможет «смотреть» спортивную игру в прямом эфире и объяснять вам правила, говорит Мурати.

Начиная с сегодняшнего дня GPT-4o доступна как платным, так и бесплатным пользователям ChatGPT, но для подписчиков платных тарифных планов ChatGPT Plus и Team ограничение на количество сообщений будет «в 5 раз выше». При превышении лимита ChatGPT автоматически переключится на GPT-3.5 у бесплатных пользователей и на GPT-4 у платных.

Бесплатным пользователям ChatGPT при взаимодействии с GPT-4o станут доступны некоторые функции, которые прежде были только у платных подписчиков. В частности, обновлённый чат-бот сможет искать информацию не только в своей ИИ-модели, но также в интернете; анализировать данные и создавать графики; работать с пользовательскими изображениями и файлами; а также лучше помнить прежние взаимодействия с пользователем. Также бесплатные пользователи получат доступ к GPT Store.

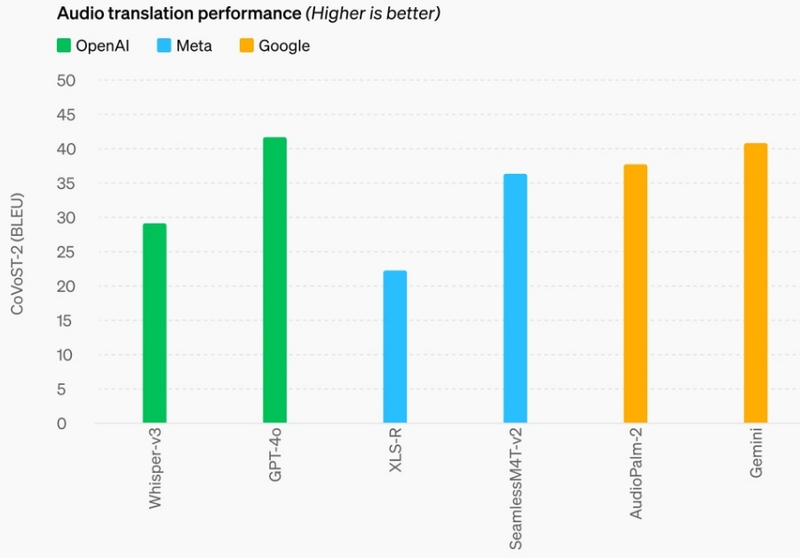

OpenAI сообщила, что GPT-4o поддерживает больше языков, с улучшенной производительностью на 50 различных языках. В API OpenAI GPT-4o в два раза быстрее, чем GPT-4 (в частности, GPT-4 Turbo), вдвое дешевле и имеет более высокие лимиты по скорости.

В настоящее время поддержка голосового общения не включена в API GPT-4o для всех клиентов. OpenAI пояснила, что из-за риска неправильного использования планирует впервые запустить в ближайшие недели поддержку новых аудиовозможностей GPT-4o для «небольшой группы доверенных партнёров».