Нейросетевая фотоника как средство против энергетического ИИ-кризиса

Упоминание о ядерных реакторах — не фигура речи: впечатлённые неутихающим спросом на услуги размещаемых в облаке генеративных моделей, провайдеры такого рода сервисов — и прежде всего Microsoft — стали уже задумываться о привлечении малых модульных реакторов (до 300 МВт электрической мощности) для обеспечения потребностей своих перспективных дата-центров, а AWS недавно приобрела землю для сооружения нового ЦОДа, ориентированного прежде всего на ИИ-задачи, в непосредственной близости от ядерной электростанции в Пенсильвании. По оценке Международного энергетического агентства ещё в 2022-м, на самой заре ИИ-бума, все дата-центры мира (за исключением занятых добычей криптовалют) потребили за год 240-340 ТВт·ч электроэнергии, или 1,0-1,3% от суммарного по планете объёма её выработки, а криптомайнинговые операции добавили к этой величине ещё не менее 0,4%. Эксперты-энергетики же, которых цитирует Scientific American, подсчитали, что ИИ-серверов только на адаптерах NVIDIA будет реализовано в глобальном масштабе к 2027 г. не менее полутора миллионов единиц и что одно лишь их совокупное энергопотребление будет превышать 85 ТВт·ч ежегодно. Потому и заходит речь именно о ядерных реакторах — им сегодня попросту нет альтернативы с точки зрения эффективности выработки условного 1 кВт·ч (при здравом допущении, что холодный термояд так и останется неприрученным в ближайшие 5-10 лет).

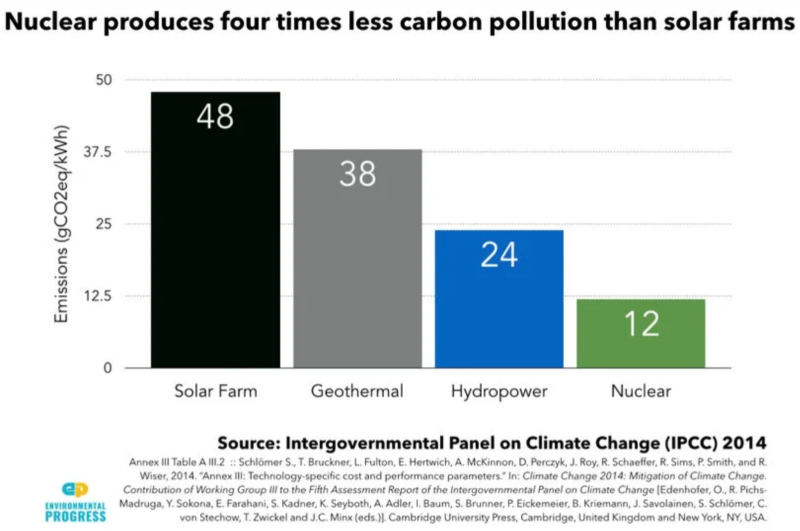

Поля солнечных панелей по показателю углеродного выброса (количеству граммов CO2, извергнутых в атмосферу в ходе выработки 1 кВт·ч) вчетверо превосходят типичную ядерную энергостанцию (источник: IPCC)

Более того, сделанный в конце 2023-го прогноз относительно 85 ТВт·ч потребляемой ИИ мощности в год может оказаться на деле сверхоптимистичной нижней оценкой: по данным Bloomberg, устроители дата-центров в Северной Вирджинии уже изыскивают возможность зарезервировать за собой в рамках долгосрочных контрактов несколько гигаватт мощности действующих в этом штате ядерных реакторов, а ряд поддерживаемых Сэмом Альтманом (Sam Altman), главой небезызвестной OpenAI, стартапов недавно пополнила компания Oklo, занятая разработкой маломощных ядерных реакторов, — каждый из которых отлично подходит для снабжения энергией средних размеров ИИ-ЦОДа. Любопытный факт: представители самой Oklo доверительно сообщили NBC News, что согласование проектов с регуляторами и сбор всех необходимых разрешений требует от них куда больше усилий, чем поиск потенциальных клиентов, в числе которых делающие ставку на ИИ гиперскейлеры занимают далеко не последнее место. Словом, хотя дефицит серверных ИИ-адаптеров NVIDIA в скором времени обещает разрешиться, бурный рост применения «тяжёлых» (не годящихся для запуска и тем более для тренировки на домашнем «железе») генеративных моделей грозит в среднесрочной перспективе ограничить острая нехватка электроэнергии.

Или всё-таки не грозит?

Энергоэффективность человеческого мозга вызывает у инженеров-микроэлектронщиков острую зависть: скажем, для вычислений с производительностью примерно в 1 эксафлопс (1018 операций в секунду) современному суперкомпьютеру уровня Oak Ridge Frontier приходится затрачивать до 20 МВт — тогда как мозг условного шахматного гроссмейстера в ходе размышлений над сложной партией (чтобы выиграть которую, суперкомпьютеру как раз и придётся выжимать если не целиком тот самый 1 ЭФЛОПС, то заметную его долю) обойдётся приблизительно двадцатью ваттами мощности. Да, по мере миниатюризации технологических норм производства полупроводниковых микросхем их энергоэффективность повышается, — но, увы, темпами, отнюдь не достаточными для того, чтобы сократить зияющий разрыв в несколько десятичных порядков.

Суперкомпьютер, конечно же, способен целый ряд задач решать куда эффективнее самого выдающегося человека — речь идёт о хорошо алгоритмизируемых точных вычислениях. Проблемы начинаются там, где алгоритмизация перестаёт выступать оптимальной стратегией. Ту же шахматную партию технически нетрудно на любом этапе свести к простому перебору всех возможных вариантов хода, который можно сделать в текущей позиции прямо сейчас, плюс всех тех вторичных (и последующих) вариантов, что порождает каждый предполагаемый ход. Эта задача великолепно алгоритмизируется; беда только в том, что итоговое число ветвящихся на каждом шаге вариантов позиций оказывается чрезмерно велико, что и вынуждает вычислительные машины, построенные по принципам фон Неймана, расходовать на подобные расчёты прорву энергии. Биологический же мозг устроен иначе и полагаясь не столько на точные вычисления (попробуйте-ка с ходу возвести число π в степень основания натурального логарифма e с точностью хотя бы FP8, — а для компьютера это немногим более сложная проблема, чем «3,0 в степени 2,0»), сколько на качественные обобщающие оценки и эвристику. И вот как раз в плане разработки таких вычислительных систем, что полагались бы на подобные биологическим принципы, фотоника оказывается крайне многообещающим направлением.

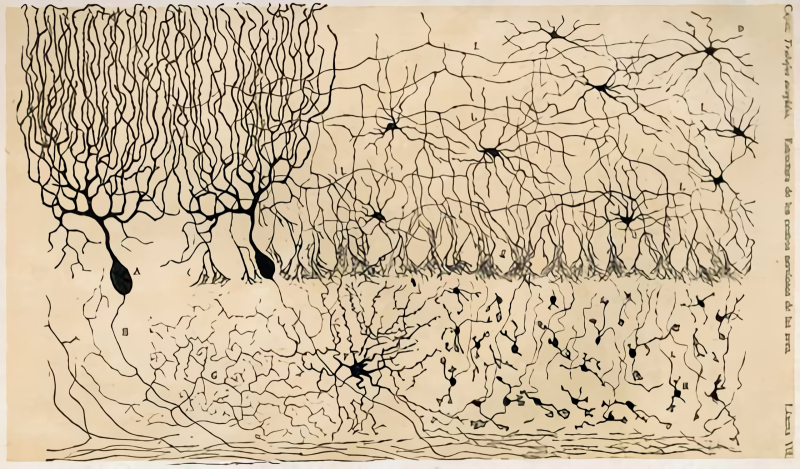

Зарисовка различных типов нейронов куриного мозжечка и их межсоединений, которую выполнил испанский нейроанатом Сантьяго Рамон-и-Кахаль (Santiago Ramón y Cajal); публикация 1905 г. (источник: Wikimedia Commons)

Ещё в конце XIX века, когда несовершенные по нынешним меркам оптические микроскопы не позволяли толком разглядеть устройство биологической ткани, в науке утвердилась нейронная доктрина (neuron doctrine) — представление об обособленной специализированной клетке, нейроне, как о базовой структурной и функциональной единице нервной системы. Сегодня известно, что человеческий мозг состоит из 80-120 млрд нейронов множества разновидностей, соединённых между собой довольно сложно организованными контактами — синапсами. С нейробиологической точки зрения это существенный момент: всего сто с небольшим лет назад нейронной доктрине целый ряд серьёзных исследователей, включая изобретателя «чёрной реакции» Камилло Гольджи (Camillo Golgi), противопоставлял ретикулярную гипотезу — предположение о том, что сеть соединений в сером веществе мозга непрерывна, а узелки-нейроны в её составе как раз благодаря этой сплошной транспортной структуре напрямую обмениваются некими «веществами плазмы», к чему и сводится нервная деятельность.

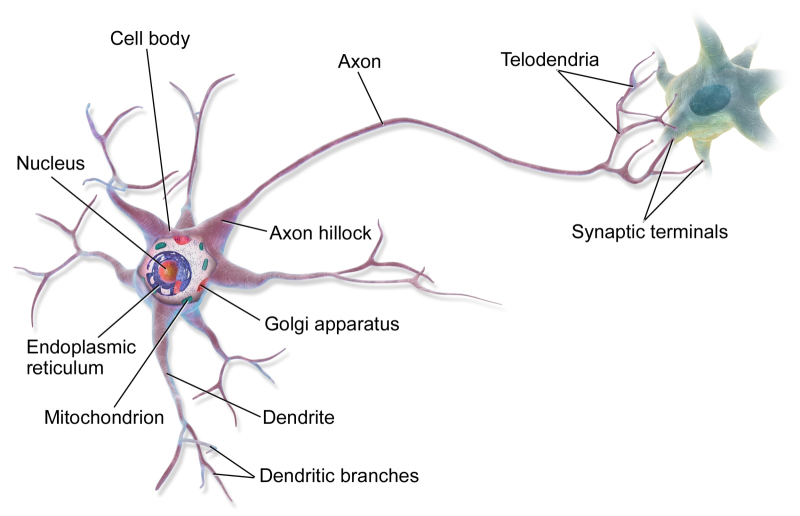

Нейронная же догма подразумевает куда более сложную — непрямую, через посредство синапсов — организацию передачи возбуждения между отдельными нейронами. Каждый такой нейрон, как это было подтверждено уже в середине XX века непосредственными наблюдениями, имеет в своём составе несколько протоплазматических выростов, называемых дендритами, — те принимают сигналы от других нейронов, предварительно обрабатывают их и передают клеточному телу. Собственно клеточное тело ответственно за финальную обработку поступающих ото всех дендритов сигналов и формирование единственного исходящего сигнала. А тот уже, в свою очередь, передаётся по аксону — протяжённому волокну, которое на конце разветвляется на множество коллатералей, образующих в нервной ткани синаптические контакты с дендритами других нейронов.

Схематическое устройство многополярного (т. е. имеющего множество дендритов) нейрона — именно такие образуют бóльшую часть нервной ткани головного мозга (источник: Wikimedia Commons)

На первый взгляд может показаться, будто компьютерные нейросети общепринятой ныне конструкции — на множестве слоёв перцептронов, multi-layer perceptrons (MLP), — реализуют как раз отвергнутую нейробиологами ретикулярную гипотезу. Ведь на схемах, иллюстрирующих пронизанные взаимными связями слои искусственных нейронов, нет каким-то сложным образом устроенных границ между отдельными их узлами. Однако на деле современные LLM и прочие системы машинного обучения воплощают как раз нейронную доктрину, поскольку собственно обучение сводится для них к формированию определённого набора весов на входах каждого из перцептронов в каждом из рабочих слоёв нейросети (напомним, что реализуются цифровые нейросети в виде математических абстракций — путём эмуляции на фон-неймановских в основе своей машинах: нейрону соответствует модель перцептрона со множеством входов и выходов; первые можно интерпретировать как дендриты, вторые — как коллатерали на конце аксона). А это как раз соответствует особенностям нейронной структуры нервной системы: на дендритах в процессе прохождения сигналов (обучения в самом широком смысле этого слова) образуются так называемые дендритные шипики — особые мембранные выросты, которые, собственно, и становятся основой для формирования синапсов. В ходе обучения количество шипиков доказательно увеличивается, что можно рассматривать как прямой аналог корректировки весов на входах перцептронов при машинном обучении. Ретикулярная же гипотеза предполагала, что каналы между узлами нейросети — чисто транспортные, сквозные, и что все операции по обработке данных производятся в самих телах нейронов. Кстати, предложенная недавно как альтернатива MLP структура нейросети Колмогорова—Арнольда (Kolmogorov-Arnold Network, KAN) от линейных весов на входах перцептронов переходит к обучаемым функциям активации, что ещё более сближает искусственную систему нейронов с её натуральным прототипом.

Принципиальная разница между биологической и цифровой нейросетями, конечно же, остаётся, и не только на уровне общей структуры (у головного мозга нейроны группируются в специализированные отделы — зоны — для решения различных задач, тогда как современные нейросетевые модели в этом смысле по большей части «однородны»), но и в приложении к организации межнейронных контактов. Синапсы ведь бывают чисто электрическими, чисто химическими или смешанными, и на работу последних двух типов оказывают огромное влияние нейромодуляторы — химические вещества, что попадают тем или иным образом в среду нервной ткани и модифицируют прохождение сигнала через синаптическую щель. Впрочем, быть может, по крайней мере на нынешнем этапе технологического развития, человечеству даже спокойнее от того, что и без того частенько галлюцинирующие нейросети нет возможности искусственно «взбадривать» инъекцией цифровых аналогов каких-нибудь эдаких нейромодулирующих веществ.

Принципиальное достоинство вычислений, производимых фон-неймановскими машинами с последовательным выполнением операций, как уже отмечалось, — их точность, определяемая, в свою очередь, лежащей в основе выполняемых ими операций булевой алгеброй. Когда любая переменная может принимать лишь одно из двух значений — «истина» или «ложь», а процедура расчётов чётко задана алгоритмически, никаких проблем с достижением любой заданной точности не возникает: для пресловутого числа π, скажем, уже известно примерно сто триллионов знаков после запятой. Правда, у компьютеров архитектуры фон Неймана имеются по меньшей мере три слабых стороны: требуемое на выполнение громоздких расчётов время (для некоторых задач оно превышает оценку актуальной продолжительности существования нашей Вселенной), величина потребляемой в процессе такого рода вычислений энергии (и снова привет, ядерные электростанции!), а также неспособность эффективно решать сложные задачи в отсутствие чётко заданного алгоритма хотя бы качественно. Классический пример — задача коммивояжёра: доказано отсутствие для неё алгоритма решения, который бы имел по крайней мере степенную сложность (т. е. для которого число шагов расчётов — константа в степени n, где — n число пунктов назначения на карте того самого коммивояжёра).

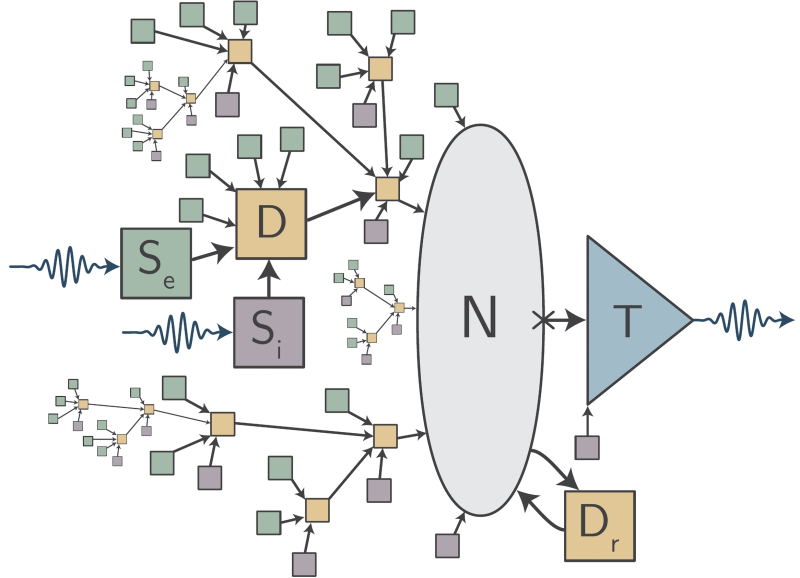

Схема т. н. петлевого нейрона (loop neuron), предложенного для реализации в оптоэлектронных нейросетях, — более приближенного к биологическому прототипу, чем классический перцептрон: N — тело нейрона, D — дендриты, Se и Si — возбуждающие (excitatory) и тормозящие (inhibitory) синапсы, T — трансмиттер (источник: NIST)

Как и всякий созданный человеком инструмент, фон-неймановский компьютер оказался отлично подходящим для определённого, пусть и весьма широкого, круга задач, но за пределами этой области разумность его применения становится всё более и более сомнительной. Скажем, рассчитать траекторию запуска космической станции к Плутону и далее, к объектам пояса Койпера, — дело как раз для прямолинейно действующей в рамках булевой алгебры вычислительной системы: законы небесной механики безупречно алгоритмизируются, а если в ходе путешествия возникнут некие возмущения, скорректировать курс несложно будет точно так же чётко рассчитанным импульсом бортовой двигательной установки.

Но на крохотный (по сравнению даже с самым завалящим астероидом) аппарат в бескрайней космической пустоте действует лишь ограниченное число значимых сил: приданный ему разгонным блоком ракеты начальный импульс, гравитационное поле Солнца, притяжение одной-двух ближайших планет на каждом участке траектории, — всем прочим можно с очень неплохой точностью пренебречь. Увы, задачи такого типа, строго говоря, встречаются в природе не так уж часто: гораздо более распространены ситуации, когда необходимо учитывать взаимодействие сразу огромного количества сравнительно малых, но почти равновеликих сил. Ну, скажем, как вычислить форму, которую примет самая обыкновенная мыльная плёнка, подцепленная проволочной рамкой? Никакой неопределённости тут нет: прекрасно известно, что силы поверхностного натяжения непременно заставят поверхность выгнуться так, чтобы минимизировать порождаемую самими этими силами потенциальную энергию. Но чем сложнее форма рамки, тем более громоздкими выходят алгоритмические расчёты, — тогда как в реальном мире мыльная плёнка принимает «нужную» форму на какой-нибудь многоугольно-звёздчатой, да ещё и неплоской рамке с той же лёгкостью, как и на идеально кольцевой, никаких предварительных вычислений притом не производя.

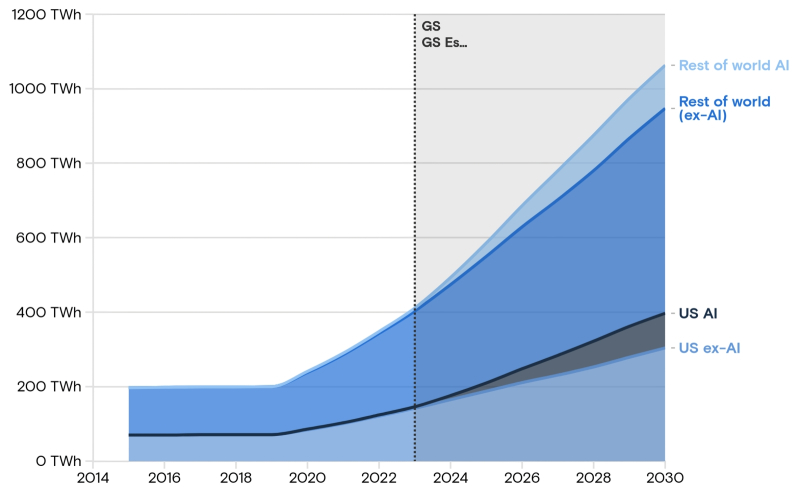

Согласно прогнозу Goldman Sachs Research, общий прирост энергопотребления ЦОДами в США и остальном мире, обусловленный ростом обращений к ИИ, в интервале от 2023 до 2030 г. будет составлять около 200 ТВт·ч ежегодно (источник: Goldman Sachs Research)

Именно это — ключевой момент для понимания того, зачем одновременно с фон-неймановскими компьютерами человечеству потребовались ещё и вычислительные нейросети. Вторые — вовсе не эволюционное развитие первых; огромный класс важных задач, что требуют точного решения по строго заданным алгоритмам, системы на базе булевой логики продолжат с успехом перемалывать и через десять, и, надо думать, через сто лет. Зато другой, едва ли не более обширный даже класс, подразумевающий эффективную параллельную обработку архиобильных объёмов данных с применением машинной эвристики, что не определяется алгоритмически, а вырабатывается, как и человеческая интуиция, на основе обучения, — вот для этой категории задач без нейросетевых вычислителей никак не обойтись. И куда разумнее применять для их построения специализированные аппаратные платформы — ту же оптоэлектронику, — а не эмулировать их снова и снова на сверхскоростных и чудовищно прожорливых в энергетическом плане фон-неймановских серверах. Для понимания масштабов проблемы: аналитики International Energy Agency оценили расход энергии на обработку единичного запроса к ChatGPT в 2,9 Вт·ч, тогда как обработка пользовательского обращения к стандартному поисковику обходится, к примеру, дата-центрам Google в 0,3 Вт·ч.

Строго говоря, микросхемы привычных сегодня полупроводниковых архитектур в основе своей тоже содержат элементарные узелки — переключатели, они же транзисторы, — из которых усилиями проектировщиков и изготовителей СБИС собираются последовательно рассматривавшиеся нами ранее штрихи Шеффера, затем сумматоры и ещё более сложные контуры. Но в том-то и дело, что даже эти базовые элементы подчинены законам булевой алгебры — выдают на выходе строго единицу либо строго ноль в зависимости от своей конструкции и значений сигналов на входах, — а значит, обречены производить исключительно точные вычисления. Простора для обучения и порождаемой им (если оно организовано должным образом, конечно) эвристики здесь попросту нет, а говорить об энергоэффективности полупроводниковых вычислений и вовсе не приходится. Биологические же нейроны устроены совершенно иначе, так что подобрать подходящие физические системы для адекватного воспроизведения принципов их работы энергетически должно быть заведомо выгоднее, чем эмулировать их виртуальными перцептронами в оперативной памяти фон-неймановской машины.

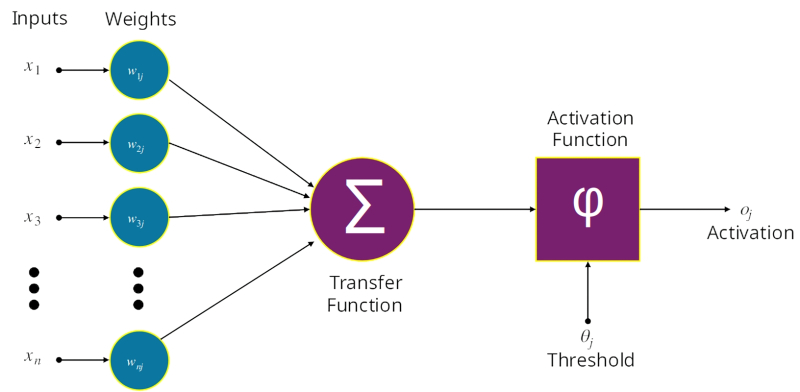

Работу классического искусственного нейрона — перцептрона — не так уж сложно смоделировать на фон-неймановской машине. Другое дело, когда такие перцептроны приходится представлять в цифровой форме миллиардами разом, да ещё и в тесном взаимодействии между собой (источник: Wikimedia Commons)

Выгоднее потому, что для построения по-настоящему хорошо обучаемой универсальной (а не просто отличающей, скажем, кошечек от собачек по фото, и только), да ещё по нынешним стандартам качества и мультимодальной нейросети требуются миллиарды нейронов, и поэтому любой выигрыш в энергоэффективности на уровне одного из этих базовых элементов обернётся для итоговой системы огромным преимуществом в плане экономичности производимых вычислений. И, как мы уже отмечали, чем сильнее человечество полагается на разнообразные (не только генеративные) модели машинного обучения, тем острее встаёт вопрос — а готово ли оно себе позволить выделять на исполнение и тренировку этих моделей всё более и более ощутимую часть своего глобального энергетического бюджета?

Сравнение биологического мозга с полупроводниковыми вычислительными системами напрямую, на уровне базовых элементов, оказывается не в пользу первого: сигнал через химические синапсы распространяется заведомо медленнее, чем электроны движутся по открываемым им транзисторными затворами каналам. Однако выигрыш распределённой нейросетевой структуры с присущей ей возможностью обучения перед жёстко закостеневшими в рамках булевой алгебры интегральными схемами оказывается впечатляющим. Так, совсем недавно исследователи из Массачусетского технологического института экспериментально доказали, что весь процесс распознавания образа — от появления картинки перед глазами испытуемого до общей её категоризации мозгом — занимает всего-навсего 13 миллисекунд, тогда как ранее считалось, что на это может требоваться 100 мс и даже более. Речь именно об отнесении изображения к некой крупной категории — «пейзаж», «человек», «четвероногое», — а не о восприятии его во всей полноте деталей, конечно же; но всё равно — впечатляет. Впечатляет так сильно, что заставляет нейробиологов пересматривать устоявшиеся за десятилетия представления о том, как на самом деле функционирует нервная ткань. А значит, и у разработчиков искусственных нейросетей появляется новая пища для размышлений.

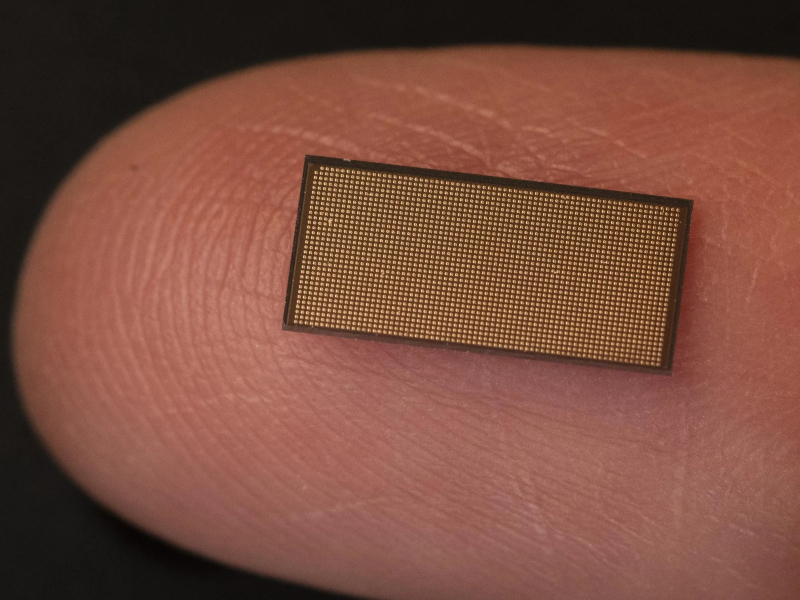

Нейроморфный чип Loihi 2, выполненный по технологическим нормам «Intel 4» (примерно соответствуют «7 нм» в терминах TSMC), содержит около 1 млн искусственных нейронов — и всё ещё продолжает оставаться в стадии исследовательского проекта; коммерческий его выпуск пока не планируется (источник: Intel)

Классическое описание работы нейрона (зрительной коры головного мозга, в частности) подразумевает сбор им через дендриты длительных серий сигнальных импульсов от аксонов «выше расположенных» соседей, агрегацию этих импульсов в собственном теле, формирование выходного сигнала и трансляцию его уже через свой аксон. На всё про всё должна уходить, если считать дотошно все перемещения ионов (носителей заряда) через синаптические щели, даже не одна сотня миллисекунд. Опыты же исследователей из MIT и их предшественников показали, что некоторые нейроны в зрительной коре манкируют исполнением полного цикла «накопление входных данных — вычисление — отправка сигнала на выход» и буквально сразу же, по получении двух-трёх нервных импульсов, уже формируют свой выходной сигнал. Это подводит к следующему умозаключению: для срабатывания нейрона (по крайней мере, некоторых из них) важную роль играет не только количество получаемых выходных импульсов, но и задержки между ними — настолько важную, что общая категоризация образа становится возможной буквально «с двух нот»; точнее, по двум, а то и даже одному характерному интервалу между импульсами.

Понятно, что такие способности возникают лишь в ходе обучения и что вслед за первичным отнесением картинки к какой-то группе по грубой оценке тех самых некоторых «скоропалительных» нейронов происходит уже более основательная верификация, когда до принимающих решение о ней клеток добираются сигналы от более «вдумчивых» их коллег. Но факт остаётся фактом: биологическая нейросеть за счёт ещё большего огрубления производимых операций (и без того далёких от высоких стандартов булевой алгебры, задаваемых полупроводниковыми вычислительными системами) ухитряется преодолевать собственные объективные ограничения и демонстрировать производительность в пересчёте на ватт затраченной мощности куда выше ожиданий. Искусственным нейросетям есть к чему стремиться!

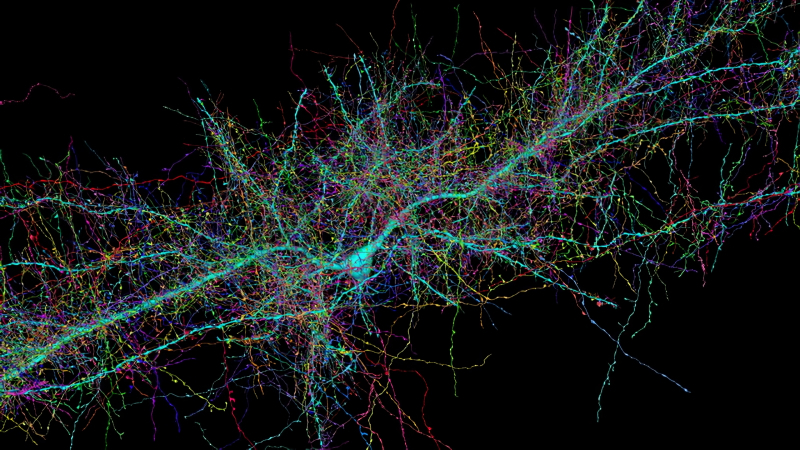

Так выглядит дендритная структура всего лишь одного биологического нейрона (источник: Harvard University/Google)

И они, собственно, стремятся, опираясь в том числе на оптоэлектронную элементную базу. Да, разумеется, с производственной точки зрения разработчикам проще иметь дело с полупроводниковыми структурами, тем или иным образом вырванными из крепких объятий булевой алгебры, — скажем, можно ведь от фиксации самого факта «есть сигнал — нет сигнала» на выходе некоего контура точно замерять величину выходящего тока и уже на основании этой величины принимать дальнейшие решения — например, передавать сигнал дальше по цепи или нет (реализация простейшего искусственного синапса). Но у располагаемых на плоскости и связываемых металлическими шинами в слоях межсоединений транзисторов всё равно крайне ограничены возможности формировать подлинно нейроноподобные структуры.

Для примера: в ходе опубликованного в 2001 г. исследования специалистов Google и Гарварда было установлено, что на 86 млрд нейронов в изученном головном мозге приходится около 100 трлн синапсов, — то есть в среднем каждый нейрон поддерживает около 1 тыс. контактов с соседями (притом, кстати, заметную долю в выборке, до 10%, составляют многосинапсовые контакты между дендритом одного нейрона и аксонной коллатералью другого, что ещё более усложняет структуру передачи нервного сигнала). Полупроводниковый же нейроноподобный контур чисто физически не способен контактировать более чем с десятком соседей — иначе структура межсоединений становится чрезмерно сложной, даже (и тем более) если реализовывать её посредством многослойных микросхем. Не следует также забывать, что для многослойных чипов, как мы уже говорили, одним из важнейших ограничений роста производительности становятся сложности с отводом тепла от промежуточных слоёв, ведь низкая шаговая энергоэффективность (в смысле величины рассеяния тепла при производстве каждой элементарной булевой операции, т. е. смены «1» на «0» или обратно в ходе прохождения сигнала по некоему контуру) полупроводниковых СБИС так никуда и не делась.

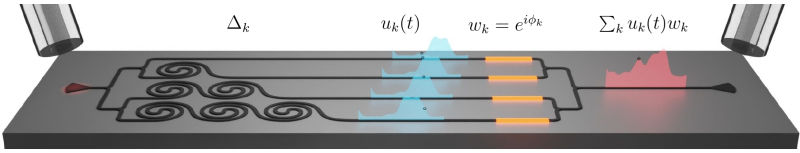

Принципиальное устройство составного перцептрона, реализованного на интегральной оптоэлектронной схеме: сигнал поступает на контур из излучателя слева, разделяется на четыре канала с различными задержками (каждая дополнительная петля световода добавляет некую стандартную задержку), затем каждый из каналов подвергают тепловой фазовой модуляции (что как раз соответствует применению корректируемых в процессе обучения весов на входах) — и в итоге суммируют получившиеся модифицированные сигналы, образуя единый выходной (источник: Università degli Studi di Trento)

Логичным способом обхода этого ограничения представляется мультиплексирование сигналов — когда для передачи сразу множества информационных потоков используют единый канал связи. В приложении к полупроводникам мультиплексирование затруднено необходимостью точно различать тонкие градации величин перемещаемого заряда (и без того крайне малых по модулю, кстати, если говорить о внутренних шинах интегральных микросхем) в электрических цепях. Насколько велика сложность задачи, можно судить по крайне неторопливому, растянувшемуся на долгие годы переходу от одноуровневых ячеек памяти NAND к трёх- и четырёхуровневым, а также по довольно жёсткой критике перспективных пятиуровневых в плане соотношения обеспечиваемых ими выигрышей и минусов — по сравнению всё с теми же четырёхуровневыми. И это касается лишь хранения данных — с динамически меняющимися сигналами в электрических цепях ситуация обстоит ещё сложнее.

Зато мультиплексирование прекрасно работает для оптоволоконных линий связи — а значит, оно окажется действенным и для оптоэлектронных систем! Помимо создания собственно перцептронов (например, комбинирующих временнóе и пространственное мультиплексирование), можно непосредственно интегрировать фотонику с квантовыми эффектами, соединяя мультиплексирующими волноводами сверхпроводящие узлы, в которых реализуется квантовая интерференция. Это может показаться избыточным усложнением технологий: в чём, спрашивается, логика перескакивания через этап «обычных» нейросетей с последовательным освоением всех необходимых технологий и процессов сразу к квантовым? Да в том, что «обычный» вычислительный контур нуждается в удержании на определённых участках сигнала на достаточно продолжительное время — например, в ожидании окончания неких параллельно идущих вычислений. Для этого в фотонике применяют оптические резонаторы (optical cavities), в которых формируется стоячая световая волна, — довольно громоздкие совокупности отражающих элементов, потери в которых оказываются довольно велики, что, увы, снижает энергоэффективность итогового вычислителя. К тому же каждый оптический резонатор настроен строго на единственную длину волны, а это дополнительно затрудняет проектирование оптоэлектронных схем с мультиплексирующими по частоте волноводами.

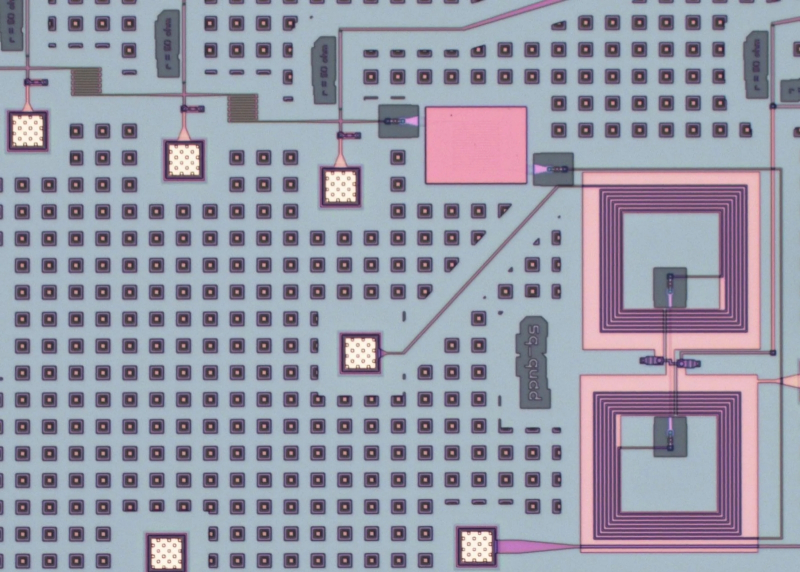

Сверхпроводящий гибридный (фотоника + квантовая система) контур — аналог биологического синапса: оптоэлектронная часть формирует волноводы, джозефсоновские переходы (между двумя большими петлями справа внизу) реализуют однофотонную фиксацию (источник: NIST)

Специалистами из американского Национального института стандартов и технологий (National Institute of Standards and Technology, NIST) предложен для решения этой проблемы гибридный вычислительный контур, который можно считать аналогом биологического синапса — межнейронного соединения: именно его поведение определяет, будет ли (и какой именно) передан импульс от аксонной коллатерали предыдущего в условной сигнальной цепочке нейрона к дендриту последующего. Остроумная идея этой группы заключается в том, что они не просто снизили энергопотребление итоговой вычислительной системы, но сократили его едва ли не до принципиально возможного минимума, — поскольку единицей передачи информации в ней оказывается ровно один фотон (что, спрашивается, может быть энергоэффективнее?!). Возможно это оказалось благодаря эффекту Джозефсона, точнее, реализованным на его основе джозефсоновским переходам (Josephson junction).

Сверхпроводящий контур с парой таких переходов образует сверхпроводниковый квантовый интерферометр — superconducting quantum interference device (SQUID), ток в цепи которого меняется в диапазоне от нуля (если токи в каждой из образующих его сверхпроводящих петель разнонаправленные) до некоего максимального значения (если происходит взаимоусиление сонаправленных токов). Высочайшая чувствительность SQUID к величине магнитного поля в той области, где располагаются джозефсоновские переходы, как раз и позволяет детектировать одиночные фотоны — сами по себе не несущие заряда, но создающие электромагнитное поле в процессе движения (точнее, сами являющиеся этим полем — его собственно квантами).

В результате полученная гибридная система позволяет распознавать сигналы продолжительностью всего 2 пикосекунды, причём после каждого прохождения фотона через детектор величина тока, что циркулирует в его сверхпроводящих петлях, возрастает на условную «единицу». Получается своего рода аналог биологического синапса — остаётся лишь передать накопленный сигнал на некий внешний по отношению к SQUID перцептрон (как именно тот будет реализован — вопрос уже отдельный). Исследователи заявляют, что пиковая частота срабатывания их синапса превышает 10 МГц, а энергопотребление при этом находится на уровне 3,3·10−17 Дж на каждый фотон. Для сравнения предельная «разрешающая способность» нейронов человеческого мозга оценивается в 340 Гц, а энергии на фиксацию каждого синаптического события они тратят примерно 10−14 Дж. Словом, в NIST удалось создать (не просто спроектировать, а реализовать на практике) аналог биологического синапса, который оказался даже на несколько порядков эффективнее своего прототипа.

Понятно, что торжествовать очередную победу над косной материей и провозглашать начало эры сверхэкономных нейровычислений пока рано, — одних SQUID-синапсов с однофотонными волноводами для этого недостаточно; требуется ещё подобрать и воплотить «в металле» не слишком уступающие им в эффективности перцептроны. Но данное направление развития квантовой фотоники уже рассматривается как чрезвычайно перспективное, тем более что приз за достижение желанной цели здесь более чем завидный, даже с учётом очевидно масштабных потребных инвестиций, — экономия многих десятков тераватт-часов электроэнергии в планетарном масштабе ежегодно.

Материалы по теме

- Вице-президент Nvidia перешла в стартап Lightmatter, который создаёт ИИ-чипы с кремниевой фотоникой.

- Intel представила фотонный интерконнект OCI: по 2 Тбит/с в обе стороны на расстоянии 100 м.

- Intel намерена заняться устранением узких мест в системах ИИ — ускорять память и сетевые интерфейсы.

- Intel представила нейроморфный компьютер Hala Point на 1152 чипах Loihi 2 с мозгоподобной архитектурой.

- TSMC считает важным развитие кремниевой фотоники в условиях бума систем искусственного интеллекта.