Microsoft представила ИИ-инструмент для защиты ИИ от галлюцинаций и ошибок

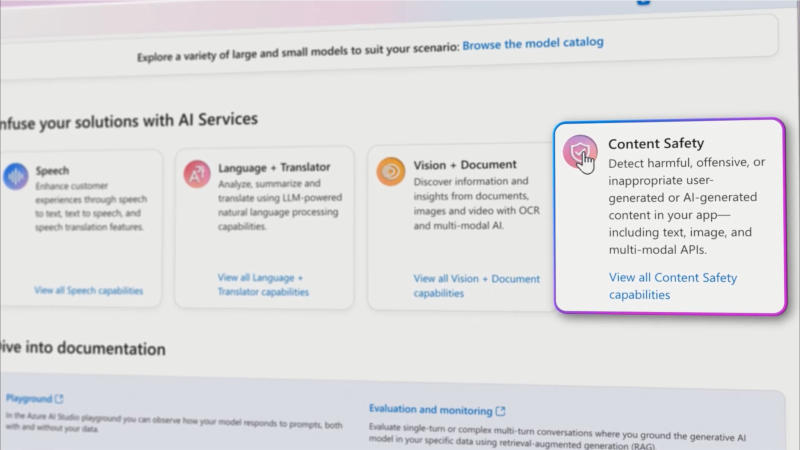

Microsoft представила новую функцию Content Safety в облачной инфраструктуре Azure — она направлена на борьбу со сбоями в работе генеративного искусственного интеллекта. Функция автоматически обнаруживает и даже исправляет ошибки в ответах моделей ИИ.

Источник изображения: youtube.com/@MicrosoftAzure

Content Safety доступна в предварительной версии в пакете Azure AI Studio — это набор средств безопасности, предназначенных для обнаружения уязвимостей, поиска «галлюцинаций» у систем ИИ, а также блокировки недопустимых запросов от пользователей. Content Safety сканирует ответы ИИ и выявляет в них неточности, сравнивая выходные данные с исходными материалами клиента.

Обнаружив ошибку, система выделяет её, сопровождает сведениями, почему предоставленная информация неверна, и переписывает проблемный контент — всё это происходит ещё «до того, как пользователь сможет увидеть» неточность. Впрочем, гарантии надёжности эта функция не даёт. На корпоративной платформе Google Vertex AI тоже есть функция «заземления» моделей ИИ посредством сверки ответов по поисковой машине Google, собственным данным компании и в перспективе сторонним наборам данных.

Система Microsoft Content Safety осуществляет согласование ответов с базовыми документами при помощи больших и малых языковых моделей, рассказал представитель компании, но и она не застрахована от ошибок. «Важно отметить, что обнаружение [ошибок при помощи функции] "заземления" не решает проблему "точности", но помогает согласовывать ответы генеративного ИИ с базовыми документами», — пояснили в Microsoft.