Нейроморфные вычислители: прямая дорога к сильному ИИ?

Чем основанные на принципах фон Неймана машины по-настоящему хороши, так это широчайшими своими способностями к эмуляции самых разнообразных процессов — не исключая и тех же самых вычислительных, но производимых системами кардинально иных архитектур. И чем плотнее становятся фоннеймановские компьютеры, т. е. чем больше их базовых элементов (а именно транзисторов, поскольку лучше всего развиты сегодня именно полупроводниковые технологии их производства) умещается на единице площади, тем выгоднее оказывается эмулировать с помощью этой техники вычислительные средства совершенно иной природы. Так, хотя искусственные нейроны — перцептроны, о которых мы не раз уже говорили, без особых затруднений могут быть реализованы физически в том числе и на полупроводниковой материальной базе, значительно эффективнее (по совокупности затраченных инженерных усилий и средств) оказывается формировать многослойные нейронные сети в памяти фоннеймановских серверов или даже ПК потребительского класса.

По крайней мере, такого рода рассуждения оставались справедливыми до начала бурного и повсеместного всплеска интереса к генеративному ИИ, что пришёлся на осень 2022 г., — и до сих пор эта тема продолжает оставаться весьма горячей.

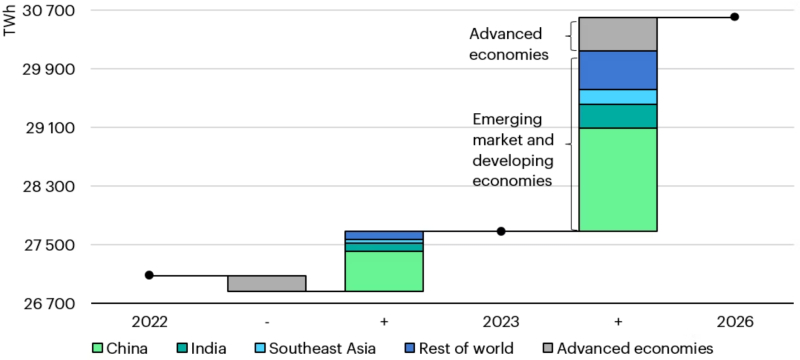

Изменения в потреблении электроэнергии по регионам мира в 2022-2023 гг. и прогноз на 2026-й, ТВт·ч (источник: IEA)

«Горячей» не только в переносном смысле: по оценке Международного энергетического агентства (International Energy Agency. IEA), в 2026 г. глобальное потребление энергии центрами обработки данных удвоится по сравнению с 2022-м, достигнув 2% от общего объёма, выработанного всеми электростанциями мира. Разумеется, не все эти несметные тераватты уйдут на питание ИИ-серверов, анимирующих по заявкам интернет-пользователей фотореалистичные изображения котиков в смешных шапочках, — но вклад исполнения действующих (и тренировки новых) моделей искусственного интеллекта самого разного предназначения в стремительный рост энергетического бюджета цивилизации огромен. К примеру, Microsoft уже заключила 20-летний контракт на поставку электроэнергии с одной из атомных электростанций Constellation Energy в Пенсильвании, а AWS нанимает главного инженера с опытом работы в атомной отрасли, чтобы развивать направление малых модульных реакторов и налаживать связи с традиционными АЭС, — всё это как раз из-за острейшей нужды в как можно более недорогой и доступной энергии для ИИ-ЦОДов.

По оценке, которую приводит The Economist, тренировка одной только модели GPT-4 (у которой на сегодня уже набралось немало прямых конкурентов) обошлась более чем в 50 ГВт·ч — это примерно 0,02% годового энергетического бюджета штата Калифорния и в 50 раз больше, чем потребовала для своего обучения модель GPT-3. Эксперты Forbes опасаются, что чрезмерно стремительное развитие ИИ подталкивает планету к энергетическому кризису, — и их беспокойство вполне объяснимо: если классическая 19-дюймовая серверная стойка в типичном дата-центре потребляет около 7 кВт мощности, то та же стойка, но с оборудованием, ориентированным на исполнение ИИ-задач, будет требовать уже от 30 до 100 кВт. С этим явно надо что-то делать, причём вариант «давайте возьмём и перестанем разом всем человечеством генерировать котиков в смешных шапочках» — по крайней мере в среднесрочной перспективе — не представляется реалистичным. Да, ажиотаж вокруг ИИ, в особенности чисто биржевой, явно идёт на спад, но снижение активности спекулянтов на горячей теме может быть указанием на более широкое и углублённое проникновение этой новой технологии в самые разные отрасли, включая ключевые для страновых и мировой экономики.

И здесь как разработчики, так и пользователи моделей искусственного интеллекта сталкиваются с очевидной дилеммой. С одной стороны, чтобы продемонстрировать скептикам не просто позитивный экономический эффект, но принципиальное превосходство, достигаемое внедрением ИИ в различные виды хозяйственной деятельности, необходимо как можно более широкое приложение этих новейших технологий. С другой — чудовищные энергозатраты на эксплуатацию (и, отдельно, на тренировку) ИИ-моделей ставят под вопрос именно экономическую целесообразность такого перехода. Ситуация выходит примерно как с потенциальной доступностью автоматического оружия уже в эпоху Возрождения: не вызывает сомнений, что творивший тогда Леонардо да Винчи смог бы перейти от разработанной им (на уровне наброска) 33-ствольной скорострельной ружейной батареи, додумавшись до унитарного патрона, к пулемёту — аналогичному, допустим, по конструкции довольно простой схеме Гатлинга. Смог бы — если бы к тому имелись экономические предпосылки. Однако массовое изготовление точно соответствующих заданным размерам гильз и пуль (а малейший разнобой в габаритах внутри единого калибра неизбежно ведёт к заклиниванию скорострельного самозарядного оружия) в доиндустриальную эру было либо вовсе невозможно, либо настолько трудоёмко, что одна пулемётная лента, заполненная выделанными вручную цеховыми мастерами патронами, наверняка обходилась бы дороже оснащения какого-нибудь отряда арбалетчиков. Пустое расточительство!

Избыточные энергетические аппетиты современных ИИ-систем также можно рассматривать как указание на несоответствие идеи нейроморфных, т. е. «мозгоподобных», вычислений — и применяемой для их практической реализации аппаратной основой. Полупроводниковые вычислительные средства вообще отличаются крайне низкой энергоэффективностью: достаточно сопоставить энергобюджеты любого ЦОДа, уходящие на работу собственно серверов, с одной стороны — и системы отвода от них тепла с другой. В то же время человек — скажем, профессиональный художник, вручную рисующий всё тех же пресловутых котиков в смешных шапочках, — тратит на свою умственную деятельность (движения мышц в расчёт даже не берём, они ещё экономичнее) едва ли более десятка ватт, т. е. на три с лишним порядка меньше набитой серверными графическими ускорителями стойки в дата-центре.

И дело тут вовсе не в скорости обработки простых задач: перемножать в уме, допустим, трёхзначные числа даже профессору математики непросто, тогда как для простейшего калькулятора хоть три знака, хоть тридцать три, всё равно, — главное, чтобы хватило позиций на экране для отображения результата. Преимущество биологического мозга — в высочайшем параллелизме его работы, благодаря которой он способен решать заведомо превосходящие по сложности целочисленное умножение задачи — и которую, по-хорошему, как раз и следовало бы имитировать «железу», занятому нейроморфными вычислениями. Так что же мешает перейти от неэффективной (с энергетической точки зрения) эмуляции нейронных сетей на фоннеймановских ПК к реализации тех же самых сетей в аппаратном, что называется, виде?

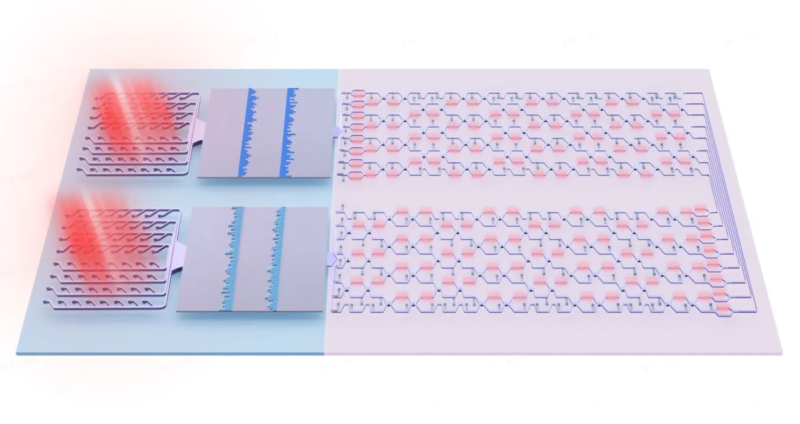

Оптический микропроцессор Taichi использует фотонные схемы и для приёма информационных/управляющих сигналов, и для их обработки (источник: Tsinghua University)

В принципе, физических препятствий для роста энергоэффективности аппаратной основы нейроморфных вычислений не существует. Мы уже обращались к идее использования фотоники (вместо микроэлектроники либо вместе с ней) для экономии энергии при решении связанных с машинным обучением (МО) задач — и это направление довольно последовательно реализуется по всему миру. В частности, исследователи из пекинского университета Цинхуа совместно с китайским же Национальным исследовательским центром в области информационных наук и технологий представили весной 2024 г. Taichi — микрочип, созданный по принципам фотоники для организации оптических нейросетей. Комбинируя интерференционный и дифракционный подходы к обработке оптического сигнала, один многочиплетный Taichi способен обеспечивать работу нейросети почти с 14 млн рабочих параметров. В результате демонстрируемая им точность распознавания более чем 1,5 тыс. рукописных знаков из полусотни различных алфавитов (взятых из хорошо известной в МО-кругах базы Omniglot) достигает почти 92%. Помимо дискриминативных ИИ-задач, Taichi позволяет решать и генеративные — такие как создание музыки в стиле Баха или пейзажей в духе Ван Гога. По сравнению с Nvidia H100 этот основанный на принципах фотоники вычислитель, как утверждают его разработчики, в тысячу с лишним раз энергоэффективнее — и вот, казалось бы, верный путь, которым и должны в обозримой перспективе следовать аппаратные средства нейроморфного компьютинга.

Увы, в практическом плане с Taichi пока далеко не всё гладко — и по целому ряду причин подобные технологии могут пока лишь претендовать на лавры сменщиков полупроводниковых микропроцессоров, в том числе и для сложных ИИ-вычислений. Сам чип решает классические для МО задачи категории «умножение матрицы на вектор» эффективно и быстро, занимая притом весьма скромную площадь — вполне сопоставимую с габаритами кремниевого ускорителя, что лежит в основе той же H100. Однако, чтобы подать на вход Taichi необходимые данные в пригодном для обработки на нём виде световых импульсов с определёнными характеристиками, а затем считать результаты проведённых расчётов на выходе и преобразовать в электрические сигналы для дальнейших операций над ними, требуется изрядное количество довольно громоздкой и энергетически прожорливой машинерии — такой как лазеры и высокочастотные фильтры.

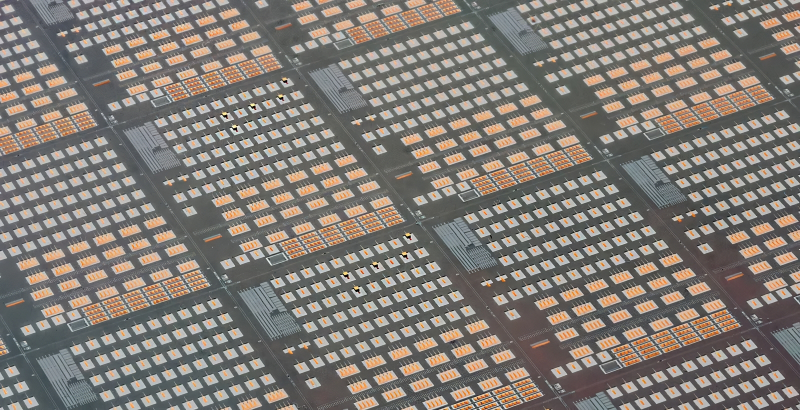

Одно из важнейших ограничений кремниевой фотоники — невозможность литографировать генератор оптического когерентного излучения (лазер) на кремниевой подложке; по этой причине микро- и нанолазеры приходится создавать отдельно, а после интегрировать на пластину-заготовку с оптическими схемами (по методу flip-chip, например; на приведённом фото лазерные модули — крупные тёмно-серые ребристые блоки), что и не упрощает изготовление таких чипов, и не удешевляет его (источник: IEEE Spectrum)

В итоге вся установка, построенная вокруг одного-единственного такого чипа, в полной комплектации поместится уже разве что на письменный стол. Безусловно, исследователи работают над сокращением габаритов и энергоёмкости своей системы — но пока что фотоника как аппаратная основа для нейроморфных вычислений явно не стоит на первом месте в ряду потенциальных сменщиц фоннеймановских полупроводниковых компьютеров. Вот если от гибридных электронно-оптических схем удастся перейти к чисто фотонным, тогда разговор пойдёт иной; но пока это дело довольно отдалённого будущего.

Прежде чем переходить к описанию более практичных реализаций нейроморфных вычислителей, ненадолго погрузимся в особенности конструкции природных, биологических нейросетей. Любая клетка, не исключая и нервных, отграничена от окружающей среды мембраной. За счёт наличия такой границы и регулируемых проходов (каналов) в ней физико-химические свойства внутреннего и внешнего пространства клетки могут довольно заметно отличаться. В частности, концентрация и состав ионов на внутренней и внешней поверхностях мембраны у клетки, которая пребывает в спокойном состоянии, различны (при этом суммарный заряд всех ионов внутри нормальной клетки в спокойном состоянии равен, разумеется, нулю — просто на мембране удерживаются различные их виды и в разном количестве; как изнутри, так и снаружи). С точки зрения физики это автоматически ведёт к появлению стабильной разности потенциалов на границе между внутренним объёмом клетки и окружающей её средой — около 70-90 мВ по абсолютной величине и с отрицательным знаком.

Простейший нервный импульс (область с отрицательным зарядом снаружи мембраны и положительным внутри), распространяющийся по поверхности аксона (заряд внешней стороны которой исходно положителен) за счёт изменения трансмембранного потенциала (источник: Wikimedia Commons)

Так вот, под воздействием разнообразных стимулов — чаще всего для нервной клетки это химические сигналы, поступающие через синапс, — мембранный потенциал может меняться. Изменение — обычно оно проявляется как кратковременное локальное замещение положительного внешнего заряда отрицательным — инициируется в определённой точке мембраны и распространяется по её поверхности. Термины «положительный» и «отрицательный» здесь относительные: сравниваются потенциалы внешней и внутренней сторон мембраны на каждом конкретном участке. Процесс такого распространения возбуждения по поверхности мембраны, иначе волна возбуждения, называется потенциалом действия (или попросту спайком, — калька с англоязычного термина spike). И это одно из ключевых понятий для нейрофизиологии, поскольку именно таким образом транслируются по биологической ткани информационные сигналы — нервные импульсы.

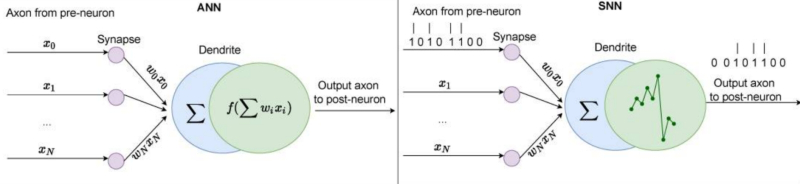

С точки зрения нейроморфных систем важно, что потенциал действия порождается в нервной клетке по достижении определённого уровня деполяризации (т. е. выхода на некое пороговое положительное значение) нейронной мембраны. Известный в нейрофизиологии ещё с XIX века закон «всё или ничего» (all or nothing) гласит, что мембрана клетки возбудимой ткани либо не отвечает на стимул совсем, либо отвечает с максимально возможной для неё на данный момент силой — разумеется, это в идеальном, модельном случае; с реальными клетками всё чаще всего гораздо сложнее. Так или иначе, закон «всё или ничего» оказался удобнейшей математической абстракцией, которая легла в основу целого класса искусственных нейросетей, по понятной теперь причине называемых спайковыми, или импульсными (spiking neural networks, SNN). От перцептронов рассматривавшихся нами прежде «обычных» искусственных нейронных сетей (называемых в англоязычной литературе просто artificial neural networks ANN) спайковые отличаются как по типу входных сигналов, так и по способу реализации в «теле» искусственного нейрона функции его срабатывания.

Схематические изображения принципов действия перцептронов «обычной» искусственной нейросети (ANN) и импульсной (SNN) (источник: PubMed)

Общий принцип действия перцептрона, напомним, — выдавать по единственному выходу определённый сигнал в зависимости от того, какие сигналы поступают на его многочисленные входы. Зависимость эту определяет функция активации, в роли которой для перцептронов ANN могут выступать «ступенька» Хевисайда, сигмоида, гиперболический тангенс, ReLU и другие. Входящие аргументы этих функций — модифицированные весами сигналы — рассматриваются как величины непрерывные, и в целом полносвязная глубокая (т. е. с числом внутренних — скрытых — слоёв, превышающим два) искусственная нейросеть имеет дело как раз с непрерывными (в частном случае — фиксированными) потоками данных на входе. И это крайне полезно для множества приложений ANN, включая распознавание образов. Картинка — даже если это один из кадров видеотрансляции — стационарна; каждый её пиксел, попадающий на вход свёрточной, к примеру, нейросети формирует сигнал с определёнными постоянными параметрами (яркость, цветовая композиция) — и обрабатывать её нейросетью, оперирующей непрерывными величинами на входе, оказывается чрезвычайно просто.

Но биологическая нервная ткань работает принципиально иначе! Потенциалы действия распространяются в ней как единичные импульсы, разделённые определёнными временными интервалами. Это сказывается на характере работы нейросети в целом: скажем, слишком часто идущие один за другим импульсы детектироваться ею не будут (и реакция на них в нейронах, соответственно, не сформируется) — поскольку приёмник, представляющий собой участок мембраны дендрита под соответствующей синаптической щелью, не успеет вернуть свой электрический потенциал в исходное значение, чтобы произвести очередное срабатывание в ответ на слишком быстро поступивший новый сигнал.

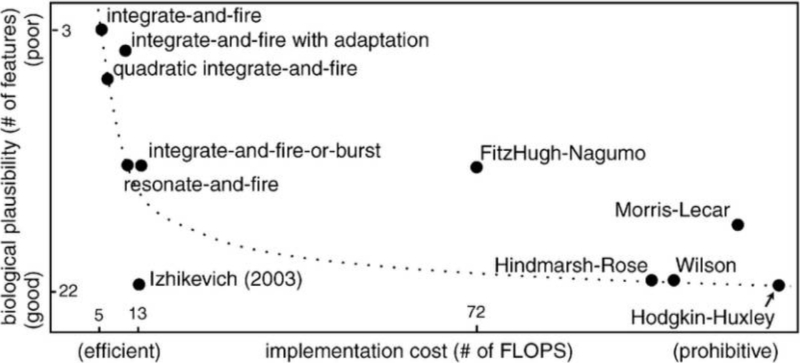

От идеи воспроизвести такое поведение нервной ткани искусственными средствами логично вытекает концепция импульсной нейронной сети, первый математически обоснованный подход к которой — Hodgkin-Huxley (HH) Spiking Neuron Model — был предложен Аланом Ходжкином (Alan Hodgkin) и Эндрю Хаксли (Andrew Huxley) ещё в 1952 году. Перцептроны в такой сети обрабатывают не непрерывные входящие величины, а последовательности единичных импульсов, применяя для этого системы обыкновенных дифференциальных уравнений различной степени сложности. Собственно HH-модель (построенная Ходжкином и Хаксли на материале наблюдений над тем, как на всём протяжении мембраны гигантского аксона кальмара меняются концентрации ионов калия и натрия по мере распространения потенциала действия) до сих пор остаётся одной из наиболее точных в плане соответствия биологическому прототипу. Однако сегодня она почти не используется из-за своей крайне высокой вычислительной сложности, — к настоящему времени разработано немало более практичных реализаций SNN.

Различные модели SNN в координатах «цена реализации — биологическая достоверность» (источник: PubMed)

Говорить о «практичности» таких реализаций имеет смысл как раз в том случае, когда модели эти эмулируются в цифровом виде на фон-неймановских компьютерах, — и можно точно измерить затрачиваемые на исполнение той или иной вычислительные ресурсы. Представляется, что на подходящей аппаратной основе импульсные искусственные нейросети должны функционировать с куда более высокой эффективностью — если не ровно с такой же, как биологический мозг, то по крайней мере заметно превосходя по этому параметру эмуляцию на обычных x86- или ARM-серверах с полупроводниковыми процессорами.

Заметим, кстати, что непременно отказываться от полупроводниковой микроэлектроники, чтобы создать подлинно нейроморфный компьютер, не так уж и необходимо. «Мозгоподобные» структуры вполне реально создавать и путём фотолитографирования на кремниевой основе, — другое дело, что существенным ограничением здесь выступает принципиальная нехватка пространственной связности между отдельными перцептронами. Биологические нейроны в составе мозга могут иметь тысячи синаптических связей с соседями (иногда физически разнесёнными на довольно значительные расстояния), тогда как плоские полупроводниковые структуры, сформированные на поверхности кремния, вынуждены полагаться для обмена информацией на металлические шины межсоединений — которые литографируются последовательно во всё более вышележащих слоях интегральной микросхемы. Чем больше слоёв, тем выше вероятность возникновения ошибок/неточностей при изготовлении чипа, плюс тем сложнее проектировать оптимальные по длине (ведь время задержки при прохождении сигнала тоже имеет значение!) контакты между отдельными перцептронами. В результате полупроводниковые искусственные нейроны, выполненные классическими средствами, могут похвастать лишь десятками, в лучшем случае сотнями синаптических связей с соседями, — чего для подлинно универсальной нейроморфности откровенно недостаточно. А если учесть ещё и чудовищное теплорассеяние полупроводниковых приборов в ходе вычислений…

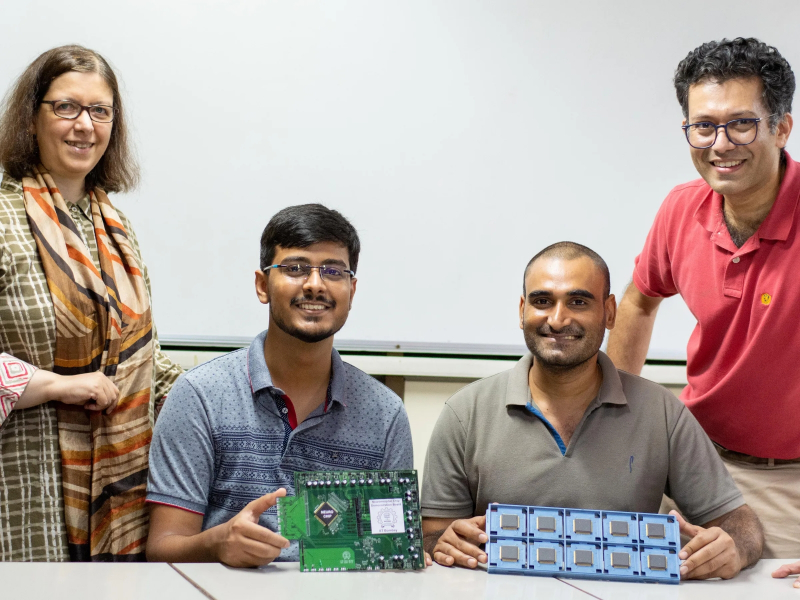

Группа индийских исследователей позирует с инженерными прототипами своих нейроморфных BTBT-вычислителей (источник: Indian Institute of Technology, Bombay)

Инженеры и учёные-микроэлектронщики, конечно же, не признают окончательного поражения в этой области — и регулярно предлагают новые пути развития полупроводниковой нейроморфики. Так, в 2022 г. группа из Индийского института технологий в Бомбее (Мумбаи) предложила остроумный и весьма экономный (в плане расходования энергии) метод построения нейроморфной — а именно, импульсной — перцептронной сети на полупроводниках с использованием эффекта межзонного туннелирования (inter-band или band-to-band-tunneling, BTBT). Интересно, что для классических полупроводниковых приборов этот квантовый эффект рассматривается как крайне нежелательный, поскольку выступает одной из причин появления паразитных утечек между стоком и истоком (а точнее — из валентной зоны истока в зону проводимости стока) в запертом транзисторе.

Идея индийских исследователей заключается в том, чтобы составить (пока на одной плоскости, в качестве подтверждения концепции) из заведомо подверженных эффекту BTBT конденсаторов прямоугольную матрицу, к каждому узлу которой подводится входная шина — для передачи на конденсатор заряда. После накопления его до определённой величины происходит межзонное туннелирование — и весь этот заряд полностью, что важно, по выходной шине перетекает далее по схеме искусственной нейросети; на следующий перцептронный слой, например. В результате формируется как раз импульсный поток данных — даже если на входе в первый слой конденсаторов они (в виде поступающего в цепь электротока) были непрерывными, — а отправивший данный импульс в дальнейшее путешествие конденсатор «обнуляется», переходя в состояние готовности к новому наполнению.

Предложенная схема привлекательна сразу с нескольких точек зрения, и прежде всего — с энергетической. Поскольку речь идёт о квантовом эффекте, для его проявления нужны сравнительно слабые токи, протекающие через достаточно миниатюрные полупроводниковые приборы. Тем самым заодно оказывается решён вопрос компактификации нейроморфного вычислителя: его изначально попросту придётся выполнять фотолитографическим способом, пусть и с применением достаточно зрелых технологических процессов, — поскольку у полупроводниковых конденсаторов куда строже ограничения снизу на допустимые габариты, чем у транзисторов. Так, инженерный прототип описываемого SNN-чипа изготовили на контрактной фабрике по «45-нм» производственным нормам.

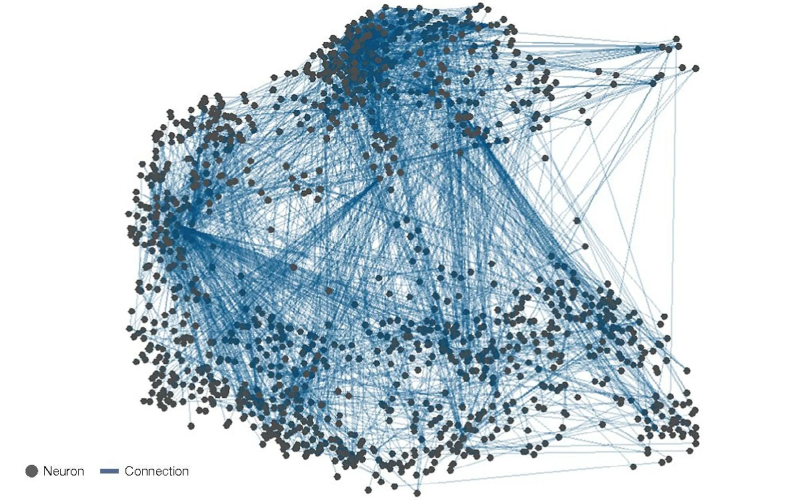

Просто для понимания масштаба задач, что стоят перед создателями нейроморфных вычислителей: на схеме — коннектом (карта межсоединений) нейронов в наиболее плотном участке нервной системы дрозофилы. Всего лишь дрозофилы! (источник: Nature Physics)

Попытки реализовать импульсную нейросеть на классических полупроводниковых устройствах (в которых BTBT-эффект рассматривается не иначе как паразитный) давно предпринимаются, но в широкую серию получаемые устройства не идут — в немалой степени по причине своей значительной энергоёмкости. Индийская же разработка, по утверждению исследователей, самым принципиальным образом повышает эффективность нейроморфных вычислений: пиковая энергия искусственного потенциала действия, распространяющегося по такой конденсаторной SNN, оказывается в пять тысяч раз меньше, чем для аналогичных полупроводниковых систем, где главную роль играют транзисторы (и выполненных по схожим технологическим нормам), а энергопотребление одиночного узла в состоянии покоя — на порядок ниже. Для демонстрации практической применимости своей идеи группа из Индийского института технологий организовала малую BTBT-нейросеть (20 кодирующих сигнал искусственных нейронов и ещё 36 для его обработки), вдохновившись устройством слуховой коры головного мозга, — и добилась, по их утверждению, уверенного распознавания произносимых экспериментаторами слов даже на столь скудной аппаратной базе.

У нейроморфных вычислений — и вычислителей — есть сегодня, конечно, немало проблем; причём едва ли не важнейшая среди них — ограниченная область применимости. Так, упомянутая уже задача распознавания образов куда лучше (а именно — точнее и быстрее) решается более привычными глубокими ANN, оперирующими непрерывными величинами на входах перцептронов, и даже кардинальный выигрыш в энергоэффективности не становится решающим аргументов в пользу SNN. Другое дело — прямая имитация биологических нервных структур: здесь импульсным нейросетям поистине нет равных (индийский пример с моделью участка слуховой коры это напрямую подтверждает). И вот на этом направлении — на пути претворения в реальность самых смелых научных фантазий об искусственном разуме, о пресловутом сильном искусственном интеллекте, — за ними определённо большое будущее.

- Учёные создали новый элемент квантовой памяти — сверхпроводящий микроволновый мемконденсатор

- SpiNNcloud представила первый коммерческий «нейроморфный суперкомпьютер» SpiNNaker2 на базе Arm

- Intel представила нейроморфный компьютер Hala Point на 1152 чипах Loihi 2 с мозгоподобной архитектурой

- В Южной Корее создан сверхэффекттивный ИИ-чип, сочетающий классический и нейроморфный подходы

- В Австралии появится нейроморфный ИИ-суперкомпьютер DeepSouth для имитации человеческого мозга