Стр.1 - nForce 790i ULTRA SLI

На днях, с интервалом в один день, компанией NVIDIA были анонсированы новые "двухголовые" видеокарты GeForce 9800GX2 (на базе хорошо себя зарекомендовавшего графического процессора G92) и набор логики nForce 790i SLI / nForce 790 Ultra SLI с поддержкой новейших процессоров от компании Intel в связке с оперативной памятью DDR3. Оба продукта очень интересны, поскольку в ближайшее время именно они будут задавать тон в сегменте высокопроизводительных игровых компьютеров.

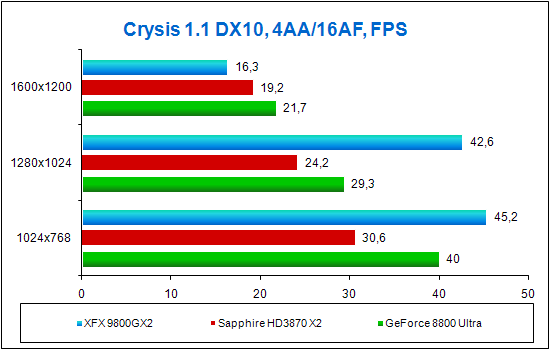

Да, именно так, поскольку в плане производительности конкурентов у новой платформы на данный момент нет. Как же так, спросите вы, а как же AMD Radeon HD3870 X2? Увы, но

наше тестирование показало, что нынешняя "топовая" видеокарта AMD не может справиться даже с одной GeForce 8800 Ultra, поэтому нетрудно предугадать, каков будет результат в схватке даже с одной GeForce 9800GX2. Тем более, что на практике новая NVIDIA-видеокарта является "склейкой" двух GeForce 8800GTS 512, подробнее о которых вы можете узнать из

нашего предыдущего обзора.

Но давайте не будем больше говорить про "конкурентов", приступим к знакомству с представленным 18 марта набором системной логики nForce 790i SLI от компании NVIDIA под новые 45 нм процессоры Intel.

Чипсет существует в двух версиях, одна из которых призвана удовлетворить "простых смертных" и ограничивается поддержкой памяти DDR3-1333, а вторая, с индексом "Ultra", предназначена для "продвинутых" пользователей, для которых разгон - норма жизни. Таким образом, чипсет NVIDIA nForce 790i Ultra SLI поддерживает оперативную память DDR3 с эффективной частотой до 2000 МГц и выше, и, как нетрудно догадаться, более лоялен к разгону, чем его "младший брат".

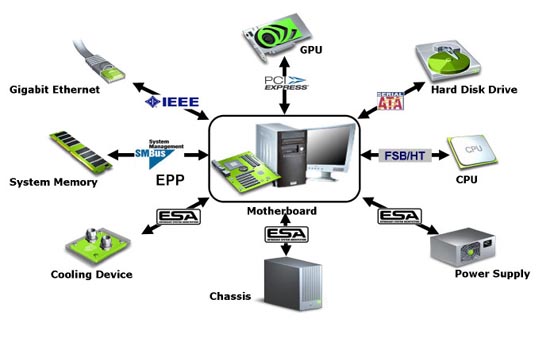

Для помощи пользователям в разгоне, точнее, в настройке модулей памяти на частоту свыше 1333 МГц, новый чипсет поддерживает вторую версию "оверклокерских" настроек памяти - EPP 2.0. Как и в случае с первой версией EPP, информация с настройками EPP 2.0 хранится в чипе SPD-модулей оперативной памяти. Такие модули носят титул "SLI-ready", и, установив их в материнскую плату с чипсетом nForce 790i SLI, вам всего лишь потребуется выставить разрешающую "галочку" напротив соответствующего пункта настроек в BIOS.

Следует заметить, что на этом отличия нового чипсета от собрата nForce 780i SLI, поддерживающего только память DDR2, заканчиваются. Поэтому, учитывая нынешнюю дороговизну модулей памяти DDR3, пока не стоит списывать предшественника со счетов. Впрочем, вы и сами можете убедиться в этом, для чего приведём сводную таблицу с характеристиками.

Для более наглядного представления о том, из чего состоит и чего умеет новый чипсет, рассмотрим соответствующую блок-диаграмму.

Первым обращает на себя внимание тот факт, что лишь два графических слота PCI Express x16 из трёх относятся ко второй версии этой шины, поскольку третий слот реализован силами не северного, а южного моста чипсета. Получается, что выпустив новый северный мост, компания NVIDIA представила его с практически прежней версией южного моста. Ничего страшного в этом нет, поскольку все "вкусности" поддерживаются именно северным мостом чипсета, а южный мост и без того в полной мере обеспечивает поддержку всего необходимого, например, дополнительных линий PCI-Express, десять портов USB, шесть накопителей SATA2 и так далее. Кстати говоря, такой нюанс никак не повлияет на наше сегодняшнее тестирование, поскольку три слота PCI Express x16 требуются для технологии 3-way SLI,

а нам необходимо лишь два слота PCI Express x16.

Компания NVIDIA приводит фотографию референсной материнской платы с двумя установленными видеокартами 9800GX2; именно такую систему мы будем сегодня тестировать.

Следует отметить ещё одно нововведение компании NVIDIA - технологию ESA.

"Системная архитектура для энтузиастов" - именно так можно перевести расшифровку аббревиатуры ESA (Enthusiast System Architecture) на русский язык. Идея нововведения в том, что диагностика, контроль и управление ключевыми устройствами системы теперь будут осуществляться с помощью единого протокола.

Результатом этого станет возможность контроля этих устройств как единой общности, то есть при помощи единой программы. Конечно же, такой программой стала фирменная утилита от компании NVIDIA, а именно NVIDIA System Tool.

Давайте знакомиться с первым участником сегодняшнего тестирования - материнской платой от XFX на базе чипсета nForce 790i ULTRA.

Лицевая сторона коробки от материнской платы лаконична - никаких монстров, только техническая информация. Отдельным пунктом отмечена поддержка технологии 3-way SLI, FSB 1600/1333 и PCI Express 2.0.

Обратная сторона коробки содержит фотографию самой материнской платы и её технические спецификации.

Комплектация материнской платы разложена по двум отсекам. В первом отсеке находится сама материнская плата и вывеска "Не входить, я играю" для ручки двери, а во втором отсеке уложены аксессуары для материнской платы.

Содержимое второго отсека тоже разделено на несколько частей. В бумажной папке лежит руководство пользователя и CD с драйверами, в полиэтиленовом пакете сложены различные кабели, а отдельно вынесены заглушка в корпус для материнской платы, вентилятор и два SLI-мостика, один для "тройного" SLI, другой для обыкновенного, "двойного".

В полиэтиленовом пакете, как мы уже сказали, находятся различные кабели, а именно:

- шесть SATA-кабелей;

- три переходника питания для SATA-накопителей с возможностью подключения до двух устройств на переходник;

- скругленные IDE- и FDD-шлейфы;

- планка с четырьмя разъёмами USB;

- планка с одним разъёмом FireWire 1394.

Материнская плата оснащена системой охлаждения на тепловых трубках, которая может работать как в пассивном, так и в активном режиме. Именно для второго случая предусмотрен небольшой вентилятор, идущий в комплекте. Новинка поддерживает четыре модуля памяти типа DDR-3 с эффективной частотой вплоть до 2000 МГц.

Для поддержки трёх видеокарт на материнской плате предусмотрено три разъёма PCI Express x16, средний принадлежит к первому поколению этого интерфейса. Поэтому при установке двух видеокарт необходимо воспользоваться крайними слотами, что, кстати, благоприятствует их охлаждению. Помимо трех слотов PCI Express x16, на материнской плате присутствует два слота PCI Express x1 и два обычных PCI-слота.

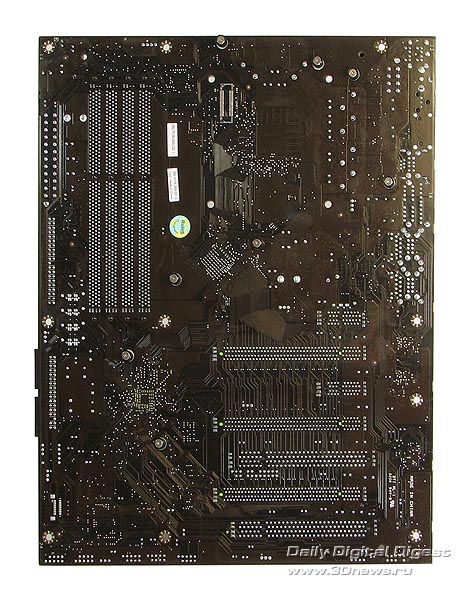

Обратная сторона материнской платы не может похвастаться ничем примечательным вроде радиаторов для лучшего охлаждения и жесткости.

Интерфейсная панель платы содержит следующее:

- два PS/2-разъёма для клавиатуры и мыши;

- электрический и оптический выход S/P-DIF;

- разъём для подключения E-SATA-накопителя;

- шесть портов USB 2.0;

- один порт FireWire 1394;

- два разъёма RJ-45 с поддержкой гигабитных сетей;

- звуковые разъёмы.

На этом закончим знакомство с материнской платой и посмотрим на оперативную память.

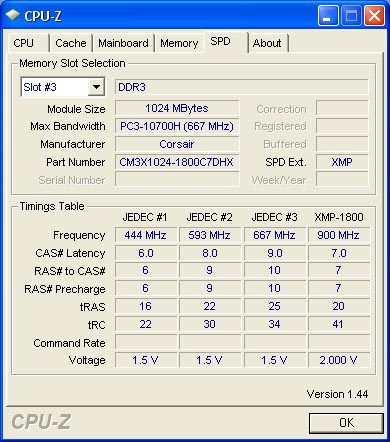

Благодаря поддержке российского представительства компании Corsair Memory, аккурат к этому тестированию в нашей лаборатории появились два модуля Corsair Dominator PC14400, ёмкость каждой из которых составляет 1 Гб.

Помимо двух модулей памяти, в комплектацию входит устройство для их охлаждения и крепление для него.

Надпись "Intel Extreme Memory" означает поддержку данными модулями расширений XMP, ставшими добавлениями к обычным настройкам SPD и поддерживаемыми новейшими чипсетами от Intel. Поскольку компания NVIDIA использует для оперативной памяти расширения EPP 2.0 и не поддерживает XMP, модули памяти в "оверклокерский" режим нам придётся настраивать вручную.

Это не проблема, поскольку вся необходимая информация о таймингах и номинале питающего напряжения указана на наклейках каждого модуля.

Стр.2 - XFX GeForce 9800GX2

Теперь перейдём к наиболее интересному - видеокартам XFX GeForce 9800GX2.

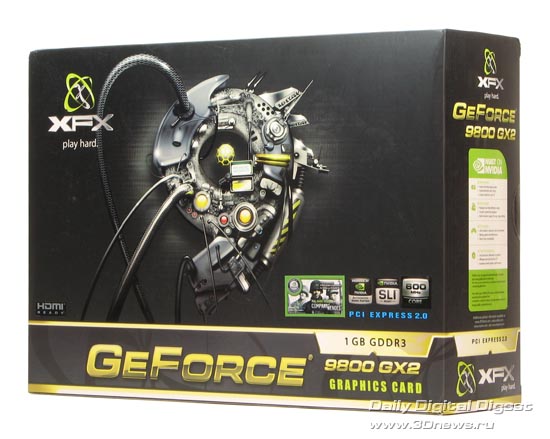

Упаковка видеокарты XFX GeForce 9800GX2, так же, как и у материнской платы, не изобилует монстрами и прочей нечистью, а украшена изображением какого-то хитрого механизма. Из технических характеристик упомянута поддержка HDMI, частота ядра - 600 МГц, 1 Гб памяти и шина PCI Express x16 второго поколения.

Обратная сторона коробки содержит много информации рекламного характера. А вот важная информация о требованиях к блоку питания почему-то оказалась на днище коробки - можно и не заметить. Производитель заявляет, что для одиночной видеокарты XFX GeForce 9800GX2 требуется блок питания мощностью 630 Вт, а для двух видеокарт потребуется чуть больше - 680 Вт. Хотя нетрудно догадаться, что если вы используете качественный блок питания, то можно обойтись и меньшими мощностями. Но, как показал наш опыт, именно с блоком питания пользователя ожидает подвох, об этом чуть позже.

По всей видимости, производитель счёл, что в видеокарте самое главное - это сама видеокарта, а не её комплектация, поскольку последняя оказалась весьма скромной:

- переходник питания для видеокарт PCI-express;

- два переходника DVI > D-sub;

- полная версия игры Company of Heroes;

- вывеска на дверь "Не входить, я играю";

- CD с драйверами;

- руководство пользователя.

Видеокарта получилась большой и увесистой. Чёрный металлический кожух не только надёжно защищает содержимое новинки, но и придаёт солидности, делая её похожей не на комплектующее устройство для компьютера, а на автономное устройство. Стоит отметить, что из внешних интерфейсов у видеокарты есть только два DVI-порта и один порт HDMI, а "старичок" S-Video канул в лету. Жаль, ведь не у всех пользователей есть телевизоры с интерфейсом HDMI. Хвостовая часть карты с обеих сторон оснащена вентиляционными отверстиями, необходимыми для вентилятора внутри. Горячий воздух из видеокарты выходит преимущественно с торца видеокарты, поэтому надо быть готовым к тому, что в компьютере будет жарко.

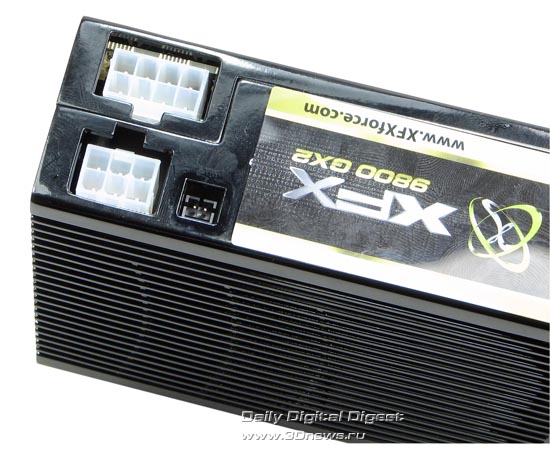

Почти все внутренние разъёмы закрыты заглушками и с непривычки может показаться, что их нет.

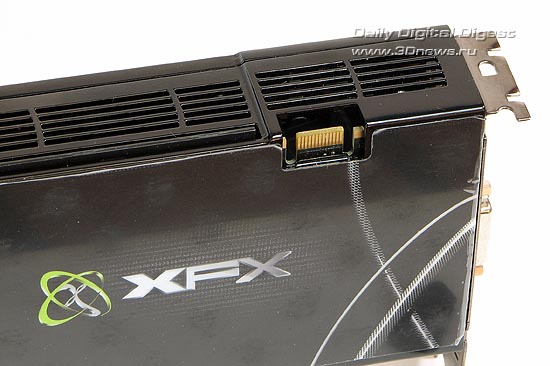

Слева у видеокарты традиционно располагается разъём SLI.

Справа расположено два разъёма питания и вход SPDIF, необходимый для передачи звука по интерфейсу HDMI. Если со звуком всё понятно, то вот с питанием нас ожидал "сюрприз". Как вы, наверное, заметили, один из разъёмов питания видеокарты 8-контактный. Подобное мы с вами уже видели в видеокартах Radeon HD2900 / HD3870 X2, но в отличие от них разъём у GeForce 9800GX2 оказался несовместим с 6-контактными разъёмами! Более того, в комплекте с видеокартой всего один переходник питания при двух разъёмах у самой карты, плюс, еще и не тот, что надо. На наше счастье, в нашей тестовой лаборатории был блок питания HIPER 880 Вт с двумя 8-контактными разъёмами питания для карт PCI Express, поэтому проблем с подключением у нас не возникло. А вот как быть тем пользователям, чьи блоки питания не располагают такими разъёмами - загадка.

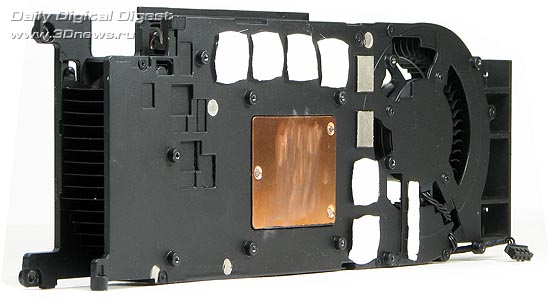

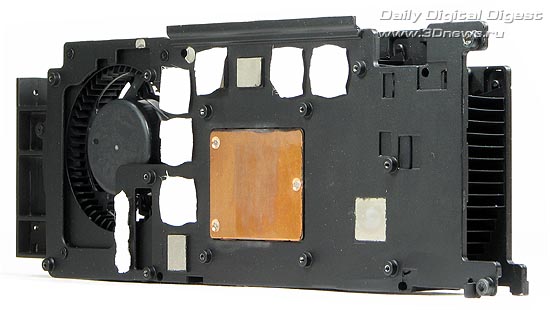

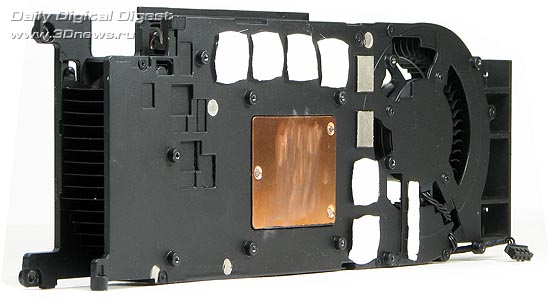

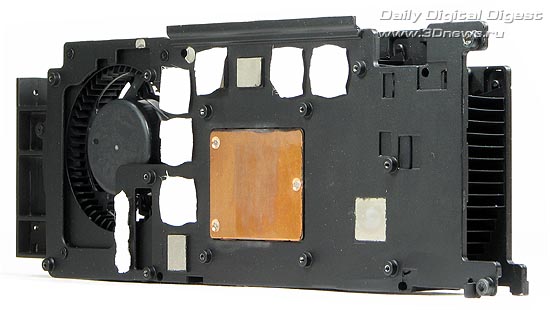

Давайте познакомимся с видеокартой поближе. Снимаем металлический кожух…

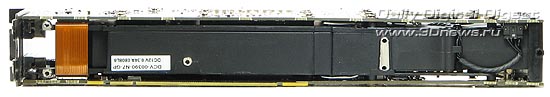

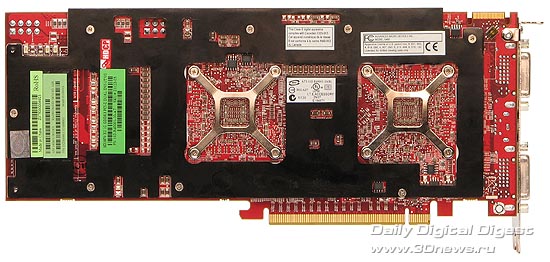

Нашему вниманию предстаёт "бутерброд" из двух печатных плат черного цвета, облаченных в нежное сердечко… тьфу, прикрепленных к единой системе охлаждения. Для всасывания воздуха в хвосте обеих плат сделан вырез.

Это хорошо видно с нижнего торца видеокарты, где, кстати, расположен соединяющий две платы шлейф.

На верхнем торце видеокарты расположены вентиляционные отверстия системы охлаждения. Продолжим экзекуцию.

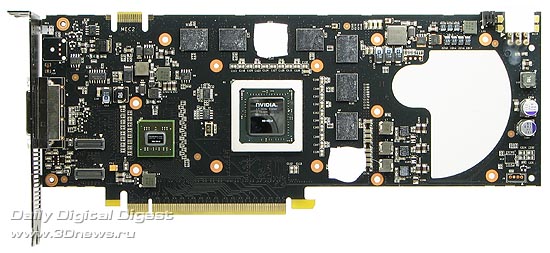

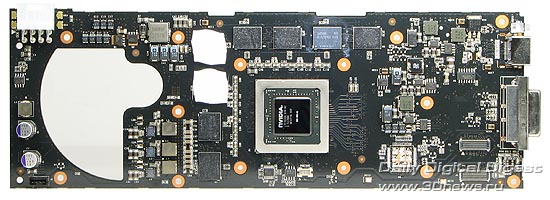

Открутив множество винтов, мы можем осмотреть две платы-половинки, ставшие основой для GeForce 9800GX2.

Каждая из двух плат содержит графический процессор G92 и 512 Мб видеопамяти, набранные из восьми чипов. Плата с разъёмом PCI Express x16 содержит фирменный чип-коммутатор, необходимый для согласования сигналов от двух графических процессоров и системной шины.

А вот тот самый соединительный шлейф, то есть шлейфы, отдельно. Заметим, что их надо подключать в определённой последовательности (или направлении - как вам угодно), иначе видеокарта не заработает. В этом мы убедились на собственном опыте.

Тема "бутерброда" прослеживается во всей конструкции видеокарты. Вот и система охлаждения, как и сама видеокарта, напоминает бутерброд, с тем лишь отличием, что вместо хлеба - алюминий, а вместо масла - контактные площадки и медные вставки. Наш "бутерброд" намазан маслом с двух сторон и, как мы уже отмечали, отводит тепло при помощи обеих сторон. Разобрать радиатор, к сожалению, не получилось - просто побоялись сломать, так как добровольно "открыться" он не захотел. Зато разглядеть его строение удалось - радиатор состоит из алюминия, алюминиевых лопастей, медных тепловых трубок и медных вставок. Принцип действия прост - от медных вставок, которые контактируют с графическими чипами, распределяется тепло по всему радиатору, и делают это тепловые трубки. Середина конструкции продувается единым вентилятором, который вы можете видеть в хвосте системы охлаждения. Остальные элементы видеокарт, то есть видеокарты, охлаждаются тем же радиатором и контактируют с ним при помощи выступов.

Графический процессор G92 принадлежит к типу G92-450 и имеет ревизию A2. Количество активных универсальных процессоров в чипе равно 128, то есть он ни в чем не урезан.

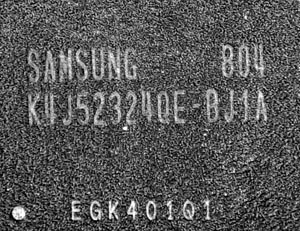

Чипы памяти, коих в видеокарте целых 16 штук, произведены компанией Samsung и имеют время выборки 1 нс, что соответствует эффективной частоте 2000 МГц, на которой они и работают.

Стр.3 - Разгон и тесты под Windows XP

Эффективность системы охлаждения и разгон

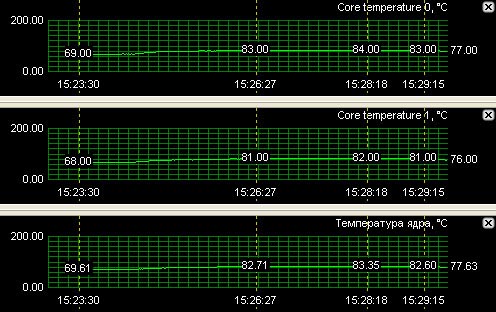

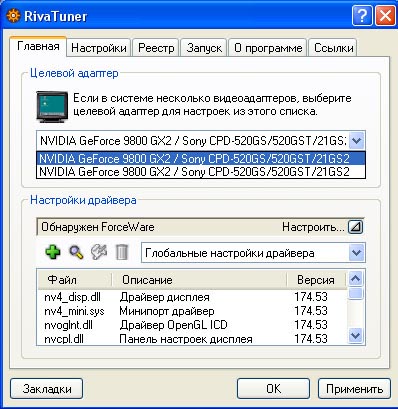

Проверять эффективность системы охлаждения на этот раз мы будем при помощи игры Crysis и программы Riva Tuner 2.08. Итак, у нас получились следующие результаты:

Температура первого графического чипа составила всего 77 градусов. Второй нагрелся чуть меньше, до 76 градусов. Заметим, что первые два значения программа Riva Tuner считывает с датчиков "по умолчанию", а последнее - со встроенного в графический процессор датчика, оно более точное. Видеокарта оказалась отнюдь не тихая, но её шум неназойлив и легко терпим.

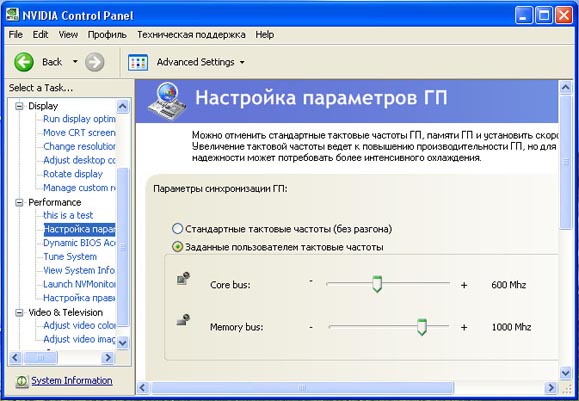

Разогнать видеокарту XFX 9800GX2 оказалось немного сложнее, чем её одночиповых коллег. Так, программа Riva Tuner смогла изменить частоту только одного графического процессора, причем, почему-то, второго. На помощь пришла фирменная утилита nTune,

которая синхронно меняла частоту сразу двух графических процессоров. Режим SLI, конечно же, при этом был включен.

Частоту графических процессоров мы проверяли при помощи программы Riva Tuner, переключаясь между двумя видеокартами.

Штатная частота работы видеокарт составляет 600/1512 МГц для графических процессоров и 2000 МГц - для видеопамяти. Обе видеокарты покорили частоты 740/1836 и 2250 МГц для графических процессоров и видеопамяти соответственно. Неплохо, но одиночная видеокарта GeForce 8800GTS 512, основанная на там же, что и GeForce 9800GX2 графическом процессоре, разгоняется лучше.

Конкурент для GeForce 9800GX2

Фраза "конкурент" всегда звучит загадочно, поскольку в разном контексте она может означать совершенно разные вещи. В нашем сегодняшнем контексте "конкурентом" стала видеокарта AMD на чипе Radeon HD3870 X2. Компания AMD считала и, возможно, по-прежнему считает её самой быстрой видеокартой в мире, но что происходит в реальности, мы выяснили

в нашем предыдущем обзоре. Доля правды в этом есть - видеокарта Radeon HD3870 X2 действительно является самой мощной в ассортименте AMD. Кстати, подобно видеокарте GeForce 9800GX2, видеокарта от AMD тоже построена на базе двух графических процессоров и для их совместного функционирования использует технологию CrossFire. Вот мы и посмотрим, кто из них лидер. Вдруг в новых драйверах компания AMD исправила былые ошибки? Мы очень на это надеемся, а пока давайте познакомимся с типичной платой от партнеров AMD.

В комплектацию видеокарты входят:

- два переходника питания для карт PCI-express;

- мостик для объединения двух видеокарт в режим CrossFire;

- два переходника DVI > D-sub;

- переходник DVI > HDMI;

- переходник S-video > Component out;

- CD с драйверами.

Видеокарта HD3870 X2

уже изучена нами ранее, поэтому мы не будем тратить время на её разборку и тому подобное. Перейдем к самому интересному - тестированию видеокарт.

Тестирование с Windows XP

Описание работы с ОС Windows XP начнём, пожалуй, с фотографии нашей системы, собранной и включенной.

Компания NVIDIA предусмотрела подсветку для видеокарты, так что любители моддинга, да и не только они, останутся довольны. А теперь - о грустном.

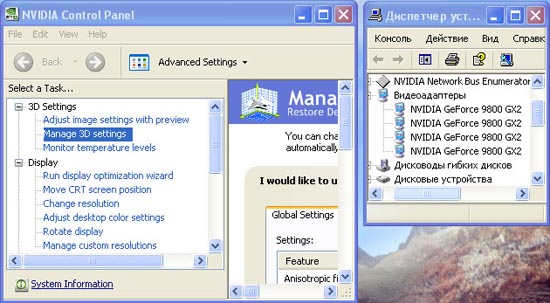

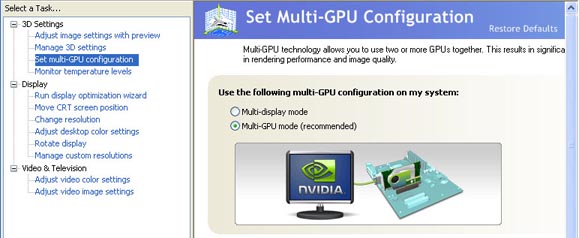

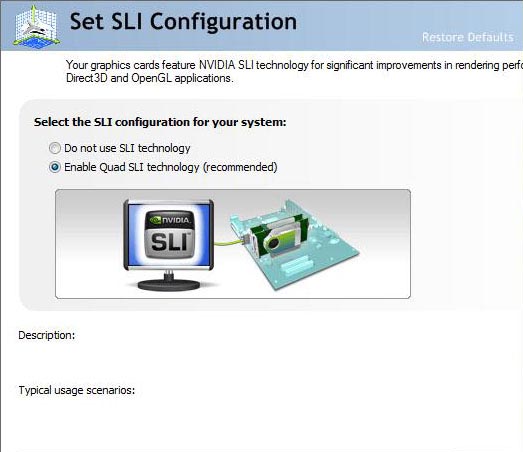

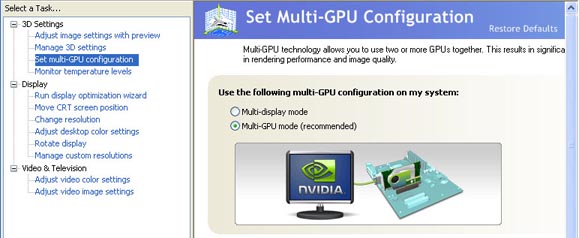

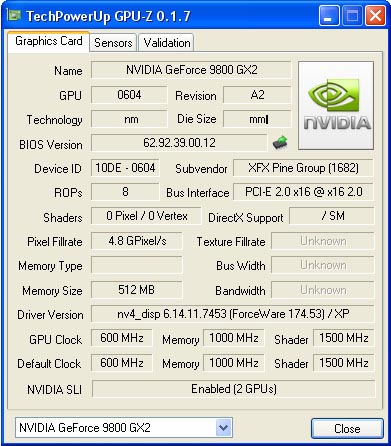

Режим Quad SLI, к сожалению, не работает в Windows XP. Так что он (ведь в одной видеокарте GeForce 9800GX2 фактически расположено две видеокарты, работающие в режиме SLI) стал прерогативой Windows Vista. Что же, в Windows XP мы протестируем одну видеокарту GeForce 9800GX2, а уж потом объединим две видеокарты и протестируем их в Windows Vista. Вынимаем одну видеокарту, загружаем Windows XP и заглядываем в панель управления NVIDIA:

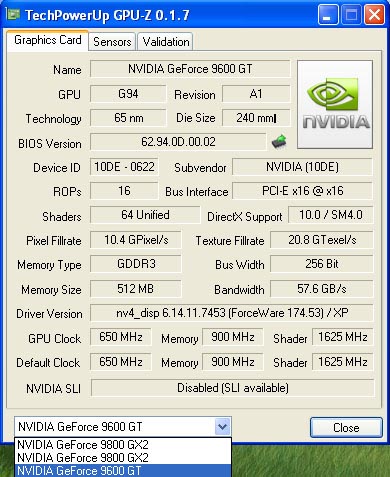

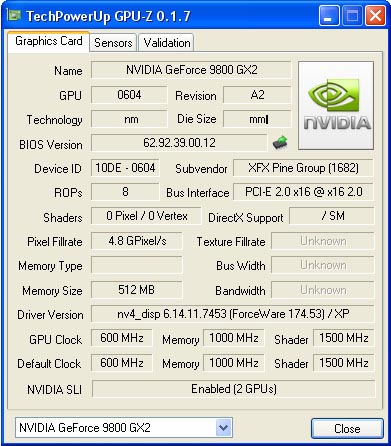

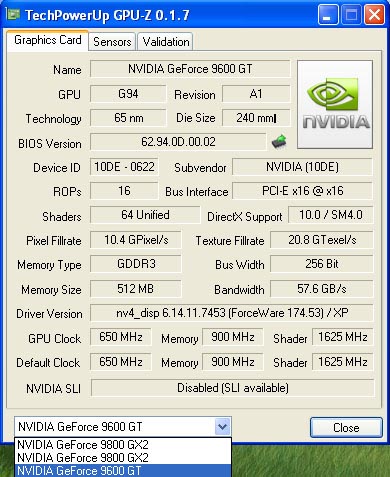

В нём появился пункт для управления режимом SLI. Хотите скорость - включаете, а если хотите более одного дисплея, скажем, монитор + телевизор, то отключаете. Ведь, в отличие от видеокарт Radeon и конкретно ATI CrossFire, технология NVIDIA SLI не позволяет использовать более одного дисплея. Кстати, а что если установить видеокарту GeForce 9800GX2, режим SLI не отключать, а для второго дисплея (монитора, телевизора, проектора и тому подобного) установить вторую видеокарту? Проверим - установим в систему вторую видеокарту GeForce 9600GT и, между прочим, заодно получим порт S-video, который у неё присутствует.

Увы, закладка "SLI multi-GPU configuration" пропала из панели управления NVIDIA, а при помощи программы GPU-Z мы узнали, что режим SLI и вовсе отключился. Таким образом, видеокарта GeForce 9800GX2 после этого работала только в половину мощности, поскольку режим SLI оказался недоступен и для неё. Ситуация объясняется довольно просто - драйверы NVIDIA смотрят на все видеокарты NVIDIA, установленные в системе, и если они не могут работать в режиме SLI, то он полностью запрещается. Кстати, ранее нам удалось включить режим SLI для двух видеокарт GeForce 7800GTX с третьей видеокартой GeForce 6600, установленной в системе. Однако драйвер, посмотрев на GeForce 6600, решил, что мы не использовали SLI-мостик, и запретил его использование. Таким образом, виртуальная недоработка в драйверах обернулась реальным падением производительности двух видеокарт в SLI. Заметим, что в Windows Vista такая же ситуация, и чуда не произошло. Поэтому нам остаётся надеяться на то, что драйверы NVIDIA станут умнее, и подобные тандемы, где режим SLI распространяется лишь на часть видеокарт, будут полноценно функционировать. Правда, есть другой способ - установка видеокарты, отличной от GeForce, например, Radeon. Но в этом случае возникнут проблемы, а в Windows Vista видеокарта Radeon и вовсе не заработает, так как драйверы NVIDIA доминируют (проверено на личном опыте), а операционная система не может функционировать сразу с двумя видеодрайверами. Хотя последнее - это наши догадки, поскольку официального их подтверждения мы так и не получили. Что же, вынимаем видеокарту GeForce 9600GT…

и всё приходит в норму. Режим SLI становится доступным, и видеокарта GeForce 9800GX2 вновь готова работать в полную силу.

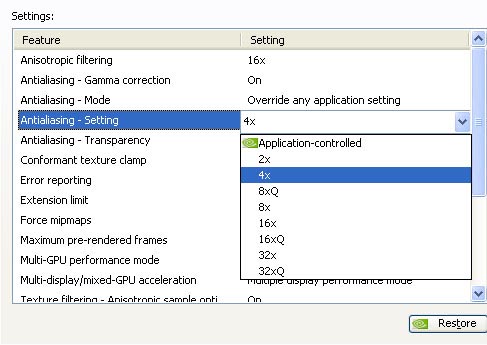

Режим SLI приносит новые высоты в качестве сглаживания - 32xQ. Хотя, пожалуй, практической пользы от этого будет немного.

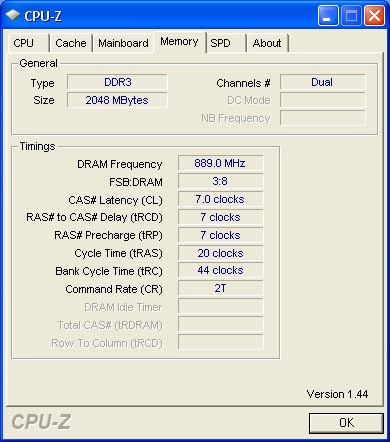

Сделаем небольшое отступление от темы видеокарт. Как вы помните, в нашем распоряжении оказались модули оперативной памяти Corsair Dominator XMS2 с номинальной частотой 1600 МГц при таймингах 7-7-7-20 и напряжении 2.0 В.

Поскольку модули памяти поддерживают расширения XMP, а не EPP 2.0, все необходимые настройки мы сделали вручную.

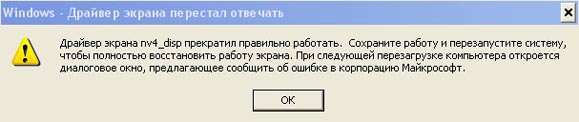

Всё, казалось, было отлично, но при тестировании в программах 3DMark, да и не только в них, периодически происходило следующее:

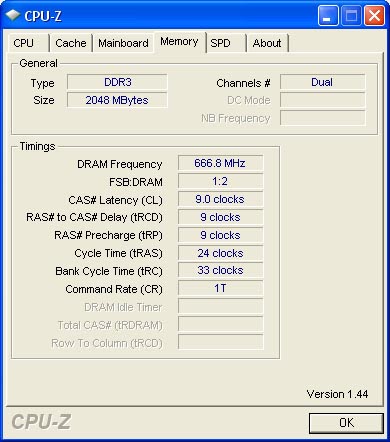

Система сообщала, что видеодрайвер совершил ошибку и был успешно перезапущен. После установки оперативной памяти в автоматический режим всё пришло в норму, и подобного не повторялось.

Материнская плата установила частоту моделей памяти 1333 МГц с таймингами 9-9-9-24. Отличительной особенностью от режима 1800 МГц стал режим 1T, вместо 2T в последнем. Поскольку в режиме 1T память работает быстрее, больших разрывов в быстродействии между двумя режимами быть не должно. Это мы и проверим при помощи программы Everest Ultimate 4.0. Таблицу с полученными результатами приведём ниже.

| Наименование теста | 1800 7-7-7-20-2T | 1333 9-9-9-24-1T |

| Чтение из памяти, Мб/с | 9043 | 9139 |

| Чтение в память, Мб/с | 6084 | 6087 |

| Копирование в памяти, Мб/с | 6748 | 6710 |

| Задержка памяти (латентность), нс | 53,5 | 60 |

Как вы видите, по первым двум показателям память на частоте 1333 МГц в режиме 1T оказалась быстрее, чем на частоте 1800 МГц. Латентность, правда, возросла, но это "не смертельно". Поэтому для тестирования была выбрана частота 1333 МГц, ведь стабильность превыше всего. Иначе представьте, что в нашей системе произошла ошибка, а мы тратим кучу времени только на то, чтобы выяснить, кто виноват - разгон или нет (да, 1800 МГц - это разгон, хотя и гарантированный).

Заметим, что никакого обмана с оперативной памятью нет, и она действительно может функционировать на частоте 1800 МГц, а проблемы в нашем случае вызваны "сырой" BIOS материнской платы. Да и совместимость никто не гарантировал - ведь наш комплект памяти оптимизирован под чипсеты компании Intel. Поэтому перед покупкой советуем вам убедиться в совместимости приобретаемых модулей оперативной памяти и материнской платы. Как правило, это можно сделать на сайте производителя.

По некоторым уточнениям, к моменту массовых поставок BIOS системных плат на чипсете nForce 790i ULTRA будет доведён "до кондиции", так что покупатели розничных изделий без труда смогут включать режим DDR30-2000, разумеется, с модулями, поддерживающими этот режим.

Приступим к тестированию видеокарт. Начнём мы с одиночной видеокарты GeForce 9800GX2, поскольку тестировать её мы будем в Windows XP. Операционная система, конечно, уже устарела и "снята с производства", но очень актуальна и по сей день. Но для начала приведем конфигурацию тестового стенда.

| Тестовый стенд |

| Процессор | Intel Core 2 Quad X6850 3 ГГц |

| Материнская плата | XFX nForce 790i ULTRA |

| Оперативная память | Corsair Dominator DDR3 2x 1 Гб 1333 МГц 9-9-9-24 1T |

| Операционная система | Windows XP+SP2+DirectX 9.0c / Windows Vista для DX10 тестов |

| Блок питания | 880 Вт |

Нами были использованы следующие версии драйверов:

- ForceWare 174.53 - для видеокарты XFX 9800GX2;

- Catalyst 8.3 - для видеокарты HD3870 X2;

- ForceWare 169.21/169.25 - для GeForce 8800Ultra, второго соперника для GeForce 9800GX2.

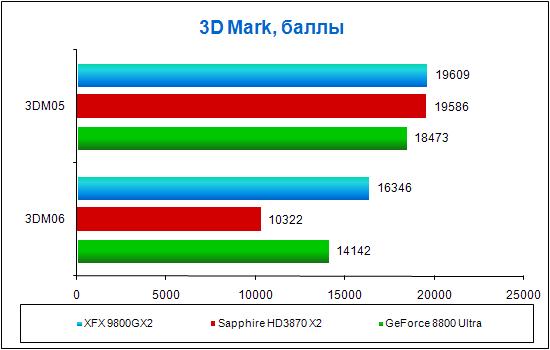

Отметим, что видеокарта GeForce 8800 Ultra по-прежнему является самой мощной однопроцессорной видеокартой, поэтому мы не могли обойти её стороной. Итак, ознакомление с результатами традиционно начнем с тестов 3DMark.

Видеокарта XFX 9800GX2 оказалась сильнейшей, что, в общем-то, не удивительно. Удивительно то, что у видеокарты HD3870 X2 оказались весьма слабые результаты, причем они заметно слабее результатов,

полученных нами ранее. Подозрения пали на неисправность видеокарты, но они не подтвердились, поскольку с драйверами Catalyst 8.1 видеокарта HD3870 показала "правильные" результаты. Вывод - проблема в драйверах.

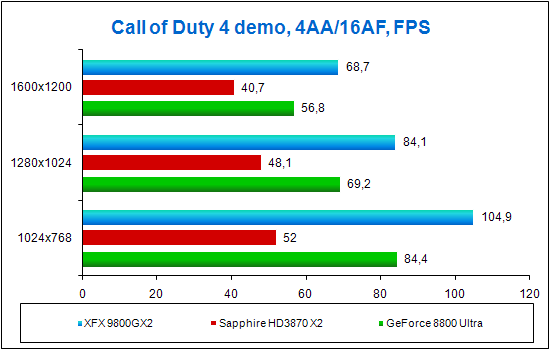

Теперь перейдём к игровым тестам, которые мы проводили с 4-кратным сглаживанием и 16-кратной анизотропной фильтрацией.

В игре Call of Duty 4 новинка от XFX становится лидером. Видеокарта от AMD, к сожалению, заняла последнее место.

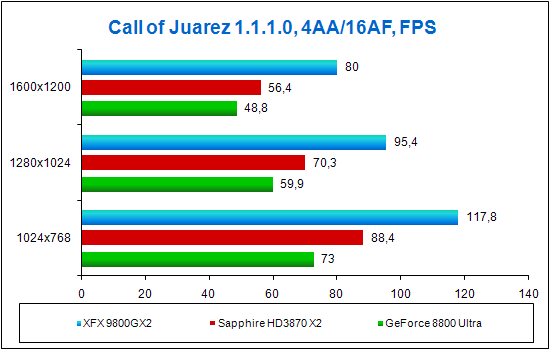

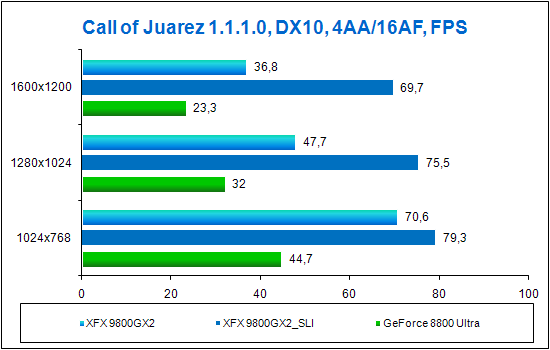

В игре Call of Juarez картина немного изменилась. Хотя видеокарта GeForce 9800GX2 и стала лидером, второе место теперь за видеокартой HD3870 X2. Стоит заметить, что Call of Juarez - из тех игр, где Radeon HD3870 X2, а если углубляться, то технология CrossFire, работают очень хорошо. Но, к сожалению, это касается только Windows XP.

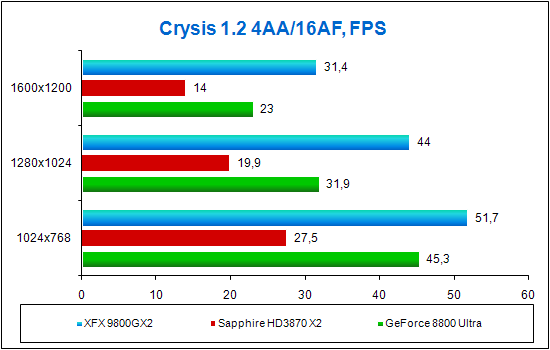

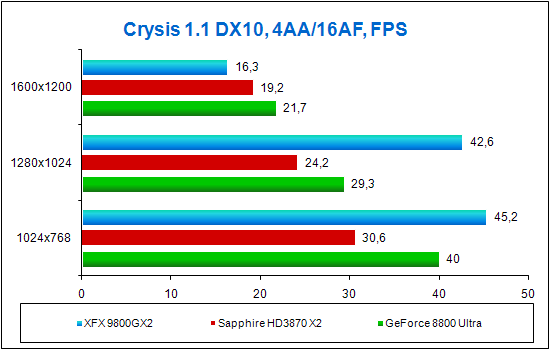

В игре Crysis вновь лидирует XFX 9800GX2, показывая, что компания NVIDIA уделяет должное внимание работе технологии SLI. Компания AMD идёт иным курсом, в результате чего HD3870 X2 показывает плачевные результаты. Что тут скажешь - ждём новые драйверы…

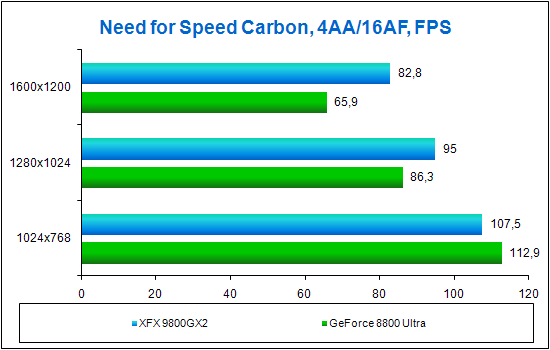

В игре Need for Speed Carbon стало на одного участника меньше. Увы, видеокарта HD3870 X2 с новыми драйверами Catalyst 8.3 в этой игре работала рывками. Что касается видеокарт XFX 9800GX2 и GeForce 8800 Ultra, то при разрешении 1024x768 производительность упёрлась в центральный процессор. Зато при разрешениях 1280x1024 и 1600x1200 видеокарта XFX 9800GX2 лидирует.

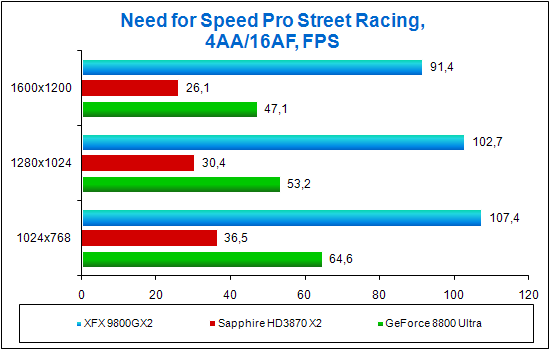

В игре Need for Speed Pro Street Racing лидирует видеокарта XFX 9800GX2, причем со значительным преимуществом. Видеокарта GeForce 8800 Ultra заняла второе место, а вот HD3870 X2 осталась давно позади. Всё дело в том, что в этой игре до сих пор технология ATI CrossFire работает "наоборот", то есть вместо прироста производительности наблюдается её падение по сравнению с одиночной видеокартой.

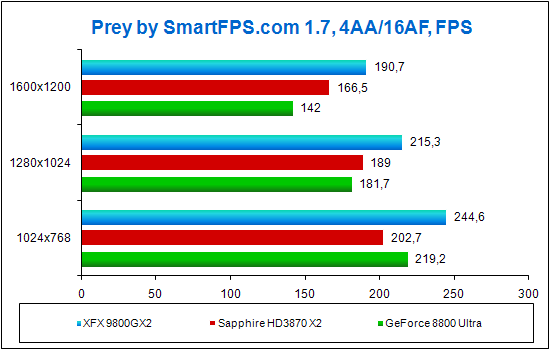

В игре Prey ситуация немного меняется. Видеокарта XFX 9800GX2 вновь лидирует, однако при разрешениях 1280x1024 и 1600x1200 второе место заняла HD3870 X2. Но результаты не более, чем показательные, поскольку производительности всех участниц тестирования более чем достаточно для этой игры.

Стр.4 - Тесты в Windows Vista

Тестирование в Windows Vista

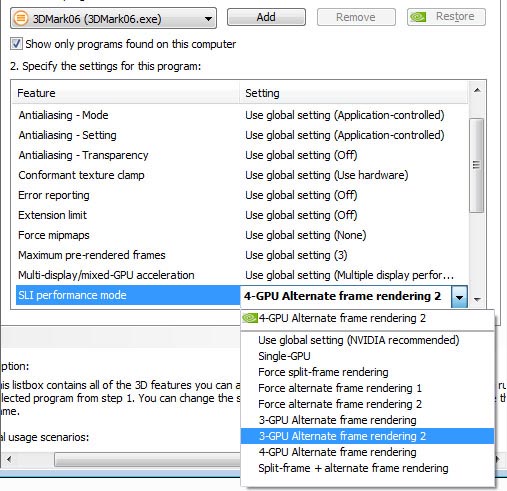

Наконец-то мы подошли к тому, чтобы протестировать две видеокарты XFX 9800GX2 в режиме SLI. Напомним, что технология SLI с тремя или четырьмя графическими процессорами поддерживается драйверами только в Windows Vista. Итак, в нашем случае графических процессоров четыре, и панель управления NVIDIA этого не скрывает.

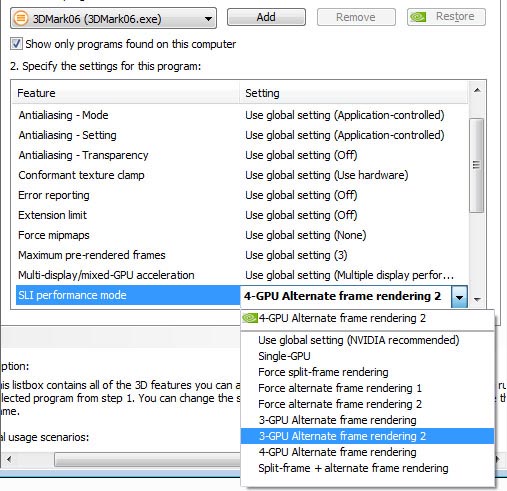

Технология называется незатейливо - Quad SLI. Впрочем, это не главное, гораздо интереснее то, что нам позволяет сделать драйвер в этом случае. Мы уже говорили, что большим плюсом драйверов NVIDIA является возможность вручную задать режим работы технологии SLI, причем это можно сделать и для конкретного приложения в отдельности. Вот мы и сделали.

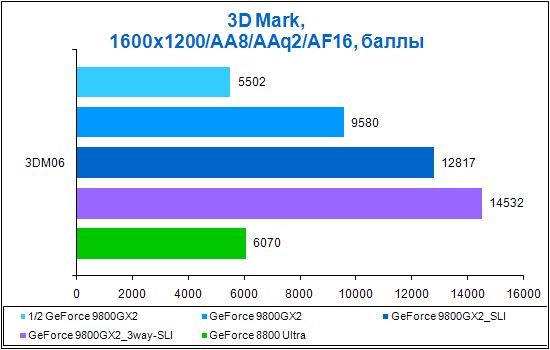

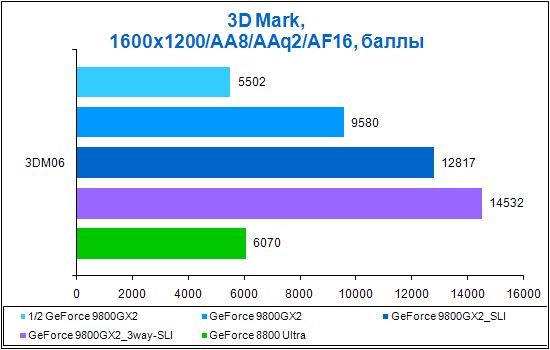

В профиле 3DMark 06 мы изменили режим работы SLI для этой программы. Сделали мы это для эксперимента, поскольку удивительной оказалась возможность снизить количество активных графических процессоров с четырёх до трёх. Конечно же, в первую очередь мы протестировали с четырьмя активными чипами, то есть как есть по умолчанию. Итак, чтобы загрузить наш дуэт-квартет по максимуму и не упереться в производительность центрального процессора, мы вручную установили в настройках теста 3DMark 06 разрешение 1600x1200, качество сглаживания - 8, качество сглаживания - 2 и качество анизотропной фильтрации - 16. Для сравнения мы протестировали одиночную видеокарту XFX 9800GX2 с отключенным режимом SLI, то есть она работала в полсилы. По полученным результатам мы можем посчитать прирост быстродействия от использования режима SLI. К сожалению, HD3870 X2 выпал из данного теста, поскольку в нем он выдавал "полосатую" картину. Давайте же познакомимся с полученными результатами.

Итак, при активации режима SLI в пределах одной видеокарты XFX 9800GX2 прирост производительности составил 74%, что неплохо. А вот при активации технологии Quad SLI процент прироста оказался не столь высок - всего 33% по сравнению с одной XFX 9800GX2 и 133% - по сравнению с её половинкой. Давайте теперь посмотрим на результаты игровых тестов, которые, как всегда, мы производили с 4-кратным сглаживанием и 16-кратной анизотропной фильтрацией.

В игре Crysis, к сожалению, тандем из двух XFX 9800GX2 не заработал, точнее говоря, при разрешении 1024x768 он показал такой же результат, как и одиночная видеокарта XFX 9800GX2; при разрешении 1280x1024 он несколько раз завис и показал меньший результат, чем одиночная видеокарта XFX 9800GX2, а при разрешении 1600x1200 он ни разу не прошел тест - всегда зависал. Перед тем, как зависнуть, игра шла рывками и что-то активно кэшировала на жёсткий диск. Мы можем предположить, что проблема тут в количестве видеопамяти, приходящемся на один графический процессор, - всего 512 Мб. Вспомните, ранее с этим уже

возникали проблемы, так может, и на этот раз драйвер не смог грамотно поделить видеопамять? Ведь, как-никак, хоть Windows Vista и объединяет всю видеопамять в единый массив, драйвер в этом играет далеко не последнюю роль. Кстати, обратите внимание, странности в работе прослеживаются и с одиночной XFX 9800GX2, скорость которой резко упала при разрешении 1600x1200.

В игре Call of Juarez убедительную победу одержал дуэт из двух XFX 9800GX2. Так, по мере роста разрешения они гораздо меньше потеряли в скорости, чем соперники. Аутсайдером стала другая видеокарта - HD3870 X2, так как компания AMD до сих пор не устранила в ней проблемы со скачками скорости.

Пожалуй, на этой ноте и закончим наше сегодняшнее ознакомительное тестирование новой платформы NVIDIA nForce 790i ULTRA в целом и видеокарт NVIDIA GeForce 9800GX2 в частности. Ах да, не будем забывать компании XFX и Corsair, благодаря которым мы это смогли осуществить. Итак, выводы.

Выводы

Надеемся, что наше сегодняшнее тестирование не оставило вас равнодушными. С чего начнём?

Что нам понравилось и не понравилось в предоставленной на тесты материнской плате. Стоит отметить отсутствие больших проблем в целом и с оперативной памятью в частности. Да, у нас возникли проблемы, но система могла вообще не запуститься, что уже неоднократно наблюдалось на некоторых других материнских платах. А у нас не только запустилась, но ещё и Windows Vista смогла установиться, что, в общем-то, показатель. Так что ждём новых версий BIOS или вручную настраиваем материнскую плату на стабильную работу, как-никак разгон это подразумевает.

Что касается видеокарт, то тут мы и поругаем, и похвалим. Поругаем за то, что технология Quad SLI на данный момент ещё сыровата, что можно отнести и к работе "простой" SLI под управлением Windows Vista, да и, в общем-то, ко всем видеодрайверам под эту операционную систему. А похвалим за безупречную работу одиночной видеокарты под управлением Windows XP. Очень приятно это говорить - проблем с GeForce 9800GX2 в Windows XP нет, вообще нет. Всё работает идеально, и по ходу тестирования у нас возникали только положительные эмоции. Единственный минус, и тот не связан с качеством работы видеокарты, это отсутствие у неё интерфейса S-Video и непереносимость видеодрайверов других видеокарт NVIDIA в системе. Что ж, возможно, это исправят, но мы точно можем сказать, что большинство пользователей ничуть это не озаботит.

Так что к NVIDIA у нас претензии лишь касательно её драйверов для Windows Vista, что, как мы полагаем, вскоре будет исправлено.

Что касается видеокарты HD3870 X2, от которой мы ожидали большего, первоначально ей планировалось посвятить отдельную статью (с заголовком "Radeon HD3870 X2: два месяца спустя"), в которой, протестировав видеокарту с новыми драйверами Catalyst 8.3, мы сравнили бы новые результаты с таковыми двухмесячной давности и похвалили бы компанию AMD: мол, какие молодцы. Однако вместо радостных эмоций по поводу улучшения драйверов мы испытали шок, так как не только не увидели ни малейшего улучшения, напротив - стало хуже! Очень, очень жаль, ведь Radeon HD3870 X2 могла бы стать неплохой видеокартой, будь для неё лучше драйверы.