День технологий HPC. Новосибирск, июнь 2010

На пути к петабайту и экзабайту

Во второй половине июня в Новосибирске состоялось одно из крупнейших российских IT-мероприятий этого года - День Суперкомпьютерных технологий. Симпозиум, организованный совместными силами компании Intel, Сибирского отделения РАН и руководства Новосибирской области, собрал под крышей Дома учёных Академгородка представителей отечественной науки, ведущих российских и зарубежных IT-компаний, а также многочисленных журналистов из российских, украинских и казахстанских изданий.

Мероприятия такого внушительного масштаба и столь впечатлительного кворума для российской действительности пока что явление нечастое, хотя, надо признать, остро востребованное, ибо круг вопросов, обсуждаемых на симпозиумах по технологиям и вопросам внедрения HPC (High-Performance Computing - высокопроизводительные вычисления) с каждым днём нарастает с неимоверной скоростью. Далеко за примером ходить не надо - совсем недавно, в декабре 2009 года, в Москве уже проходило мероприятие подобного масштаба (см наш репортаж "Симпозиум Intel HPC 2009: всё о российских суперкомпьютерах"). Прошло всего полгода, однако за это время успело поменяться очень многое. Некоторые проблемы, стоявшие на повестке дня полгода назад, уже успешно разрешены и воспринимались участниками последнего симпозиума как привычная обыденная данность, а на июньском мероприятии шла речь о ближайших горизонтах, просто немыслимых полгода назад.

Полная программа Дня Суперкомпьютерных технологий вместила в себя множество докладов по самым разным направлениям, так или иначе связанным с заявленной темой. Докладчики рассказали о сегодняшнем и завтрашнем дне аппаратной части суперкомпьютеров; о новых методах вычислений, в частности, распараллеливании и виртуализации; о непосредственной связи науки и бизнеса, где нынче как никогда ранее востребованы возможности HPC; о новых горизонтах теоретических и прикладных научных исследований, открываемых благодаря доступности современных вычислительных мощностей, и о многом другом. В конце этого насыщенного дня состоялся круглый стол, где журналисты и представители науки и бизнеса смогли напрямую обсудить друг с другом прикладные аспекты вопросов, поднятых в докладах.

Кроме того, в рабочую программу московских журналистов в этой поездке также было включено посещение Новосибирского государственного университета, знакомство с его руководством и экскурсия по действующим лабораториям, где ежедневно творится будущее российской науки.

Обо всём об этом – в нашем сегодняшнем репортаже. Однако прежде чем приступить к рассказу о наиболее интересных событиях Новосибирского Дня Суперкомпьютерных технологий, хотелось бы сказать несколько слов об атмосфере, царившей на этом симпозиуме. С моей точки зрения – как человека, не первый год принимающего участие в подобных мероприятиях и внимательно следящего за развитием направления HPC в России, индустрия в настоящее время переходит на новый качественный уровень.

Ситуация с постоянным запаздыванием внедрения и использования возможностей HPC, похоже, уходит в прошлое - Россия, хотя и с оговорками (о которых ниже), постепенно превращается в державу, наука и бизнес которой на равных говорят со всем миром, и уже сейчас предлагают в некоторых областях передовые решения важнейших задач.

Немаловажную роль в усилении этой тенденции играет государство, которое хоть и со скрипом, постепенно, но всё же разворачивается в сторону высоких технологий. Благодаря пониманию стратегической важности развития HPC удалось значительным образом увеличить объём инвестиций в российские суперкомпьютеры.

Однако главным фактором, на мой взгляд, является классический переход количества в качество - многократно возросшая за последние годы мощь российских суперкомпьютеров, применяемых в научных и промышленных приложениях, а также рост числа специалистов по технологиям HPC, не могли не породить новой культуры высокопроизводительных вычислений в нашей стране.

Симпозиум начался с ряда вступительных слов от именитых академиков и представителей администрации Новосибирской области, а затем последовали пленарные доклады. Однако мне хотелось бы представить их не в том порядке, в котором они были озвучены, а сгруппированными по тематическим направлениям. Хотя, в любом случае придётся начать с прозвучавшего первым доклада профессора Сергея Михайловича Абрамова, руководителя российской части проекта союзного государства России и Беларуси программ СКИФ и СКИФ-ГРИД по разработке суперкомпьютеров.

Презентация Сергея Михайловича особо ценна чёткими, без прикрас и "рюшечек", оценками нашей сегодняшней российской действительности в области развития и внедрения суперкомпьютерных технологий. Да, темпы развития HPC в России в последние годы взяты действительно впечатляющие, но таковыми они выглядят лишь до сравнения с динамикой развития технологий HPC ведущих зарубежных стран. К примеру, США только на протяжении 2005–2009 годов тратили на эти цели от двух до шести миллиардов долларов в год. Более того, в развитии вычислительных грид-систем США ставка была сделана на региональные центры. В результате, на июнь 2009 года системы Техаса и Нью-Мексико занимали в рейтинге Top500 8-е и 17-е место, соответственно, а вычислительные мощности каждого из этих региональных суперкомпьютерных центров были выше, чем у самой производительной системы в России.

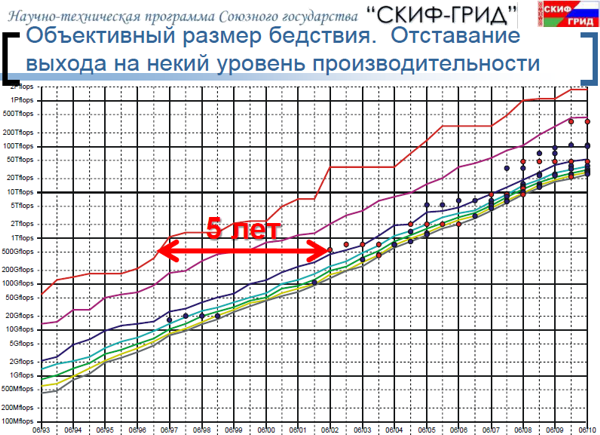

Слайды, приведённые ниже, иллюстрируют развитие суперкомпьютерной отрасли в мире и в России за последние годы. Обратите внимание, для того, чтобы успешно конкурировать, сейчас уже недостаточно поступательного роста мощностей, сейчас идёт речь об увеличении скорости роста ускорения!

Следующий слайд во всей красе наглядно представляет нынешнее неутешительное положение дел с развитием суперкомпьютерной отрасли в России. Несмотря на успешное вхождение в ряд топовых мировых рейтингов и впечатляющий рост мощностей, говорить о выходе на единый с мировыми лидерами уровень развития пока рано. Впрочем, даже если перестать ориентироваться на зарубежные показатели, остаётся открытым такой вопрос, как внутрироссийский спрос на высокопроизводительные вычисления, который, как отлично видно на слайде, весьма и весьма далёк от насыщения.

Для того, чтобы понять всю серьёзность нынешней ситуации с развитием отрасли в России, Сергей Михайлович привёл ряд интересных слайдов, отображающих динамику развития HPC в ведущих мировых странах за последние годы.

Для удобства восприятия предлагаю вашему вниманию этот фрагмент доклада в видеозаписи, непосредственно с комментариями С. М. Абрамова.

В итоге, в настоящее время мы имеем примерно 5-летнее отставание по выходу на лидирующие позиции в пиковых уровнях производительности и примерно 7-летнее отставание по показателям суммарной производительности российской вычислительной инфраструктуры.

С одной стороны, все не так уж и плохо - как-никак, а 5-7 лет это уже не 20-25, которые наблюдались совсем недавно. С другой стороны, при таком отставании очень трудно добиться как лидирующих позиций в мире, так и удовлетворения внутрироссийского спроса на высокопроизводительные вычисления. А спрос этот, следует отметить, в обозримом будущем только усилится.

Самое главное, на чём хотелось бы сделать акцент в этом плане – на том, что все возможности для ускоряющегося роста вычислительных мощностей России имеются. В настоящее время производственный суперкомпьютерный потенциал России складывается из следующих предприятий:

- Институт точной механики и вычислительной техники имени Лебедева АН СССР (ИТМиВТ)

- Научно-исследовательский центр электронной вычислительной техники (ОАО «НИЦЭВТ»)

- ФГУП НИИ «Квант»

- "РОСАТОМ", РФЯЦ: Всероссийский НИИ экспериментальной физики — Институт теоретической и математической физики (РФЯЦ ВНИИЭФ-ИТМФ, г. Саров и г. Снежинск)

- Межведомственный суперкомпьютерный центр РАН (МСЦ РАН)

- Научно-исследовательский институт системных исследований РАН (НИИСИ РАН)

- Научно-исследовательский институт многопроцессорных вычислительных систем (НИИ МВС)

- Разработчики систем на базе архитектуры микропроцессора серии

- "Эльбрус" (ЗАО "Московский центр спарк технологий", "МЦСТ")

- Кооперация СКИФ-исполнителей, где головным исполнителем суперкомпьютерных программ "СКИФ" и "СКИФ-ГРИД" от России выступает Институт программных систем имени А. К. Айламазяна, кроме того, над проектами работает 25 организаций России и 10 организаций Беларуси.

Далее Сергей Михайлович рассказал об успехах своего детища - программ "СКИФ" и "СКИФ-ГРИД". В настоящее время речь идёт о внедрении наиболее современных решений "СКИФ" 4-го поколения, известных также под названием "СКИФ-Аврора", оснащенных уникальной водяной системой охлаждения. В наших новостях и статьях мы неоднократно упоминали решения на системах этого класса. Так, первое полушасси СКИФ-Аврора производительностью 1,5 Tflops было представлено ещё в июне 2009 года на гамбургском мероприятии ISC’09. А совсем недавно система СКИФ-Аврора с пиковой производительность 24 Tflops на базе 256 blade-модулей с чипами Intel Xeon серии 5500, системой жидкостного охлаждения и рядом уникальных отечественных разработок, была установлена в Южно-Уральском государственном университете (ЮУрГУ).

Интересно отметить, что уже сейчас российскими и белорусскими специалистами разработан проект системы СКИФ П-0.5 на базе совершенно бесшумных монтажных шкафов (общим количеством 21 штука), обеспечивающий проектную вычислительную мощность порядка 500 Tflops!

В ряду преимуществ архитектуры "СКИФ-Аврора" можно отметить такие качества, как в 1,5 раза лучшая эффективность использования электроэнергии, в 2 раза выше плотность упаковки вычислительной мощности, в 1,5 раза выше пропускная способность системной сети, повышенная эффективность реализации массовых операций, повышенная надежность суперкомпьютера (нет подвижных частей, N+1 резервирование, тройное резервирование управления и мониторинга). Кроме того, не стоит забывать о том, что все эти системы производятся в России, и на них никоим образом не распространяется печально известная и до сих пор по какому-то недоразумению не отменённая поправка Джексона–Вейника (ограничение экспорта из США).

Иными словами, в настоящее время в России имеются все предпосылки, чтобы собственными силами реализовать на практике системы с "петафлопной" производительностью.

В заключение доклада вкратце были описаны основные проблемы, встающие на пути к следующей сияющей и пока недостижимой (надолго ли?) вершине - производительности уровня "экзафлопа". Прежде всего, специалистам придётся столкнуться с высокой плотностью компоновки вычислительных модулей при продолжающемся сокращении физической длины соединений. Наряду с вопросами дальнейшего снижения удельного потребления электроэнергии, придётся решать задачи эффективного отвода тепла. И, конечно же, классические вопросы - построение систем обмена данными между вычислительными узлами с низкой задержкой и высокой пропускной способностью, поддержка интеграции очень большой системы (Nх106), мониторинг и управление такой системой, отказоустойчивость, использование неоднородных ядер и ускорителей, новые подходы к организации параллельного выполнения программ.

Ещё раз вернусь к "эмоциональной" оценке мероприятия, о которой зашла речь в начале репортажа - только ради одного этого доклада имело смысл ехать в эту командировку. Даже нелестная оценка нынешней ситуации не повлияла на бодрый и уверенный тон и направленность выступления Сергея Михайловича. Собственно говоря, доклад как раз и ценен отсутствием похвальбы и громких слов – только факты, и только по делу. И ещё то, чего порой так не хватает многим - уверенность в будущем.

Впрочем, это был только первый доклад.

Что означают термины "экзафлоп", "экзафлопная производительность" применительно к сфере HPC? Это очень просто - производительность многих сегодняшних суперкомпьютерных систем находится на уровне порядка десятков и даже сотен TFLOPS (тера-FLOPS, приставка "тера-", напомню, означает 10 в 12-й степени). Таким образом, о преодолении порога следующей размерности - PFLOPS (пета-FLOPS, "пета" – 10 в 15-й степени), говорить особого смысла уже нет, поскольку такой уровень вполне достижим даже современными программно-аппаратными средствами.

Другое дело - EFLOPS (экза-FLOPS, "экза" – 10 в 18-й степени). Столь высокая производительность потребует совершенно иных инструментов, совершенно новых платформенных решений. Возникает закономерный вопрос - какие задачи по силам современным "суб-петафлопным" суперкомпьютерам, и для чего, хотя бы теоретически, может понадобиться экзафлоп?

С ответа на этот вопрос началась презентация Виктора Владимировича Самофалова, директора академических и исследовательских программ в Нижегородском подразделении Intel. Процитировав народную мудрость (авторства М.Р. Шура-Бура)

"Народу нужно что – решить задачу,

Хоть синтезом - хоть лаптем все равно"

Виктор Владимирович представил очень интересный слайд, наглядно объясняющий возможности "петафлопных" вычислений и то, что таким вычислениям, увы, "не по зубам".

Как видите, производительности порядка сотни TFLOPS уже вполне достаточно, чтобы рассчитывать совершенно немыслимые ранее задачи, вроде полного моделирования поведения самолета, расшифровки генома или прогнозирования погоды. Однако представьте себе, что суперкомпьютер производительностью 1 EFLOPS сможет "всего-навсего" моделировать жизнедеятельность… одной единственной клетки организма! И даже невозможно сейчас представить, какие немыслимые мощности потребуются для моделирования жизнедеятельности хотя бы простейшего живого организма.

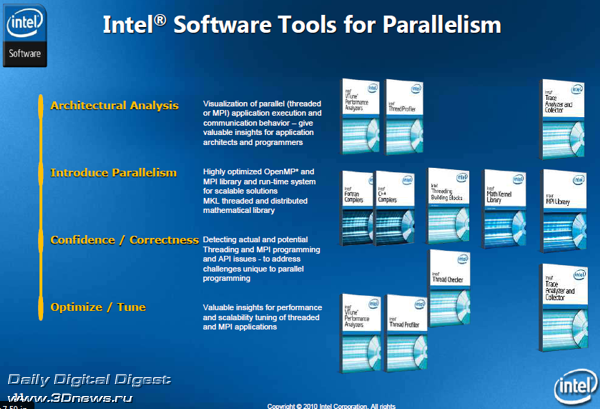

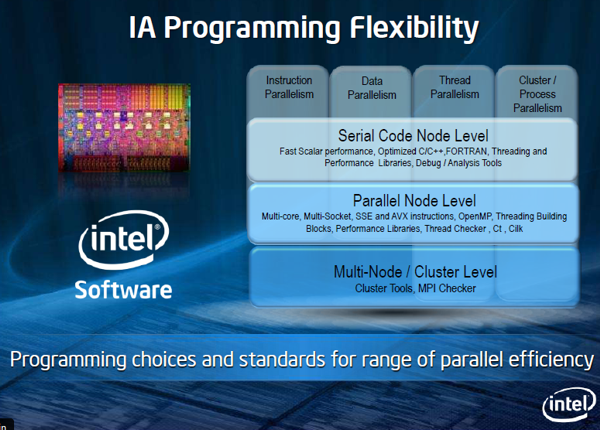

Свой доклад Виктор Владимирович посвятил вопросам разработки новых вычислительных алгоритмов в свете современного изменения архитектуры суперкомпьютеров. И действительно, качественный алгоритм позволяет уменьшить время выполнения задач, максимально распараллелить задание, добиться максимального быстродействия всех ветвей. Именно поэтому хорошие инструменты разработки программ должны обеспечивать качественную локализацию – по данным, по исполнению, по взаимодействию параллельных ветвей. При разработке реального приложения важны параллельные и последовательные алгоритмы, разумное использование типов параллелизма - по данным, функционального, по распределению работ, корректность и масштабируемость, синхронизация, баланс загрузки и многие другие факторы.

В настоящее время компания Intel предлагает широкий спектр инструментов, подходящих для решения этих задач. Однако на очереди – переход от мультиядерности к многоядерности, и уже сейчас самое время разрабатывать инструменты с прицелом на системы с производительностью уровня того самого грядущего "экзабайта". И здесь не обойтись без новых подходов, без применения новых координационных языков программирования высокого уровня, способных полностью использовать аппаратные возможности подобных систем.

Интересно отметить, что развивая свои инструменты, Intel не только поддерживает тесные контакты с сообществом разработчиков, но также стимулирует их работу проведением различных тренингов и конкурсов. Так, в настоящее время – со 2 апреля по 10 октября, принимаются заявки на конкурс проектов по применению высокопроизводительных вычислений под девизом "Невозможное стало возможным: реальные приложения для HPC". Конкурс ставит своей целью демонстрацию возможностей практического применения высокопроизводительных вычислений для нужд различных отраслей науки и промышленности и поощрение творческих коллективов, работающих над проектами в области HPC. В этом году призовой фонд составляет 950 тысяч рублей (6 денежных призов) и 1,5 млн процессоро-часов работы на суперкомпьютерах. Заявку можно подать на сайте http://www.intel.ru/hpc. Отметим, что конкурс проводится уже не первый год (см, например, Rusnanotech 2009: Победители конкурса проектов в сфере HPC).

Продолжая тему программно-аппаратных технологий для высокопроизводительных вычислений, необходимо остановиться на блестящем и очень интересном докладе Андрея Сёмина, менеджера компании Intel по технологиям HPC в регионе EMEA.

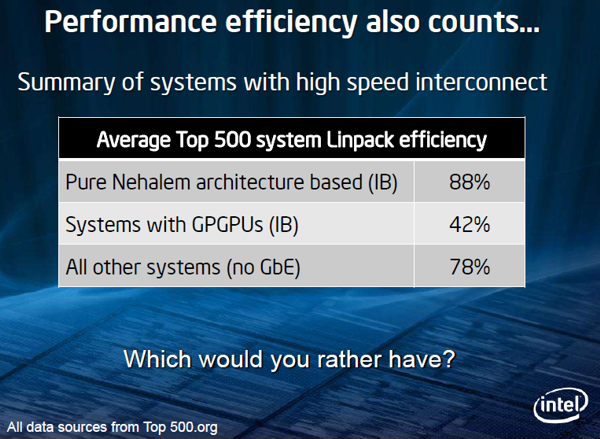

В его докладе, например, была озвучена такая интересная статистика - на июнь 2010 года 408 систем из мирового списка Top 500 работали на процессорах Intel, в том числе шесть из семи самых производительных систем планеты. При этом семь из них основаны на процессорах Intel Xeon 5600, две - на чипах Intel Xeon 7500, и 184 системы - на чипах Intel Xeon 5500.

Отметив преимущества новой архитектуры Intel Nehalem, в частности, плюсы новой скоростной шины, Андрей подробно остановился на архитектуре следующего поколения серверных процессоров Intel Xeon, известной ныне под рабочим названием Sandy Bridge.

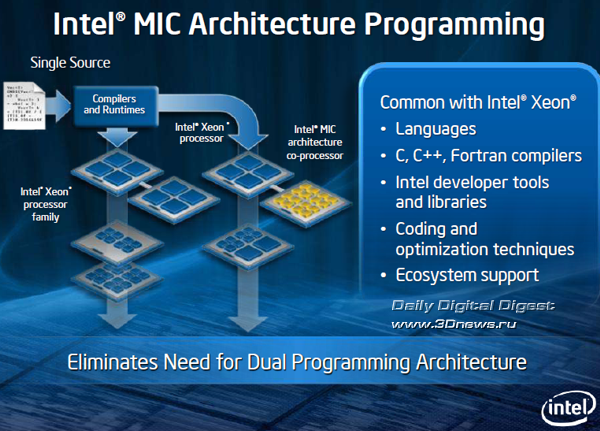

Особенности новой архитектуры – увеличение производительности за счёт большего количества ядер, поддержка технологии Hyper-threading Technology, обработка большего количества инструкций за такт и поддержка инструкций AVX, будут особенно востребованы в грядущую эпоху "петафлопных вычислений", особенно при обработке нерегулярных и неструктурированных массивов данных. И здесь Intel планирует использовать преимущества новой процессорной микроархитектуры вместе с полным комплексом собственных программных инструментов разработки для гетерогенных систем, таких как Intel Parallel Studio, HPC Tools и Cluster Tools, сочетающих использование стандартной модели программирования с расширенной поддержкой параллелизма.

Коснувшись всемирной программы Intel по обучению специалистов в области HPC (порядка 2000 университетов в 88 странах, более 4000 преподавателей, около 320 тысяч подготовленных специалистов), Андрей переключился на тему, ставшую лейтмотивом всего симпозиума – как вы уже догадались, речь идет о "петафлопном" и "экзафлопном" будущем.

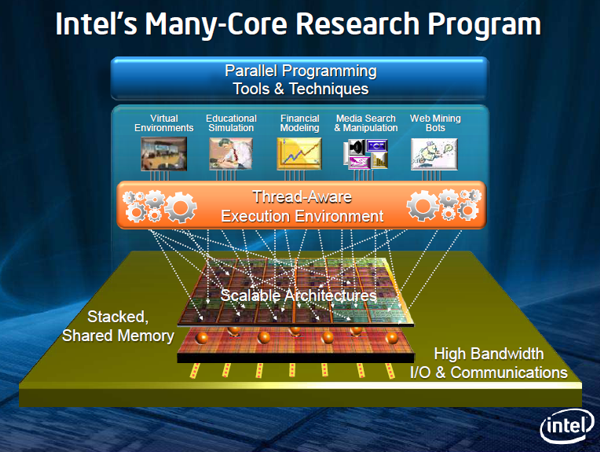

В Intel полагают, что будущее высокопроизводительных вычислений - за много-ядерной (Many Core) архитектурой. В отличие от традиционного пути развития процессорной мульти-ядерной (Multi Core) архитектуры с эволюционным наращиванием количества ядер, технология Many Core строится на принципах использования десятков вычислительных ядер с заведомо разной архитектурой и соответствующей специализацией.

Предтечами технологии, анонсированной совсем недавно под названием Intel Many Integrated Core Architecture (MIC), можно назвать представленный ещё в 2007 году проект Tera-scale Research Processor, на котором обкатывались технологии распараллеливания вычислений на масштаб десятков процессорных ядер, а также хорошо известную всем многоядерную x86 микроархитектуру – Larrabee, с поддержкой векторных операций и ускорением визуальных вычислений с помощью множества небольших процессорных ядер общего назначения.

Первенцем на основе новой архитектуры Intel Many Integrated Core стала опытная платформа Knights Ferry - 32 ядра, частота 1,2 ГГц, 128 потоков (по 4 потока на ядро), 8 Мб распределённой связанной кеш-памяти, 1-2 Гб памяти GDDR5. Впервые представленная в конце мая 2010 на мероприятии International Supercomputing Conference (ISC2010), платформа Knights Ferry предназначена, главным образом, для разработки и оптимизации ПО.

Следующим этапом в развитии семейства многоядерных со-процессоров Knights станет серийный продукт Knights Corner, имеющий более чем 50 ядер с архитектурой х86 и выполненный по техпроцессу 22-нм.

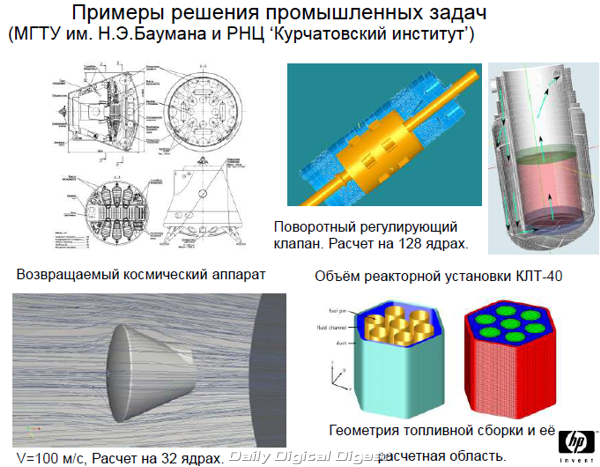

Огромный содержательный доклад представителей Сибирского Суперкомпьютерного Центра и Центра Компетенции СО РАН – Intel был посвящён проблемам внедрения высокопроизводительных вычислений в научной сфере.

Сейчас ССКЦ занимается выполнением задач институтов СО РАН и университетов Сибири по математическому моделированию в фундаментальных и прикладных исследованиях, координацией работ по развитию суперкомпьютерных центров Сибири, организацией обучения специалистов СО РАН и студентов университетов (ММФ и ФИТ НГУ, НГТУ) методам параллельных вычислений на суперкомпьютерах, сотрудничеством с Intel, HP и промышленными организациями, тестированием новых процессоров и программного обеспечения, а также организацией взаимодействия с другими Суперкомпьютерными центрами РАН, других городов России и зарубежных стран. Для этих целей в Центре используется мощная аппаратная база, оснащение которой улучшается с каждым годом.

Среди мероприятий, проведенных ССКЦ, можно упомянуть серию совместных семинаров с Intel и НГУ для пользователей ССКЦ, студентов и аспирантов; поддержку четырёх летних и шести зимних школ (более 180 студентов), множество консультаций и семинаров. На ресурсах ССКЦ решаются такие сложные задачи, как численное моделирование высотной аэродинамики модели пилотируемого транспортного корабля нового поколения, моделирование релаксации релятивистского электронного пучка в высокотемпературной плазме и многое другое.

Завершая тему создания и практического внедрения программно-аппаратных суперкомпьютерных систем в России, нельзя не упомянуть доклад представителей компании HP - "Реализованные в России HPC-проекты". Сегодня компания работает с такими российскими заказчиками, как университеты, нефтегазовые компании, научные и суперкомпьютерные центры. Компания, в частности, является участником программы "Университетский кластер", в учредителях которой кроме НР также числится Российская академия наук (ИСП РАН и МСЦ РАН) и компания "Синтерра". Программа нацелена на повышение уровня компетенций в параллельных и распределенных вычислениях в образовательной и научно-исследовательской деятельности, создание сообщества специалистов, использующих и разрабатывающих современные технологии, передачу знаний и технологий в российскую индустрию (энергетика, машиностроение, транспорт, связь и пр.).

В качестве примера работы компании можно упомянуть проект, выполненный в содружестве с компанией "Крок" и ИСП РАН по установке в ТТИ ЮФУ (г. Таганрог) HPC-кластера из 8 стоек (9 Voltaire IB switches + HP Procurve switches + 16 blade enclosures), 128 BL685c серверов и пр., с пиковой производительностью 18,8 Tflops.

HP также плотно сотрудничает с рядом ведущих научных и производственных учреждений России, в том числе с МГТУ им. Н. Э. Баумана, РНЦ Курчатовский институт и РКК Энергия им. С. П. Королева, а также с рядом нефтегазовых компаний (Schlumberger, Роснефть и др.).

HPC в науке и промышленности

Переходя к рассказу о докладах представителей науки и бизнеса, применяющих высокопроизводительные вычисления на практике, стоит упомянуть рассказ представителей Российского научного центра компании Baker Hughes, применяющей HPC в своих исследованиях.

Компания Baker Hughes работает в нефтегазовой сфере и поставляет предприятиям отрасли продукцию и услуги для бурения скважин, оценки параметров продуктивных пластов и добычи углеводородного сырья. В России компания присутствует с середины 90-х.

Продукты Baker Hughes опираются на фундаментальные научные исследования в электромагнитных методах геофизики, механике и физике жидкости и газа, механике и физике твердого тела, гравиметрических методах геофизики, сейсмических и акустических методах геофизики, горном деле, петрофизике, петрохимии и геохимии. Технологии Baker Hughes присутствуют даже в программах NASA по освоения Марса.

В своём докладе представители компании отметили, что используют программы, из которых 95% написаны и работают на персональных компьютерах под MS Windows, а оставшиеся 5% это кросс-платформенные программы GEANT4. В плане работы с программами основные приоритеты лежат в оптимизации кода с использованием вычислительных библиотек Intel MKL и IMSL, портирования на 64-битную платформу, распараллеливания.

Ещё один интересный аспект, рассмотренный в этой презентации – вопрос оптимального использования корпоративных ресурсов, например, простаивающих в ночное время или в период отпусков персональных компьютеров, а также корпоративных ЦОД, обладающих избыточными ресурсами для обеспечения отказоустойчивости. Все эти ресурсы вполне можно направлять на выполнение несрочных задач в долговременных проектах с помощью специализированного ПО.

Значительное время заседаний Дня Суперкомпьютерных технологий было отведено для выступления представителей научных кругов России. Выступавшие учёные рассказывали о своей работе очень интересно. Хочется отметить, что тематика большинства докладов затрагивала не только и не столько способы использования суперкомпьютеров в науке, сколько вопросы, которые наука решает или пытается решить в настоящее время с помощью тех или иных инструментов, в том числе, и HPC.

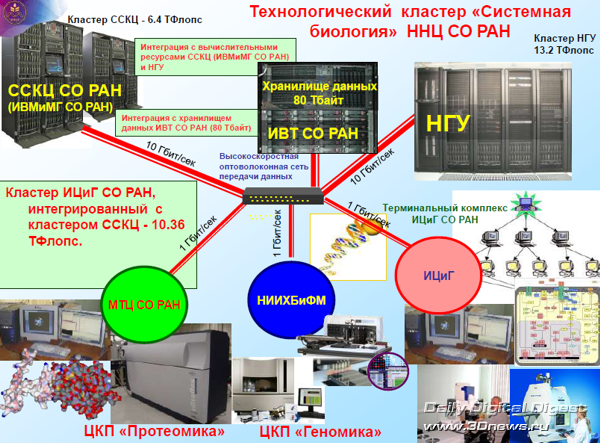

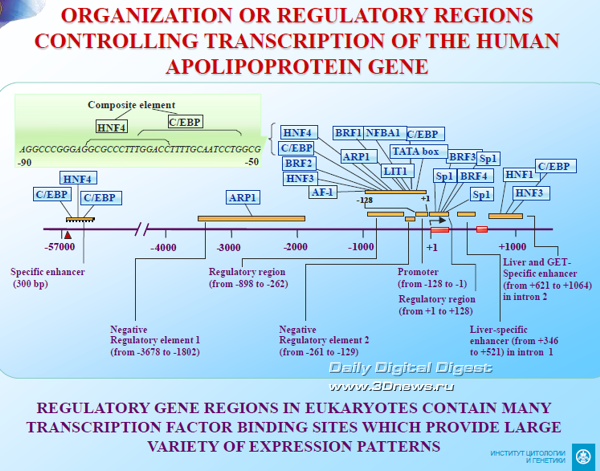

В этом плане наиболее показательно блестящее, сорвавшее максимум аплодисментов за весь симпозиум выступление академика Николая Александровича Колчанова, директора института цитологии и генетики СО РАН. Примечательно, что в это же время в соседнем с нами здании СО РАН проходил профильный симпозиум по вопросам цитологии и генетики, и Николай Александрович, как и некоторые другие учёные, совмещал работу сразу на двух мероприятиях.

Мне, как неспециалисту, очень трудно пересказывать пересыпанный специализированной терминологией рассказ Николая Александровича о проблемах современной цитологии, геномики и системной биологии. Что касается технологической части процесса, то ограничусь лишь описанием методики применения высокопроизводительных вычислений.

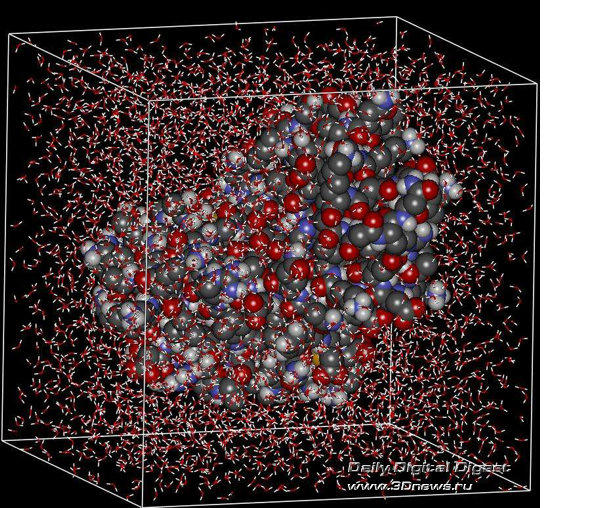

В этом плане процесс заключается в интеграции экспериментальных данных и биоинформатики, составлении баз данных с описаниями функций живых организмов, интеграция гетерогенных экспериментальных данных о структурной и функциональной организации живых систем. Далее происходит анализ экспериментальных данных, математическое моделирование живых систем, попытки предсказания новых функциональных моделей поведения, а также планирование дальнейших экспериментов для опытной проверки этих предсказаний, и затем – проведение экспериментов с получением новых данных.

В качестве подтверждения тезиса о ресурсоёмкости таких вычислений приведу пример, озвученный Николаем Александровичем. Человеческий геном содержит порядка 25 тысяч генов, при этом среднее количество факторов, применяемых для описания одного гена, требует порядка 40 TFLOPS вычислительной мощности. И это на каждый из 25 тысяч генов! Таким образом, для работы с полным геномом человека требуется ни много ни мало, а 40 х 25 000 = 1 000 000 TFLOPS вычислительной мощности – вот вам тот самый экзафлоп.

Ещё цифры - в настоящее время база исследователей PDBSite содержит более 150 тысяч пространственных структур различных функциональных сайтов (участков) белков, а в базе PDB содержится более 65000 пространственных структур белков. Распознавание функциональных сайтов требует их оптимального 3-D выравнивания с белками из PDB, а сравнение одного сайта с одним белком только по С-альфа атомам занимает на одном процессоре от нескольких секунд до минуты. Таким образом, анализ всех белков c высокой точностью может потребовать до 5 000 000 часов работы на одном CPU. Если же рассматривать пространственные структуры белков, реконструированных на основе гомологии последовательностей, время анализа увеличивается еще на три порядка.

Разъяснять важность таких работ, думаю, особо не нужно, однако в первую очередь это важно для распознавания функциональных сайтов в пространственной структуре белков как потенциальных мишеней для действия лекарственных препаратов, способных спасти жизни и вылечить от неизлечимых пока недугов. Вот почему любые затраты на такие работы всегда будут недостаточными.

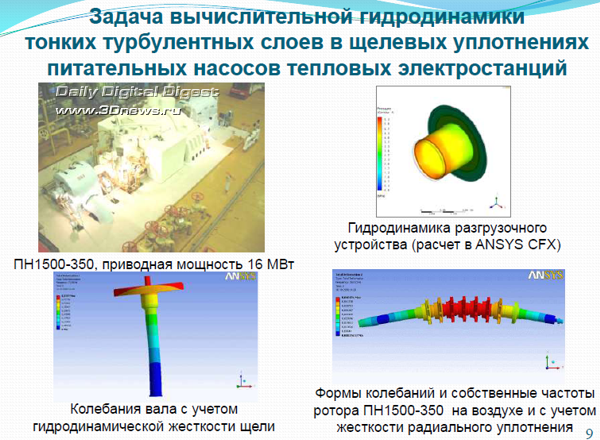

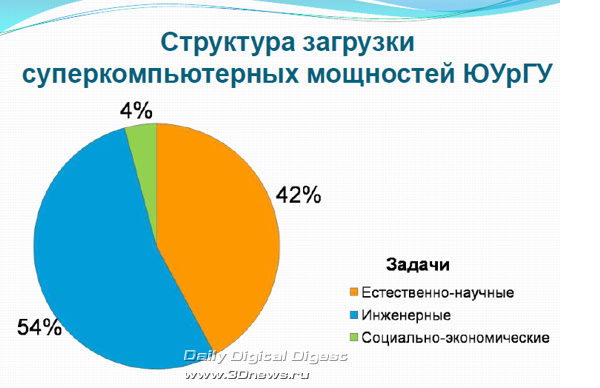

Очень интересным было выступление представителей национального исследовательского университета ЮУрГУ (Челябинск), буквально на днях официально объявившего о запуске нового суперкомпьютера СКИФ-Аврора ЮУрГУ с пиковой производительностью до 24 Teraflops.

В университете решаются серьёзные прикладные задачи, востребованные гражданской и оборонной промышленностью. В частности, в качестве примеров задач инженерного моделирования нам рассказали о расчётах тепло-массообмена и газовой динамики с моделированием тонких турбулентных слоев в щелевых уплотнениях питательных насосов тепловых электростанций, работах по расчету многофазных течений в камере сгорания ракетного двигателя, о моделировании деформирования и разрушения тканевых бронежилетов, а также механического поведения грудной клетки человека при локальных ударах и пр.

Словом, в ЮурГУ мощности суперкомпьютеров никогда не простаивают и приносят реальный экономический эффект.

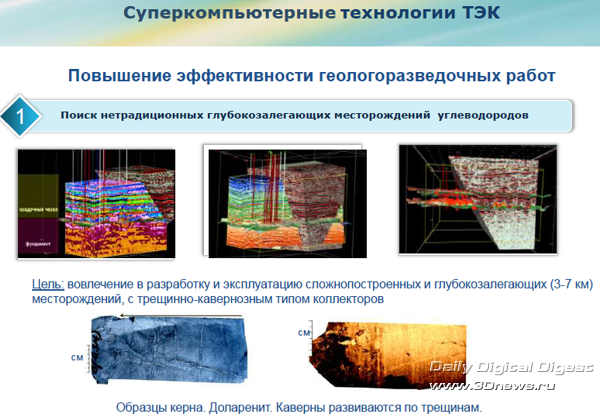

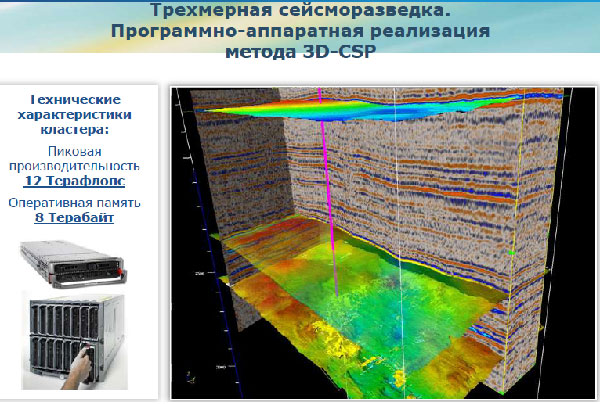

Доклад представителей Югорского НИИ Информационных Технологий (ЮНИИ ИТ) логически продолжил тему применения суперкомпьютерных технологий в промышленности, а именно в топливно-энергетическом комплексе. Специалисты ЮНИИ ИТ занимаются созданием суперкомпьютерных технологий для поиска месторождений углеводородов и повышения нефтеотдачи, информационно-космическими технологиями для решения задач экологии и рационального природопользования, информационными технологиями в управлении, медицине и образовании.

Так, применяя суперкомпьютеры для обработки данных сейсморазведки и моделирования структуры залежей, специалистам ЮНИИ ИТ удаётся предсказать глубину и характер залегания полезных ископаемых, позволяя таким образом существенно снизить затраты на разработку и эксплуатацию добывающих предприятий. И это только один из примеров того, как инвестиции в высокопроизводительные вычисления отбиваются с лихвой и приносят реальную пользу в промышленности.

Как видите, в одной статье просто нереально передать даже основную суть ключевых докладов столь насыщенного Дня суперкомпьютерных технологий. Один день – и столько впечатлений. Однако завершилось наше путешествие в Новосибирск всё же на следующий день, визитом в Новосибирский государственный университет, где Сергей Викторович Нетёсов, доктор биологических наук, профессор, член-корреспондент РАН, проректор по научной работе НГУ представил нам подробную презентацию о научных и учебных программах университета с использованием вычислительных мощностей суперкомпьютеров.

Особенно приятной оказалась экскурсия по вычислительному центру и исследовательским лабораториям НГУ. Одних взволновал вид суперкомпьютерных стоек, других – вид уникального электронного микроскопа с фантастическим разрешением 1 нм, а мне было очень приятно пройтись по этажам и коридорам учебных корпусов, взглянуть на студентов, занятых сдачами-досдачами, или на абитуриентов, пока что смутно представляющих выбранный ими путь. Эх, где мои 17 лет!

День Суперкомпьютерных Технологий в закончился. Не без сожаления покидая гостеприимный Новосибирск, вновь ловишь себя на мысли - полноте, а день ли это был, или, судя по гамме впечатлений и объёму полученной информации, не неделя ли часом прошла? Впрочем, удивляться тут нечему если вспомнить, что поездку организовывало Российское представительство Intel. Прокачать максимум полезной информации в единицу драгоценного журналистского времени – это можно назвать ещё одним своеобразным рекордом компании, за что ей большое человеческое спасибо.