|

Опрос

|

реклама

Быстрый переход

Grok научится создавать видео: xAI поглотила разработчика ИИ-генератора видео Hotshot

17.03.2025 [22:57],

Владимир Фетисов

Принадлежащая американскому бизнесмену Илону Маску (Elon Musk) компания xAI стала владельцем стартапа Hotshot, который работает над созданием инструментов на базе искусственного интеллекта, предназначенных для генерации видео. О завершении сделки в своём аккаунте в соцсети X заявил Аакаш Састри (Aakash Sastry), соучредитель и генеральный директор Hotshot.

Источник изображений: xAI «За последние два года мы небольшой командой создали три модели для генерации видео — Hotshot-XL, Hotshot Act One и Hotshot. Процесс обучения этих моделей помог нам понять, как в ближайшие годы будут меняться глобальные сферы образования, развлечения, общения и производительности. Мы рады продолжить масштабирование усилий в крупнейшем в мире кластере Colossus, как часть xAI», — сказано в сообщении Састри. Компания Hotshot была основана несколько лет назад в Сан-Франциско. Изначально стартап занимался разработкой ИИ-инструментов для генерации и редактирования изображений, но со временем переориентировался на модели искусственного интеллекта, позволяющие генерировать видео на основе текстовых подсказок. Ранее Hotshot удалось привлечь внимание инвесторов, но размер вложенных в стартап средств никогда не озвучивался публично. Переход Hotshot под контроль xAI может помочь стартапу в создании ИИ-моделей для генерации видео, которые станут конкурентами аналогов, таких как Sora от OpenAI или Veo 2 от Google. Ранее Маск намекал, что xAI работает над созданием инструментов генерации видео, которые в будущем планируется интегрировать с чат-ботом Grok. В начале этого года бизнесмен заявлял, что ожидает появление модели «Grok Video через несколько месяцев». Alibaba снова ударила по OpenAI — вышел бесплатный ИИ-генератор реалистичных видео Wan 2.1

26.02.2025 [13:25],

Павел Котов

Китайский гигант в области электронной коммерции Alibaba сделал общедоступной разработанную им модель искусственного интеллекта для создания видео и статических изображений Wan 2.1. Этим шагом компания создала условия для её массового развёртывания и способствовала усилению конкуренции в области ИИ.

Источник изображения: Alibaba Публикация ИИ-моделей с открытым исходным кодом — распространённый шаг в отрасли ИИ; одним из наиболее заметных игроков здесь стал стартап DeepSeek. Alibaba выпустила четыре варианта Wan 2.1: T2V-1.3B, T2V-14B, I2V-14B-720P и I2V-14B-480P — эти модели генерируют видео и статические картинки по текстовому запросу или по образцу, которым может служить изображение. Обозначения «1.3B» и «14B» указывают, что эти варианты содержат соответственно 1,3 млрд и 14 млрд параметров. Младшей модели T2V-1.3B для работы требуется всего 8,19 Гбайт видеопамяти, что делает её совместимой со многими потребительскими видеокартами. Разработчики заявляют, что эта модель может сгенерировать пятисекундный ролик в 480р на GeForce RTX 4090 примерно за 4 минуты (без оптимизаций). Модели доступны для пользователей по всему миру на платформах HuggingFace и ModelScope (входит в Alibaba Cloud) для академических, исследовательских и коммерческих целей. Последнюю версию модели ИИ для генерации видео Alibaba представила в январе — первоначально она называлась Wanx, впоследствии её переименовали в Wan. Проект получил высокую оценку в тестах Vbench, предназначенных для генераторов видео — в частности, она стала лидером по критерию взаимодействия объектов. Накануне Alibaba также выпустила предварительный вариант рассуждающей модели QwQ-Max, которая впоследствии также будет опубликована как проект с открытым кодом. В ближайшие три года компания намеревается вложить не менее 380 млрд юаней ($52 млрд) в поддержку облачных вычислений и инфраструктуры ИИ. «Сбер» представил собственный ИИ-генератор видео по текстовому описанию Kandinsky 4.0 Video

12.12.2024 [23:02],

Владимир Фетисов

На проходящей на этой неделе конференции AI Journey «Сбер» представил бета-версию нейросети Kandinsky 4.0 Video, которая позволяет генерировать реалистичные видео на основе текстового описания или стартового кадра. Алгоритм может быть полезен не только обычным пользователям, но также дизайнерам, маркетологам и мультипликаторам, так как с его помощью можно создавать различные видео: от анимированных роликов с поздравлениями для близких до трейлеров и клипов.

Источник изображения: fusionbrain.ai В компании отметили, что с момента релиза первой версии Kandinsky Video в прошлом году разработчики значительно улучшили многие характеристики алгоритма, включая качество создаваемых роликов и скорость генерации. Обновлённая нейросеть способна создавать ролики продолжительностью до 12 секунд с разрешением 1280 × 720 пикселей на основе текстового описания или изображения. Также поддерживается создание роликов с различным соотношением сторон. Улучшилось визуальное качество: повысились контрастность и чёткость кадров, композиция стала более выверенной, а движения объектов в кадре — реалистичными. В дополнение к этому разработчики анонсировали ускоренную версию нейросети — Kandinsky 4.0 Video Flash, которая способна генерировать ролики продолжительностью до 12 секунд с разрешением 720 × 480 пикселей всего за 15 секунд. На начальном этапе доступ к новой версии Kandinsky Video получат представители креативных индустрий, включая художников, дизайнеров и кинематографистов через портал fusionbrain.ai. Для обычных пользователей алгоритм станет доступен в первом квартале следующего года. OpenAI запустила ИИ-генератор видео по текстовым запросам Sora — он косячит так же, как и другие

10.12.2024 [01:30],

Андрей Созинов

Компания OpenAI в понедельник запустила Sora — свою революционную модель искусственного интеллекта для генерации видео по текстовым описаниям. С сегодняшнего дня новая модель стала доступна на сайте Sora.com для платных пользователей ChatGPT в США и «большинстве других стран». России в списке нет, как и стран ЕС. Представленная сегодня версия под названием Sora Turbo может генерировать ролики длиной от 5 до 20 секунд в различных соотношениях сторон и разрешениях от 480p до 1080p. Каждая генерация обойдётся пользователю в определённое количество так называемых «кредитов». Например, видео в 480p стоит от 20 до 150 кредитов, ролик в 720p — от 30 до 540 кредитов, а видео в 1080p — от 100 до 2000 кредитов. Что именно влияет на цену, пока не уточняется. OpenAI сообщила, что подписчики базового тарифного плана ChatGPT Plus ($20 в месяц) получат 1000 кредитов в месяц. Это позволит сгенерировать до 50 «приоритетных видео» (то есть видео, которые генерируются быстро) в формате 720p и длительностью 5 секунд. В свою очередь, пользователи нового тарифа ChatGPT Pro за $200 в месяц получат 10 000 кредитов, которые смогут потратить на 500 приоритетных видео в формате 1080p и длительностью 20 секунд. Кроме того, более обеспеченные пользователи получат неограниченное количество низкоприоритетных генераций видео. Также пользователи с подпиской Pro смогут выполнять до пяти генераций одновременно и скачивать ролики без водяных знаков. OpenAI отмечает, что видео, созданные с помощью Sora, по умолчанию будут иметь видимые водяные знаки и метаданные C2PA, указывающие на их создание с помощью ИИ. Sora может создавать несколько вариантов видеоклипов на основе текстовой подсказки или изображения, а также редактировать существующие видео с помощью инструмента Re-mix. Интерфейс Storyboard позволяет пользователям создавать видео на основе последовательности подсказок, инструмент Blend объединяет два видео, сохраняя элементы обоих, а опции Loop и Re-cut дают возможность авторам дополнительно настраивать и редактировать свои видео и сцены. По словам видеоблогера Маркуса Браунли (Marcus Brownlee), известного как MKBHD, который получил доступ к предварительной версии Sora, система работает далеко не идеально. На создание среднего видеоролика в формате 1080p у него уходило «пара минут». Эта модель страдает от тех же недостатков, что и другие генераторы видео: ей не хватает постоянства объектов. В видеороликах Sora объекты перемещаются нелогично, исчезают и появляются вновь без видимой причины. Ноги — ещё один серьёзный источник проблем, отмечает Браунли. Если человек или животное с ногами долго ходит в ролике, Sora путает передние и задние ноги, а сами ноги могут «меняться местами». Также сообщается, что в Sora встроен ряд защитных механизмов, запрещающих генерировать видео с изображением людей младше 18 лет, содержащие насилие, «откровенные темы» или нарушающие авторские права третьих лиц. По словам Браунли, Sora также не создаёт видео на основе изображений с общественными деятелями, узнаваемыми персонажами или логотипами. Компания предупреждает, что «неправомерное использование загружаемых медиафайлов» может привести к запрету или приостановке работы аккаунта. По мнению блогера, новинка может быть полезна для генерации таких вещей, как заставки в определенном стиле, анимации, абстракции и стоп-кадры. Но он не стал бы рекомендовать её для создания фотореалистичных роликов. OpenAI подчёркивает, что это «ранняя версия Sora», в которой «будут ошибки». «Она не идеальна, но уже на том этапе, когда мы думаем, что она будет действительно полезна для дополнения человеческого творчества, — заявил Уилл Пиблз (Will Peebles), член технического персонала OpenAI и руководитель исследования Sora. — Мы не можем дождаться, когда увидим, что мир создаст с помощью Sora». Если у вас нет подписки на ChatGPT, вы всё равно сможете просматривать ленту видеороликов, созданных искусственным интеллектом другими пользователями с помощью Sora. В то время как модель станет доступна в США и многих других странах уже сегодня, генеральный директор OpenAI Сэм Альтман (Sam Altman) отметил, что запуск в «большинстве стран Европы и Великобритании» может «занять некоторое время». Китайская Tencent представила генератор видео HunyuanVideo, который пользователи назвали лучшим из существующих

05.12.2024 [10:57],

Павел Котов

Китайский технологический гигант Tencent анонсировал HunyuanVideo — передовую модель искусственного интеллекта для генерации видео, опубликованную с открытым исходным кодом. Впервые код вывода и веса модели ИИ с такими возможностями доступны всем желающим.

Источник изображения: Tencent HunyuanVideo, как утверждает Tencent, способна генерировать видеоролики на уровне ведущих мировых систем с закрытым исходным кодом — эти видео отличают высокое качество картинки, разнообразие движений объектов в кадре, способность синхронизировать визуальный и звуковой ряд, а также стабильность генерации. Это крупнейшая модель для генерации видео — у неё 13 млрд параметров. Пакет HunyuanVideo включает в себя фреймворк с инструментами для управления данными; инструментами для совместного обучения моделей, работающих с изображениями и видео; а также инфраструктуру с поддержкой крупномасштабного обучения моделей и их запуска. Tencent протестировала модель при поддержке профессионального сообщества, которое установило, что HunyuanVideo превосходит по качеству закрытые проекты Runway Gen-3 и Luma 1.6. Чтобы добиться такого результата, разработчик обратился к гибридной архитектуре передачи «двойного потока в одинарный» (Dual-stream to Single-stream). На начальном этапе видео- и текстовые токены обрабатываются независимо несколькими блоками модели-трансформера, благодаря чему данные разных форматов преобразуются без помех. На этапе единого потока видео- и текстовые токены передаются в последующие блоки трансформера, обеспечивая эффективное слияние мультимодальных данных. Это позволяет зафиксировать сложные отношения между визуальной и семантической информацией, а общая производительность модели повышается. Выпустив HunyuanVideo, компания Tencent сделала значительный шаг к демократизации технологий создания видео при помощи ИИ. Благодаря открытому исходному коду модель способна произвести революцию в экосистеме генерации видео. ИИ-функция Google Vids для генерации видео стала доступна пользователям Workspace

08.11.2024 [19:47],

Владимир Фетисов

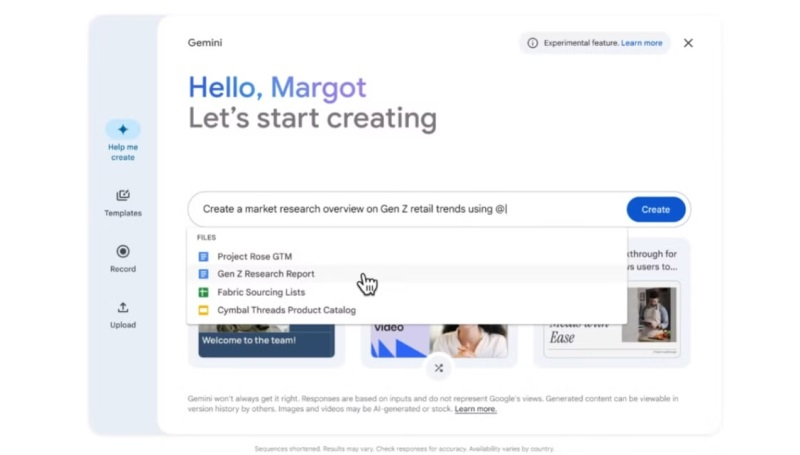

В апреле этого года Google представила инструмент Vids, который построен на базе искусственного интеллекта, предназначен для генерации или редактирования видео, а также позиционируется как средство для совместной работы. Он позволит пользователям создавать ролики профессионального уровня без необходимости учиться работе с ПО для редактирования и обработки видео. Теперь же этот инструмент становится доступен пользователям платформы Google Workspace.

Источник изображения: Google В новом сообщении разработчиков в блоге Workspace подчёркивается, что Vids будет полезен для команд, занимающихся обучением клиентов, развитием разных проектов, маркетингом, хотя по сути данный инструмент может пригодиться кому-угодно для реализации творческих идей. Основой Vids стала нейросеть Gemini, которая позволяет быстро генерировать видео, которые могут потребоваться бизнес-клиентам компании. К примеру, одна из функций позволяет сгенерировать раскадровку на основе текстового запроса и документа из Google Диска. В раскадровке излагаются подтемы, которые будут рассмотрены в будущем видео, а пользователь может менять их очередность, удалять какие-то пункты и добавлять новые. После выбора стиля алгоритм объединит черновик видео с созданным сценарием, включая выбранные медиафайлы, текст, сценарии для каждой сцены и даже фоновую музыку. Пользователи также получат доступ к готовым шаблонам, которые можно быстро адаптировать под свои задачи. При необходимости к видео можно добавить закадровый голос, генерируемый ИИ-алгоритмом. Отметим, что входящие в состав Vids функции на основе ИИ, такие как «Помоги мне создать», «Удалить фон изображения», «Создать закадровый голос», будут доступны бесплатно до конца 2025 года. В сообщении разработчиков сказано, что ограничения на использование ИИ-функций в Vids могут быть введены, начиная с 2026 года. Google начала тестировать Vids с привлечением ограниченного числа пользователей летом этого года. Теперь же этот инструмент становится доступным бизнес-клиентам платформы Workspace. Отмечается, что для оптимальной работы в Vids лучше использовать последние версии браузеров Chrome, Firefox и Edge для Windows. Другие браузеры также поддерживаются, но некоторые функции могут работать в них некорректно. Представлен ИИ-генератор чрезвычайно реалистичных видео Luma Dream Machine — попробовать можно бесплатно

13.06.2024 [16:24],

Павел Котов

Компания Luma Labs представила модель искусственного интеллекта Dream Machine, предназначенную для создания видео и доступную массовому пользователю. Систему отличает высокий реализм — создаваемые ей видео совсем не похожи на творчество ИИ.

Источник изображений: x.com/LumaLabsAI Разработчик анонсировал свой проект в соцсети X, опубликовав несколько примеров созданных ИИ видео. «Представляем Dream Machine — видеомодель нового поколения для создания высококачественных реалистичных роликов по текстовым запросам и изображениям с помощью ИИ», — говорится в описании. Проект стал пользоваться высоким спросом, поэтому в ближайшее время опробовать систему в деле будет непросто — запросы большинства пользователей ставятся в очередь, и некоторые бросают забаву, так и не дождавшись результатов. Возможно, когда шумиха вокруг нового проекта поутихнет, работать с системой будет проще. Попробовать создать видео по текстовому описанию или по статическому изображению может любой желающий, достаточно лишь зарегистрировать учётную запись. После этого в Dream Machine можно создать 30 видео в месяц — есть и платные варианты до 2000 видео в месяц за $499, но большинству, вероятно, хватит бесплатной версии сервиса. ИИ-модель действительно отличают реалистичные видео, причём реалистично смотрятся не только объекты на роликах, но и движения камеры — как будто съёмку ведёт профессиональный оператор. |