|

Опрос

|

реклама

Быстрый переход

«Сбер» предсказал всплеск ИИ-мошенничества, к которому никто не готов, к середине этого года

04.03.2025 [22:43],

Дмитрий Федоров

Мошенники в 2025 году начнут активно использовать ИИ для создания дипфейков, подделки голоса и телефонных звонков на разных языках. По оценке «Сбера», финансовые институты недостаточно подготовлены к подобным угрозам, что может привести к увеличению финансовых потерь среди рядовых граждан. Банкам и государственным структурам необходима срочная модернизация систем безопасности для предотвращения таких преступлений.

Источник изображения: Wesley Tingey / Unsplash Согласно прогнозу «Сбера», уже к середине 2025 года мошенники начнут активно применять технологии генеративного ИИ для создания реалистичных подделок изображений, видеозаписей и голосов. Эти методы уже используются при создании фишинговых сайтов, но вскоре выйдут на новый уровень. «Мы прогнозируем, что примерно к середине года появятся дипфейки», — заявил заместитель председателя правления «Сбера» Станислав Кузнецов. Особенно серьёзной угрозой, связанной с развитием ИИ, станет преодоление языкового барьера в телефонном мошенничестве. Кузнецов отметил, что в ближайшие три-четыре месяца злоумышленники начнут активно применять технологии генерации речи на различных языках. «Как только модели позволяют нам сегодня преодолеть последнюю границу — языковой барьер, как только нажатием одной кнопки можно звонить в любую страну или разговаривать на любом языке, следует задуматься о том, что телефонное мошенничество появится и на башкирском, и на татарском языках», — подчеркнул он. Согласно данным, представленным Кузнецовым, 81 % мошеннических звонков совершается через мессенджеры, sim-box и облачные АТС. Оставшиеся 19 % приходятся на классические телефонные звонки, причём лишь 1 % осуществляется с подменой номера. Это означает, что основная угроза исходит именно от мессенджеров, а не от традиционной телефонии. По данным Центрального банка России (ЦБ), в 2024 году мошенники похитили у клиентов банков 27,5 млрд руб., принуждая их совершать денежные переводы. Основной инструмент преступников — методы социальной инженерии, основанные на обмане и манипуляции жертвами. Банк России направил операторам связи почти 172 тысячи номеров, использовавшихся злоумышленниками, что подчёркивает масштаб проблемы. Несмотря на снижение числа мошеннических звонков через традиционную телефонную связь, преступники продолжают активно применять мессенджеры не только для звонков, но и для рассылки вредоносного программного обеспечения (ПО) и поддельных документов. ООН рассказала об использовании Telegram преступными сетями из Юго-Восточной Азии

07.10.2024 [20:02],

Сергей Сурабекянц

Представитель ООН заявил, что в Telegram открыто и в огромных масштабах продаются похищенные данные, а также доступны инструменты для киберпреступников и услуги по отмыванию денег. В недавно опубликованном докладе ООН утверждается, что преступные группировки Юго-Восточной Азии широко используют приложение, что позволяет им вести крупномасштабную незаконную деятельность.

Источник изображения: Pixabay В отчёте Управления ООН по наркотикам и преступности (УНП ООН) говорится, что в Telegram широко продаются похищенные персональные данные, что авторы отчёта связывают со слабой модерацией в приложении. Широко доступны также инструменты, используемые киберпреступниками, включая программное обеспечение для создания дипфейков и вредоносное ПО для кражи данных, а нелицензированные криптовалютные биржи предлагают в Telegram услуги по отмыванию денег. Юго-Восточная Азия стала крупным центром многомиллиардной криминальной индустрии, которая использует мошеннические схемы для поиска жертв по всему миру. По данным УНП ООН, отрасль ежегодно генерирует от 27,4 до 36,5 млрд долларов. В качестве примера цитируется рекламное объявление на китайском языке: «Мы ежедневно переводим 3 миллиона долларов США, украденных из-за рубежа». В докладе идёт речь о китайских преступных синдикатах, замешанных в торговле людьми и использовании рабского труда. «Есть убедительные доказательства того, что подпольные рынки данных перемещаются в Telegram, а поставщики активно ищут цели для транснациональных организованных преступных группировок, базирующихся в Юго-Восточной Азии», — говорится в отчёте. В августе в Париже создателю и главе мессенджера Павлу Дурову были предъявлены обвинения по шести пунктам, в том числе в отказе от сотрудничества. Самый тяжкий пункт — соучастие в администрировании онлайн-платформы для совершения незаконных транзакций. За это Дурову грозит наказание до десяти лет лишения свободы и штраф до €500 тыс. Поводом для ареста Дурова стал отказ администрации мессенджера от сотрудничества с властями Евросоюза, а политика модерации давно вызывала критику у властей. Париж также оказался разочарован отказом платформы сотрудничать конкретно с французскими властями. После ареста Дуров заявил, что приложение станет передавать IP-адреса и номера телефонов пользователей властям, подающим официальные юридические запросы. Он также пообещал, что будут удалены некоторые функции, которые использовались для незаконной деятельности. Арест Дурова привлёк внимание к ответственности поставщиков приложений, а также вызвал дебаты о том, где заканчивается свобода слова и начинается исполнение закона. В отчёте УГП ООН говорится, что размах деятельности преступных группировок в регионе привёл к внедрению ими инноваций и новых бизнес-моделей и технологий, включая вредоносное ПО, генеративный ИИ и дипфейки. Заместитель представителя УНП ООН Бенедикт Хофман (Benedikt Hofmann) заявил, что приложение является удобной средой для преступников. «Для потребителей это означает, что их данные подвергаются большему риску попасть к мошенникам или в другую преступную схему, чем когда-либо прежде», — считает он. По словам Хофмана, УНП ООН выявило более 10 поставщиков услуг программного обеспечения для создания дипфейков, «специально нацеленных на преступные группы, занимающиеся кибермошенничеством в Юго-Восточной Азии». В настоящее время регулирующие органы Южной Кореи проводят расследование о причастности мессенджера Telegram к распространению дипфейков сексуального содержания из-за недостаточной модерации. Сообщается, что в Telegram есть каналы с более чем 200 000 подписчиков, где распространяется такой контент. В прошлом месяце агентство Reuters сообщило, что чат-боты Telegram использовались для кражи данных из ведущей индийской страховой компании Star Health, что побудило страховую компанию подать в суд на онлайн-платформу. К преступникам могли попасть документы по страхованию и претензиям, содержащие имена, номера телефонов, адреса, налоговые реквизиты, копии удостоверений личности, результаты анализов и медицинские диагнозы. Напомним, что бот для передачи информации о нарушениях правил мессенджера Telegram заработал в России с 23 сентября. Южная Корея ввела уголовную ответственность за просмотр, хранение и распространение сексуальных дипфейков

27.09.2024 [18:14],

Сергей Сурабекянц

26 сентября южнокорейский парламент принял законопроект, предусматривающий уголовную ответственность за распространение, хранение и просмотр видео или изображений, содержащих дипфейки откровенно сексуального характера. За просмотр и хранение такого контента закон предусматривает наказание в виде тюремного заключения на срок до трёх лет или штрафа до 30 млн вон ($22,6 тыс.), а за создание подобных дипфейков грозит заключение сроком до пяти лет или штраф.

Источник изображения: Pixabay Только в этом году южнокорейская полиция получила более 800 заявлений о создании дипфейков сексуального содержания. В частности, регулирующие органы Южной Кореи проводят расследование о причастности мессенджера Telegram к распространению такого контента из-за недостаточной модерации. Сообщается, что в Telegram есть каналы с более чем 200 000 подписчиков, где распространяется такой контент. Чтобы нынешний закон вступил в силу, его должен подписать президент Южной Кореи Юн Сок Ель. Российские законодатели также на днях предложили добавить ответственность за дипфейки в Уголовный кодекс — в Госдуму внесён законопроект, предлагающий признать использование дипфейков отягощающим обстоятельством при мошенничестве и клевете. YouTube больше не станет терпеть дипфейки и ИИ-плагиат

06.09.2024 [07:46],

Анжелла Марина

YouTube сказал твёрдое «нет» дипфейкам и ИИ-плагиату, защищая права авторов на платформе. По данным The Verge, компания начинает разработку новых инструментов, которые дадут создателям контента больше контроля над использованием их голоса и образа, сгенерированного искусственным интеллектом.

Источник изображения: convertcrypto.ru Первый инструмент, получивший название «технология идентификации синтезированного пения», позволит артистам и авторам автоматически распознавать и управлять контентом YouTube, в котором их голоса имитируются с помощью искусственного интеллекта. Эта технология будет интегрирована в существующую систему идентификации авторских прав Content ID и запущена в рамках пилотной программы в следующем году. Решение YouTube связано с растущим беспокойством в музыкальной индустрии по поводу использования ИИ для создания копий песен и голосов артистов. В открытом письме, опубликованном ранее в этом году, более 200 артистов, включая Билли Айлиш (Billie Eilish), Pearl Jam (Pearl Jam) и Кэти Перри (Katy Perry), назвали несанкционированное ИИ-копирование «посягательством на человеческий творческий потенциал» и потребовали от видеохостинга большей ответственности в этом отношении. Помимо защиты голосов, YouTube на своей платформе также разрабатывает инструмент для выявления дипфейков лиц и образов авторов, актёров, музыкантов и спортсменов. Однако система ещё находится в разработке и не сообщается, когда она будет запущена. В дополнение к этому, YouTube обещает бороться с теми, кто собирает данные с платформы для обучения ИИ-моделей. «Мы ясно дали понять, что несанкционированный доступ к контенту авторов нарушает наши условия обслуживания», — заявили представители YouTube. Однако это не помешало таким компаниям, как OpenAI, Apple, Anthropic, Nvidia, Salesforce и Runway AI, обучать свои ИИ-системы на тысячах скачанных с YouTube видео. Для защиты контента от ботов-сканеров YouTube планирует блокировать им доступ полностью и для этого начнёт инвестировать в систему обнаружения сбора данных. Также заявляется, что разрабатываются способы предоставления авторам больше возможностей в отношении того, как сторонние компании, занимающиеся ИИ, всё же смогли бы использовать их контент на платформе, очевидно делясь заработками. Более подробная информация об этом выйдет позднее в этом году. Политические дипфейки оказались самой популярным направлением в злоупотреблениях ИИ

26.06.2024 [00:26],

Анжелла Марина

Исследование Google DeepMind выявило, что злоупотребления искусственным интеллектом (ИИ) в форме дипфейков — реалистичных поддельных изображений политиков и знаменитостей или их видео и аудио — намного превосходят использование ИИ для кибератак.

Источник изображения: Kandinsky Согласно анализу, проведённому совместно с исследовательским подразделением группы Jigsaw, наиболее распространённой целью злоупотреблений генеративным ИИ стало формирование общественного мнения или влияние на него, что составило 27 % всех случаев использования искусственного интеллекта, сообщает Ars Technica. Такие данные вызывают у экспертов серьёзные опасения по поводу влияния дипфейков на предстоящие во многих странах мира выборы в 2024 году. Отмечается, что в последние месяцы в социальных сетях, таких как TikTok, X и Instagram✴, появились дипфейки премьер-министра Великобритании Риши Сунака (Rishi Sunak) и других мировых лидеров. Избиратели Великобритании пойдут на всеобщие выборы уже на следующей неделе, и существует обеспокоенность тем, что, несмотря на усилия платформ социальных сетей по маркировке или удалению такого контента, аудитория может не распознать его как фейк, что потенциально повлияет на решения избирателей. Арди Янжева (Ardi Janjeva), научный сотрудник Института Алана Тьюринга (The Alan Turing Institute), отмечает, что распространение контента, созданного ИИ, может «искажать наше коллективное понимание социально-политической реальности», что представляет долгосрочные риски для демократических процессов, даже если прямое влияние на поведение избирателей пока не доказано. По мере роста популярности генеративных ИИ-продуктов, таких как ChatGPT от OpenAI и Gemini от Google, компании, разрабатывающие ИИ, начинают более пристально следить за потенциально вредным или неэтичным контентом, создаваемым их инструментами. Например, в мае OpenAI опубликовала исследование, показавшее использование их инструментов для создания и распространения дезинформации, связанное с Россией, Китаем, Ираном и Израилем. Второй по распространённости мотивацией злоупотреблений стало получение финансовой выгоды, например, через предложение услуг по созданию дипфейков, включая создание изображений реальных людей, или использование генеративного ИИ для создания фейковых новостных статей. Исследование показало, что в большинстве инцидентов используются легкодоступные инструменты, не требующие глубоких технических знаний, что в свою очередь только может увеличивать рост числа злоумышленников в среде ИИ. Одновременно результаты исследования Google DeepMind повлияют на действия ИИ-компаний для проверки моделей на безопасность и оценку не только пользы, но и потенциального вреда от использования генеративного ИИ. Поддельный Илон Маск продвигает мошеннические схемы с криптовалютой на YouTube Live

24.06.2024 [19:26],

Сергей Сурабекянц

Голос Илона Маска (Elon Musk), сгенерированный искусственным интеллектом, в сегодняшней прямой трансляции посоветовал зрителям разместить криптовалюту на сомнительном сайте. В пятичасовом эфире на YouTube Live был показан фрагмент видеоряда с мероприятия Tesla, где Маск якобы призывает зрителей внести криптовалюту, чтобы принять участие в розыгрыше. Всем участникам был обещан автоматический возврат внесённой суммы в двойном размере.

Источник изображений: Engadget В какой-то момент трансляцию одновременно смотрели более 30 000 зрителей (не исключена накрутка ботами), что подняло её на вершину рекомендаций YouTube Live Now. Учётная запись @elon.teslastream, имела значок подтверждённого официального канала, что может говорить о взломе учётной записи. Через некоторое время и видео, и канал были удалены. Число подобных дипфейковых мошенничеств от лица Маска резко возросло за последние месяцы. В каждом случае преступники используют учётную запись якобы одной из компаний Маска. Сегодняшнее видео имело подзаголовок «Tesla представляет шедевр: Tesla, которая навсегда изменит автомобильную промышленность». В начале июня, во время запуска Starship, сообщалось об аналогичных мошенничествах, проводимых 35 аккаунтами от лица SpaceX. Криптовалютные преступления, нацеленные на последователей Маска в социальных сетях, уже много лет является проблемой, как и мошенничество с участием знаменитостей в целом. 21 июня были одновременно взломаны сайт и аккаунт в социальной сети X рэпера 50 Cent. Точная сумма ущерба неясна, по слухам, преступники украли мемкойн GUNIT на сумму около $3 млн. Государство получит право использовать голоса россиян после их смерти без согласия родственников

31.05.2024 [13:00],

Павел Котов

Голоса россиян будут защищены от неправомерного использования — это регламентирует проект закона «Об охране голоса», разработанный Альянсом в сфере ИИ и Национальной федерацией музыкальной индустрии (НФМИ). Вместе с тем государство получит право использовать в общественных интересах голос гражданина после его смерти без согласия родственников. Об этом сообщили «Ведомости» со ссылкой на заявление члена Совета Федерации по конституционному законодательству и госстроительству Артёма Шейкина, а также разработчиков документа.

Источник изображения: Soundtrap / unsplash.com Законопроект предусматривает внесение изменений в Гражданский кодекс (ГК). В общем случае для обнародования и дальнейшего использования голоса гражданина требуется его согласие; после его смерти согласие необходимо получать у супруга, детей или родителей. Но если голос предполагается использовать в государственных или общественных интересах, то такое согласие не требуется — при условии, что голос записывался за плату или в публичных местах. Документ описывает механизм правовой защиты голоса от неправомерного использования и создания дипфейков на основе его записей. В рамках работы секции «Искусственный интеллект» Совета по развитию цифровой экономики при Совете Федерации анализировались предложения экспертов и профильных ведомств по определению дипфейка. «Сейчас мы находимся на завершающем этапе проработки этого определения, которое будет закреплено в законопроекте», — сообщил господин Шейкин. Уже готовится итоговая версия законопроекта — после получения отзыва от правительства он будет внесён в Госдуму.

Источник изображения: Studio_Iris / pixabay.com «Если голос гражданина, воссозданный с помощью специальных технологий, получен или используется в интернете с нарушением закона, гражданин вправе требовать удаления этой записи, а также пресечения или запрещения её дальнейшего использования и распространения», — считает Артём Шейкин. Нарушения ГК предусматривают последствия в виде возмещения убытков и вреда, выплат неустойки, приостановления или прекращения определённой деятельности, возврата неосновательного обогащения и другие меры. Российское законодательство в существующем виде охраняет лишь фотографическое изображение человека, а нормы, которые защищают артистов и дикторов от использования их синтезированных голосов и цифровых образов, пока отсутствуют, отметили в НФМИ. Речевые особенности человека не охраняются правом ни в одной стране мира, отмечают опрошенные «Ведомостями» эксперты, хотя в России действуют законы «О персональных данных» и «О биометрических данных», которые требуют обрабатывать данные, включая голос, лишь с согласия человека. Принятие нового закона сформирует базу для разрешения споров в области прав на голос — к примеру, до сих пор нет ясности, кому принадлежит воспроизведённый нейросетью голос человека: ему самому или разработчику этой нейросети. Так, американская актриса Скарлетт Йоханссон (Scarlett Johansson) уже минимум дважды была вынуждена отстаивать право на собственный голос. Сейчас также распространилась мошенническая схема с использованием сгенерированных голосовых записей, призванных убедить жертву перевести деньги злоумышленникам. Предложенный законопроект конкретных мер ответственности за неправомерное использование голоса не предусматривает, но есть и другой, который предусматривает внесение поправок уже в Уголовный кодекс РФ — он также ещё не внесён в Госдуму. McAfee продемонстрировала детектор звуковых дипфейков

09.05.2024 [15:08],

Павел Котов

На мероприятии RSA Conference компания McAfee продемонстрировала систему Deepfake Detector, работа над которой ведётся при участии Intel. Система, первоначально называвшаяся Project Mockingbird, предназначена для обнаружения звуковых дипфейков — аудиоподделок, созданных при помощи искусственного интеллекта.

Источник изображения: S. Keller / pixabay.com Технический директор McAfee Стив Гробман (Steve Grobman) показал работу Deepfake Detector на примере двух видеороликов — показ видео сопровождается информацией от ИИ-детектора, которая выводится в строке состояния. При запуске видеоролика, не подвергавшегося обработке, система показала нулевую вероятность подделки. Далее было запущено явно фейковое видео, на которое система сразу отреагировала показателем в 60 %, и по мере просмотра вероятность выросла до 95 %. С момента первой демонстрации на CES 2024 инженеры McAfee оптимизировали систему для работы с ИИ-ускорителями Intel NPU на чипах Meteor Lake, что позволило увеличить производительность на 300 %. Можно запускать несколько процессов Deepfake Detector для одновременного анализа нескольких видеороликов; хотя и видеозаписями возможности системы не ограничиваются — она может анализировать звук любого приложения в системе. А локальный режим её работы вместо запуска из облака означает высокую конфиденциальность — анализируемые данные не покидают компьютера. Авторы проекта преднамеренно ограничились работой со звуком: специалисты McAfee по борьбе с угрозами обнаружили, что во многих публикуемых мошенниками видеороликах используется настоящее видео с поддельным звуком. Фальшивый звук сопровождает и поддельное видео, а значит, постоянной величиной чаще всего оказывается подделка аудио. Сейчас компания работает над адаптацией технологии для потребителей — для этого управление программой будет необходимо сделать предельно простым и понятным. Мошенники с помощью голосового дипфейка пытались выдать себя за гендира LastPass

12.04.2024 [19:39],

Сергей Сурабекянц

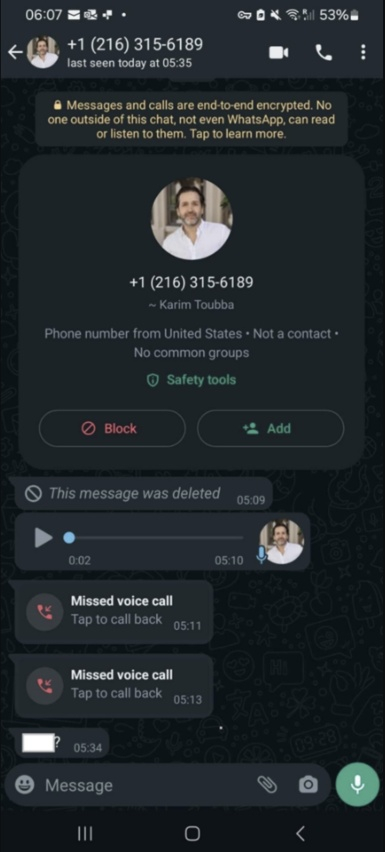

Менеджер паролей LastPass подвергся атаке мошенников, которые применили технологии искусственного интеллекта, пытаясь выдать себя за генерального директора LastPass Карима Туббу (Karim Toubba). Злоумышленники создали поддельную учётную запись Туббы в WhatsApp и начали переписку с одним из сотрудников компании. В процессе они отправляли голосовые сообщения, в которых имитировали голос руководителя Last Pass.

Источник изображения: insider.com Подвергшийся атаке сотрудник LastPass оказался достаточно опытным и стрессоустойчивым, поэтому попытка обмана силами дипфейка не удалась. Сотрудника насторожило то, что сообщения WhatsApp «выходили за пределы обычных каналов делового общения». Дополнительным поводом усомниться в реальности аудиосообщения от руководителя стало излишнее давление со стороны мошенников, тактика под названием «вынужденная срочность», которую преступники часто используют для манипулирования жертвами. Это окончательно убедило сотрудника LastPass, что вся переписка была фикцией.  LastPass сообщила, что попытка мошенничества не увенчалась успехом и сейчас расследованием инцидента занимается служба безопасности компании. Тем не менее, компания решила поделиться подробностями этого инцидента, чтобы привлечь внимание к тому, что дипфейки всё чаще используются для мошеннических кампаний с выдачей себя за руководителей. За последнее время многие компании, в том числе криптовалютная биржа Binance, столкнулись с мошенниками, выдающими себя за руководителей компаний при помощи искусственного интеллекта. Недавно в Гонконге занятый в финансовой сфере сотрудник международной компании, думая, что участвует в сеансе одновременной видеосвязи со своими коллегами, по указанию «финансового директора предприятия из Великобритании» перевёл $25,6 млн на указанный ему счёт. С 8 февраля 2024 года в США коммерческим компаниям запретили использовать голосовых ИИ-ботов в ходе автоматизированных «холодных звонков» потенциальным клиентам. Компания отдала мошенникам $25,6 млн после видеоконференции с дипфейками

05.02.2024 [18:19],

Владимир Мироненко

Транснациональная компания потеряла 200 млн гонконгских долларов ($26 млн) из-за мошенников, использовавших технологию дипфейка на новом уровне. Злоумышленникам удалось убедить сотрудника офиса компании в Гонконге перечислить указанную сумму с помощью фальшивого группового видеозвонка, в котором с помощью дипфейка участвовали поддельный финансовый директор и несколько сотрудников компании.

Источник изображения: Pixabay Полиция отметила, что это было первое дело такого рода для Гонконга, причём касающееся крупной суммы. По словам исполняющего обязанности старшего суперинтенданта Криминального бюро Барона Чана Шунь-цзина (Baron Chan Shun-ching), в предыдущих случаях мошенники обманывали жертв с помощью видеозвонков один на один. «В этот раз в ходе видеоконференции с участием нескольких человек все, кого можно было увидеть, оказались фальшивками», — сообщил он, добавив, что мошенникам удалось создать убедительные изображения целевых лиц, которые выглядели и звучали как настоящие люди. Сотрудник финансового отдела филиала компании сообщил полиции, что в середине января получил фишинговое сообщение, по-видимому, от финансового директора компании из Великобритании, в котором говорилось, что необходимо провести секретную транзакцию. Поначалу это вызвало у него сомнения, которые развеяла проведённая мошенниками групповая видеоконференция, на которой он увидел финансового директора, а также других сотрудников компании. По словам потерпевшего, сотрудники компании, участвовавшие в телефонной конференции, выглядели и говорили как настоящие люди. Затем мошенники поддерживали связь с жертвой через платформы обмена мгновенными сообщениями, электронную почту и видеозвонки один на один. В результате он, следуя указаниям фейкового руководителя, выполнил 15 переводов на общую сумму 200 млн гонконгских долларов на пять банковских счетов в Гонконге. Спустя неделю сотрудник начал подозревать неладное и обратился в головной офис компании. В результате проведённого расследования полиция установила, что участники видеоконференции были воссозданы в цифровом виде мошенниками, которые использовали общедоступные видео- и аудиозаписи этих лиц. «Они использовали технологию дипфейка, чтобы имитировать голос своих жертв, читающих текст», — отметил Чан. Он сообщил, что мошенники пытались найти подход к ещё несколькими сотрудникам компании из других филиалов, но отказался предоставить подробности обстоятельств дела. Расследование этого дела всё ещё продолжается. Старший инспектор Тайлер Чан Чи-Винг (Tyler Chan Chi-wing) сообщил, что существует несколько способов проверить, является ли человек, появившийся на экране, фальшивым цифровым фейком. Он предложил попросить собеседника делать движения головой, а также задавать вопросы, которые позволили бы определить подлинность персонажа, и сразу проявлять бдительность если тот попросит перечислить деньги. Полиция сообщила, что расширит свою систему оповещения, включив в неё систему быстрых платежей, чтобы предупреждать пользователей о том, что они переводят деньги на счета, связанные с мошенничеством. Мошенники вооружились ИИ для вымогательства с помощью фейковых голосовых сообщений

10.01.2024 [14:43],

Дмитрий Федоров

Злоумышленники стали практиковать новый метод вымогательства через социальные сети и мессенджеры с использованием ИИ для создания поддельных голосовых сообщений. Получив доступ к аккаунту пользователя, они рассылают его знакомым и во все чаты, где он состоит, поддельные голосовые сообщения с просьбами о переводе денег.

Источник изображения: B_A / Pixabay При этом мошенники не ограничиваются созданием с помощью ИИ поддельных голосовых сообщений: они также используют фотографии банковских карт, указывая на них имя и фамилию владельца украденного аккаунта. Это делается для придания дополнительной достоверности их просьбам о переводе денег. Так, один из пользователей социальной сети «ВКонтакте» потерял 200 000 рублей, а другой — 3000 рублей. Важно отметить, что в некоторых случаях злоумышленники использовали данные паспорта пользователя украденного аккаунта, которые отличались от информации в его социальных сетях, что дополнительно затрудняло выявление обмана. Это свидетельствует о высокой степени изощрённости и планирования таких атак. Представители «ВКонтакте» подчеркнули, что подобные массовые мошеннические схемы на их платформе отсутствуют. Для борьбы с такими угрозами компания использует системы безопасности, в том числе автоматические инструменты на основе ИИ, которые способны оперативно реагировать на обращения пользователей. По словам Евгения Егорова, ведущего специалиста департамента Digital Risk Protection компании F.A.C.C.T., взлом аккаунтов в Telegram или WhatsApp чаще всего происходит через фишинговые атаки, в том числе с использованием фейковых голосований. После кражи аккаунта мошенники скачивают сохранённые голосовые сообщения пользователя и с помощью ИИ создают поддельные аудиозаписи с нужным содержанием. Диана Селехина, эксперт центра мониторинга внешних цифровых угроз Solar AURA ГК «Солар», сообщила о значительном росте числа случаев мошенничества в Telegram, связанных с кражей аккаунтов. Она добавила, что за последние 30 дней было выявлено более 500 новых доменных имён, созвучных с названием мессенджера, что указывает на активизацию мошенников. Селехина отметила, что в Telegram наряду с фейковыми голосованиями и схемами подписки Premium активно распространяются и другие мошеннические методы. Общим элементом всех этих схем является требование от пользователей вводить свой номер телефона и SMS-код, которые затем используются для несанкционированного доступа к аккаунтам. В последнее время эксперты фиксируют участившееся использование дипфейков в Telegram, часто сочетаемых с поддельными голосовыми сообщениями. Упомянутая ситуация требует повышенного внимания со стороны пользователей социальных сетей и мессенджеров. Важно быть бдительным и критически подходить к любым просьбам о переводе финансовых средств, в том числе от знакомых лиц. Развитие ИИ открывает новые горизонты не только для положительных инноваций, но и для мошеннических схем. Всё это подчёркивает важность осведомлённости и предосторожности в цифровом мире. В России впервые оштрафовали компанию за воровство видео с дипфейком — в нём есть липовый Киану Ривз и утюг

06.12.2023 [16:36],

Павел Котов

Арбитражный суд Москвы взыскал с ООО «Бизнес-аналитика», управляющего аналитическим сервисом Roistat, компенсацию в размере 500 тыс. руб. за несанкционированное использование видео с дипфейком. В ролике использовался образ канадского актёра Киану Ривза (Keanu Reeves). Компенсация была присуждена создателю видео, компании «Рефейс Технолоджис», которая работает под брендом Agenda Media Group (AMG), сообщает Forbes.

Источник изображения: agenda.media На видеоролике человек, которому при помощи технологии дипфейка было дорисовано лицо Киану Ривза, пытается выйти из дома, но несколько раз возвращается и проверяет, выключил ли он утюг, — в итоге герой уносит утюг с собой. В июне 2023 года сервис Roistat начал распространять в Telegram рекламный ролик, в котором использовалось это видео. AMG специализируется на создании роликов с использованием дипфейков — компания также выпускала короткие постановки, используя образы Джейсона Стейтема (Jason Statham) и Роберта Паттинсона (Robert Pattinson). Ставший предметом разбирательства ролик имеет пародийный и юмористический характер, он направлен на завладение вниманием аудитории, а не прямое извлечение коммерческой выгоды. После выхода рекламы глава AMG Алексей Парфун обратился в Roistat, но администрация сервиса ответила, что «продукция нейросетей авторским правом не регулируется, можно брать и использовать». В ответ создатели видео подали в суд, «чтобы разобраться в юридической практике».

Источник изображения: succo / pixabay.com Решение суда было вынесено 30 ноября 2023 года. Как гласит его мотивировочная часть, «доводы ответчика о том, что созданный видеоролик не является объектом авторского права по причине использования технологии deep-fake, отклоняются судом, поскольку технология дипфейк — это дополнительный инструмент обработки (технического монтажа) видеоматериалов, а не способ их создания». Иными словами, при создании ролика был подготовлен сценарий; произведена видеосъёмка артиста, чьё лицо было заменено на образ Киану Ривза; создано аудиосопровождение; а использованная для подмены лица нейросеть оказалась одним из использованных рабочих инструментов, установил суд. Опрошенные Forbes специалисты, в частности, отметили, что современным нейросетям пока не под силу полностью генерировать видеоролики с настолько глубокой драматургией — ИИ выступает лишь как один из многих инструментов при производстве. При этом создатели ролика должны были также заручиться разрешением Киану Ривза на использование его образа — права артиста также были потенциально нарушены. Недавно схожую претензию за несанкционированное использование своего голоса в рекламе подала актриса Скарлетт Йоханссон (Scarlett Johansson). В 2021 году российский мобильный оператор «МегаФон» показывал серию рекламных роликов с использованием образа актёра Брюса Уиллиса (Bruce Willis) — при производстве видео также использовалась технология дипфейка, о чем компания предупреждала зрителей. «МегаФон» заключил с артистом контракт, действие которого к настоящему моменту завершено. Разработана система защиты голоса от создания дипфейков

29.11.2023 [15:49],

Павел Котов

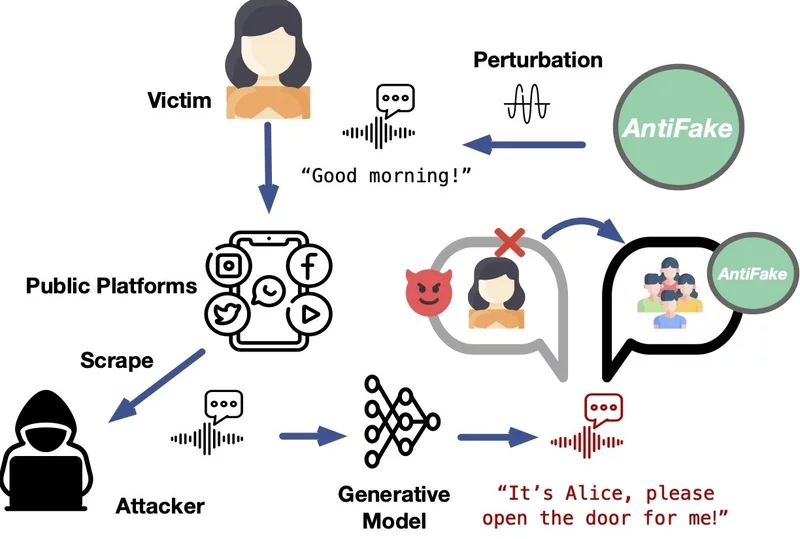

Технологии подделки голоса при помощи искусственного интеллекта являются довольно опасным инструментом — они способны правдоподобно воспроизвести человеческий голос даже по короткому образцу. Не допустить создание искусной подделки сможет предложенный американским учёным алгоритм AntiFake.

Источник изображения: Gerd Altmann / pixabay.com Дипфейки представляют собой достаточно опасное явление — с их помощью можно приписать знаменитому артисту или политику высказывание, которого он никогда не делал. Были также прецеденты, при которых злоумышленник звонил жертве и голосом друга просил срочно перевести деньги в связи с некой чрезвычайной ситуацией. Доцент кафедры компьютерных наук и инженерии Вашингтонского университета в Сент-Луисе Нин Чжан (Ning Zhang) предложил технологию, которая значительно усложняет создание голосовых дипфейков. Принцип работы алгоритма AntiFake состоит в формировании условий, при которых системе ИИ оказывается намного сложнее считывать ключевые характеристики голоса при записи разговора реального человека. «В инструменте используется техника состязательного ИИ, которая изначально применялась киберпреступниками, но теперь мы направили её против них. Мы немного искажаем записанный аудиосигнал, создавая возмущения ровно в той мере, чтобы для человека он звучал так же, а для ИИ — совершенно иначе», — прокомментировал свой проект господин Чжан.

Источник изображения: wustl.edu Это значит, что при попытке создать дипфейк на основе изменённой этим способом записи сгенерированный ИИ голос не будет похож на голос человека в образце. Как показали проведённые испытания, алгоритм AntiFake на 95 % эффективен для предотвращения синтеза убедительных дипфейков. «Что будет с голосовыми ИИ-технологиями дальше, я не знаю — новые инструменты и функции разрабатываются постоянно, — но всё же считаю, что наша стратегия использования техники противника против него самого так и останется эффективной», — заключил автор проекта. Американские актёры потребовали запретить студиям бесконтрольное использование дипфейков

14.07.2023 [16:23],

Павел Котов

Гильдия киноактёров США рассказала о борьбе, которую она ведёт со студиями за право контролировать цифровые копии артистов — студии, уверены в профсоюзе, хотят использовать их неограниченно. Представляющая студии организация заявила, что выдвинула «новаторское» предложение, которое поможет защитить актёров от подобных злоупотреблений.

Источник изображения: 0fjd125gk87 / pixabay.com Технологии искусственного интеллекта становятся больной темой для представителей актёрской профессии — они опасаются, что студии смогут бесконтрольно воспроизводить их внешний вид и голоса при помощи цифровых систем. Этот вопрос стал камнем преткновения в очередном раунде переговоров по поводу контрактов, которые должны заключаться с голливудскими студиями. Организация AMPTP, ведущая переговоры от имени Walt Disney, Netflix и других крупных игроков, заявила, что выдвинула «новаторское предложение по искусственному интеллекту», которое защитит актёров от возможных злоупотреблений. Эта мера защиты предполагает согласие актёра на создание и использование его цифровой копии либо на изменение его выступления при помощи цифровых средств, отметили представители студий и служб потокового видео. Дункан Крэбтри-Айланд (Duncan Crabtree-Ireland), главный переговорщик профсоюза SAG-AFTRA, представляющего интересы 160 тыс. актёров кино и телевидения, заявил, что это утверждение не соответствует действительности. «Они предлагают сканировать исполнителей, платить им за один день, чтобы компания владела этим отсканированным изображением, их подобием, и имела возможность использовать его вечно. Так что, если вы думаете, что это предложение новаторское, предлагаю вам подумать ещё», — цитирует Reuters Крэбтри-Айланда. В AMPTP возразили, что утверждение о возможности использовать цифровую копию артиста бессрочно без согласия или компенсации является ложным. По версии представителей студий и стримингов, в документе говорится, что договор об использовании цифровой копии заключается только на один фильм — дальнейшее применение технологий дипфейка требует согласия «отсканированного» актёра и переговоров о гонораре при условии, что он будет не меньше размера минимальной оплаты. Создано ПО, способное обмануть систему голосовой аутентификации в 99 случаях из 100

28.06.2023 [20:06],

Владимир Мироненко

Учёные-компьютерщики из Университета Ватерлоо создали программное обеспечение для дипфейка голосов, позволяющее в 99 % случаев обмануть систему голосовой аутентификации. Всё, что нужно при использовании этого ПО с поддержкой машинного обучения для клонирования голоса — пять минут аудиозаписи голоса человека.

Источник изображения: uk.pcmag.com Ведущий автор исследования Андре Кассис (Andre Kassis), кандидат наук в области компьютерной безопасности и конфиденциальности из Университета Ватерлоо, объяснил, как работает голосовая аутентификация: «При регистрации с использованием голосовой аутентификации вас просят повторить определённую фразу своим голосом. Затем система извлекает уникальную голосовую подпись (голосовой отпечаток) из этой предоставленной фразы и сохраняет её на сервере <..> При попытке аутентификации в будущем вас попросят сказать другую фразу, а извлечённые из неё характерные особенности сравниваются с голосовым отпечатком, сохранённым в системе, чтобы определить, следует ли предоставлять доступ». Как сообщается, даже меры противодействия спуфингу, используемые системами голосовой аутентификации, не позволяют заметить подмену, поскольку программа компьютерщиков из Университета Ватерлоо, удаляет маркеры из дипфейкового аудио, которые «выдают, что оно было сгенерировано компьютером». Сделав шесть попыток обойти систему аутентификации, учёные в 99 % добились успеха. Созданием поддельного голоса для обмана системы голосовой аутентификации никого не удивишь, но разработанное компьютерщиками ПО оказалось настолько эффективным, что профессор компьютерных наук Университета Ватерлоо Урс Хенгартнер (Urs Hengartner) выразил надежду, что компании, полагающиеся на голосовую аутентификацию как на единственный фактор аутентификации, «рассмотрят возможность развёртывания дополнительных или более строгих мер аутентификации». |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |