|

Опрос

|

реклама

Быстрый переход

ChatGPT потребляет не так много энергии, как считалось ранее, показало новое исследование

13.02.2025 [07:24],

Николай Хижняк

Согласно более ранним оценкам, ChatGPT потребляет около 3 Вт·ч энергии для ответа на один запрос, что в 10 раз больше средней мощности, необходимой при использовании поиска Google. Однако свежий отчёт исследовательского института Epoch AI, занимающегося изучением ключевых трендов и вопросов, которые будут определять траекторию развития и управление искусственным интеллектом, опровергает эту статистику и указывает на то, что энергозатраты чат-бота OpenAI значительно меньше, чем предполагалось ранее.

Источник изображения: OpenAI В отчёте Epoch AI говорится, что ChatGPT на базе модели GPT-4o потребляет всего 0,3 Вт·ч энергии при генерации ответа. В разговоре с порталом TechCrunch дата-аналитик Epoch AI Джошуа Ю (Joshua You) отметил: «Потребление энергии на самом деле не так уж и велико по сравнению с использованием обычных бытовых приборов, отоплением или охлаждением дома или использованием автомобиля». По словам эксперта, предыдущие оценки энергозатрат ChatGPT были основаны на устаревших данных. Специалист отмечает, что предполагаемая «универсальная» статистика энергопотребления ChatGPT была основана на предположении, что OpenAI для запуска и работы ИИ использует старые и неэффективные чипы. «Кроме того, некоторые из моих коллег обратили внимание, что наиболее широко распространённая оценка в 3 Вт·ч на выполнение запроса была основана на довольно старых исследованиях. И если судить по каким-то приблизительным расчётам, эта статистика показалась слишком завышенной», — добавил Ю. И всё же следует добавить, что оценку энергозатрат ChatGPT от Epoch AI тоже нельзя считать непреложной, поскольку она не учитывает некоторые ключевые возможности ИИ, такие как генерация изображений чат-ботом. По словам эксперта, он не ожидает роста энергопотребления у ChatGPT, но по мере того, как ИИ-модели становятся более продвинутыми, им будет требоваться больше энергии для работы. Ведущие компании по разработке ИИ, включая OpenAI, склоняются к развитию так называемых рассуждающих моделей ИИ, которые не просто дают ответ на поставленный вопрос, но также описывают весь процесс, который привёл к получению того или иного ответа, что в свою очередь требует больших энергозатрат. Множество отчётов последних лет показывают, что такие технологии, как Microsoft Copilot и ChatGPT (а точнее оборудование, на котором они работают) потребляют эквивалент объёма одной бутылки воды для охлаждения при генерации ответа на запрос. Эти выводы следуют за более ранним отчётом, в котором говорится, что совокупные энергозатраты Microsoft и Google превышают потребление электроэнергии более чем в 100 странах мира. В одном из наиболее свежих исследований подробно описывалось, что модель OpenAI GPT-3 потребляет в четыре раза больше воды, чем считалось ранее, в то время как GPT-4 потребляет объёмы до трёх бутылок воды, чтобы сгенерировать всего лишь 100 слов. Вполне очевидно, что модели ИИ начинают потреблять больше ресурсов по мере того, как становятся более продвинутыми. Однако, выводы последнего исследования показывают, что тот же ChatGPT может быть не таким прожорливым, как считалось ранее. Boston Dynamics обучит робота-гуманоида Atlas таскать тяжести и динамически бегать

06.02.2025 [11:35],

Владимир Мироненко

Boston Dynamics объявила о заключении соглашения о сотрудничестве с Институтом робототехники и искусственного интеллекта (Robotics and AI Institute), ранее известным как Институт ИИ Boston Dynamics (Boston Dynamics AI Institute), с целью обучения с подкреплением электрического человекоподобного робота Atlas.

Источник изображения: Boston Dynamics Обе организации были основаны Марком Райбертом (Marc Raibert), бывшим профессором Массачусетского технологического института, который в течение 30 лет занимал пост генерального директора Boston Dynamics. Институт робототехники и ИИ был создан им в 2020 году. Обе организации связаны с Hyundai: корейский автопроизводитель приобрёл Boston Dynamics в 2021 году и также финансирует институт. В рамках сотрудничества Boston Dynamics и институт сосредоточатся на обучении Atlas с подкреплением — одном из способов машинного обучения, который работает путём проб и ошибок, подобно тому, как учатся люди и животные. Обучение с подкреплением всегда было чрезвычайно трудоёмким процессом, однако создание эффективной симуляции позволило выполнять многие процессы одновременно в виртуальной среде, отметил ресурс TechCrunch. Это один из последних совместных проектов Boston Dynamics и института. Ранее они уже работали над созданием исследовательского комплекта для обучения с подкреплением четвероногого робота Spot от Boston Dynamics. В случае с Atlas учёные займутся обучением робота навыкам «динамического бега и манипулирования тяжёлыми предметами». Трещины на дорогах будут затягиваться сами собой: ИИ помог создать асфальт со способностью к регенерации

03.02.2025 [13:57],

Владимир Мироненко

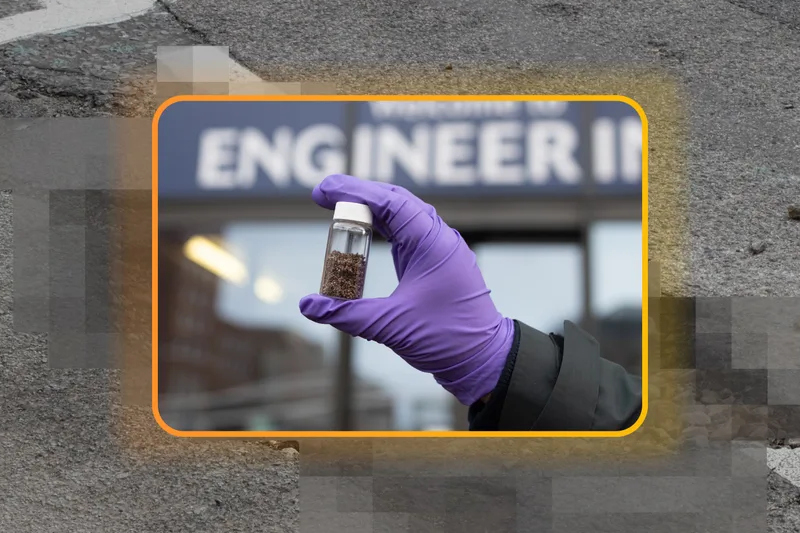

Исследователи из Королевского колледжа Лондона и Университета Суонси (Уэльс, Великобритания) в сотрудничестве с учеными из Чили, а также Google Cloud разработали новый тип асфальта, который способен со временем самостоятельно «заживлять» образовавшиеся трещины, устраняя необходимость в использовании ручного труда для их ремонта, сообщается в блоге Google.

Источник изображения: Google Причины образования трещин в асфальте пока не изучены полностью, но одной из частых причин является чрезмерное затвердевание в связи с окислением битума, который входит в состав асфальта. Ученые занимаются разработкой способов обратить этот процесс вспять, чтобы привести асфальт в прежнее рабочее состояние. Для изучения органических молекул веществ со сложным химическим составом, таких как битум, команда учёных использовала машинное обучение. Была разработана новая модель на основе собранных данных для ускорения атомистического моделирования, что позволило значительно продвинуться в исследовании процессов окисления битума и образования трещин. Этот подход значительно быстрее и экономичнее традиционных вычислительных моделей, отмечено в блоге Google. В сотрудничестве с Google Cloud учёные работали над созданием инструментов ИИ, которые позволяют определять химические свойства и создавать виртуальные молекулы, предназначенные для определенных целей, аналогично методам, используемым при открытии лекарств. Эксперт по вычислительной химии, доктор Франциско Мартин-Мартинес (Francisco Martin-Martinez) отметил значительный вклад Google Cloud в создание инструментов ИИ для быстрой разработки самовосстанавливающихся дорожных покрытий, подчеркнув, что подражание природе в её способности к самовосстановлению позволит продлить срок службы дорог и создать более устойчивую и надёжную дорожную инфраструктуру. Исследователи продемонстрировали в лабораторных экспериментах, как новый асфальтовый материал может залечить микротрещину менее чем за час. Чтобы получить битум со способностью к устранению трещин, исследователи добавили в него крошечные пористые споры растений, пропитанные переработанными маслами. Когда дорожное покрытие сжимается при движении транспорта, споры выдавливаются, и масло попадает в близлежащие трещины, размягчая битум настолько, что он может заполнять трещины. Исследователи полагают, что через пару лет они выйдут на этап коммерческого выпуска нового материала для использования на дорогах Великобритании. Nvidia научит старые видеокарты GeForce повышать FPS с помощью ИИ, но потом

20.01.2025 [17:56],

Николай Хижняк

В интервью Digital Foundry Брайан Катандзаро (Bryan Catanzaro), вице-президент по исследованиям в области прикладного глубокого обучения в Nvidia сообщил, что не исключает возможности в будущем внедрения функции генерации кадров силами ИИ для повышения FPS, ставшей частью технологии DLSS, в старые видеокарты Nvidia GeForce.

Источник изображений: Digital Foundry / Nvidia С момента своего дебюта в 2018 году технология масштабирования с глубоким обучением (DLSS) от Nvidia эволюционировала уже до четвёртой версии. Её последняя итерация перешла на ИИ-модель типа трансформер, что позволило реализовать ряд новых функций, включая мультикадровую генерацию (Multi Frame Generation, MFG). Последняя позволяет создавать до трёх дополнительных кадров на каждый традиционно отрисованный кадр для повышения FPS. Nvidia смогла реализовать некоторые новые технологии, включая реконструкцию лучей (DLSS Ray Reconstruction), супер-разрешение (Super Resolution) и технологию сглаживания, опирающуюся на искусственный интеллект (Deep Learning Anti-Aliasing, DLAA) на всех видеокартах GeForce RTX, начиная с 20-й серии. Однако генератор кадров (Frame Generation) первого поколения, изначально представленный как эксклюзивная функция видеокарт GeForce RTX 40-й серии, не поддерживается моделями GeForce RTX 30-й и RTX 20-й серий. Новый мультикадровый генератор так и вовсе изначально заявлен только для новейших GeForce RTX 5000. В разговоре с журналистами Брайан Катандзаро отметил, что не исключает появления функции генерации кадров у старых моделей видеокарт Nvidia. «Я думаю, что ключевым здесь является вопрос проектирования и оптимизации, а также конечного пользовательского опыта. Мы запускаем этот генератор кадров, лучший генератор кадров, коим является технология Multi Frame Generation, с видеокартами 50-й серии. А в будущем посмотрим, сможем ли что-то выжать для старого поколения оборудования», — прокомментировал представитель Nvidia. На фоне заявления Катандзаро можно предположить, что первая версия генератора кадров может в перспективе появиться на видеокартах GeForce RTX 30-й серии. Однако маловероятно, что она появится у моделей GeForce RTX 20-й серии. При этом, скорее всего, мультикадровый генератор кадров останется эксклюзивом видеокарт RTX 50-й серии, поскольку для его работы требуется значительно больше вычислительной мощности, заточенной под ИИ, которую у этих карт обеспечивают новые тензорные ядра. Один из ведущих разработчиков Nvidia также поделился некоторой информацией о разработке DLSS. «Когда мы создавали Nvidia DLSS 3 Frame Generation, нам было абсолютно необходимо аппаратное ускорение для вычислений Optical Flow. Но у нас не было достаточного количества тензорных ядер и не было достаточно хорошего алгоритма Optical Flow. Мы не создавали алгоритм Optical Flow для работы в реальном времени на тензорных ядрах, который мог бы вписаться в наш запас вычислительной мощности. У нас был аппаратный ускоритель Optical Flow, который Nvidia создавала годами как эволюцию нашей технологии видеокодирования. Он также был частью нашей технологии ускорения работы компьютерного зрения для беспилотных автомобилей. Казалось бы, для нас имело смысл использовать его и для Nvidia DLSS 3 Frame Generation. Но сложность в любой аппаратной реализации алгоритма типа Optical Flow заключается в том, что его действительно трудно улучшить. Он такой, какой он есть, и те сбои, которые возникли из-за этого аппаратного Optical Flow, мы не могли исправить с помощью более умной нейронной сети, пока не решили просто заменить его и перейти на решение, полностью основанное на ИИ. Именно это мы и сделали для Frame Generation в DLSS 4». Сильный ИИ не станет спасением для человечества — придётся ждать сверхинтеллект, считает глава OpenAI

05.12.2024 [00:02],

Николай Хижняк

Около двух лет назад OpenAI заявила, что искусственный интеллект общего назначения (Artificial General Intelligence, AGI), который также называнию сильным ИИ или ИИ уровня человека, «может возвысить человечество» и «предоставить всем невероятные новые возможности». Теперь же генеральный директор OpenAI Сэм Альтман (Sam Altman) пытается снизить градус ожидания от появления AGI.

Источник изображения: OpenAI Forum «Я предполагаю, что мы достигнем AGI раньше, чем думает большинство людей в мире, и это будет иметь гораздо меньшее значение. И многие опасения по поводу безопасности, о которых говорили мы и другие стороны, на самом деле не возникнут в момент создания AGI. AGI можно создать. Мир после этого будет в основном развивается примерно так же, как и сейчас. Некоторые вещи начнут выполняться быстрее. Но переход от того, что мы называем AGI, до того, что мы называем сверхинтеллектом — это очень долгая дорога», — сказал Альтман во время интервью на саммите The New York Times DealBook в среду. Альтман уже не первый раз преуменьшает значимость, казалось бы, теперь точно неизбежного создания искусственного интеллекта общего назначения, о котором когда-то говорилось в уставе самой компании OpenAI, и который, как она же заявляла, сможет «автоматизировать большую часть интеллектуального труда» человечества. Недавно глава OpenAI намекнул, что это может произойти уже в 2025 году и будет достижимо с помощью актуального специализированного программного и аппаратного обеспечения. Ходят слухи, что OpenAI просто объединит все свои большие языковые модели и назовёт это AGI. Последующее заявление Альтмана об AGI прозвучало так, как будто OpenAI больше не рассматривает создание искусственного интеллекта общего назначения как нечто грандиозное, что способно решить все проблемы человечества: «Мне кажется, что экономические трудности в мире будут продолжаться немного дольше времени, чем думают люди, потому что в обществе много инерции. Поэтому в первые пару лет [после создания AGI], возможно, будет не так много изменений. А потом, возможно, последует много изменений». Те надежды и возможные достижения, которые OpenAI ранее приписывала AGI, компания теперь возлагает на так называемый «сверхинтеллект», который как недавно спрогнозировал Альтман, может появиться «через несколько тысяч дней». Искусственный интеллект научили разоблачать учёных-шарлатанов

27.11.2024 [18:56],

Геннадий Детинич

Научный поиск вскоре может претерпеть коренные изменения — искусственный интеллект показал себя в качестве непревзойдённого человеком инструмента для анализа невообразимых объёмов специальной литературы. В поставленном эксперименте ИИ смог точнее людей-экспертов дать оценку фейковым и настоящим научным открытиям. Это облегчит людям научный поиск, позволив машинам просеивать тонны сырой информации в поисках перспективных направлений.

Источник изображения: ИИ-генерация Кандинский 3.1/3DNews С самого начала разработчики генеративных ИИ (ChatGPT и прочих) сосредоточились на возможности больших языковых моделей (LLM) отвечать на вопросы, обобщая обширные данные, на которых они обучались. Учёные из Университетского колледжа Лондона (UCL) поставили перед собой другую цель. Они задались вопросом, могут ли LLM синтезировать знания — извлекать закономерности из научной литературы и использовать их для анализа новых научных работ? Как показал опыт, ИИ удалось превзойти людей в точности выдачи оценок рецензируемым работам. «Научный прогресс часто основывается на методе проб и ошибок, но каждый тщательный эксперимент требует времени и ресурсов. Даже самые опытные исследователи могут упускать из виду важные выводы из литературы. Наша работа исследует, могут ли LLM выявлять закономерности в обширных научных текстах и прогнозировать результаты экспериментов», — поясняют авторы работы. Нетрудно представить, что привлечение ИИ к рецензированию далеко выйдет за пределы простого поиска знаний. Это может оказаться прорывом во всех областях науки, экономя учёным время и деньги. Эксперимент был поставлен на анализе пакета научных работ по нейробиологии, но может быть распространён на любые области науки. Исследователи подготовили множество пар рефератов, состоящих из одной настоящей научной работы и одной фейковой — содержащей правдоподобные, но неверные результаты и выводы. Пары документов были проанализированы 15 LLM общего назначения и 117 экспертами по неврологии человека, прошедшими специальный отбор. Все они должны были отделить настоящие работы от поддельных. Все LLM превзошли нейробиологов: точность ИИ в среднем составила 81 %, а точность людей — 63 %. В случае анализа работ лучшими среди экспертов-людей точность повышалась до 66 %, но даже близко не подбиралась к точности ИИ. А когда LLM специально обучили на базе данных по нейробиологии, точность предсказания повысилась до 86 %. Исследователи говорят, что это открытие прокладывает путь к будущему, в котором эксперты-люди смогут сотрудничать с хорошо откалиброванными моделями. Проделанная работа также показывает, что большинство новых открытий вовсе не новые. ИИ отлично вскрывает эту особенность современной науки. Благодаря новому инструменту учёные, по крайней мере, будут знать, стоит ли заниматься выбранным направлением для исследования или проще поискать его результаты в интернете. Каждый пятый ПК теперь оснащён ИИ-ускорителем, но люди покупают их не из-за этого

15.11.2024 [00:30],

Николай Хижняк

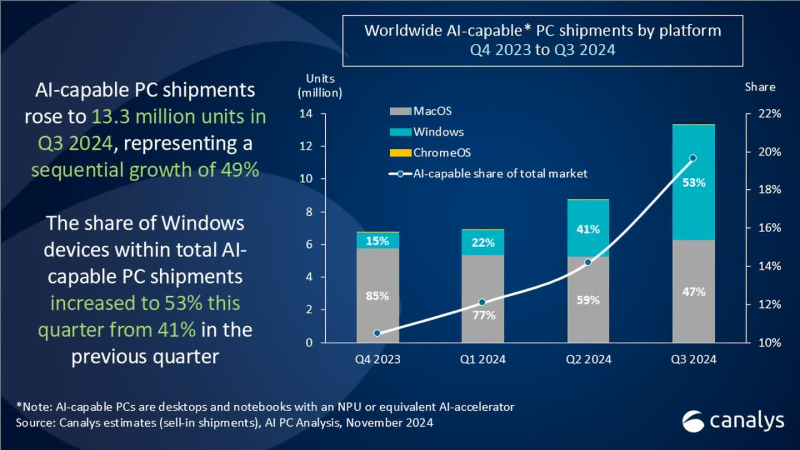

Поставки настольных и мобильных компьютеров с ускорителями для приложений искусственного интеллекта достигли 13,2 млн единиц в третьем квартале 2024 года, что составляет 20 % от всех поставок ПК за указанный период, по подсчётам агентства Canalys. Во втором квартале объём поставок таких компьютеров составлял 8,8 млн единиц.

Источник изображения: Microsoft Сразу стоит отметить, что к «ИИ-совместимым» персональным компьютерам аналитики Canalys относят все настольные и мобильные компьютеры, оснащённые специализированным ИИ-ускорителем NPU или «его аналогом». Таким образом к данной категории относятся не только системы на Copilot+PC на новейших чипах AMD, Intel и Qualcomm, но и Windows-компьютеры на чипах Intel и AMD прошлого поколения, а также все Apple Mac на процессорах M-серии.

Источник изображения: Canalys Согласно свежему анализу Canalys, на системы с Windows пришлось более половины (53 %) поставок ПК с ИИ в третьем квартале, тогда как доля Apple снизилась до 47 %. Во втором квартале лидером являлась как раз компания Apple с 59 % поставок систем с поддержкой ИИ, тогда как на долю систем с Windows приходилось 41 % поставок. Несмотря на прогресс в развитии ПК с поддержкой ИИ производителям по-прежнему приходится убеждать покупателей в том, что покупка такой системы, а стоят они зачастую дороже, того стоит. Некоторые наблюдатели утверждают, что рост поставок таких компьютеров не обязательно связан с тем, что люди ищут именно ПК с ИИ. Просто многие современные системы изначально оснащены ИИ-ускорителем.

Источник изображения: Canalys Главный аналитик Canalys Ишан Датт (Ishan Dutt) рассказал, что проведённый в ноябре опрос компаний, занимающихся продажами компьютеров, показал, что 31 % не планирует продавать системы Copilot+PC в следующем году, а 34 % респондентов ожидают, что такие устройства составят менее десятой части от общего объёма продаж в 2025 году. Для получения заветного обозначения Copilot+PC компания Microsoft требует от производителей ПК, чтобы система оснащалась ИИ-движком (NPU), производительность которого составляет не менее 40 TOPS (триллионов операций в секунду). В любом случае поставки и продажи ИИ-совместимых ПК в ближайшие месяцы должны вырасти, поскольку до даты окончания поддержки Windows 10, не имеющей функции ИИ, осталось меньше года. По данным StatCounter, Windows 10 по-прежнему занимает более 60 % рынка настольных ПК на базе Windows во всём мире. С прекращением поддержки многие потребители перейдут на новые ПК с Windows 11 в 2025 году. The Beatles номинированы на «Грэмми» с песней, восстановленной с помощью искусственного интеллекта

10.11.2024 [05:26],

Анжелла Марина

Легендарные The Beatles вновь номинированы на музыкальную премию «Грэмми» спустя более 50 лет после распада группы. Их последняя песня «Now and Then», отреставрированная в прошлом году с помощью искусственного интеллекта, претендует на звание «Запись года» наряду с песенными хитами Билли Айлиш (Billie Eilish) и Тейлор Свифт (Taylor Swift).

Источник изображения: Now And Then / YouTube Песня «Now and Then» была выпущена в ноябре 2023 года, но её история началась ещё в конце 1970-х годов. Тогда Джон Леннон (John Lennon) записал демоверсию этой композиции не в студийных условиях. Позднее запись, вместе с другими треками «Free As A Bird» и «Real Love», была передана оставшимся участникам группы в 1990-х годах для включения в проект The Beatles Anthology. Однако «Now and Then» так и не была завершена из-за технических ограничений того времени, которые не позволяли качественно отделить вокал Джона Леннона от инструментального сопровождения. Изменить ситуацию удалось только в 2021 году, когда режиссёр Питер Джексон (Peter Jackson) и его команда, снимавшие документальный фильм о «Битлз», использовали технологию машинного обучения. Это позволило ныне живущим Полу Маккартни (Paul McCartney) и Ринго Старру (Ringo Starr) завершить работу над песней, отделив голос от фортепиано и создав полноценный трек с сопровождением музыкальных инструментов. «Теперь, благодаря ИИ, мы смогли вернуть эту песню к жизни», — отметил Маккартни. Несмотря на то, что «Now and Then» была закончена с использованием искусственного интеллекта, она соответствует правилам «Грэмми» в отношении ИИ. Правила гласят, что «только люди имеют право быть номинированными или выиграть премию Grammy, но работы, содержащие элементы ИИ, имеют право участвовать в соответствующих категориях». Церемония «Грэмми» состоится 2 февраля 2025 года, а песне The Beatles придётся конкурировать с современными хитами известных артистов. «Больше, чем у кого-либо»: Цукерберг похвастался системой с более чем 100 тыс. Nvidia H100 — на ней обучается Llama 4

31.10.2024 [22:31],

Николай Хижняк

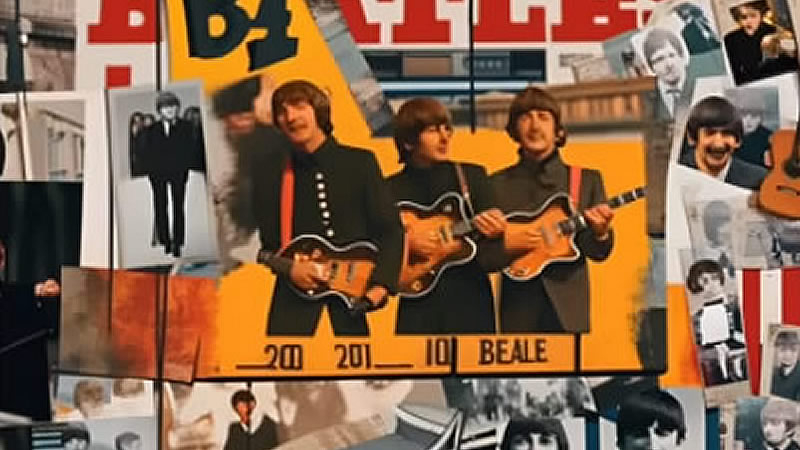

Среди американских IT-гигантов зародилась новая забава — соревнование, у кого больше кластеры и твёрже уверенность в превосходстве своих мощностей для обучения больших языковых моделей ИИ. Лишь недавно глава компании Tesla Илон Маск (Elon Musk) хвастался завершением сборки суперкомпьютера xAI Colossus со 100 тыс. ускорителей Nvidia H100 для обучения ИИ, как об использовании более 100 тыс. таких же ИИ-ускорителей сообщил глава Meta✴ Марк Цукерберг (Mark Zuckerberg).

Источник изображения: CNET/YouTube Глава Meta✴ отметил, что упомянутая система используется для обучения большой языковой модели нового поколения Llama 4. Эта LLM обучается «на кластере, в котором используется больше 100 000 графических ИИ-процессоров H100, и это больше, чем что-либо, что я видел в отчётах о том, что делают другие», — заявил Цукерберг. Он не поделился деталями о том, что именно уже умеет делать Llama 4. Однако, как пишет издание Wired со ссылкой на заявление главы Meta✴, их ИИ-модель обрела «новые модальности», «стала сильнее в рассуждениях» и «значительно быстрее». Этим комментарием Цукерберг явно хотел уколоть Маска, который ранее заявлял, что в составе его суперкластера xAI Colossus для обучения ИИ-модели Grok используются 100 тыс. ускорителей Nvidia H100. Позже Маск заявил, что количество ускорителей в xAI Colossus в перспективе будет увеличено втрое. Meta✴ также ранее заявила, что планирует получить до конца текущего года ИИ-ускорители, эквивалентные более чем полумиллиону H100. Таким образом, у компании Цукерберга уже имеется значительное количество оборудования для обучения своих ИИ-моделей, и будет ещё больше. Meta✴ использует уникальный подход к распространению своих моделей Llama — она предоставляет их полностью бесплатно, позволяя другим исследователям, компаниям и организациям создавать на их базе новые продукты. Это отличает её от тех же GPT-4o от OpenAI и Gemini от Google, доступных только через API. Однако Meta✴ всё же накладывает некоторые ограничения на лицензию Llama, например, на коммерческое использование. Кроме того, компания не сообщает, как именно обучаются её модели. В остальном модели Llama имеют природу «открытого исходного кода». С учётом заявленного количества используемых ускорителей для обучения ИИ-моделей возникает вопрос — сколько электричества всё это требует? Один специализированный ускоритель может съедать до 3,7 МВт·ч энергии в год. Это означает, что 100 тыс. таких ускорителей будут потреблять как минимум 370 ГВт·ч электроэнергии — как отмечается, достаточно для того, чтобы обеспечить энергией свыше 34 млн среднестатистических американских домохозяйств. Каким образом компании добывают всю эту энергию? По признанию самого Цукерберга, со временем сфера ИИ столкнётся с ограничением доступных энергетических мощностей. Компания Илона Маска, например, использует несколько огромных мобильных генераторов для питания суперкластера из 100 тыс. ускорителей, расположенных в здании площадью более 7000 м2 в Мемфисе, штат Теннесси. Та же Google может не достичь своих целевых показателей по выбросам углерода, поскольку с 2019 года увеличила выбросы парниковых газов своими дата-центрами на 48 %. На этом фоне бывший генеральный директор Google даже предложил США отказаться от поставленных климатических целей, позволив компаниям, занимающимся ИИ, работать на полную мощность, а затем использовать разработанные технологии ИИ для решения климатического кризиса. Meta✴ увильнула от ответа на вопрос о том, как компании удалось запитать такой гигантский вычислительный кластер. Необходимость в обеспечении растущего объёма используемой энергии для ИИ вынудила те же технологические гиганты Amazon, Oracle, Microsoft и Google обратиться к атомной энергетике. Одни инвестируют в разработку малых ядерных реакторов, другие подписали контракты на перезапуск старых атомных электростанций для обеспечения растущих энергетических потребностей. Робоэкскаватор обучили прицельно швырять камни

10.07.2024 [15:44],

Геннадий Детинич

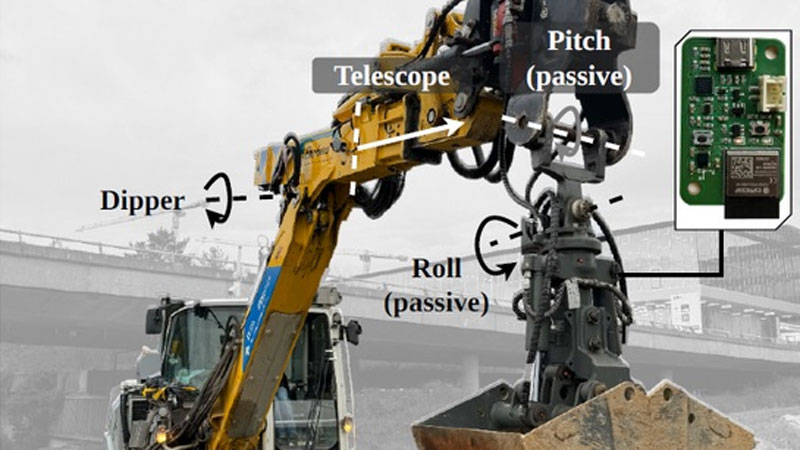

Опытным экскаваторщикам знаком трюк, который позволяет отправлять содержимое ковша за пределы досягаемости стрелы. Наделённый нейросетью робоэкскаватор оказался прилежным учеником, который также смог освоить прицельное метание камней дальше зоны досягаемости стрелы. На очереди швыряние сыпучих материалов и повышение точности для работы ковшом на разных высотах.

Источник изображения: ETH Zürich О процессе обучения нейросети робоэкскаватора для точного манипулирования содержимым ковша сообщили исследователи из Швейцарии (ETH Zürich). Нейросеть на основе обучения с подкреплением была обучена бросать мяч и камни в указанную точку, которая была дальше досягаемости стрелы (до 9,5 м при дальности захвата стрелой 7,5 м). Подобные операции помогут робототехнике справляться с большим кругом задач с меньшими затратами энергии на перемещения, а также сделают её работу более безопасной. Экскаватор совершал захват и броски ковшом с двумя степенями свободы, который не был жёстко закреплён на стреле. Броски совершались как по прямой, когда в работе была одна только стрела, так и с поворотом кабины. Во втором случае точность была чуть меньше, но в любом случае снаряд отклонялся от точки прицеливания не более чем на 30–40 см. Исследователи обучали нейросеть на базе модернизированного 12-т колёсного экскаватора Menzi Muck M545. Ранее они обучили экскаватор ряду нетривиальных операций, например, научив его строить устойчивую стену из неподготовленных каменных блоков. Экскаватор сам оценивал баланс камней и строил прочное каменное ограждение. Для точных автономных работ на местности экскаватор с помощью установленных на него датчиков строит модель окружающего пространства, в котором выполняет заданные операции. Ноутбуки на Intel Lunar Lake и AMD Strix Point на старте продаж не получат ИИ-функции Copilot Plus

07.06.2024 [22:20],

Николай Хижняк

Новые ИИ-функции Windows, включая технологию масштабирования Auto SR, не являются эксклюзивными для ПК на базе процессоров Qualcomm Snapdragon X Elite. Чипы Intel Lunar Lake и AMD Strix Point тоже оснащены производительными NPU, необходимыми для их работы. Компьютеры на этих процессорах появятся в продаже осенью и тоже получат маркировку Copilot Plus PC. Однако никто не гарантирует, что они получат поддержку ИИ-функций прямо на старте продаж, в отличие от систем на чипах Qualcomm.

Источник изображения: Microsoft Как пишет портал The Verge, поговоривший с представителями компаний Intel, AMD и Nvidia, системы на базе новых процессоров Core Ultra и Ryzen AI потребуют установку программных обновлений для Windows, которые наделят их поддержкой ИИ-функций Copilot Plus от Microsoft. Однако неизвестно, будут ли эти обновления выпущены до конца текущего года. «Системы на базе Intel Lunar Lake и AMD Strix Point соответствуют требованиям Windows 11 AI PC и нашим требованиям аппаратного обеспечения для Copilot Plus PC. Мы тесно сотрудничаем с Intel и AMD для оснащения их систем функциями Copilot Plus через бесплатные программные обновления, когда те станут доступны», — говорится в заявлении менеджера по маркетингу Microsoft Джеймса Хауэлла (James Howell) для The Verge. «Lunar Lake получат поддержку функций Copilot Plus PC через обновления, когда они станут доступным», — сообщил в ответе изданию PR-менеджер Intel Томас Ханнафорд (Thomas Hannaford). Ранее в разговоре с The Verge представители Nvidia сообщили аналогичную информацию: «Эти Windows 11 AI PC получат бесплатные обновления с функциями Copilot Plus, когда эти обновления будут готовы». Представитель AMD Мэтью Гурвиц (Matthew Hurwitz) в разговоре с журналистами не смог подтвердить, что ноутбуки на базе их процессоров получат функции Copilot Plus PC на старте продаж. «Мы ожидаем, что функции Copilot Plus появятся [в составе ноутбуков на базе наших процессоров] к концу 2024 года», — заявил Гурвиц. В Intel и Microsoft тоже не смогли уточнить, появятся ли ИИ-функции в составе ноутбуков на базе Intel до конца текущего года. Microsoft изменила Recall — функция не будет делать скриншоты без разрешения пользователя

07.06.2024 [22:05],

Николай Хижняк

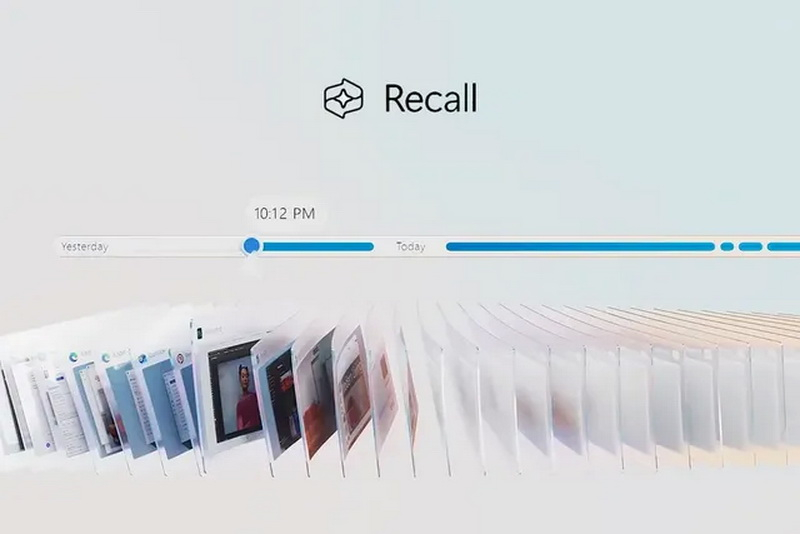

Microsoft внесла изменения в функцию записи действий Recall для Windows 11 после того, как она вызвала жаркие споры на тему конфиденциальности пользователей. Recall постоянно делает скриншоты действий пользователя на ПК, а затем позволяет в любой момент вернуться к той или иной активности. Как пишет The Verge, у Recall можно будет отключить функцию съёмки скриншотов при первоначальной настройке ОС.

Источник изображений: Microsoft Функция Recall станет доступна с поступлением в продажу ноутбуков Copilot Plus PC. Изначально Microsoft планировала активировать Recall на компьютерах по умолчанию, однако сейчас компания говорит, что предоставит пользователям возможность выбора — включить или оставить выключенной спорную ИИ-функцию. Выбор можно будет сделать во время процесса первоначальной настройки нового Copilot Plus PC. «Если не будет выбран иной вариант, то Recall будет отключена по умолчанию», — говорит глава подразделения Windows Паван Давулури (Pavan Davuluri). Перед использованием Recall компания также потребует авторизацию через Windows Hello. Таким образом, пользователю придётся предоставить изображение своего лица, отпечаток пальца или использовать PIN-код перед обращением к Recall. «Кроме того, для просмотра вашей хроники и поиска в Recall потребуется подтверждение присутствия [владельца ПК]», — говорит Давулури, отмечая, что посторонний не сможет использовать поиск в Recall без предварительной аутентификации. Эта аутентификация также будет применяться к защите скриншотов, создаваемых Recall. «Мы добавляем дополнительные уровни защиты данных, включая дешифровку по методу «точно в срок», защищенную системой безопасного входа Windows Hello Enhanced Sign-in Security (ESS). Таким образом, снимки Recall будут расшифрованы и доступны только после аутентификации пользователя», — объясняет Давулури, добавляя, что база данных поисковых индексов также будет зашифрована. Ранее сообщалось, что Recall при поддержке ИИ-алгоритмов будет делать скриншоты того, что происходит на ПК, и сохранять эту информацию локально, то есть на компьютере пользователя. Эта информация не попадёт в облако и не будет использоваться Microsoft для обучения своих ИИ-моделей. Поисковая строка Recall позволит просматривать разные временные отрезки активности в форме созданных скриншотов (открытые страницы веб-браузера, программы и т.д.). При желании пользователь сможет вернуться в ту или иную временную точку активности с помощью всего пары движений мыши.  Microsoft внесла изменения в способы хранения базы данных Recall и доступа к ней после того, как эксперт по кибербезопасности Кевин Бомонт (Kevin Beaumont) обнаружил, что функция хранит информацию в виде обычного текста, что значительно упрощало авторам вредоносных программ создание инструментов для извлечения базы данных и её содержимого. Хотя Recall пока доступна лишь в тестовых сборках Windows, некоторые умельцы уже успели воспользоваться этим недостатком и создали ряд программных инструментов, позволяющих получить доступ к хранящимся в ней данным пользователей. Например, приложение TotalRecall извлекает базу данных Recall и позволяет легко просматривать сохранённый текст и снимки экрана, созданные функцией Microsoft. А сетевой инструмент NetExec, похоже, скоро получит собственный модуль Recall, который сможет получать доступ к папкам Recall на ПК и создавать их дамп для дальнейшего просмотра созданных снимков экрана. Появление подобных инструментов стало возможным только потому, что база данных Recall не наделена системой полного шифрования. Как сообщается, Microsoft разработала Recall в рамках инициативы Secure Future Initiative (SFI), призванной повысить безопасность её программных продуктов после крупных атак на облачный сервис Azure. Портал The Verge пишет, что глава Microsoft Сатья Наделла (Satya Nadella) ставит во главу угла безопасность над всеми остальным при разработке новых программных продуктов, о чём он сообщил во внутреннем письме для сотрудников компании и призвал их последовать его примеру, даже если это будет означать отказ от каких-то новых функций. «Если вы столкнулись с выбором между безопасностью и другим приоритетом, ваш ответ ясен: занимайтесь безопасностью. В некоторых случаях это означает, что безопасность имеет более высокий приоритет над другими задачами, которыми мы занимаемся, такими как разработка новых функций или обеспечение постоянной поддержки устаревших систем», — сообщил Наделла сотрудникам Microsoft. Глава подразделения Windows Паван Давулури в своих комментариях тоже ссылается на новую инициативу SFI по повышению безопасности программных продуктов Microsoft и отмечает, что компания принимает меры по повышению защиты Recall. Однако, похоже, эти вносимые изменения во многом опираются на отзывы сторонних исследователей цифровой безопасности, а не на собственные принципы безопасности Microsoft. В противном случае спорные моменты, связанные с Recall, были бы выявлены ещё на стадии её разработки и компания приняла бы соответствующие меры для их исправления или изменения ещё до запуска этой функции. Microsoft подчеркивает, что Recall будет доступна только на новых ПК Copilot Plus PC. Эти системы разработаны с учётом повышенных требований к программной и аппаратной безопасности и оснащены криптографическим процессором Pluton, разработанным для защиты персональных данных пользователей от кражи. AMD представила мощнейший ИИ-ускоритель MI325X с 288 Гбайт HBM3e и рассказала про MI350X на архитектуре CDNA4

03.06.2024 [12:22],

Николай Хижняк

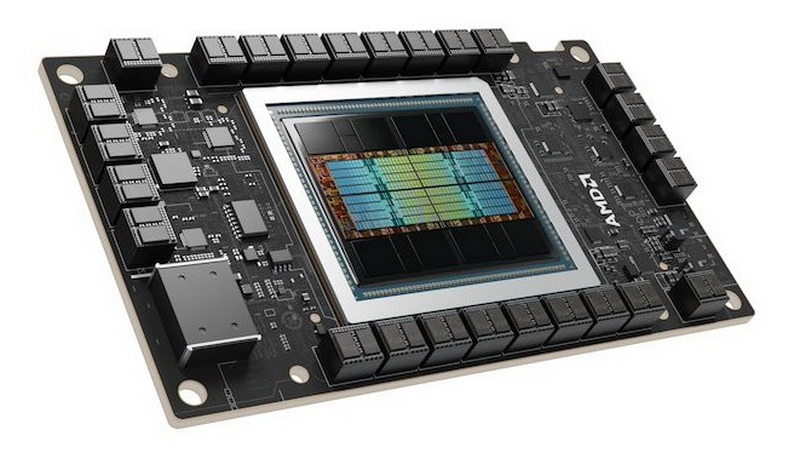

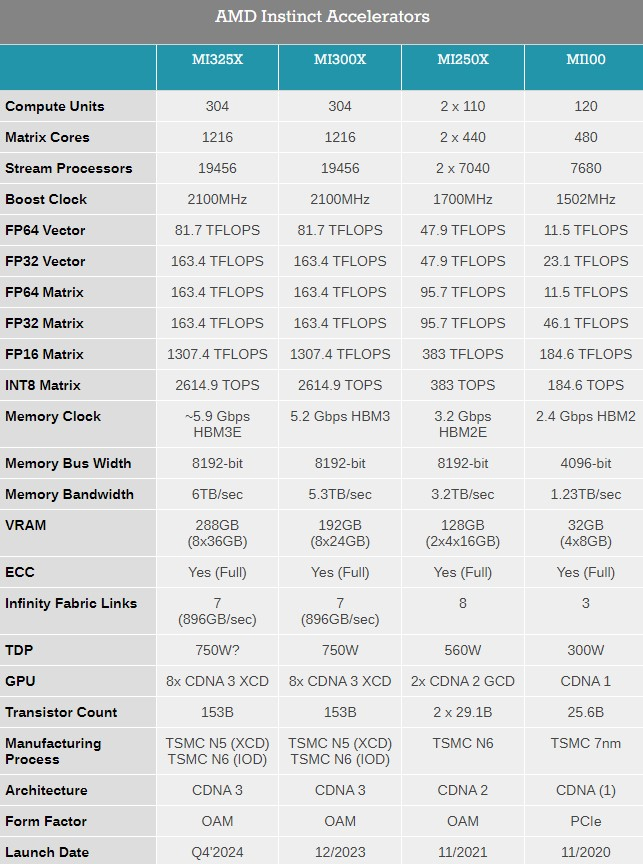

Компания AMD представила на выставке Computex 2024 обновлённые планы по выпуску ускорителей вычислений Instinct, а также анонсировала новый флагманский ИИ-ускоритель Instinct MI325X.

Источник изображений: AMD Ранее компания выпустила ускорители MI300A и MI300X с памятью HBM3, а также несколько их вариаций для определённых регионов. Новый MI325X основан на той же архитектуре CDNA 3 и использует ту же комбинацию из 5- и 6-нм чипов, но тем не менее представляет собой существенное обновление для семейства Instinct. Дело в том, что в данном ускорителе применена более производительная память HBM3e. Instinct MI325X предложит 288 Гбайт памяти, что на 96 Гбайт больше, чем у MI300X. Что ещё важнее, использование новой памяти HBM3e обеспечило повышение пропускной способности до 6,0 Тбайт/с — на 700 Гбайт/с больше, чем у MI300X с HBM3. AMD отмечает, что переход на новую память обеспечит MI325X в 1,3 раза более высокую производительность инференса (работа уже обученной нейросети) и генерации токенов по сравнению с Nvidia H200. Компания AMD также предварительно анонсировала ускоритель Instinct MI350X, который будет построен на чипе с новой архитектурой CDNA 4. Переход на эту архитектуру обещает примерно 35-кратный прирост производительности в работе обученной нейросети по сравнению с актуальной CDNA 3. Для производства ускорителей вычислений MI350X будет использоваться передовой 3-нм техпроцесс. Instinct MI350X тоже получат до 288 Гбайт памяти HBM3e. Для них также заявляется поддержка типов данных FP4/FP6, что принесёт пользу в работе с алгоритмами машинного обучения. Дополнительные детали об Instinct MI350X компания не сообщила, но отметила, что они будут выпускаться в формфакторе Open Accelerator Module (OAM).

Источник изображения: AnandTech ИИ-ускорители Instinct MI325X начнут продаваться в четвёртом квартале этого года. Выход MI350X ожидается в 2025 году. Кроме того, AMD сообщила, что ускорители вычислений серии MI400 на архитектуре CDNA-Next будут представлены в 2026 году. ChatGPT обретёт тело: OpenAI возродила разработку роботов

31.05.2024 [18:44],

Сергей Сурабекянц

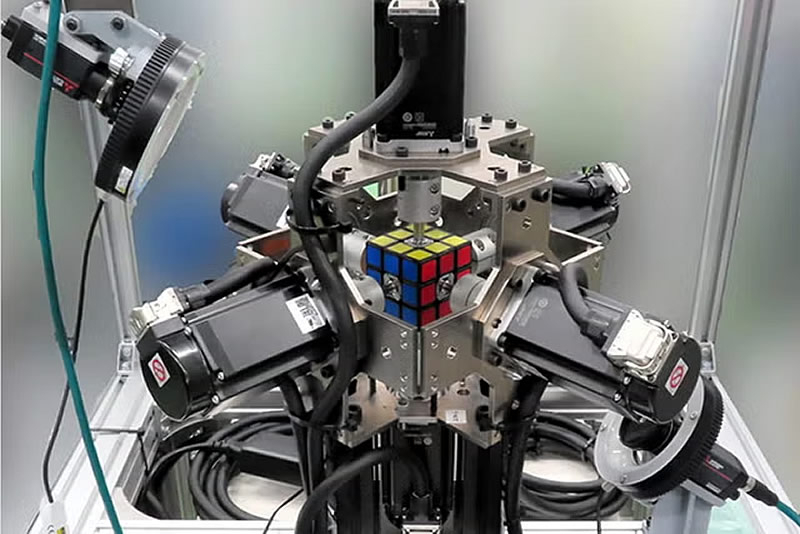

Компания OpenAI заморозила разработку собственного робота общего назначения ещё в 2020 году. Теперь гигант искусственного интеллекта собирается поставлять свои технологии машинного обучения другим разработчикам и производителям роботов. По сообщению Forbes, в связи с ростом инвестиций в роботов с ИИ компания OpenAI перезапускает свое ранее закрытое подразделение по робототехнике.

Источник изображения: unsplash.com По данным трёх независимых источников, в настоящее время OpenAI нанимает инженеров-исследователей для восстановления команды, которую она закрыла в 2020 году. Новая команда существует менее двух месяцев и в списке вакансий поясняется, что новые сотрудники станут «одними из первых её членов». За последний год OpenAI инвестировала в несколько компаний, занимающихся разработкой человекоподобных роботов, включая Fig AI (привлечено $745 млн), 1X Technologies (125 $млн) и Physical Intelligence ($70 млн). Первые намёки на возвращение интереса OpenAI к робототехнике появились в февральском пресс-релизе, посвящённом сбору средств для компании Fig. Месяц спустя компания Fig представила робота, демонстрирующего элементарные навыки речи и мышления на основе большой мультимодальной модели, обученной OpenAI.

Источник изображения: pexels.com Источники сообщают, что OpenAI намерена сосуществовать, а не конкурировать с разработчиками роботов, создавая технологии, которые производители роботов будут интегрировать в свои собственные системы. Инженеры компании будут сотрудничать с внешними партнёрами и заниматься обучением моделей ИИ. Даже такая, более узкая направленность команды робототехники OpenAI, может пересекаться с другими компаниями. Например, Covariant, основанная бывшими членами команды OpenAI по робототехнике, занимаются обучением собственных моделей, а количество талантливых специалистов весьма ограничено.

Источник изображения: pexels.com Робототехника была одним из основных направлений OpenAI с первых дней её существования. Команда специалистов под руководством соучредителя OpenAI Войцеха Зарембы (Wojciech Zaremba) стремилась создать «робота общего назначения». В 2019 году исследователи OpenAI обучили нейросеть собирать кубик Рубика с помощью роботизированной руки. Но в октябре 2020 года команда была распущена из-за «нехватки данных для обучения», по словам Зарембы.

Источник изображения: Mitsubishi В конечном итоге OpenAI направила усилия команды по робототехнике на другие проекты. «Благодаря быстрому прогрессу в области искусственного интеллекта и его возможностей мы обнаружили, что другие подходы, такие как обучение с подкреплением и обратной связью с человеком, приводят к более быстрому прогрессу», — говорится в заявлении компании. В конечном итоге, достижения в обучении с подкреплением стимулировали бум ИИ, который произошёл после выпуска компанией ChatGPT. Некоторые из бывших сотрудников OpenAI в области робототехники остаются в компании на других должностях. Например, Заремба помогает руководить разработкой флагманских моделей GPT, Питер Велиндер (Peter Welinder) руководит продуктами и партнёрскими отношениями, Боб МакГрю (Bob McGrew) является вице-президентом по исследованиям, а Лилиан Венг (Lilian Weng) возглавляет отдел систем безопасности и является членом недавно созданного комитета по безопасности OpenAI.

Источник изображения: pexels.com Пока нет точной информации, планирует ли OpenAI разрабатывать своё робототехническое оборудование, что она пыталась сделать несколько лет назад. Растущие амбиции компании в последнее время были отмечены некоторой турбулентностью, в том числе серией увольнений высокопоставленных специалистов. После публикации Forbes от 30 мая, OpenAI официально подтвердила набор специалистов в возрождённую команду по робототехнике. Google представила мощнейший серверный ИИ-процессор Trillium — почти в пять раз быстрее предшественника

14.05.2024 [22:21],

Николай Хижняк

В рамках конференции Google I/O компания Google представила шестое поколение своего фирменного тензорного процессора (Tensor Processing Unit) с кодовым названием Trillium. Он предназначен для центров обработки данных, ориентированных на работу с искусственным интеллектом. По словам компании, новый чип почти в пять раз производительнее предшественника.

Источник изображения: The Verge «Промышленный спрос на компьютеры для машинного обучения вырос в миллион раз за последние шесть лет и каждый год продолжает увеличиться в десять раз. Я думаю, что Google была создана для этого момента. Мы являемся новаторами в разработке чипов для искусственного интеллекта уже более десяти лет», — заявил генеральный директор Alphabet Сундар Пичаи (Sundar Pichai) в разговоре с журналистами. Разрабатываемые Alphabet, материнской компанией Google, специализированные чипы для центров обработки данных, ориентированных на ИИ, представляют собой одну из немногих жизнеспособных альтернатив решениям компании Nvidia. Вместе с программным обеспечением, оптимизированным для работы с тензорными процессорами Google (TPU), эти решения позволили компании занять значительную долю на рынке. По данным издания Reuters, Nvidia по-прежнему доминирует на рынке чипов для ИИ-дата-центров с долей 80 %. Значительная часть от оставшихся 20 % приходятся на различные версии TPU от Google. В отличие от Nvidia, компания Google не продаёт свои процессоры, а использует их сами и сдаёт в аренду облачные вычислительные платформы, которые на них работают. Для шестого поколения TPU под названием Trillium компания заявляет прибавку вычислительной производительности в 4,7 раза по сравнению с TPU v5e в задачах, связанных с генерацией теста и медиаконтента с помощью больших языковых моделей ИИ (LLM). При этом Trillium на 67 % энергоэффективнее, чем TPU v5e, отмечают в компании. Как пишет портал TechCrunch, значительного увеличения производительности у Trillium компания смогла добиться благодаря увеличения количества используемых матричных умножителей (MXU), а также повышения тактовой частоты чипа. Кроме того, компания удвоила для Trillium пропускную способность памяти. Более конкретных технических деталей Trillium не приводится. Вычислительные мощности нового процессора станут доступны для клиентов облачных сервисов Google к «концу 2024 года», отмечают в компании. Однако от решений Nvidia компания Google не отказывается. В рамках конференции Google I/O также было заявлено, Google станет одним из первых облачных провайдеров, который с начала будущего года будет предлагать облачные услуги на базе специализированных ИИ-ускорителей нового поколения Nvidia Blackwell. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |