|

Опрос

|

реклама

Быстрый переход

Россия заняла третье место в мире по потреблению пиратского контента

16.12.2024 [12:05],

Дмитрий Федоров

Российские видеохостинги cтолкнулись с массовым распространением пиратского контента, особенно после ухода западных правообладателей. В результате Россия заняла третье место в мире по потреблению пиратского контента, уступив только США и Индии.

Источник изображения: «VK Видео» На платформе «VK Видео» фиксируется ежемесячное удаление до 250 тыс. единиц пиратского контента, о чём сообщил технический директор бизнес-группы «Социальные платформы и медиаконтент» VK Сергей Ляджин. Ежемесячно платформа обрабатывает порядка 15 тыс. жалоб правообладателей, большинство из которых касается отечественного контента. Для автоматизации обработки обращений на «VK Видео» внедрена ИИ-система Content ID, использующая цифровые отпечатки видео- и аудиофайлов. Кроме того, правообладатели могут подавать запросы через форму DMCA. Другие крупные российские видеохостинги, такие как NUUM и RuTube, не предоставляют точных данных о количестве удалённого нелегального контента. Представители NUUM утверждают, что система обработки жалоб работает в штатном режиме, а материалы, нарушающие авторские права, удаляются в течение 24 часов. Однако, по словам участников медиарынка, именно на этих платформах наблюдается значительный рост объёма пиратских материалов после ухода из России западных правообладателей. Антипиратский меморандум, впервые подписанный 1 ноября 2018 года, был направлен на усиление борьбы с распространением нелегального видеоконтента в интернете. Документ обязывал правообладателей и интернет-платформы создавать реестры пиратских ресурсов и удалять ссылки на них из поисковой выдачи. Однако его эффективность снизилась, особенно после того как из меморандума вышли представители западных медиакомпаний, таких как Sony, Warner и Universal. В 2023 году меморандум был расширен за счёт включения книжной и музыкальной индустрий, но издательства отмечают, что результаты пока далеки от ожидаемых. Участники медиарынка полагают, что рост потребления пиратского контента в России был неизбежен после ухода западных правообладателей. Некоторые фильмы и сериалы появляются на пиратских платформах быстрее, чем на официальных площадках. При этом западные компании ограничиваются лишь уведомлением платформ о завершении сроков лицензий, что дополнительно усложняет борьбу с пиратством. По данным аналитических компаний MUSO и Kearney, Россия заняла третье место в мире по объёму трафика на пиратские ресурсы в 2023 году, уступив только США и Индии. На долю России пришлось 6 % мирового трафика на такие сайты. В целом по миру количество посещений пиратских ресурсов выросло на 10 % по сравнению с прошлым годом, что отражает глобальную тенденцию увеличения нелегального потребления контента. Проблема пиратского контента на российских видеохостингах является следствием как внешних, так и внутренних факторов. Для успешной борьбы с пиратством потребуется усиление законодательной базы, внедрение более продвинутых технологий контроля и активизация сотрудничества между платформами, правообладателями и государственными органами. Без этих шагов Россия рискует укрепить своё положение среди лидеров по нелегальному потреблению цифрового контента. «Сбер» представил собственный ИИ-генератор видео по текстовому описанию Kandinsky 4.0 Video

12.12.2024 [23:02],

Владимир Фетисов

На проходящей на этой неделе конференции AI Journey «Сбер» представил бета-версию нейросети Kandinsky 4.0 Video, которая позволяет генерировать реалистичные видео на основе текстового описания или стартового кадра. Алгоритм может быть полезен не только обычным пользователям, но также дизайнерам, маркетологам и мультипликаторам, так как с его помощью можно создавать различные видео: от анимированных роликов с поздравлениями для близких до трейлеров и клипов.

Источник изображения: fusionbrain.ai В компании отметили, что с момента релиза первой версии Kandinsky Video в прошлом году разработчики значительно улучшили многие характеристики алгоритма, включая качество создаваемых роликов и скорость генерации. Обновлённая нейросеть способна создавать ролики продолжительностью до 12 секунд с разрешением 1280 × 720 пикселей на основе текстового описания или изображения. Также поддерживается создание роликов с различным соотношением сторон. Улучшилось визуальное качество: повысились контрастность и чёткость кадров, композиция стала более выверенной, а движения объектов в кадре — реалистичными. В дополнение к этому разработчики анонсировали ускоренную версию нейросети — Kandinsky 4.0 Video Flash, которая способна генерировать ролики продолжительностью до 12 секунд с разрешением 720 × 480 пикселей всего за 15 секунд. На начальном этапе доступ к новой версии Kandinsky Video получат представители креативных индустрий, включая художников, дизайнеров и кинематографистов через портал fusionbrain.ai. Для обычных пользователей алгоритм станет доступен в первом квартале следующего года. Четверть россиян ускоряет замедленный YouTube, а треть переключилась на «VK Видео» и Rutube

11.12.2024 [13:04],

Дмитрий Федоров

После замедления работы YouTube 24 % россиян начали использовать специальные инструменты для ускорения платформы. Одновременно 33 % пользователей перешли на отечественные видеохостинги, включая «VK Видео» (12 %) и Rutube (11 %). В то же время 13 % россиян полностью отказались от просмотра онлайн-видео. Об этом свидетельствуют результаты исследования, проведённого компанией edna.

Источник изображения: Eyestetix Studio / Unsplash Проведённые опросы показали, что 20 % россиян принципиально не пользуются отечественными видеохостингами. Основными причинами отказа названы нехватка разнообразия контента (24 %), отсутствие любимых блогеров (16 %) и зарубежного видео (10 %). Также респонденты отметили неудобный интерфейс (8 %) и слабую функциональность поиска (5 %). Несмотря на сложности с доступом к YouTube, 19 % пользователей заявили, что будут продолжать смотреть YouTube до тех пор, пока он остаётся доступным. В то же время 13 % респондентов полностью отказались от онлайн-видео, а 12 % вообще не заметили изменений в работе платформы. По данным исследования, трафик YouTube в России с августа сократился на 30 % и с тех пор стабилизировался на этом уровне. В попытке привлечь аудиторию, покинувшую YouTube, российские видеохостинги активно внедряют новые функции. В августе Rutube предложил инструмент переноса контента из YouTube, а в сентябре VK интегрировала видеокодек AV1, позволяющий смотреть видео высокого качества даже при низкой скорости интернета. В октябре VK запустила грантовую программу с бюджетом 100 млн рублей, направленную на поддержку блогеров и развитие оригинального контента. Устойчивый рост интернет-трафика в России указывает на то, что пользователи постепенно адаптируются к новым условиям, однако долгосрочные перспективы российских видеохостингов остаются неопределёнными. OpenAI запустила ИИ-генератор видео по текстовым запросам Sora — он косячит так же, как и другие

10.12.2024 [01:30],

Андрей Созинов

Компания OpenAI в понедельник запустила Sora — свою революционную модель искусственного интеллекта для генерации видео по текстовым описаниям. С сегодняшнего дня новая модель стала доступна на сайте Sora.com для платных пользователей ChatGPT в США и «большинстве других стран». России в списке нет, как и стран ЕС. Представленная сегодня версия под названием Sora Turbo может генерировать ролики длиной от 5 до 20 секунд в различных соотношениях сторон и разрешениях от 480p до 1080p. Каждая генерация обойдётся пользователю в определённое количество так называемых «кредитов». Например, видео в 480p стоит от 20 до 150 кредитов, ролик в 720p — от 30 до 540 кредитов, а видео в 1080p — от 100 до 2000 кредитов. Что именно влияет на цену, пока не уточняется. OpenAI сообщила, что подписчики базового тарифного плана ChatGPT Plus ($20 в месяц) получат 1000 кредитов в месяц. Это позволит сгенерировать до 50 «приоритетных видео» (то есть видео, которые генерируются быстро) в формате 720p и длительностью 5 секунд. В свою очередь, пользователи нового тарифа ChatGPT Pro за $200 в месяц получат 10 000 кредитов, которые смогут потратить на 500 приоритетных видео в формате 1080p и длительностью 20 секунд. Кроме того, более обеспеченные пользователи получат неограниченное количество низкоприоритетных генераций видео. Также пользователи с подпиской Pro смогут выполнять до пяти генераций одновременно и скачивать ролики без водяных знаков. OpenAI отмечает, что видео, созданные с помощью Sora, по умолчанию будут иметь видимые водяные знаки и метаданные C2PA, указывающие на их создание с помощью ИИ. Sora может создавать несколько вариантов видеоклипов на основе текстовой подсказки или изображения, а также редактировать существующие видео с помощью инструмента Re-mix. Интерфейс Storyboard позволяет пользователям создавать видео на основе последовательности подсказок, инструмент Blend объединяет два видео, сохраняя элементы обоих, а опции Loop и Re-cut дают возможность авторам дополнительно настраивать и редактировать свои видео и сцены. По словам видеоблогера Маркуса Браунли (Marcus Brownlee), известного как MKBHD, который получил доступ к предварительной версии Sora, система работает далеко не идеально. На создание среднего видеоролика в формате 1080p у него уходило «пара минут». Эта модель страдает от тех же недостатков, что и другие генераторы видео: ей не хватает постоянства объектов. В видеороликах Sora объекты перемещаются нелогично, исчезают и появляются вновь без видимой причины. Ноги — ещё один серьёзный источник проблем, отмечает Браунли. Если человек или животное с ногами долго ходит в ролике, Sora путает передние и задние ноги, а сами ноги могут «меняться местами». Также сообщается, что в Sora встроен ряд защитных механизмов, запрещающих генерировать видео с изображением людей младше 18 лет, содержащие насилие, «откровенные темы» или нарушающие авторские права третьих лиц. По словам Браунли, Sora также не создаёт видео на основе изображений с общественными деятелями, узнаваемыми персонажами или логотипами. Компания предупреждает, что «неправомерное использование загружаемых медиафайлов» может привести к запрету или приостановке работы аккаунта. По мнению блогера, новинка может быть полезна для генерации таких вещей, как заставки в определенном стиле, анимации, абстракции и стоп-кадры. Но он не стал бы рекомендовать её для создания фотореалистичных роликов. OpenAI подчёркивает, что это «ранняя версия Sora», в которой «будут ошибки». «Она не идеальна, но уже на том этапе, когда мы думаем, что она будет действительно полезна для дополнения человеческого творчества, — заявил Уилл Пиблз (Will Peebles), член технического персонала OpenAI и руководитель исследования Sora. — Мы не можем дождаться, когда увидим, что мир создаст с помощью Sora». Если у вас нет подписки на ChatGPT, вы всё равно сможете просматривать ленту видеороликов, созданных искусственным интеллектом другими пользователями с помощью Sora. В то время как модель станет доступна в США и многих других странах уже сегодня, генеральный директор OpenAI Сэм Альтман (Sam Altman) отметил, что запуск в «большинстве стран Европы и Великобритании» может «занять некоторое время». «VK Видео» снял сливки с замедления YouTube — установки приложений сервиса достигли 44 млн

09.12.2024 [13:41],

Владимир Мироненко

Количество установок приложения «VK Видео» на устройства Android, iOS и Android TV со дня запуска в сентябре 2023 года превысило 44 млн. Суточный рекорд просмотров отечественного конкурента платформы YouTube составил 2,9 млрд, пишет ТАСС со ссылкой на отчёт «VK Видео» об итогах года.

Источник изображения: VK По данным Mediascope, в 2024 году активная месячная аудитория сервиса увеличилась до 72,2 млн. При этом число создателей оригинального контента выросло на 52 %, а подписки на их страницы — в 3,5 раза. Доля просмотров «VK Видео» на устройствах Smart TV составляет более 30 % от всех просмотров на платформе. Наибольшей популярностью среди авторов в видеосервисе пользуется ведущий, юморист и актер Азамат Мусагалиев, на 2-м месте находится Влад А4. В тройку также вошёл Антон Шастун. Больше всего обсуждались пользователями шоу «Натальная карта», сообщество о китайской гимнастике, а также проекты «Импрокома» и видеоролики тренера Олега Попова. В 2024 году наибольшее количество просмотров было у первых эпизодов сериалов «Подростки в космосе» (25 млн просмотров). Далее по популярности следуют «Амура» (13,9 млн), «Ректор» (11,9 млн), «Цербер» (11,7 млн) и «По зову сердца» (11,3 млн). Наибольшей популярностью в категории мультфильмов пользовались «Добрая пчела. Песенка про козу дерезу!» (1,46 млн просмотров), «Лунтик и его друзья» (1,45 млн), «Барбоскины. Пчелка» (1,39 млн), «Синий Трактор. Совушка колыбельная» (1,34 млн) и «Доктор Машинкова. Важный светофор» (1,31 млн). Китайская Tencent представила генератор видео HunyuanVideo, который пользователи назвали лучшим из существующих

05.12.2024 [10:57],

Павел Котов

Китайский технологический гигант Tencent анонсировал HunyuanVideo — передовую модель искусственного интеллекта для генерации видео, опубликованную с открытым исходным кодом. Впервые код вывода и веса модели ИИ с такими возможностями доступны всем желающим.

Источник изображения: Tencent HunyuanVideo, как утверждает Tencent, способна генерировать видеоролики на уровне ведущих мировых систем с закрытым исходным кодом — эти видео отличают высокое качество картинки, разнообразие движений объектов в кадре, способность синхронизировать визуальный и звуковой ряд, а также стабильность генерации. Это крупнейшая модель для генерации видео — у неё 13 млрд параметров. Пакет HunyuanVideo включает в себя фреймворк с инструментами для управления данными; инструментами для совместного обучения моделей, работающих с изображениями и видео; а также инфраструктуру с поддержкой крупномасштабного обучения моделей и их запуска. Tencent протестировала модель при поддержке профессионального сообщества, которое установило, что HunyuanVideo превосходит по качеству закрытые проекты Runway Gen-3 и Luma 1.6. Чтобы добиться такого результата, разработчик обратился к гибридной архитектуре передачи «двойного потока в одинарный» (Dual-stream to Single-stream). На начальном этапе видео- и текстовые токены обрабатываются независимо несколькими блоками модели-трансформера, благодаря чему данные разных форматов преобразуются без помех. На этапе единого потока видео- и текстовые токены передаются в последующие блоки трансформера, обеспечивая эффективное слияние мультимодальных данных. Это позволяет зафиксировать сложные отношения между визуальной и семантической информацией, а общая производительность модели повышается. Выпустив HunyuanVideo, компания Tencent сделала значительный шаг к демократизации технологий создания видео при помощи ИИ. Благодаря открытому исходному коду модель способна произвести революцию в экосистеме генерации видео. «VK Видео» переехал на отдельный домен и обзавёлся новыми функциями

04.12.2024 [13:38],

Павел Котов

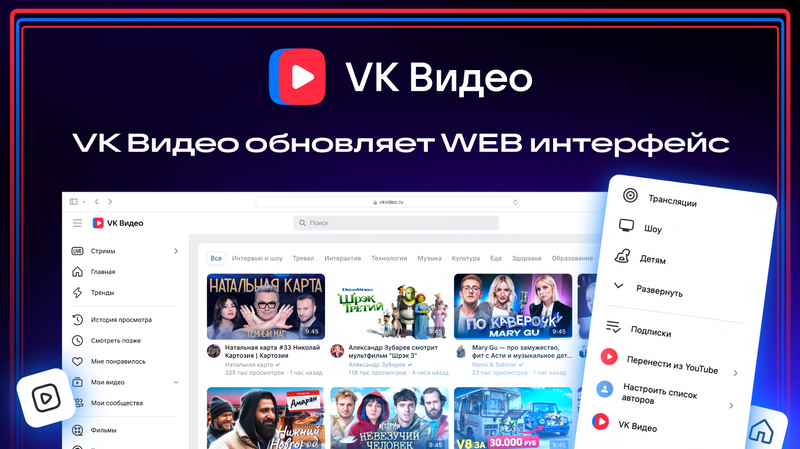

Веб-версию «VK Видео» перенесли на отдельный домен vkvideo.ru — теперь его можно указывать в адресной строке браузера, чтобы оперативно находить представленные на платформе материалы: фильмы, трансляции, шоу и записанные блогерами ролики.

Источник изображения: VK На «VK Видео» появились новые функции, обновилась навигация по сайту. Есть возможность, в частности, переносить с других платформ подписки на любимых авторов, чтобы отслеживать появление новинок. Быстрый доступ к списку авторов появился в разделе «Подписки», а в общей ленте теперь можно скрывать материалы, которые не представляют для пользователя интереса. Удобство навигации обеспечат появившиеся на главной странице разделы «Продолжить просмотр», «Подписки», «Фильмы», «Сериалы», «Телеканалы» и «Шоу». «Отдельный домен "VK Видео" позволит быстрее внедрять технологии и инструменты для авторов и откроет новые возможности для монетизации: например, более гибкие модели размещения рекламы или премиум-функции для видеоблогеров. Пользователи, в свою очередь, получат не только много качественного видеоконтента, но и привычный для них формат его потребления», — рассказал вице-президент по музыкальным и видеосервисам компании VK Николай Дуксин. Платформа «VK Видео» стала активно набирать популярность с замедлением YouTube — уже в начале августа её приложение стало самым скачиваемым в России. VK расширила сеть доставки контента и перенесла в единое облачное хранилище видео со всех своих сервисов, улучшила видеоредактор и добавила возможность создавать интерактивные ролики. В ходе последнего квартального отчёта компания подробно рассказала об успехах платформы. Нашумевший ИИ-генератор видео Sora без разрешения OpenAI приоткрыли для всех желающих

26.11.2024 [22:36],

Владимир Мироненко

Группа создателей видеоконтента, привлечённых OpenAI к участию разработке ИИ-генератора видео Sora, похоже, открыли доступ к ней для всех желающих, сообщил TechCrunch. Во вторник группа опубликовала на платформе разработки ИИ Hugging Face интерфейс, связанный с API Sora OpenAI, с помощью которого пользователи могут генерировать 10-секундные видео с разрешением до 1080p.

Источник изображения: Levart_Photographer/unsplash.com Свой поступок художники объяснили протестом против «отмывки искусства». По их словам, OpenAI оказывает давление на ранних тестировщиков Sora, включая участников Red Team и творческих партнёров, чтобы те создавали позитивную историю вокруг Sora и не выплачивает им справедливую компенсацию за их работу. «Эта программа раннего доступа, похоже, меньше связана с творческим самовыражением и критикой, а больше с PR и рекламой», — указали они в сообщении, прикрепленном к интерфейсу. «Мы не против использования технологии ИИ в качестве инструмента для искусства (если бы мы были против, нас, вероятно, не пригласили бы в эту программу), — написали создатели видеоконтента. — Мы не согласны с тем, как была развёрнута эта программа для художников и как инструмент формируется перед возможным публичным выпуском». По другой версии, о которой сообщил ресурс BGR, пользователь X @legit_rumors рассказал, что ресурс HuggingFace нашел доступ к OpenAI Sora через каналы Discord и поделился некоторыми примерами использования этого инструмента для создания видео с использованием ИИ в Сети. Как бы то ни было, OpenAI вскоре закрыла возможность использовать Sora всем желающим. Некоторым пользователям соцсети X удалось с помощью интерфейса загрузить образцы видеороликов, созданных Sora. Напомним, что во время анонса Sora компания OpenAI сообщила, что это «модель ИИ, которая может создавать реалистичные и образные сцены согласно текстовым инструкциям. Sora может создавать видео длительностью до минуты, сохраняя визуальное качество и следуя указаниям пользователя». В настоящее время доступ к платформе имеют лишь небольшое число визуальных художников, дизайнеров и режиссеров, и сотрудничество с ними позволяет компании «получать обратную связь о том, как усовершенствовать модель, чтобы она была максимально полезной для творческих профессионалов». YouTube добавил в Shorts функцию Dream Screen — ИИ-генератор фонов для роликов

22.11.2024 [16:25],

Павел Котов

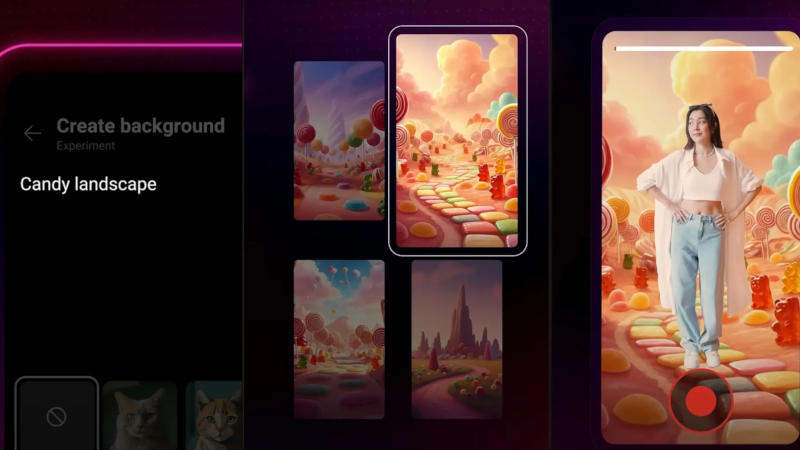

Администрация YouTube объявила, что в разделе коротких вертикальных роликов Shorts теперь доступна обновлённая функция Dream Screen — генерация динамических фоновых изображений с использованием искусственного интеллекта. Ранее функция Dream Screen позволяла генерировать в качестве фонов не видео, а неподвижные картинки.

Источник изображения: YouTube Новая возможность появилась благодаря интеграции модели для генерации видео Google DeepMind Veo — она позволяет создавать ролики с разрешением 1080p в разных кинематографических стилях. Чтобы запустить новую функцию, необходимо перейти в камеру Shorts, выбрать значок «Зелёный экран» и опцию Dream Screen — здесь можно ввести текстовый запрос, например, «пейзаж из конфет» или «волшебный лес и ручей»; после чего останется выбрать стиль анимации и нажать кнопку «Создать». Dream Screen создаст несколько видеофонов, из которых нужно выбрать один, после чего можно записывать видео с этим изображением позади себя. Новая функция пригодится, например, чтобы погрузить зрителя в атмосферу любимой книги или подготовить анимированное вступление к основному ролику. В перспективе YouTube планирует предоставить авторам возможность создавать 6-секундные видеоролики, полностью сгенерированные Dream Screen. Крупнейшая в мире платформа коротких видео TikTok также поддерживает создание фоновых изображений с помощью ИИ, но эти картинки пока статические. Воспользоваться обновлённым вариантом Dream Screen могут пользователи YouTube из США, Канады, Австралии и Новой Зеландии. VK похвасталась успехами «VK Видео» на фоне замедления YouTube

21.11.2024 [15:39],

Павел Котов

Одним из важнейших направлений работы VK в III квартале 2024 года стало развитие платформы «VK Видео», сообщили в компании — это коснулось продуктового развития сервиса, внедрения новых технологий, повышения вовлечённости зрителей, создания эксклюзивных материалов, а также сотрудничества с блогерами. Развитие сервиса происходит на фоне замедления работы YouTube в России.

Источник изображения: VK В «VK Видео» запущена программа монетизации для авторов — они получают от 50 % до 80 % доходов от рекламы в их роликах; появились инструменты для связывания коротких вертикальных роликов с длинными и наоборот. С начала года на платформу пришли 14 тыс. новых авторов — каждый второй использовал средства переноса материалов с других платформ или создания канала с нуля. За квартал на «VK Видео» вышли более 3 тыс. единиц эксклюзивного контента; платформа первой в России запустила интерактивные видео; активно привлекались популярные авторы, транслировались спортивные мероприятия. Вышли версии приложения, предназначенные для iPad и планшетов под Android. Проведён редизайн «VK Видео», дебютировали новые функции: обновился раздел подписок, появились отложенный просмотр и управление уведомлениями. В единое облачное хранилище перенесены материалы «VK Видео», «Дзена» и «ОК.Видео» — их суммарный объём достиг 1,5 Эбайт (1,5 млрд Гбайт). Расширена сеть CDN: все федеральные округа России и страны СНГ охватывают 150 CDN-узлов с кеширующими серверами. Реализована поддержка кодека AV1; развёрнуты алгоритмы искусственного интеллекта для распознавания речи и генерации субтитров. По итогам III квартала «VK Видео» стала второй по популярности видеоплатформой в России — ежедневно сюда заходили 59 % пользователей Рунета; для просмотра видео со смартфона россияне чаще всего открывают «VK Видео». Среднесуточное число просмотров по сравнению с аналогичным периодом прошлого года выросло на 48,5 % и достигло 2,6 млрд; приложения платформы для мобильных устройств и Android TV с момента запуска в сентябре 2023 года установлены более 30 млн раз. Совокупное время просмотра материалов на «VK Видео» за год увеличилось на 265 %; больше всего видео с платформы смотрят владельцы умных телевизоров — в среднем 205 минут в день. ИИ-функция Google Vids для генерации видео стала доступна пользователям Workspace

08.11.2024 [19:47],

Владимир Фетисов

В апреле этого года Google представила инструмент Vids, который построен на базе искусственного интеллекта, предназначен для генерации или редактирования видео, а также позиционируется как средство для совместной работы. Он позволит пользователям создавать ролики профессионального уровня без необходимости учиться работе с ПО для редактирования и обработки видео. Теперь же этот инструмент становится доступен пользователям платформы Google Workspace.

Источник изображения: Google В новом сообщении разработчиков в блоге Workspace подчёркивается, что Vids будет полезен для команд, занимающихся обучением клиентов, развитием разных проектов, маркетингом, хотя по сути данный инструмент может пригодиться кому-угодно для реализации творческих идей. Основой Vids стала нейросеть Gemini, которая позволяет быстро генерировать видео, которые могут потребоваться бизнес-клиентам компании. К примеру, одна из функций позволяет сгенерировать раскадровку на основе текстового запроса и документа из Google Диска. В раскадровке излагаются подтемы, которые будут рассмотрены в будущем видео, а пользователь может менять их очередность, удалять какие-то пункты и добавлять новые. После выбора стиля алгоритм объединит черновик видео с созданным сценарием, включая выбранные медиафайлы, текст, сценарии для каждой сцены и даже фоновую музыку. Пользователи также получат доступ к готовым шаблонам, которые можно быстро адаптировать под свои задачи. При необходимости к видео можно добавить закадровый голос, генерируемый ИИ-алгоритмом. Отметим, что входящие в состав Vids функции на основе ИИ, такие как «Помоги мне создать», «Удалить фон изображения», «Создать закадровый голос», будут доступны бесплатно до конца 2025 года. В сообщении разработчиков сказано, что ограничения на использование ИИ-функций в Vids могут быть введены, начиная с 2026 года. Google начала тестировать Vids с привлечением ограниченного числа пользователей летом этого года. Теперь же этот инструмент становится доступным бизнес-клиентам платформы Workspace. Отмечается, что для оптимальной работы в Vids лучше использовать последние версии браузеров Chrome, Firefox и Edge для Windows. Другие браузеры также поддерживаются, но некоторые функции могут работать в них некорректно. «Яндекс», подвинься: VK начнёт предустанавливать свои сервисы на автомобили в России

05.11.2024 [18:40],

Сергей Сурабекянц

Пресс-служба VK сообщила о ведущихся переговорах с десятью крупными автопроизводителями о предустановке медиасервисов компании, в том числе «VK Видео», в мультимедийные системы продаваемых в России автомобилей. На сегодняшний день этот рынок полностью контролируется «Яндексом». Тем не менее, в VK планируют к концу 2025 года внедрить свои сервисы в каждый десятый китайский автомобиль, продающийся через официальных дилеров.

Источник изображения: VK VK не рассматривает создание собственной мультимедийной платформы в среднесрочной перспективе — на данном этапе автопроизводителям будут предлагаться только отдельные сервисы, в первую очередь «VK Видео», «VK Музыка» и «VK Mecceнджер». По словам эксперта компании «Эйлер Аналитические технологии» Владимира Беспалова, дисплей в автомобиле «становится пятым экраном после киноэкрана, телевизора, компьютера и телефона», поэтому уже сейчас интеграция видеосервисов является важной инвестицией в будущее. «К тому моменту, когда беспилотное вождение будет реализовано, сервисы-первопроходцы уже займут нишу», — уверен он. Единая платформа «Яндекс Авто» была представлена ещё в 2017 году. С августа 2024 года в качестве альтернативы предложен набор отдельных сервисов (Yandex Automotive Services, YAS), которыми автопроизводители могут дополнять собственные системы. По словам представителя «Яндекса», это связано с дрейфом российского автомобильного рынка в сторону китайских автопроизводителей, которые не хотят полностью заменять свои мультимедийные интерфейсы, стремясь сохранить идентичность бренда. «Открытая мобильная платформа», дочерняя компания «Ростелекома», также в настоящее время разрабатывает свою автомобильную мультимедийную оболочку на базе ОС «Аврора». Её планируется использовать в автомобилях АвтоВАЗа. Instagram✴ стал понижать качество видео для непопулярных роликов

28.10.2024 [04:39],

Анжелла Марина

Instagram✴ вводит новую политику в отношении воспроизведения видео. Глава Instagram✴ и Threads Адам Моссери (Adam Mosseri) заявил, что более популярные видео будут отображаться в высоком качестве, а ролики, набравшие небольшое количество просмотров — в более низком.

Источник изображения: Brett Jordan/Unsplash Моссери объяснил, что Instagram✴ старается показывать видео в самом высоком качестве, какое только возможно. Но если ролик не получает достаточного количества просмотров в начале, качество его воспроизведения может быть снижено. Он отметил, что большинство просмотров происходит в первые часы после публикации, и если алгоритм фиксирует, что видео не привлекает внимания, платформа начинает использовать менее ресурсоёмкую кодировку, сообщает TechCrunch. Вообще идея не является новой — ещё в прошлом году компания Meta✴ сообщала о том, что применяет разные настройки кодирования CPU в зависимости от популярности контента. Однако после того, как один из пользователей поделился видео Моссери в Threads, в котором он рассказывает о политике занижения качества роликов, эта тема вызвала оживлённую дискуссию. Некоторые раскритиковали подход компании, назвав его «безумием». Решение о снижении качества принимается на агрегированном уровне, а не индивидуально для каждого пользователя, уточняет Моссери. То есть, качество видео не зависит от того, как конкретный человек взаимодействует с ним. «Мы отдаём предпочтение более качественной кодировке для авторов, чьи видео набирают больше просмотров», — объясняет он, при этом подчёркивая, что будет применяться гибкий подход, а не жёсткие ограничения. Некоторые пользователи выразили обеспокоенность тем, что такая система может усилить разрыв между популярными и менее известными авторами. Популярные создатели контента получают возможность публиковать видео в наилучшем качестве, что способствует их дальнейшему росту, тогда как начинающие блогеры могут оставаться в тени. Однако Моссери заверил, что разница в качестве незначительна и на решение пользователей о взаимодействии с тем или иным видео больше влияет его содержание, нежели технические параметры. Zotac опровергла информацию о начале производства видеокарты GeForce RTX 5090

21.10.2024 [22:48],

Николай Хижняк

Компания Zotac опубликовала официальное опровержение появившихся в Сети слухов о начале сборки и тестирования видеокарт GeForce RTX 5090. Ранее профильные СМИ, в том числе и наш сайт, со ссылкой на опубликованное в китайской социальной сети Bilibili видео заявили, что Zotac произвела и приступила к тестированию первой видеокарты GeForce RTX 5090 из ожидаемой серии GeForce RTX 5000 от Nvidia.

Zotac Gaming GeForce RTX 4070 Ti Super Solid В официальном заявлении компании Zotac по этому поводу сообщается следующее: «За последние два дня мы заметили неточные предположения, циркулирующие относительно слухов о новой видеокарте, предположительно производимой Zotac. Мы хотели бы воспользоваться возможностью и предоставить разъяснение. Продукт, продемонстрированный в соответствующем видеоисточнике, на самом деле является существующим продуктом, в настоящее время находящимся в производстве, Он известен как Zotac Gaming GeForce RTX 4070 Ti Super Solid. Видео, которое стало вирусным в интернете, представляет собой запись процесса внутреннего обучения во время пробного производственного запуска на нашем предприятии в Индонезии, целью которого было проверить работоспособность недавно установленного производственного оборудования». Добавим, что для начала тестирования видеокарт нового поколения ещё слишком рано — по слухам, видеокарты представят только в январе. Россияне вернулись к просмотру длинных видео на YouTube — охват восстановился до уровня 2023 года

21.10.2024 [20:23],

Дмитрий Федоров

Аналитики WhoIsBlogger зафиксировали восстановление интереса к длинным видеороликам на YouTube в России, несмотря на замедление работы платформы. Охват таких видео практически вернулся к уровню 2023 года.

Источник изображения: Artapixel / Pixabay В рамках исследования, проведённого платформой для аналитики инфлюенс-маркетинга WhoIsBlogger, были проанализированы данные 48 000 YouTube-каналов. Результаты показали, что в период с 30 сентября по 6 октября 2024 года охват длинных видеороликов снизился всего на 0,8 % по сравнению с аналогичным периодом прошлого года. Однако стоит отметить, что с 18 по 24 августа 2024 года было зафиксировано значительное падение охватов длинных видео на 28 % в годовом выражении, что, вероятно, было связано с техническими ограничениями в работе видеохостинга в России. Тем не менее уже через несколько недель аудитория вновь начала возвращаться, что привело к восстановлению показателей. Интересно, что на фоне роста охватов длинных видеороликов короткие видео категории Shorts продолжают терять популярность среди россиян. 8 октября Всероссийский центр изучения общественного мнения (ВЦИОМ) представил данные, согласно которым платформа VK Видео обогнала YouTube по числу просмотров на смартфонах. По результатам исследования, наибольшую популярность у российских пользователей получили фильмы и сериалы — 56 %, за ними следуют новости — 53 %, а также юмористический и развлекательный контент — 51 %. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |