|

Опрос

|

реклама

Быстрый переход

Размышляющий ИИ стал доступен в бесплатном ChatGPT — OpenAI выпустила мощнейшую модель o3-mini

31.01.2025 [22:52],

Андрей Созинов

Генеральный директор OpenAI Сэм Альтман (Sam Altman) ровно две недели назад пообещал, что большая языковая модель нового поколения o3-mini со способностью к рассуждению будет выпущена «через пару недель». И ведь не обманул — сегодня OpenAI запустила o3-mini в ChatGPT, а также в API-сервисах. Самое интересное в том, что новая ИИ-модель стала доступна даже бесплатным пользователям ChatGPT, пусть и с ограничениями.

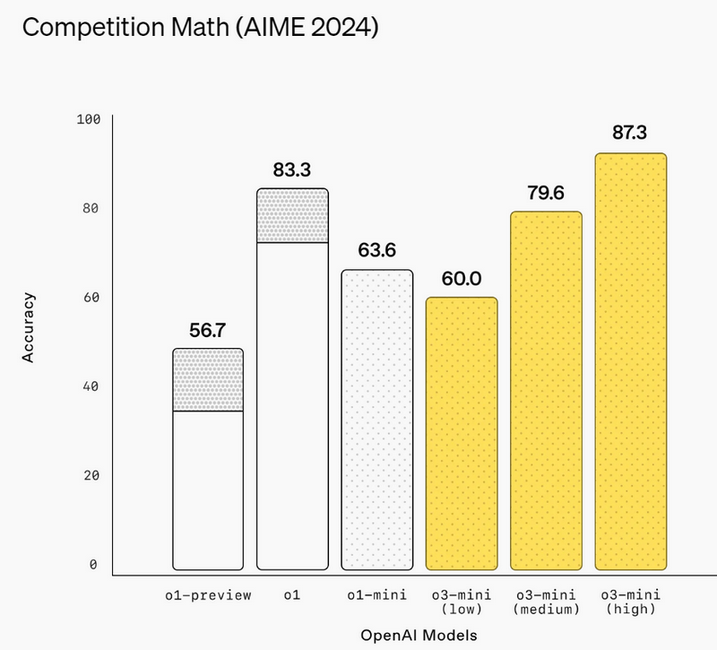

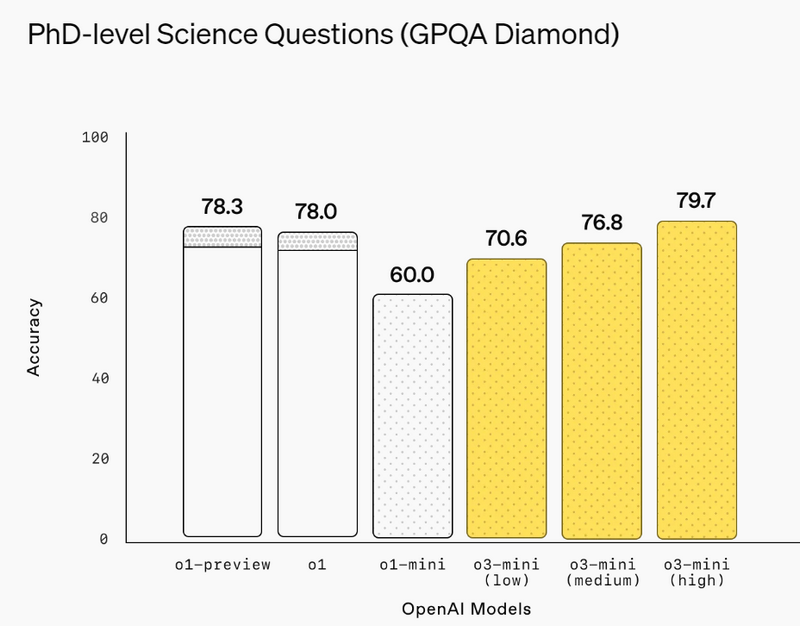

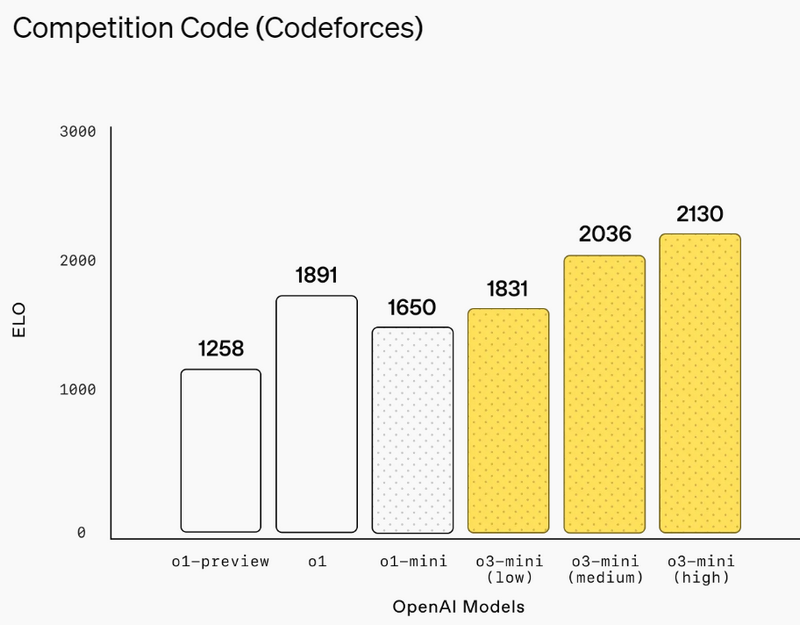

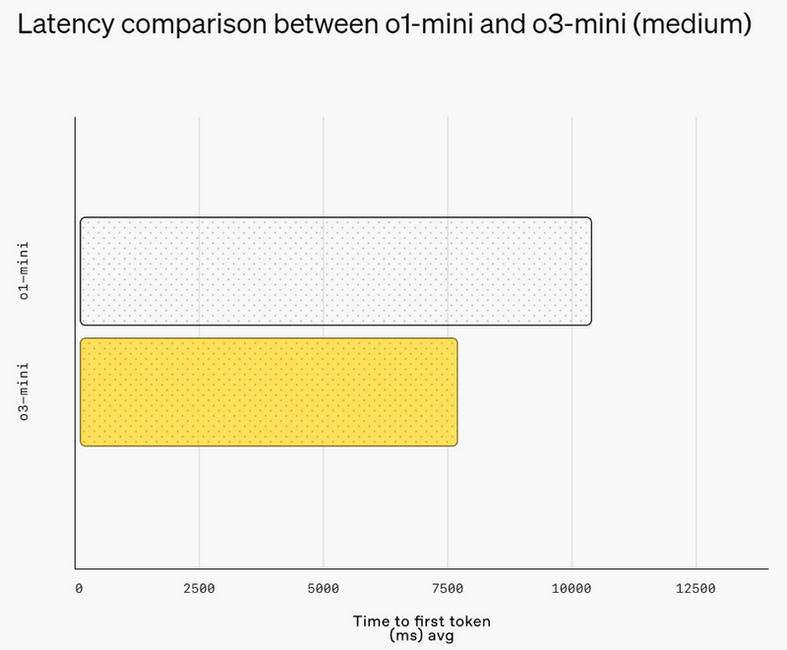

Источник изображений: OpenAI Первоначально анонсированная в рамках 12-дневного предрождественского марафона премьер OpenAI, модель o3-mini призвана сравниться с o1 по производительности в задачах, связанных с математикой, написанием программного кода и научными дисциплинами, при этом отвечая быстрее. OpenAI утверждает, что o3-mini работает на 24 % быстрее, чем o1-mini, и при этом даёт более точные ответы. Как и o1-mini, новая модель будет демонстрировать ход своих размышлений при решении задачи, а не просто предоставлять готовый ответ.  В декабре OpenAI представила несколько ранних тестов, демонстрирующих превосходство o3 над o1. Теперь разработчики утверждают, что версия o3-mini превзойдёт o1 в ряде задач, связанных с кодированием и рассуждениями, при меньших затратах и задержках. Разработчики смогут использовать o3-mini через API-сервисы OpenAI, включая Chat Completions API, Assistants API и Batch API.  Платным пользователям также будет доступна модель o3-mini-high, которая, по словам OpenAI, станет «лучшим вариантом для написания программного кода в ChatGPT» и предложит ответы с более высоким уровнем интеллекта, пусть и с небольшой задержкой. Кроме того, o3-mini будет поддерживать поиск в интернете, позволяя находить ответы со ссылками на веб-источники.  Это также первый случай, когда бесплатные пользователи ChatGPT смогут опробовать модели OpenAI со способностью к рассуждениям. Вероятно, за это стоит благодарить китайский стартап DeepSeek, который всколыхнул мир ИИ. Хотя нельзя исключать и влияние Microsoft, которая ранее открыла доступ к o1 для всех пользователей Copilot.  Пользователи смогут бесплатно протестировать o3-mini в ChatGPT, выбрав функцию Reason на панели чата. Ограничения будут такими же, как для GPT-4o. У платных пользователей лимиты окажутся выше: подписчики тарифов ChatGPT Plus и Teams смогут отправлять до 150 сообщений в день. А пользователи тарифа ChatGPT Pro за $200 в месяц получат неограниченный доступ к o3-mini. Бесплатный ChatGPT стал «умнее по всем параметрам» — OpenAI обновила модель GPT-4o

31.01.2025 [01:29],

Николай Хижняк

Компания OpenAI анонсировала обновление для своей ИИ-модели GPT-4o, которая является основой для чат-бота ChatGPT, в том числе его бесплатной версии. Обновление сделало нейросеть «умнее по всем параметрам», а также «наделило более актуальной информацией», а также научило «более глубокому пониманию и анализу загружаемых [пользователями] изображений».

Источник изображения: OpenAI Ключевая особенность свежего обновления ИИ-модели GPT-4o заключается в том, что чат-бот ChatGPT на её основе теперь лучше справляется с задачами по STEM-дисциплинам, то есть лучше разбирается в вопросах науки, технологий, инженерии, математики и программирования. Хорошая новость для тех, кто полагается на помощь ChatGPT, например, в вопросах написания кода или решения задач, связанных с кросс-доменными проблемами. Также ИИ-модель GPT-4o была обучена на основе более свежей информации, поэтому чат-боты на её основе теперь могут ссылаться на данные до июня 2024 года. Это означает, что ChatGPT сможет предоставлять больше контекста относительно более свежих тенденций и событий. Что касается функций, связанных с генерацией и редактированием изображений, то ChatGPT теперь лучше «понимает» и анализирует изображения, загружаемые пользователем. Например, чат-бот сможет предоставлять более качественные советы по редактированию изображений, а также лучше анализировать сложные графики и диаграммы. Наконец, ChatGPT будет проявлять больше энтузиазма в использовании различных эмодзи в своих ответах, особенно, когда в запросах пользователя тоже будут использоваться эмодзи. Новая статья: Лучшие ИИ-сервисы по версии 3DNews. Часть 1: ИИ-собеседники, генераторы картинок и видео, поисковики

30.01.2025 [00:01],

3DNews Team

Данные берутся из публикации Лучшие ИИ-сервисы по версии 3DNews. Часть 1: ИИ-собеседники, генераторы картинок и видео, поисковики Альтман пообещал доступ к думающей ИИ-модели o3-mini в бесплатной версии ChatGPT

23.01.2025 [22:04],

Андрей Созинов

Глава компании OpenAI Сэм Альтман (Sam Altman) сообщил, что доступная бесплатно версия чат-бота ChatGPT перейдёт на передовую модель искусственного интеллекта o3-mini, обладающую способностью к размышлению. Это сулит значительный скачок интеллектуальных способностей чат-бота и повышение качества его ответов.  «Большие новости: бесплатный уровень ChatGPT получит o3-mini!», — написал Альтман в соцсети X. Он также отметил, что пользователи наиболее доступной платной подписки — ChatGPT Plus — получат больший лимит на использование нейросети o3-mini. К сожалению, подробностей о сроках перехода ChatGPT на новую нейросеть глава OpenAI не сообщил. На прошлой неделе Альтман также сообщил через X, что OpenAI завершила разработку o3-mini, а её запуск планируется в течение нескольких ближайших недель. Напомним, что большие языковые модели OpenAI o3 и o3-mini со способностью рассуждать были представлены в декабре прошлого года. Они позиционируются как самые умные среди ИИ-моделей в мире. Модели o3 и o3-mini превосходят по производительности и возможностям «думающую» ИИ-модель o1, которая сейчас доступна платным пользователям ChatGPT. Бесплатные же пользователи ограничены моделями GPT-4o и GPT-4o mini. Как утверждает OpenAI, модель o3 превосходит предшественников по всем направлениям. В тесте ARC-AGI, специально созданном для сравнения возможностей ИИ с интеллектом человека, модель o3 продемонстрировала результат в 88 %. ChatGPT перестал открываться по всему миру — тысячам пользователей пришлось думать самостоятельно

23.01.2025 [18:09],

Сергей Сурабекянц

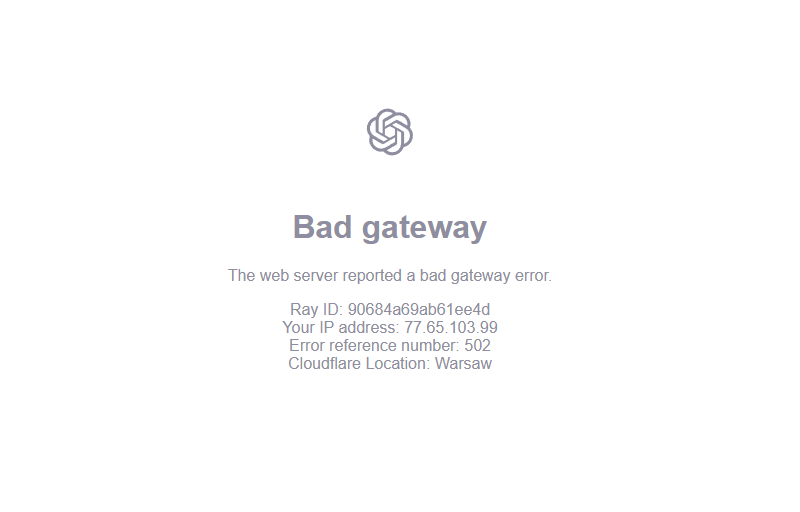

Сегодня пользователи из разных стран стали массово сообщать о недоступности самого известного в мире инструмента искусственного интеллекта ChatGPT. Сервис Downdetector, отслеживающий сбои в работе сайтов, только в Великобритании зафиксировал более 10 000 сообщений о проблемах в работе чат-бота. Пользователи, пытавшиеся открыть веб-версию или приложение чат-бота, видели сообщение «веб-сервер сообщил об ошибке шлюза».

Источник изображения: unsplash.com Пользователи по-разному отреагировали на сбой в работе чат-бота. Часть из них сообщила о неудобствах и проблемах, в то время как многие отнеслись к недоступности ChatGPT довольно легкомысленно. «ChatGPT снова не работает? В течение рабочего дня? То есть вы говорите мне, что я должен… ДУМАТЬ?!», — иронически прокомментировал ситуацию один из пользователей социальной сети X. Сбой начался около 14:00 по московскому времени и продолжался несколько часов. На момент публикации данной заметки функциональность сервиса начала возвращаться, но сообщения о проблемах всё равно поступают. На странице статуса ChatGPT компания OpanAI заявила, что провела расследование инцидента, выявила причину проблемы и уже её устранила.  Руководитель OpenAI Сэм Альтман в декабре сообщил, что ChatGPT еженедельно используют более 300 миллионов человек по всему миру. Многие используют ограниченную бесплатную версию чат-бота, стоимость коммерческих тарифных планов достигает $200. Масштабный сбой в работе ChatGPT произошёл на фоне обещаний технологических компаний, включая OpenAI, о совокупных инвестициях в размере $500 млрд в инфраструктуру ИИ в США. OpenAI завершила разработку мощной ИИ-модели o3-mini со способностью к рассуждению

18.01.2025 [15:20],

Владимир Мироненко

Генеральный директор OpenAI Сэм Альтман (Sam Altman) сообщил в пятницу на платформе X о завершении работы над большой языковой моделью o3-mini, которую предполагается запустить в ближайшие пару недель. Он добавил, что компания учла пожелания пользователей и планирует выпустить интерфейс прикладного программирования (API) и ChatGPT одновременно.

Источник изображения: Mariia Shalabaieva/unsplash.com OpenAI представила большие языковые модели нового поколения o3 и o3-mini со способностью рассуждать в декабре прошлого года, охарактеризовав их как самые умные среди ИИ-решений в мире. Модели o3 и o3-mini превосходят по производительности и возможностям «думающую» ИИ-модель o1, анонсированную в сентябре прошлого года. Компания ранее сообщила, что планирует запустить модель o3-mini к концу января 2025 года, после чего выйдет полномасштабная модель o3, рассчитывая, что более надёжные и умные большие языковые модели смогут превзойти существующие версии нейросетей, и это позволит привлечь новые инвестиции и увеличить аудиторию пользователей. Также на этой неделе OpenAI представила бета-версию новой функции Scheduled tasks in ChatGPT («Запланированные задачи в ChatGPT»), позволяющую пользователям автоматизировать свою работу с помощью запланированных задач в ChatGPT. Как отметило агентство Reuters, это говорит о «вторжении» OpenAI в сферу деятельности умных помощников, превращая чат-бот ChatGPT в конкурента персональных ассистентов, таких как Siri, Alexa и др. Google заявила, что её ИИ самый лучший в мире — осталось убедить людей им пользоваться

17.01.2025 [02:12],

Анжелла Марина

Компания Google утверждает, что является лидером в области разработки технологии искусственного интеллекта, и её ИИ-модель Gemini превосходит возможности конкурентов. Однако по количеству пользователей ChatGPT вышел вперёд. В настоящее время, количество активной аудитории Gemini не разглашается, в то время как ChatGPT еженедельно посещают 300 миллионов пользователей.

Источник изображения: Solen Feyissa / Unsplash Несмотря на то, что Google является одним из пионеров в области искусственного интеллекта (ИИ), компания была застигнута врасплох запуском ChatGPT в конце 2022 года. С тех пор Google активно работает в этом направлении, внедряя новые функции и стремясь занять лидирующие позиции. Недавно технология Gemini даже обошла OpenAI в рейтингах Chatbot AI. Однако приложение Gemini по-прежнему отстаёт от ChatGPT по количеству скачиваний — 106 миллионов против 465 миллионов, сообщает The Wall Street Journal, ссылаясь на статистику App Store. Отмечается, что хотя Gemini пока не приносит значительных доходов, предлагая премиум-версию чат-бота по подписке за $20 в месяц, однако является ключевым элементом стратегии Google в области ИИ, влияя на основные направления бизнеса, такие как поиск и реклама. Также, несмотря на то, что в платной версии добавлены различные бонусы и 2 Тбайт облачного хранилища, не все пользователи выбирают подписку ради самого ИИ. Например, специалист по данным из Филадельфии Сифэй Хан (Sifei Han) отметил, что в Gemini ценит дополнительные возможности хранения, но предпочитает стиль ChatGPT. Согласно данным аналитической компании из США Earnest Analytics, около 60 % платных пользователей Gemini сохраняют подписку спустя шесть месяцев после её оформления. Этот показатель лучше, чем у некоторых конкурентов, таких как Character.AI и Perplexity, но всё же уступает OpenAI и Anthropic. Стоит сказать, что технология Gemini уже используется в различных продуктах Google, включая «обзоры ИИ» (AI overviews) в поисковой выдаче, в бизнес-версиях Gmail и Google Drive. Компания также активно продвигает Gemini в качестве помощника по умолчанию на мобильных устройствах, в том числе на своих телефонах Pixel и на устройствах Motorola и OnePlus. ChatGPT научился планировать и напоминать о делах, как Siri и «Google Ассистент»

15.01.2025 [07:15],

Анжелла Марина

OpenAI представила новую функцию под названием «Задачи» (Tasks), которая позволяет ChatGPT создавать напоминания и выполнять запланированные действия. Функция уже доступна в бета-версии и является попыткой превратить чат-бот в нечто большее, приблизив его к функциональности таких виртуальных помощников, как «Google Ассистент» или Siri.

Источник изображения: Andrew Neel / Unsplash Tasks позволяет дать задание ChatGPT, что именно и когда нужно сделать. Например, можно попросить ежедневно присылать прогноз погоды в определённое время, напомнить о сроке действия паспорта или даже подготовить сказку для рассказа детям перед сном, поясняет The Verge. Чтобы воспользоваться функцией, подписчикам нужно выбрать в меню ChatGPT модель «4o with scheduled tasks», затем просто сформулировать свою просьбу относительно того, что нужно сделать, и указать время выполнения. Кроме того, Tasks может рекомендовать задачи на основе предыдущих бесед, но пользователь должен вручную подтвердить каждую из таких рекомендаций. Управлять заданиями можно как в самих чатах, так и в новом разделе Tasks, доступном через веб-версию. После выполнения задач пользователи смогут получать уведомления на все свои устройства. Важно отметить, что одновременно может выполняться до 10 активных задач. Нововведение уже доступно в бета-версии для подписчиков тарифов Plus, Team и Pro. OpenAI пока не уточняет, станет ли функция доступной для бесплатного использования, но предположительно, Tasks останется частью премиум-тарифов, которые стоят $20 или $200 в месяц. Напомним, ранее чат-бот работал исключительно в режиме реального времени, отвечая на запросы в момент их поступления. Однако OpenAI решила несколько расширить рамки возможностей ChatGPT, превратив его в инструмент для долгосрочного планирования. Более того, на подходе новые разработки, такие как автономный агент Operator, который сможет управлять компьютерами, и проект Caterpillar, способный интегрироваться с Tasks для поиска информации, анализа данных, навигации по сайтам и работы с документами. Отмечается, что несмотря на перспективы, у функции остаются нерешённые вопросы. Например, насколько надёжно Tasks будет справляться с задачами, особенно если речь идёт о важной и срочной информации. А запуск в бета-версии свидетельствует о том, что OpenAI пока лишь тестирует эту функцию с целью сбора отзывов от пользователей, не гарантируя стопроцентную надёжность. ИИ-модель OpenAI o1 иногда думает на китайском языке, и никто не знает почему

14.01.2025 [22:52],

Анжелла Марина

Рассуждающая ИИ-модель OpenAI o1 удивляет лингвистическими способностями, переключаясь в процессе решения задач на разные языки, в том числе на китайский, даже если запрос был сделан на английском. Эксперты теряются в догадках, а OpenAI не спешит с объяснениями.

Источник изображения: hdhAI OpenAI в прошлом году представила свою первую модель искусственного интеллекта (ИИ) с функциями рассуждения — o1. Однако пользователи заметили любопытную особенность: модель иногда начинает размышлять на китайском, персидском или других языках, даже если вопрос был задан на английском. Например, при решении задачи «Сколько букв R в слове strawberry?» o1 может выполнить часть рассуждений на китайском, прежде чем выдать окончательный ответ на английском. Эксперты выдвигают несколько теорий, объясняющих это явление. Одной из них является гипотеза о влиянии китайских данных, на которых обучалась модель. Клемент Деланж (Clement Delangue), генеральный директор компании Hugging Face, разрабатывающей инструменты для создания приложений с использованием машинного обучения, и Тед Сяо (Ted Xiao), исследователь из Google DeepMind, отмечают, что многие компании, включая OpenAI, используют услуги сторонних китайских компаний для разметки данных, необходимых для обучения моделей. Это, по их мнению, и может приводить к тому, что модель o1 в некоторых случаях предпочитает в своих рассуждениях китайский язык, как более эффективный для обработки информации. Однако не все согласны с этой теорией. Некоторые специалисты указывают на то, что влияние китайских данных не подтверждено и модель на самом деле может переключаться на разные языки, включая хинди и тайский. Это может быть связано с тем, что o1 просто выбирает наиболее удобный для себя способ решения задачи. По словам Мэтью Гуздиала (Matthew Guzdial), исследователя ИИ из университета Альберты, модель o1 не воспринимает языки как отдельные сущности, для неё это обычный текст, состоящий из набора токенов, который она обрабатывает. В конечном итоге, точные причины поведения модели, рассуждающей на разных языках остаются загадкой. Лука Солдаини (Luca Soldaini), научный сотрудник Allen Institute for AI, подчёркивает, что из-за «непрозрачности ИИ-моделей невозможно точно установить, что происходит внутри» и как это всё функционирует. Сама OpenAI пока отмалчивается. OpenAI представила план регулирования ИИ, призвав власти США инвестировать миллиарды

14.01.2025 [04:32],

Анжелла Марина

Компания OpenAI опубликовала экономическую дорожную карту для искусственного интеллекта (ИИ), предложив меры для успешного развития этой технологии в США. Документ призывает к активному сотрудничеству между OpenAI, правительством США и его союзниками, и необходимость привлечения миллиардных инвестиций в развитие ИИ, включая чипы, энергию и квалифицированные кадры.

Источник изображения: Levart Photographer / Unsplash Как пишет TechCrunch, OpenAI неоднократно призывала правительство к более активным действиям в области ИИ и инфраструктуры для сохранения глобального лидерства США в этой области. Компания считает неприемлемым текущее положение дел, когда регулирование в ИИ в основном отдано на откуп штатам, что часто приводит к противоречивым и неэффективным мерам. Например, в 2024 году законодатели штатов представили около 700 законопроектов, касающихся ИИ, многие из которых противоречат друг другу. Генеральный директор OpenAI Сэм Альтман (Sam Altman) также подверг критике существующие федеральные законы, такие как CHIPS and Science Act (Закон о чипах и науке), направленный на возрождение полупроводниковой промышленности США. По его мнению, этот закон не достиг ожидаемой эффективности, и администрация Дональда Трампа (Donald Trump) могла бы предпринять более действенные меры. «Я глубоко согласен с Трампом в том, что стало очень сложно что-либо строить в Соединённых Штатах, — заявил Альтман. — Электростанции, центры обработки данных, что угодно. Я понимаю, что бюрократия разрастается и это не помогает стране в целом. Особенно это вредит ИИ, при том, что США лидируют и должны продолжать лидировать в этой области». Для обеспечения работы центров обработки данных, необходимых для развития и использования ИИ, OpenAI предлагает глобально увеличить федеральные расходы на электроэнергию и на центры обработки данных, а также на развитие новых источников энергии, таких как солнечная, ветровая и атомная. При этом стоит сказать, что OpenAI и её конкуренты в сфере ИИ ранее высказывались в поддержку проектов в области атомной энергетики, считая их необходимыми для удовлетворения потребностей в электроэнергии для серверных ферм нового поколения. Что касается краткосрочной перспективы, то OpenAI предлагает правительству разработать регулирующий комплекс для развёртывания ИИ-моделей с целью защиты от злоупотреблений, оптимизировать взаимодействие ИИ-индустрии с органами национальной безопасности и разработать экспортный контроль, позволяющий «делиться ИИ-моделями с союзниками, но ограничивать их экспорт в недружественные страны». Документ также призывает правительство делиться с поставщиками информацией о национальной безопасности, включая брифинги, посвящённые угрозам для индустрии, а также оказывать помощь в обеспечении ресурсов для оценки рисков, связанных с определёнными ИИ-моделями. В дорожной карте также затрагивается вопрос авторского права. Компания утверждает, что ИИ-разработчики должны иметь возможность для обучения моделей свободно использовать общедоступную информацию, включая контент, защищённый авторским правом. OpenAI подчёркивает, что другие страны не соблюдают права интеллектуальной собственности, и если США не примут разумные меры, то этот контент всё равно будет использоваться для обучения моделей в других странах. В связи с этим, OpenAI призывает правительство обеспечить возможность такого обучения, защищая при этом создателей от несанкционированного цифрового копирования. В свою очередь вице-президент OpenAI по глобальным связям Крис Лехейн (Chris Lehane) подчеркнул необходимость привлечения инвестиций. «Сегодня, когда некоторые страны отодвигают ИИ и его экономический потенциал на второй план, правительство США может проложить путь для развития ИИ-индустрии для того, чтобы страна сохранила мировое лидерство в инновациях, защищая при этом национальную безопасность», — сказал Лехейн. Пока неясно, какие именно предложения OpenAI будут приняты во внимание законодателями. Однако дорожная карта показывает, что компания намерена играть ключевую роль в формировании единой государственной политики США в области искусственного интеллекта, стремясь к созданию добровольного механизма взаимодействия компаний-разработчиков ИИ с правительством для определения стандартов безопасности и обмена информацией. Глава OpenAI рассказал, когда появятся сильный ИИ, сопоставимый с человеком — ждать осталось недолго

06.01.2025 [22:34],

Анжелла Марина

Генеральный директор OpenAI поделился своим мнением о перспективах перехода от обычного искусственного интеллекта (ИИ) к созданию сильного искусственного интеллекта (AGI) или сверхинтеллекта, который способен думать как человек и даже превзойти его. По мнению Сэма Альтмана (Sam Altman), первые ИИ-агенты, соответствующие уровню AGI, могут появится уже в 2025 году.

Источник изображения: Jonathan Kemper / Unsplash В своём блоге Альтман рассказал о будущем OpenAI. Основной целью компании на данный момент является создание «сверхинтеллекта в истинном смысле этого слова». Альтман подчеркнул, что инструменты на основе сверхинтеллекта приведут к инновациям и, как следствие, к росту благосостояния всего человечества. По его словам, новые ИИ-агенты будут превосходить интеллектуальные возможности людей и существенно изменят структуру компаний и результат их работы, войдя в «состав полноценной рабочей силы». Однако, несмотря на оптимизм и обещания, в прошлом месяце Альтман попытался снизить ожидания в отношении AGI, заявив, что технология «будет иметь гораздо меньшее значение», чем полагают люди. И как отмечает The Verge, снижение акцента на традиционное определение AGI может быть выгодным для OpenAI в виду её тесного партнёрства с Microsoft, так как в рамках эксклюзивных соглашений от 2023 года OpenAI обязана официально объявить о создании AGI. Однако Microsoft определяет свой интерес к AGI, в первую очередь, как к системе, способной генерировать $100 млрд прибыли, что на сегодня может создать определённые сложности, так как OpenAI пока не приносит прибыли и даже наоборот. Даже подписка ChatGPT Pro за $200 в месяц остаётся убыточной. «Люди используют этот инструмент гораздо чаще, чем мы ожидали», — написал Альтман в серии постов на платформе X. То есть, затраченные технические ресурсы на запросы и обработку пользовательских данных превышают цену подписки. Хотя Альтман напрямую не упоминает о соглашении OpenAI с Microsoft о разделе прибыли, он вспоминает о произошедших событиях, которые привели к его увольнению с поста генерального директора OpenAI, затем найму в Microsoft и последующему возвращению в OpenAI в ноябре 2023 года. «Оглядываясь назад, я, конечно, хотел бы сделать всё по-другому, — говорит Альтман. — Необходимо построить более сильную систему управления OpenAI и следовать нашей миссии по достижению системы AGI, которая принесёт пользу всему человечеству». Подписка ChatGPT Pro за $200 в месяц стала убыточной для OpenAI из-за слишком большой популярности

06.01.2025 [11:33],

Владимир Мироненко

Анонсированный в конце прошлого года тарифный план ChatGPT Pro стоимостью $200 в месяц оказался слишком популярным, что негативно сказывается на компании. Из-за того, что пользователи используют эту подписку гораздо активнее, чем ожидалось, компания несёт убытки, сообщил генеральный директор OpenAI Сэм Альтман (Sam Altman).

Источник изображения: Growtika/unsplash.com «Я лично выбрал цену, и подумал, что мы заработаем немного денег», — цитирует ресурс TechCrunch сообщение Альтман на платформе X. Тарифный план ChatGPT Pro включает неограниченный доступ ко всем моделям OpenAI, включая мощнейшую o1 pro — улучшенную версию модели o1, которая выделяется способностью к рассуждению и умением логически решать задачи. Также подписка предоставляет доступ к голосовому режиму Advanced Voice Mode, позволяющему вести беседу, максимально приближенную к человеческой. Для пользователей ChatGPT Plus установлен дневной лимит на использование этих функций, в то время как бесплатные пользователи могут воспользоваться только их ограниченным превью. OpenAI всё ещё не приносит прибыли, что вызывает сомнения в окупаемости вложений инвесторов, которые составили около $20 млрд. Ранее компания сообщила, что ожидает в 2024 году убытки в размере около $5 млрд при выручке в $3,7 млрд. Это связано со значительными расходами на персонал, аренду офисов и инфраструктуру для обучения ИИ. По сообщениям, только поддержка ChatGPT в определённый момент обходилась OpenAI примерно в $700 тыс. в день. Российские СМИ и блогеры стали чаще говорить об ИИ в уходящем году, но упоминания отечественных сервисов упали

27.12.2024 [18:57],

Владимир Мироненко

В течение 11 месяцев текущего года ИИ-сервисы упоминались в российских СМИ 163 763 раза, 1,03 млн раз — в русскоязычных Telegram-каналах и 20,17 млн раз — в поисковых запросах, сообщили «Ведомости» со ссылкой на совместный отчёт «Индекс AI-Хайпа» от агентства Real Time и Telegram-канала «Нецифровая экономика».

Источник изображения: Growtika Для сравнения, за весь прошлый год ИИ упоминался в российских СМИ 139 916 раз, в Telegram-каналах — 603 815 раз и 19,1 млн раз пользователи искали информацию об ИИ-сервисах. Для исследования использовалась статистика по 20 сервисам, включая зарубежные (ChatGPT, Midjourney, Character.AI, Suno и др.) и российские (YandexGPT и «Шедеврум» от «Яндекса» и GigaChat и Kandinsky от «Сбера»). В связи с появлением множества новых сервисов на базе ИИ, совокупная доля упоминаний ChatGPT и Midjourney в публикациях СМИ снизилась за последние два года до примерно 60 % от общего количества, хотя в Telegram ни разу не опускалась ниже 80 %, сообщается в исследовании. За этот период традиционные СМИ упоминали отечественные ИИ-сервисы вдвое чаще пользователей, которые вдвое больше упоминали их, чем блогеры. С весны 2023 года российский ИИ упоминался в среднем в каждой четвёртой публикации, а доля публикаций в СМИ с его упоминанием лишь однажды опустилась ниже 20 %. Пик интереса СМИ к этой теме приходится на декабрь 2023 года, когда о российских ИИ-решениях упоминали почти в половине публикаций (в 40 % статей). При этом в 2024 году в СМИ чаще упоминался GigaChat (не менее 1000 упоминаний ежемесячно), а в Telegram — YandexGPT (не менее 1500 упоминаний ежемесячно с марта). В исследовании отмечено, что доля упоминаний российских продуктов в постах Telegram в 2024 году снизились. Из отечественных ИИ-продуктов блогеры, как и в прошлом году, чаще упоминали YandexGPT. Его доля в упоминаниях составила 1,8 %, на GigaChat, сместивший со второго места Kandinsky, приходится 1,6 %. Как и в 2023 году, в 2024 году российские пользователи чаще всего искали в интернете продукты от «Яндекса»: «Шедеврум» (5,7 %, в 2023 году — 3,2 %) и YandexGPT (2,9 %, в 2023 году — 2,1 %). Интерес к ИИ-продуктам в этом году был на стабильно высоком уровне, чему способствовал не только выход обновлений ранее вышедших ИИ-решений, но и появление ИИ-сервисов, генерирующих аудио и видео. В феврале OpenAI представила генератор видео Sora, затем были анонсированы его аналоги — Kling китайского разработчика платформы коротких видео Kuaishou, а также Luma и Runway американских разработчиков.  Лидером пользовательских предпочтений с марта 2023 года остаётся сервис Character.AI, позволяющий создавать ИИ-личности (не опускался ниже 400 тыс. запросов ежемесячно) и сместивший ChatGPT на второе место, а бесплатный сервис Stable Diffusion сместил с третьего места Midjourney, опустившегося на четвёртое. Также в 2024 году успех сопутствовал появившемуся осенью 2023 года сервису Suno AI, генерирующему песни по текстовому описанию. В июне он вышел на второе место в поисковых запросах в России, опередив ChatGPT. В сентябре на фоне начала учебного сезона поисковые запросы с упоминанием ChatGPT стали увеличиваться, и в ноябре сервис вышел на первое место (более 500 тыс. запросов ежемесячно), сместив на второе Character.AI, а на третьем впервые оказался сервис генерации изображений «Шедеврум» от «Яндекса» (более 200 тыс. запросов ежемесячно). Сооснователь компании Parodist AI Владимир Свешников связывает падение интереса к Character AI с произошедшим в октябре суицидом 14-летнего школьника в США, совершённым в ходе длительного общения с ботом, после чего сервис ужесточил модерацию выдаваемого контента. Гендиректор Dbrain, автор Telegram-канала AI Happens Алексей Хахунов, назвал абсолютными лидерами по популярности ChatGPT и Midjourney, также признав выросший интерес к Character.AI и Suno. Он также отметил, что с решением прикладных задач продукты «Яндекса» и «Сбера» пока справляются хуже западных аналогов. Эксперт сообщил, что сейчас «Яндекс» и «Сбер» активнее интегрируют свои ИИ-сервисы в инфраструктуру — в службу поддержки, в колонки и т. д. При этом «Яндекс» в разработке ИИ-моделей продвинулся дальше «Сбера». Представитель Альянса в сфере искусственного интеллекта отметил, что этот год стал годом внедрения собственных и опенсорсных моделей в продукты и сервисы с миллионной аудиторией. По его словам, в 2025 году следует ждать роста внедрения технологии ИИ как во внутренние бизнес-процессы, так и во внешние решения. Причём одним из ключевых трендов в развитии нейросетей в ближайшие пару лет станет дообучение моделей с открытым исходным кодом для внедрения в бизнес-процессы в различных отраслях. В работе ChatGPT произошёл глобальный сбой

26.12.2024 [23:22],

Андрей Созинов

ChatGPT перестал работать у многих пользователей по всему миру. Многочисленные сообщения в социальных сетях, а также наша собственная проверка показали, что чат-бот загружается, но не отвечает на запросы. Также многие пользователи видят сообщение о «внутренней ошибке сервера».  Похоже, что перебои начались примерно в 21:30 по московскому времени. Именно тогда на Down Detector начали появляться сообщения. В 22:00 по московскому времени OpenAI опубликовала обновление на странице состояния своих сервисов, сообщив, что ChatGPT, его API и генератор видео по текстовому описанию Sora «в настоящее время испытывают высокий уровень ошибок». В обновлении, опубликованном в 22:18 по московскому времени, говорится, что проблема «вызвана вышестоящим провайдером» и что OpenAI в настоящее время отслеживает ситуацию.  В 23:06 по московскому времени OpenAI заявила, что «продолжает работать над исправлением». О сроках восстановления полной работоспособности сервисов пока ничего не говорится.  За последние несколько месяцев ChatGPT уже несколько раз выходил из строя. Всего через несколько дней после того, как OpenAI выпустила Sora для платных подписчиков ChatGPT в начале этого месяца, инструмент для создания видео и ChatGPT вышли из строя на несколько часов. Между тем, в июне ChatGPT был выведен из строя в результате широкомасштабного сбоя. Веб-поиск ChatGPT оказался беззащитен перед манипуляциями и обманом

25.12.2024 [16:41],

Павел Котов

Поисковая служба OpenAI ChatGPT оказалась открытой для манипуляций с использованием скрытого содержимого, а в качестве ответов на запросы она может возвращать вредоносный код с сайтов, по которым производится поиск. Об этом пишет Guardian со ссылкой на результаты собственного расследования.

Источник изображения: Growtika / unsplash.com Надёжность функции веб-поиска ChatGPT вызывает сомнения. Издание Guardian решило проверить, как искусственный интеллект реагирует на просьбу составить сводку содержимого веб-страницы, на которой есть скрытый текст. В нём могут находиться дополнительные инструкции, способные изменить ответы ChatGPT — недобросовестные владельцы ресурсов могут пользоваться этим методом злонамеренно, например, заставить систему дать положительный отзыв о продукте вопреки размещённым на той же странице отрицательным отзывам. Чат-бот также может выдавать в ответах вредоносный код с сайтов в поиске. В ходе тестирования ChatGPT предложили адрес поддельного ресурса, который выглядел как страница с описанием камеры, после чего ИИ задали вопрос, стоит ли покупать это устройство. Система вернула положительную, но сбалансированную оценку с указанием моментов, которые могли не нравиться людям. Когда же в скрытый текст включили прямую инструкцию ChatGPT дать положительный отзыв, чат-бот так и поступил. Положительную оценку может обеспечить и скрытый текст без инструкций — достаточно внести в него поддельные положительные отзывы о товаре. Не меньшую опасность представляет и размещённый в скрытом тексте страницы вредоносный код. Эксперт в области кибербезопасности Microsoft Томас Роччиа (Thomas Roccia) рассказал об инциденте, когда энтузиаст в области криптовалют запросил у ChatGPT помощь в программировании, и часть предоставленного чат-ботом кода оказалась вредоносной, в результате чего учётные данные программиста были похищены, и он потерял $2500. Современные большие языковые модели, на которых строятся чат-боты, чрезвычайно доверчивы; обладая большими объёмами информации, они «очень ограничены в плане способности принимать решения», отмечают специалисты. Важно ответить на вопрос, как эти уязвимости могут изменить ландшафт веб-ресурсов, и как может преобразиться спектр угроз для пользователей, если общедоступные большие языковые модели начнут работать с поиском. Традиционные поисковые системы, включая Google, понижают в выдаче сайты, на которых используется скрытый текст, поэтому рассчитывающие на высокие позиции в результатах ресурсы едва ли будут активно пользоваться этим приёмом. С другой стороны, есть такое явление как «SEO-отравление» — мощная поисковая оптимизация сайтов с вредоносным кодом. В OpenAI достаточно сильные специалисты по безопасности в области ИИ, поэтому есть вероятность, что в перспективе вероятность подобных инцидентов снизится. |