|

Опрос

|

реклама

Быстрый переход

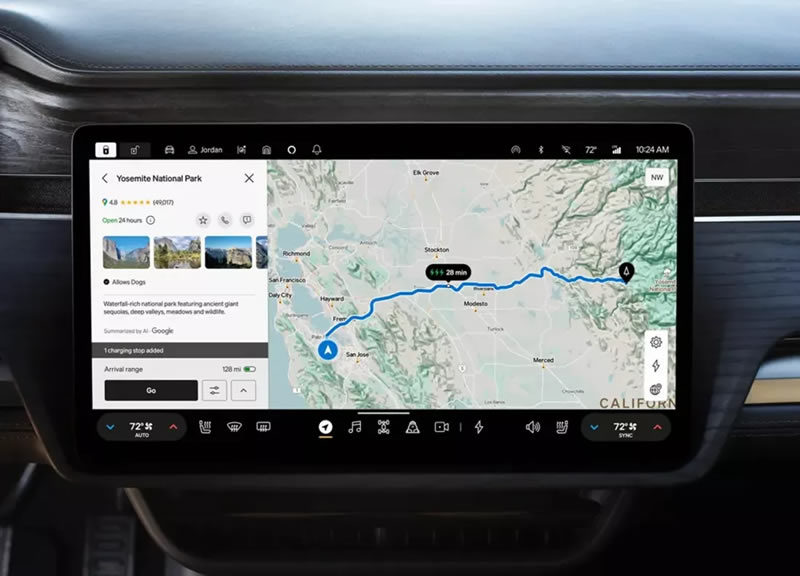

Генеративный ИИ от Google прописался в автомобилях Mercedes-Benz

13.01.2025 [20:17],

Сергей Сурабекянц

Google Cloud представила «новый способ для автопроизводителей использовать полезные генеративные возможности ИИ». Новый автомобильный агент ИИ от Google позволяет автопроизводителям создавать персонализированных и интуитивно понятных ИИ-помощников, которые умеют поддерживать беседу и отвечать на сложные вопросы, такие как «Есть ли поблизости итальянский ресторан?», «Какие о нём отзывы?» и «Какое там самое популярное блюдо?».

Источник изображения: techspot.com Mercedes-Benz и Google Cloud сегодня объявили о расширении своего стратегического партнёрства с целью внедрения новых разговорных возможностей в виртуального помощника MBUX на основе ИИ-агента Google Cloud Automotive AI Agent. Созданный с использованием Gemini на основе Vertex AI, Google Cloud Automotive AI Agent специально настроен для автомобильной промышленности и напрямую взаимодействует с платформой Google Maps. Mercedes-Benz является одним из первых автопроизводителей, внедривших автомобильного агента ИИ в свой виртуальный помощник MBUX, который появится в новом Mercedes-Benz CLA в конце этого года. По словам Google, «усовершенствованный виртуальный помощник MBUX предлагает свежую и достоверную информацию с платформы Google Maps и позволяет водителям и пассажирам использовать голосовые команды для получения персонализированной информации о точках интереса, условиях дорожного движения и многом другом за считанные секунды». Агент Google Cloud Automotive AI Agent также позволит виртуальному помощнику MBUX обрабатывать сложные многоуровневые диалоги и запоминать разговоры, чтобы продолжить общение на ту же тему позже. «В Mercedes-Benz мы стремимся предложить нашим клиентам исключительный цифровой опыт. Наше партнёрство с Google Cloud ещё больше улучшит навигацию в автомобиле, объединив сложные данные о местоположении с генеративным ИИ. Запущенная с новым CLA, наша навигация следующего поколения позволит водителям и пассажирам использовать голосовые команды для получения полной и персонализированной информации в течение нескольких секунд», — заявил генеральный директор Mercedes-Benz Group AG Ола Келлениус (Ola Källenius). «Mercedes-Benz известен тем, что обеспечивает невероятный опыт вождения, и наше партнёрство принесёт передовые достижения в области искусственного интеллекта, чтобы сделать этот опыт ещё лучше. Наш новый агент Automotive AI Agent поможет водителям ориентироваться и осуществлять поиск с помощью помощников в автомобиле, поэтому эти взаимодействия будут более естественными и полезными. Это только начало того, как агентские возможности могут преобразовать автомобильную промышленность, и я рад видеть, как наше партнёрство продвигает прогресс вперёд», — полагает генеральный директор Google Сундар Пичаи (Sundar Pichai). Новая функция поиска и навигации Point-of-Interest с улучшенным ИИ появится в новом Mercedes-Benz CLA в конце этого года. Это будет первый автомобиль, разработанный с новой операционной системой Mercedes-Benz MB.OS. В дальнейшем планируется внедрение новых ИИ-функций в другие модели. Google сделает использование телевизора более интуитивным и полезным, подселив нейросети Gemini в Google TV

07.01.2025 [12:20],

Владимир Мироненко

Google TV получит интеграцию с нейросетью Gemini, что позволит сделать взаимодействие пользователя с телевизором «более интуитивным и полезным», объявила Google на выставке CES 2025. Благодаря обновлению Google TV, которое выйдет в этом году, пользователи смогут искать контент и задавать вопросы, не начиная с фразы «Окей, Google», пишет The Verge.

Источник изображений: Google Для поиска медиа будет достаточно спросить: «Какие последние фильмы от Disney?». Также можно будет задавать более общие вопросы, такие как: «Какие места лучше всего посетить в Азии летом?», и Google TV покажет результаты с YouTube. Интеграция с нейросетью также позволит пользователям взаимодействовать с устройствами умного дома, предоставляя возможность просматривать видеопоток с дверного звонка, приглушать свет и выполнять другие действия. Аналогичные функции Gemini компания добавила в ТВ-приставку Google TV Streamer, вышедшую в прошлом году. Помимо интеграции Google TV с Gemini, компания оснащает телевизоры с использованием своей операционной системы микрофонами дальнего радиуса действия, что позволяет управлять телевизором с помощью голосовых команд напрямую, без необходимости использования пульта дистанционного управления. Телевизоры с Google TV также получат датчики приближения, которые будут определять, когда пользователь находится рядом с телевизором, и показывать «персонализированные и информативные виджеты» с информацией о погоде или новостями. Добавим, что LG и Samsung объявили по планах использовать ИИ-ассистента Microsoft Copilot в своих телевизорах. Google применила конкурирующего ИИ-бота Anthropic Claude для улучшения своих нейросетей Gemini

26.12.2024 [11:32],

Владимир Мироненко

Контрактные партнёры Google, работающие над повышением качества ответов ИИ-чат-бота Google Gemini, сравнивают их с ответами конкурирующего чат-бота Claude компании Anthropic, пишет ресурс TechCrunch со ссылкой на внутреннюю переписку компании. При этом Google оставила без ответа вопрос TechCrunch по поводу того, получила ли она разрешение на использование Claude в тестировании с Gemini.

Источник изображения: Google Эффективность разрабатываемых ИИ-моделей в сравнении с разработками конкурентов компании зачастую оценивают, используя отраслевые бенчмарки, а не поручая подрядчикам сравнивать с возможностями ИИ своих конкурентов. Привлечённые Google контрактные разработчики, занимающиеся улучшением Gemini, должны оценивать каждый ответ модели по нескольким критериям, таким как достоверность и уровень детализации. Согласно переписке, опубликованной TechCrunch, им выделяется до 30 минут на каждый запрос, чтобы определить, чей ответ лучше — Gemini или Claude. Разработчики сообщают, что в ответах Claude больше внимания уделяется безопасности, чем у Gemini. «Настройки безопасности у Claude самые строгие» среди моделей ИИ, отметил один из контрактных разработчиков в служебном чате. В некоторых случаях Claude не реагировал на подсказки, которые он считал небезопасными, например, предложение ролевой игры с другим ИИ-помощником. В другом случае Claude уклонился от ответа на подсказку, в то время как ответ Gemini был отмечен как «грубое нарушение правил безопасности», поскольку включал «обнажение тела и связывание». Шира Макнамара (Shira McNamara), представитель Google DeepMind, разработчика Gemini, не ответила на вопрос TechCrunch о том, получила ли Google разрешение Anthropic на использование Claude. Она уточнила, что DeepMind «сравнивает результаты моделирования» для оценки, но не обучает Gemini работе с моделями компании Anthropic. «Любое предположение о том, что мы использовали модели Anthropic для обучения Gemini, является неточным», — заявила Макнамара. Google представила первую ИИ-модель, которая рассуждает «вслух»

20.12.2024 [02:17],

Анжелла Марина

Компания Google представила новую экспериментальную модель искусственного интеллекта Gemini 2.0 Flash Thinking, которая, вероятно, станет конкурентом ИИ-модели o1 от OpenAI. Она также способна размышлять и отвечать на сложные вопросы, но помимо этого она также может пояснять ход своих «мыслей», сообщает The Verge.

Источник изображений: Google Главный научный сотрудник Google DeepMind Джефф Дин (Jeff Dean) в своём посте в X отметил, что модель в целях усиления логических рассуждений обучена «мыслить», а также обладает высокой скоростью обработки данных благодаря обновлённой технологии Gemini Flash 2.0. В одном из примеров показано, как модель решает задачу по физике, последовательно «размышляя» шаг за шагом перед тем, как выдать правильное решение. И хотя такой процесс не является аналогом мышления человека, однако позволяет алгоритму разбивать сложные задачи на более мелкие, что приводит к более точным и надёжным результатам. Ещё один пример работы Gemini 2.0 Flash Thinking, представленный менеджером по продукту Google Логаном Килпатриком (Logan Kilpatrick) в своём аккаунте X, продемонстрировал, как модель решала задачу, в которой были скомбинированы текстовые и визуальные элементы. Стоит сказать, что последние недели оказались насыщенными новостями в сфере ИИ. Недавно Google представила обновлённую версию своей модели Gemini 2.0, подчёркивая стремление развивать «агентский» ИИ, а компания OpenAI выпустила эксклюзивную версию модели o1 для подписчиков ChatGPT за $200, способную рассуждать. Google показала ИИ-агента, который помогает проходить игры, наблюдая за действиями игрока

12.12.2024 [01:54],

Анжелла Марина

Google представила новую версию платформы искусственного интеллекта Gemini 2.0, с помощью которой можно создавать ИИ-агентов для советов и подсказок в видеоиграх. Агенты способны анализировать игровой процесс и предлагать оптимальные стратегии, а пользователи смогут получать рекомендации в режиме реального времени.

Источник изображения: Supercell, theverge.com Как сообщают в блоге компании генеральный директор Google DeepMind Демис Хассабис (Demis Hassabis) и технический директор Корай Кавукчуоглу (Koray Kavukcuoglu), агенты «делают выводы об игре, основываясь исключительно на действиях на экране, и предлагают решения в режиме реального времени». Кроме того, они могут использовать поиск Google по базам знаний для предоставления более полной информации. Агенты уже тестируются в популярных играх, таких как Clash of Clans и Hay Day от Supercell. Однако, как пишет The Verge, технология находится на ранней стадии разработки, и пока не ясно, насколько полезными такие наставники окажутся для игроков. Помимо помощи в видеоиграх, Google развивает и другие направления применения Gemini 2.0. Например, ведётся работа над проектом Genie 2, который создаёт виртуальные игровые миры на основе лишь одного изображения. Пока эти миры остаются стабильными только около минуты, однако эксперты видят большой потенциал технологии. Также компания представила мультимодальные возможности Gemini 2.0 Flash, которые уже доступны разработчикам через API в Google AI Studio и Vertex AI. Новая версия отличается высокой скоростью работы, улучшенной обработкой данных и способностью генерировать изображения и текст, а также преобразовывать текст в речь на нескольких языках. Эти функции уже тестируются ранними партнёрами, а в январе платформа станет доступна широкой аудитории. Среди других проектов можно выделить Project Astra, Mariner и Jules. Project Astra, созданный для использования на Android-устройствах, был улучшен с помощью Gemini 2.0. Теперь ассистент на базе Astra может разговаривать на нескольких языках, использовать Google Search, Maps и Lens, а также запоминать больше данных, сохраняя при этом конфиденциальность. Project Mariner исследует, как ИИ может помогать в браузере, распознавая текст, изображения, код и другие элементы интерфейса, а Jules предназначен для помощи разработчикам в их рабочих процессах на GitHub. ИИ-агенты также могут применяться в физическом мире. Исследования Google показывают, что Gemini 2.0 способен использовать пространственное мышление в робототехнике. Хотя эти разработки находятся на ранней стадии, сама компания видит большой потенциал в создании агентов, которые способны взаимодействовать с реальной средой. Чтобы минимизировать риски и обеспечить безопасность своих ИИ-сервисов, компания проводит масштабные тестирования, сотрудничает с доверенными тестировщиками и внешними экспертами. В ближайшем будущем Google планирует интегрировать возможности Gemini 2.0 во все свои продукты, включая мобильное приложение Gemini. Google научила ИИ глубоко гуглить — Deep Research тщательно исследует любую тему в интернете

11.12.2024 [22:12],

Николай Хижняк

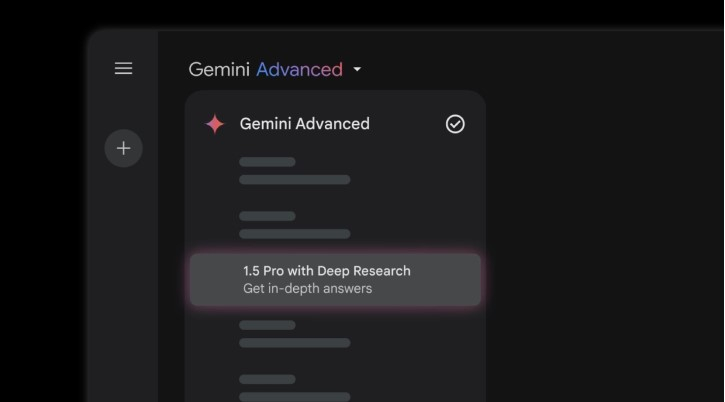

Компания Google представила новый ИИ-инструмент под названием Deep Research, который позволяет чат-боту Gemini проводить тщательный веб-поиск по заданной теме вместо пользователя и составлять детальный отчёт на основе обнаруженной информации.

Источник изображений: Google В настоящий момент Deep Research доступен только для платных подписчиков Gemini Advanced и только на английском языке. Для его активации необходимо выбрать в Gemini в качестве модели «Gemini 1.5 Pro с Deep Research».  При наличии доступа можно попросить Gemini провести исследование на определённую тему. После этого чат-бот составит «план поиска», который можно отредактировать или сразу одобрить. По словам Google, Gemini начнет своё исследование с «поиска интересных фрагментов информации» в интернете, а затем выполнит связанный поиск — процесс, который он повторяет несколько раз.  Когда исследование будет завершено, Gemini выдаст отчёт о своих «ключевых выводах» со ссылками на веб-сайты, где была найдена информация. Пользователь может попросить расширить определённые области поиска, подправить отчёт, а также экспортировать сгенерированное ИИ-исследование в Google Docs. Всё это напоминает функцию Pages, предлагаемую поисковой системой ИИ Perplexity, которая генерирует пользовательскую веб-страницу на основе запроса пользователя. Google представила Deep Research в рамках более широкого анонса Gemini 2.0 — новой модели для эпохи «агентного» ИИ, или систем, которые способны заменить пользователя в рутинных операциях. Deep Research является лишь одним из примеров ИИ-агентов Google. Другие компании, работающие в сфере ИИ, также разрабатывают аналогичные решения. Вместе с анонсом Deep Research компания Google также объявила, что Gemini Flash 2.0 — более быстрая версия чат-бота следующего поколения — стала доступна для разработчиков. Google запустила «всеобъемлющую» ИИ-модель Gemini 2.0, которая может заменить человека

11.12.2024 [20:03],

Сергей Сурабекянц

Представлена новая модель ИИ Gemini 2.0 от Google, которая стала предельно универсальной — она генерирует текст, звук и изображения, а также предлагает новые мультимодальные возможности, которые закладывают основу для следующего большого этапа в развитии ИИ: агентов, которые в буквальном смысле могут заменить пользователя в рутинных операциях. Новая модель также стала заметно производительнее и энергоэффективнее.

Источник изображения: techspot.com Как и любая другая компания, участвующая в гонке ИИ, Google лихорадочно встраивает ИИ во всё, до чего может дотянуться, пытаясь создать коммерчески успешные продукты. Одновременно требуется так настроить всю инфраструктуру, чтобы дорогостоящие ИИ-решения не разорили компанию. Тем временем Amazon, Microsoft, Anthropic и OpenAI вливают свои собственные миллиарды в практически тот же самый набор проблем. Gemini 2.0 представлена примерно через 10 месяцев после выпуска версии 1.5. Генеральный директор Google DeepMind Демис Хассабис (Demis Hassabis) очень высоко оценивает новую модель, называя её «всеобъемлющей», хотя Gemini 2.0 все ещё находится в стадии «экспериментального предварительного просмотра», по терминологии Google. Тем не менее Хассабис уверен, что новая модель предоставит совершенно другой уровень возможностей, в первую очередь в области агентского ИИ. Агентским ИИ называют ИИ-ботов, которые могут полноценно выполнять действия от имени пользователя. Например, Project Astra от Google — это визуальная система, которая может распознавать объекты, помогает ориентироваться в мире и находить утерянные предметы. По словам Хассабиса, возможности Astra в версии Gemini 2.0 многократно возросли. Другой пример — Google Project Mariner — экспериментальное расширение для браузера Chrome, которое может буквально подменять пользователя при веб-серфинге. Агент Jules, в свою очередь, помогает разработчикам в поиске и исправлении плохого программного кода. Выпущен даже агент, который помогает лучше играть в видеоигры. Хассабис приводит его в пример в качестве по-настоящему мультимодальной модели ИИ. «Мы действительно считаем 2025 год настоящим началом эры на основе агентов, — заявил Хассабис, — Gemini 2.0 является её основой». Он также отметил возросшую производительность и энергоэффективность новой модели, особенно на фоне общего замедления прогресса в отрасли ИИ. План Google относительно Gemini 2.0 заключается в том, чтобы использовать её абсолютно везде. Google ставила своей целью внедрить как можно больше функций в единую модель, а не запускать множество отдельных разрозненных продуктов. «Мультимодальность, различные виды выходных данных, функции — цель состоит в том, чтобы включить все это в основополагающую модель Gemini. Мы пытаемся построить максимально общую модель», — говорит Хассабис. По словам Хассабиса, с началом агентской эры ИИ потребуется решать как новые, так и старые проблемы. Старые вечны, они касаются производительности, эффективности и стоимости вывода. Новые во многом связаны с рисками в сфере безопасности и конфиденциальности. Gemini 2.0 на данный момент находится на экспериментальной стадии, причём только в облегчённой версии Gemini 2.0 Flash. Выход окончательной версии запланирован на начало следующего года. Миллионы роликов на YouTube получат дубляж на иностранных языках

11.12.2024 [08:27],

Алексей Разин

Совершенствование больших языковых моделей, лежащих в основе ИИ-ассистента Gemini, уже позволило Google предложить ограниченному кругу создателей видеоконтента функцию автоматического дубляжа их роликов на различных языках. Теперь доступ к этой возможности расширен для авторов видеороликов познавательного и образовательного содержания.

Источник изображения: Unsplash, Bhautik Patel Как отмечает TechCrunch, сервис YouTube объявил о расширении поддержки функции автоматического дубляжа видеоконтента на сотни тысяч каналов, которые посвящены познавательным целям. Получить автоматический дубляж видео могут те авторы контента, которые, например, ведут кулинарные блоги или делятся секретами мастерства в различных сферах. В перспективе функция охватит и те каналы, которые специализируются на других типах контента. Чтобы воспользоваться новшеством, автору видео достаточно загрузить исходный видеоролик в обычном режиме. YouTube сам определит язык исходного видео и создаст дублированные версии на различных языках, если пользователь поставил необходимую отметку в интерфейсе страницы загрузки. Пока поддерживаются английский, французский, немецкий, индийский, индонезийский, итальянский, японский, португальский и испанский языки. Google предупреждает, что возможности Gemini по воссозданию человеческой речи на различных языках пока ограничены. Ассистент не только может допускать грамматические, стилистические и фонетические ошибки, но и отличаться от тембра владельца исходного голоса в видеоролике. В дальнейшем YouTube обещает добавить речи своего автоматического переводчика экспрессивности, что позволит лучше отображать эмоциональность оригинала и даже повторять окружающие звуки исходной аудиодорожки. Google выпустила крупное обновление для Android 15 — улучшены субтитры, приложение Lookout и не только

06.12.2024 [11:21],

Владимир Фетисов

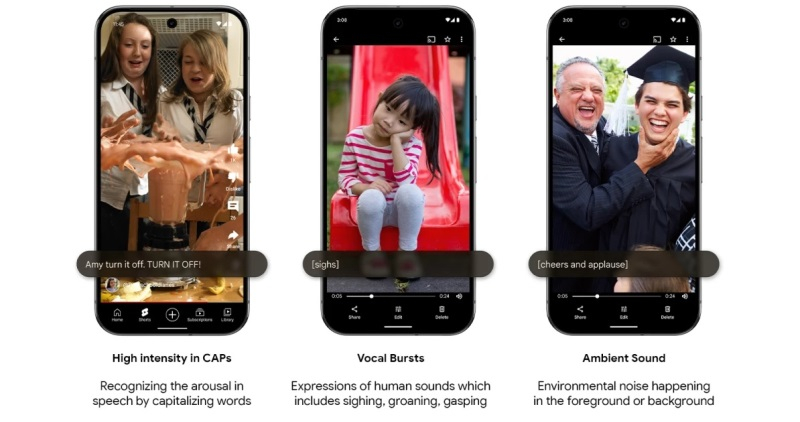

Компания Google выпустила функциональное обновление для мобильной ОС Android и устройств семейства Pixel. Разработчики улучшили инструмент генерации субтитров к видео, обновили приложение Lookout, а также добавили несколько ИИ-функций, основой для которых стала нейросеть Gemini 1.5. Все нововведения будут доступны владельцам устройств с Android 15, но некоторые функции также появятся в смартфонах с более старыми версиями программной платформы.

Источник изображений: Google Разработчики улучшили приложение Lookout, с помощью которого люди с нарушениями зрения могут получить в формате аудио описания разных объектов и фотографий. Google интегрировала нейросеть Gemini 1.5 в приложение, благодаря чему пользователи смогут получать более качественные и детальные описания фотографий, сделанных или открытых с помощью Lookout. Это нововведение стало очередным шагом на пути Google по интеграции большего количества ИИ-функций в приложение Lookout, о чём компания объявила на прошедшей ранее в этом году конференции I/O. Обновление Android принесёт с собой улучшенные субтитры для видео. Теперь помимо расшифровки речи субтитры будут отображать сопутствующие звуки и эмоции, например, аплодисменты или вздохи. Это нововведение касается всей системы Android и будет доступно везде, где есть возможность активации функции субтитров.  Google продолжает развивать новый ИИ-помощник Gemini Assistant. На этот раз он получил расширение Spotify, позволяющее воспроизводить аудио из музыкального сервиса через Gemini. На момент дебюта Gemini Assistant в нём отсутствовала поддержка ряда базовых функций, таких как воспроизведение музыки из Spotify. Теперь же это изменится, и новый ИИ-помощник станет более похожим на стандартный Google Assistant, который уже несколько лет может проигрывать аудио из Spotify. Gemini также получит доступ к расширению «Утилиты», благодаря чему ИИ-ассистент сможет выполнять больше действий от имени пользователя, например, совершать звонки, отправлять электронные письма и менять настройки устройства. Среди других примечательных особенностей пакета обновлений отметим появление возможности создания стикеров с помощью Emoji Kitchen внутри Gboard, возможности делиться фотографиями с помощью QR-кода в Quick Share, а также улучшенного инструмента сканирования квитанций и других документов в «Google Диске». Все упомянутые функции будут доступны на устройствах с Android 15, но некоторые из них также появятся в более старых версиях ОС. Декабрьское обновление принесёт несколько больше нововведений на смартфоны Pixel. В дополнение к перечисленным функциям владельцы смартфонов Google смогут задействовать улучшенную функцию проверки входящих вызовов. Пока звонящий разговаривает с голосовым помощником пользователь сможет включиться в беседу, чтобы отвечать на задаваемые звонящим вопросы от имени помощника, не принимая при этом вызов. Разработчики также обновили приложение Screenshots, улучшив функцию Circle to Search и добавив возможность сохранения в приложении результатов поиска. Google Gemini сможет управлять приложениями без пользователя и даже не открывая их

23.11.2024 [08:00],

Анжелла Марина

Система искусственного интеллекта Google Gemini получит новые возможности благодаря API App Functions, который позволяет выполнять действия в приложениях без их открытия. По данным The Verge, новая функция обнаружена в коде Android 16 для разработчиков и может стать доступна для всех пользователей уже в следующем году.

Источник изображения: Solen Feyissa / Unsplash Функция App Functions, основанная на программном интерфейсе API (Application programming interface), может дать ассистенту Gemini возможность выполнять действия внутри приложений. На сайте разработчиков Google описывает app functions как «конкретную функциональность, которую приложение предоставляет системе, и которая одновременно может быть интегрирована в различные системные функции». И хоть пока это звучит довольно расплывчато, Мишаал Рахман (Mishaal Rahman) из Android Authority приводит пример из документации, который проясняет суть. Например, разработчики приложений смогут открывать доступ посредством API к отдельным действиям, как, например, заказ еды, а Gemini сможет сделать заказ, не открывая приложения. Интересно, что подобную функцию разрабатывает и Apple. В iOS 18 Siri также сможет выполнять действия внутри приложений через обновлённый фреймворк app intents. Например, пользователи смогут заказать что-либо в магазине через Siri, если разработчики определённого приложения подключат такую возможность. Однако внедрение этой функции в случае с Apple ожидается не раньше весны 2025 года. Стоит отметить, что способность «выполнять действия за пользователя» изначально была одной из главных целей умных ассистентов, но её реализация начала появляться лишь недавно. Пока Gemini в основном ограничен поиском информации в Gmail или Google Maps. Что касается голосового помощника Siri в iOS 18, то он получил интеграцию с ChatGPT, за счёт чего можно задавать более сложные вопросы, но с выполнением действий Siri пока справляется хуже. Судя по всему, и Google, и Apple закладывают фундамент для более «умных» ассистентов, которые смогут выполнять сложные задачи внутри приложений, и это произойдёт уже очень скоро. Google научила Gemini запоминать личную информацию о пользователе — для его же удобства

20.11.2024 [01:46],

Николай Хижняк

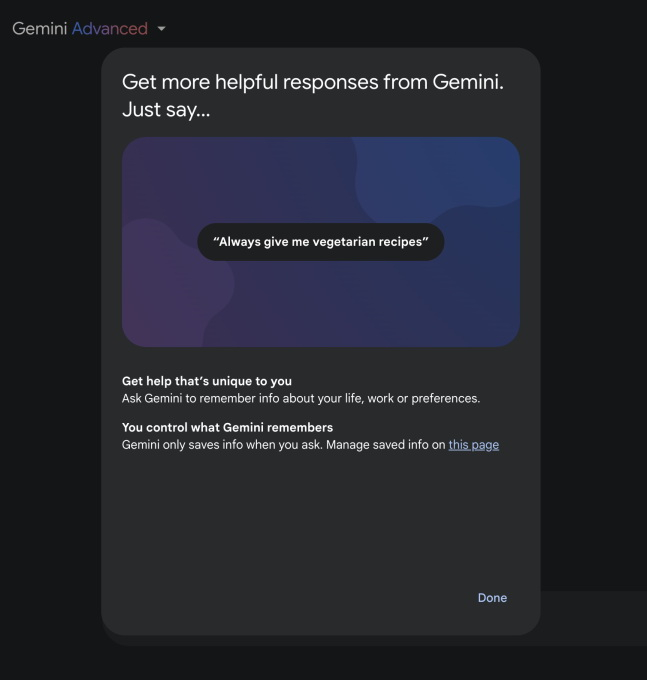

Чат-бот Gemini от Google научился запоминать информацию о жизни пользователя, его работе, а также личных предпочтениях. В настоящий момент функция «памяти» Gemini доступна только для некоторых пользователей.

Источник изображения: blog.google Как и аналогичная функция в ChatGPT, «память» позволяет Gemini расширять контекст текущего разговора. Например, чат-боту можно дать команду запомнить вашу любимую еду, и в следующий раз, при запросе поиска ближайших ресторанов, чат-бот подберёт варианты в соответствии с вашими гастрономическими предпочтениями. Функция «памяти» будет доступна только для платных подписчиков Google One AI Premium для Gemini с ежемесячной платой в размере $20. По данным портала 9to5Google, функция появилась только в веб-версии Gemini и пока недоступна в мобильных приложениях для iOS и Android.

Источник изображения: Google В качестве примеров запросов для данной функции Google приводит следующие варианты: «используй простой язык и избегай жаргонизмов», «я могу писать код только на JavaScript», «при планировании поездки учитывай стоимость ежедневных затрат». Компания отмечает, что функция пока поддерживает только англоязычные запросы, может быть отключена в любое время, но «воспоминания» хранятся до тех пор, пока их не удалят вручную. Компания также уверяет, что не использует «воспоминания» для обучения модели.  «Ваша сохраненная информация никуда не передаётся и не используется для обучения модели», — сообщил представитель Google в разговоре с TechCrunch. Эксперты по компьютерной безопасности предупреждают, что функции памяти чат-ботов при слабой защите могут быть использованы злоумышленниками. Например, ранее сообщалось, что хакер внедрил в ChatGPT ложные воспоминания для кражи пользовательских данных. Google выпустила для iPhone приложение ИИ-чат-бота Gemini

14.11.2024 [17:59],

Владимир Мироненко

Бесплатное приложение ИИ-чат-бота Google Gemini, как и ожидалось, появилось в магазине приложений App Store компании Apple по всему миру. При его запуске появляется окно чата со списком предыдущих диалогов пользователя, который может отправлять запросы с помощью текста, голоса или камеры.

Источник изображений: Apple До этого пользователям iOS-устройств для доступа к Gemini приходилось открывать приложение Google и переключаться на соответствующую вкладку. В качестве альтернативы, в сентябре был обновлен виджет главного экрана приложения Google с настраиваемыми ярлыками, которые позволили напрямую получать доступ к Gemini одним нажатием. Приложение Gemini для iOS имеет новую функцию Gemini Live, обеспечивающую доступ к более интерактивному и разговорному режиму чата-бота, который похож на голосовой режим ChatGPT и доступен на платформе Android. Gemini Live отображается как на Dynamic Island iPhone, так и на экране блокировки. Как и все другие чат-боты, не поддерживающие Siri, Gemini имеет некоторые ограничения. Он не может менять настройки или получать доступ к другим приложениям. Но он может получать доступ к программным решениям Google. Например, его можно попросить воспроизвести музыку, и он запустит YouTube Music. Также можно его попросить указать дорогу, и он откроет картографический сервис Google Maps. Пузырь ИИ сдувается, пока OpenAI, Google и Anthropic пытаются создать более продвинутый ИИ

13.11.2024 [19:26],

Сергей Сурабекянц

Три ведущие компании в области искусственного интеллекта столкнулись с ощутимым снижением отдачи от своих дорогостоящих усилий по разработке новых систем ИИ. Новая модель OpenAI, известная как Orion, не достигла желаемой компанией производительности, предстоящая итерация Google Gemini не оправдывает ожиданий, а Anthropic столкнулась с отставанием в графике выпуска своей модели Claude под названием 3.5 Opus.

Источник изображения: unsplash.com После многих лет стремительного выпуска всё более сложных продуктов ИИ три ведущие в этой сфере компании наблюдают убывающую отдачу от дорогостоящих усилий по созданию новых моделей. Становится все труднее находить свежие, ещё неиспользованные источники высококачественных данных для обучения более продвинутых систем ИИ. А нынешних весьма скромных улучшений недостаточно, чтобы окупить огромные затраты, связанные с созданием и эксплуатацией новых моделей, как и оправдать ожидания от выпуска новых продуктов. Так, OpenAI утверждала, что находится на пороге важной вехи. В сентябре завершился начальный раунд обучения для новой масштабной модели Orion, которая должна была приблизится к созданию мощного ИИ, превосходящего людей. Но ожидания компании, по утверждению осведомлённых источников, не оправдались. Orion не смогла продемонстрировать прорыва, который ранее показала модель GPT-4 по сравнению с GPT-3.5.

Источник изображения: Pixabay Anthropic, как и её конкуренты, столкнулась с трудностями в процессе разработки и обучения 3.5 Opus. По словам инсайдеров, модель 3.5 Opus показала себя лучше, чем старая версия, но не так значительно, как ожидалось, учитывая размер модели и затраты на её создание и запуск. Эти проблемы бросают вызов утвердившемуся в Кремниевой долине мнению о масштабируемости ИИ. Приверженцам глобального внедрения ИИ приходится признать, что бо́льшая вычислительная мощность, увеличенный объём данных и более крупные модели пока не прокладывают путь к технологическому прорыву в области ИИ.

Источник изображения: Nvidia Эксперты высказывают обоснованные сомнения в окупаемости крупных инвестиций в ИИ и достижимости всеобъемлющей цели, к которой стремятся разработчики ИИ-моделей, — создания общего искусственного интеллекта (AGI). Этот термин обычно применяется к гипотетическим ИИ-системам, способным соответствовать или превосходить человека в большинстве интеллектуальных задач. Руководители OpenAI и Anthropic ранее заявляли, что AGI может появиться уже через несколько лет. Технология, лежащая в основе ChatGPT и конкурирующих ИИ-чат-ботов, была создана на основе данных из социальных сетей, онлайн-комментариев, книг и других источников из интернета. Этих данных хватило для создания продуктов, генерирующих суррогатные эссе и поэмы, но для разработки систем ИИ, которые превзойдут интеллектом лауреатов Нобелевской премии — как надеются некоторые компании, — могут потребоваться другие источники данных, помимо сообщений в Википедии и субтитров YouTube.

Источник изображения: unsplash.com OpenAI была вынуждена заключить соглашения с издателями, чтобы удовлетворить хотя бы часть потребности в высококачественных данных, а также адаптироваться к растущему юридическому давлению со стороны правообладателей контента, используемого для обучения ИИ. Отмечается высокий спрос на рынке труда на специалистов с высшим образованием, которые могут маркировать данные, связанные с их областью компетенции. Это помогает сделать обученные ИИ-системы более эффективными в ответах на запросы. Подобные усилия обходятся дороже и требуют на порядок больше времени, чем простое индексирование интернета. Поэтому технологические компании обращаются к синтетическим данным, таким как сгенерированные компьютером изображения или текст, имитирующие контент, созданный людьми. Однако у такого подхода есть свои ограничения, так как трудно добиться качественного улучшения при использовании подобных данных для обучения ИИ. Тем не менее компании ИИ продолжают следовать принципу «чем больше, тем лучше». В стремлении создавать продукты, приближающиеся к уровню человеческого интеллекта, технологические компании увеличивают объём вычислительной мощности, данных и времени, затрачиваемых на обучение новых моделей, что приводит к росту расходов. Генеральный директор Anthropic Дарио Амодеи (Dario Amodei) заявил, что в этом году компании потратят $100 млн на обучение новейших моделей, а в ближайшие годы эта сумма может достичь $100 млрд.

Источник изображения: unsplash.com Безусловно, потенциал для улучшения моделей ИИ, помимо масштабирования, существует. Например, для своей новой модели Orion OpenAI применяет многомесячный процесс пост-обучения. Эта процедура включает использование обратной связи от людей для улучшения ответов и уточнения «эмоциональной окраски» взаимодействия с пользователями. Разработчики ИИ-моделей оказываются перед выбором: либо предлагать старые модели с дополнительными улучшениями, либо запускать чрезвычайно дорогие новые версии, которые могут работать ненамного лучше. По мере роста затрат растут и ожидания — стремительное развитие ИИ на начальном этапе создало завышенные ожидания как у специалистов, так и у инвесторов. Приложение ИИ-чат-бота Google Gemini появится на iPhone с эксклюзивными функциями

11.11.2024 [19:40],

Сергей Сурабекянц

ИИ-чат-бот Google Gemini дебютировал на Android в начале этого года. Теперь Google приступила к тестированию отдельного приложения Gemini для iPhone. Ожидается, что это ПО получит дополнительные функции, недоступные в интегрированном ИИ-помощнике Google.

Источник изображений: techspot.com Gemini — это чат-бот ИИ от Google, работающий на одноименной языковой модели, представленный в конце 2023 года после объединения моделей Bard и Duet AI для конкуренции с ChatGPT от OpenAI. Приложение Gemini было запущено на Android в начале этого года, позволяя пользователям обрабатывать документы, обобщать электронные письма и получать другую помощь от функций ИИ. Пользователь Reddit из Филиппин утверждает, что загрузил приложение Gemini в App Store. Судя по скриншотам, оно доступно в магазине приложений Apple этой страны уже около недели. После установки на главном экране появляется ярлык, позволяющий пользователям вызывать ИИ-помощника одним нажатием. В описании App Store приложение рекламируется как способ «разблокировать мощь Google AI на вашем iPhone». В настоящее время приложение Gemini для iOS недоступно в большинстве регионов, включая США. Пользователи в Канаде, Австралии и Индии также не могут получить доступ к приложению. Похоже, что Google тестирует его в определённых регионах перед началом широкомасштабного развёртывания. Новое приложение представляет функцию под названием Gemini Live, которая недоступна в Gemini для Android. По словам установившего ИИ-помощника пользователя, Gemini Live «работает в фоновом режиме с Live Activity iOS, пока пользователи выполняют несколько задач одновременно, обеспечивая более плавный и удобный опыт». В настоящее время пользователи iOS могут получить доступ к Gemini, только переключившись на вкладку Gemini в верхней части поискового приложения Google, что аналогично использованию Gemini через веб-интерфейс. Такой способ менее плавный и удобный по сравнению с ИИ-помощником Gemini на устройствах Google Pixel. Google пока официально не подтвердила разработку отдельного приложения Gemini для iOS, поэтому дата глобального релиза неизвестна. Однако, поскольку тестирование, по-видимому, уже началось, ИИ-помощник может стать широко доступным для владельцев iPhone в ближайшие несколько месяцев. Google начал внедрять генеративный ИИ в «Карты» и другие геосервисы

01.11.2024 [22:36],

Анжелла Марина

Google обновляет свои картографические платформы, интегрируя возможности генеративного ИИ на базе модели Gemini. Нововведения коснутся «Google Карт», «Google Планета Земля» и Waze, что, по мнению компании, поможет решать сложные геопространственные задачи и улучшит взаимодействие пользователей с физической средой.

Источник изображения: techspot.com Новые возможности уже начали появляться у пользователей «Google Карт» в США на устройствах Android и iOS, сообщает TechSpot. Среди них — более детализированные и контекстные результаты поиска, основанные на модели Gemini. Теперь можно запрашивать информацию о месте для вечернего отдыха в конкретном городе. ИИ проанализирует данные из обширной геобазы Google, учтёт отзывы пользователей, и выдаст рекомендации. По словам вице-президента и генерального директора Google по геотехнологиям Криса Филлипса (Chris Phillips), модель Gemini проверяет и подтверждает информацию из базы данных «Google Карт», а также ссылается на сторонние источники, такие как блоги, если это необходимо. Среди других нововведений — улучшенное исследование маршрутов, с рекомендациями по достопримечательностям по проложенному пути, а также информация о парковках. Кроме того, в «Google картах» добавлена функция дополненной реальности и сведения о возможных задержках по маршруту, связанных с погодой. Google Earth также получит поддержку ИИ, что облегчит работу городским службам. Благодаря новым функциям они смогут быстрее анализировать данные. Например, транспортный планировщик сможет узнать, в каких районах наименьшее количество зарядных станций для электромобилей, используя многозадачное логическое обоснование и визуализации, созданные ИИ. Сообщается, что эти функции были разработаны в партнёрстве с Google Research и X, moonshot factory (исследовательский центр Google), и начнут тестироваться уже в следующем месяце. Waze, который теперь полностью интегрирован в геопространственное подразделение Google, также получил обновления с использованием ИИ-модели Gemini. Появилась функция голосового помощника, сообщающего пользователю о неблагоприятных дорожных условиях. Кроме того, Waze упростил добавление школьных зон на карту, и теперь водители транспорта будут получать предупреждения при их проезде. Данная функция станет доступна на iOS и Android позже в этом году. Для разработчиков, использующих Google Maps Platform, Google представил инструмент «grounding with Google Maps». Он позволяет интегрировать геоданные в приложения, использующие искусственный интеллект. Отмечается, что в ближайшее время внедрять возможности Gemini начнёт и американский производитель электромобилей компания Rivian, которая будет показывать ИИ-сводку ресторанов и магазинов на экранах своих автомобилей. |