|

Опрос

|

реклама

Быстрый переход

Google выпустила Gemma 3 — самую мощную модель ИИ для запуска на одной видеокарте

12.03.2025 [12:23],

Павел Котов

Google выпустила открытую модель искусственного интеллекта Gemma 3 — это новый представитель семейства моделей, на основе которых разработчики смогут создавать приложения, способные запускаться локально на рабочих станциях или даже смартфонах. Поддерживаются 35 языков, есть функции анализа текста, изображений и коротких видеороликов.

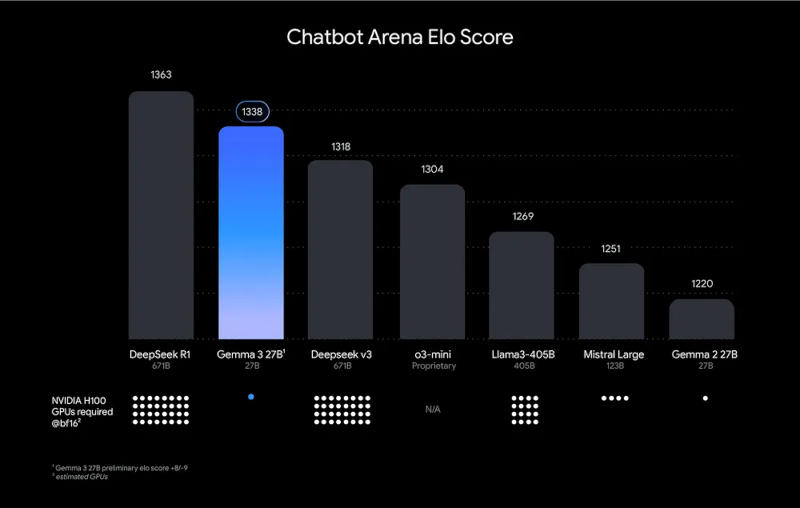

Источник изображений: blog.google Google охарактеризовала Gemma 3 как «лучшую в мире модель для одного ускорителя» и заверила, что она демонстрирует результаты лучше, чем конкуренты от Meta✴, DeepSeek и OpenAI при работе на одной видеокарте; она оптимизирована для оборудования Nvidia и других ИИ-ускорителей. Обновился компонент анализа видео — теперь он поддерживает записи высокого разрешения и отличную от квадратной форму кадра; фильтр безопасности входных и выходных изображений ShieldGemma 2 реагирует на картинки деликатного характера и материалы с изображением жестокости.  У Google это открытая модель ИИ уже третьего поколения, но потенциал этого направления помогла раскрыть китайская DeepSeek — её проекты продемонстрировали, что существует спрос на ИИ-решения с относительно невысокими системными требованиями. У Gemma 3 отмечаются значительные познания в области технических дисциплин, и Google провела дополнительное тестирование на возможность нецелевого использования модели, например, для создания вредных веществ — вероятность сбоя защитных механизмов в компании оценили как невысокую. Открытая лицензия Gemma 3 на деле является ограниченной: Google указала, для чего её разрешено использовать. Новая модель доступна, в частности, в Google Cloud. В рамках академической программы можно подать заявку на получение кредитов на сумму $10 000, если она будет использоваться в исследовательских целях. Google представила компактную языковую модель Gemma 2 2B, которая превосходит GPT 3.5 Turbo

01.08.2024 [16:36],

Николай Хижняк

Компания Google представила Gemma 2 2B — компактную, но мощную языковую модель искусственного интеллекта (LLM), которая может составить конкуренцию лидерам отрасли, несмотря на свой значительно меньший размер. Новая языковая модель, содержащая всего 2,6 миллиарда параметров, демонстрирует производительность не хуже гораздо более крупных аналогов, включая OpenAI GPT-3.5 и Mistral AI Mixtral 8x7B.

Источник изображений: Google В тесте LMSYS Chatbot Arena, популярной онлайн-платформы для сравнительного тестирования и оценки качества моделей искусственного интеллекта, Gemma 2 2B набрала 1130 баллов. Этот результат немного опережает результаты GPT-3.5-Turbo-0613 (1117 баллов) и Mixtral-8x7B (1114 баллов) — моделей, обладающих в десять раз большим количеством параметров. Google сообщает, что Gemma 2 2B также набрала 56,1 балла в тесте MMLU (Massive Multitask Language Understanding) и 36,6 балла в тесте MBPP (Mostly Basic Python Programming), что является значительным улучшением по сравнению с предыдущей версией. Gemma 2 2B бросает вызов общепринятому мнению, что более крупные языковые модели изначально работают лучше компактных. Производительность Gemma 2 2B показывает, что сложные методы обучения, эффективность архитектуры и высококачественные наборы данных могут компенсировать недостаток в числе параметров. Разработка Gemma 2 2B также подчеркивает растущую важность методов сжатия и дистилляции моделей ИИ. Возможность эффективно компилировать информацию из более крупных моделей в более мелкие открывает возможности к созданию более доступных инструментов ИИ, при этом не жертвуя их производительностью. Google обучила Gemma 2 2B на огромном наборе данных из 2 триллионов токенов, используя системы на базе своих фирменных ИИ-ускорителей TPU v5e. Поддержка нескольких языков расширяют её потенциал для применения в глобальных приложениях. Модель Gemma 2 2B имеет открытый исходный код. Исследователи и разработчики могут получить доступ к модели через платформу Hugging Face. Она также поддерживает различные фреймворки, включая PyTorch и TensorFlow. Google анонсировала Gemma 2 — открытую ИИ-модель с 27 млрд параметров

14.05.2024 [23:13],

Владимир Фетисов

Сегодня началась ежегодная конференция для разработчиков Google I/O, в рамках которой уже было представлено немало любопытных новинок, таких как серверный ИИ-процессор Trillium и генератор изображений Imagen 3. Вместе с этим разработчики анонсировали скорое появление модели искусственного интеллекта Gemma 2 с открытым исходным кодом, которая включает 27 млрд параметров. Её запуск должен состояться в июне этого года.

Источник изображения: techcrunch.com Ранее в этом году Google выпустила версии Gemma 2B и Gemma 7B с 2 млрд и 7 млрд параметров соответственно. Появление версии ИИ-модели с 27 млрд параметров можно назвать существенным продвижением в развитии этого алгоритма. Во время презентации вице-президент Google Labs Джош Вудворд (Josh Woodward) рассказал, что ИИ-модели Gemma были загружены более «миллиона раз» в разные сервисы, где и продолжают работать. Он подчеркнул, что новая версия нейросети Gemma 2 предложит лучшую в отрасли производительность в компактных размерах благодаря оптимизации для работы на графических процессорах Nvidia следующего поколения или одном хосте Google Cloud TPU в сервисе Vertex AI. Размер большой языковой модели может отойти на второй план, если окажется, что она работает не слишком качественно. Google ещё не раскрыла подробностей касательно алгоритма Gemma 2. Это означает, что оценить его качество, вероятно, можно будет только после того, как ИИ-модель попадёт в руки разработчиков. По заявлениям Google, ИИ-модель Gemma 2 превосходит в плане производительности вдвое более крупные модели. Google представила Gemma — открытую версию ИИ-модели Gemini

21.02.2024 [18:13],

Павел Котов

Google представила Gemma 2B и 7B — модели искусственного интеллекта с открытым исходным кодом, которые позволят разработчикам свободно пользоваться результатами исследований, проведённых при создании флагманской Gemini. Gemini — закрытая большая языковая модель, прямой конкурент OpenAI ChatGPT, а Gemma подойдёт для решения относительно небольших задач, таких как простые чат-боты или подготовка сводок текста.

Источник изображения: blog.google Недостаточно высокая сложность Gemma 2B и 7B может компенсироваться их более высокой скоростью работы и низкой стоимостью развёртывания. Открытые нейросети, согласно Google, «значительно превосходят более крупные модели по ключевым показателям» и «могут работать непосредственно на ноутбуке или ПК разработчика». Они появятся на платформах Kaggle, Hugging Face, NVIDIA NeMo и Google Vertex AI. Gemma будут доступны по коммерческой лицензии независимо от размера организации, числа пользователей или типа проекта, но их запрещено использовать для некоторых задач, например, для разработки оружия. Открытые модели также будут поставляться с «инструментами ответственного ИИ», поскольку внедрение ограничительных мер для них представляется более сложной задачей, чем в случае с закрытой Gemini. Разработчики смогут применять собственные политики использования Gemma и внедрять списки запрещённых слов при развёртывании моделей в собственных проектах. В комплект также включены средства отладки моделей, которые помогут в изучении их поведения и исправлении проблем. Лучше всего Gemma 2B и 7B подойдут для англоязычных задач. На платформе Kaggle их можно будет использовать бесплатно, а новые клиенты Google Cloud смогут получить скидку в $300 на развёртывание моделей — для учёных её размер может быть увеличен до $500 тыс. Закрытая модель Gemini выпускается в трёх вариантах: Gemini Nano, Gemini Pro и Gemini Ultra. Недавно также была анонсирована более быстрая Gemini 1.5, но пока только для корпоративных пользователей и разработчиков. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |