|

Опрос

|

реклама

Быстрый переход

Китайская CXMT закупила оборудование для выпуска памяти HBM, которую пока не разработала

01.02.2024 [08:20],

Алексей Разин

Попытки китайских компаний типа YMTC наладить выпуск передовой по мировым меркам памяти не ограничиваются сегментом 3D NAND. Лидирующая на местном рынке в производстве DRAM компания CXMT пытается подготовиться к началу производства памяти типа HBM, применяемой ускорителями вычислений зарубежного образца в составе систем искусственного интеллекта. При этом технологии для производства HBM компания пока даже не освоила.

Источник изображения: CXMT По информации Nikkei Asian Review, китайская компания CXMT уже заказала и начала получать оборудование для производства памяти HBM. Подобная инициатива обусловлена тем, что поставки такого оборудования пока не контролируются США и их союзниками, а потому у CXMT есть возможность приобрести его «впрок» в США и Японии, до введения возможных санкций. Компания CXMT пока что не располагает технологией производства HBM, но хочет заранее обзавестись необходимым оборудованием. С прошлого года CXMT ведёт разработку микросхем DRAM с вертикальной интеграцией, напоминающих по своей архитектуре HBM. Попутно CXMT также смогла приобрести подходящее оборудование для менее продвинутых микросхем DRAM у китайского поставщика, чтобы наладить на одном из местных предприятий выпуск довольно современной по меркам КНР оперативной памяти. Как отмечается, некоторые американские поставщики оборудования получили в середине 2023 года экспортные лицензии, позволяющие им снабжать своей продукцией CXMT. Среди них упоминаются лидеры рынка Applied Materials и Lam Research. Поставляемое ими в Китай оборудование всё равно будет соответствовать правилам экспортного контроля США, которые действуют с октября 2022 года. Основанная в 2006 году компания CXMT в прошлом году сообщила, что начала производство первой в стране памяти типа LPDDR5 для флагманских смартфонов, данная продукция прошла сертификацию компаниями Xiaomi и Transsion. Зарубежные конкуренты CXMT подобную память выпускают с 2021 года. Теоретически, CXMT по уровню своего технологического развития отстаёт от Micron или SK hynix, но опережает тайваньскую Nanya Technology. Впрочем, в масштабах мирового рынка DRAM компания CXMT всё равно по итогам прошлого года занимала менее 1 %, а на тройку лидеров в лице Samsung, SK hynix и Micron приходились 97 %. В сегменте HBM в прошлом году 92 % рынка контролировали южнокорейские SK hynix и Samsung, а поздно вышедшая на рынок Micron Technology довольствовалась 4–6 %, но демонстрировала амбиции увеличить свою долю. Выпуск HBM требует не только оборудования, способного обрабатывать кремниевые пластины, но и достаточно сложной техники для упаковки кристаллов в готовые микросхемы. Даже если CXMT и удастся наладить полноценный выпуск памяти типа HBM, как считают эксперты Counterpoint Research, она будет поставляться преимущественно на внутренний рынок. SK hynix увеличит объёмы выпуска памяти типа HBM в два раза

27.01.2024 [12:01],

Алексей Разин

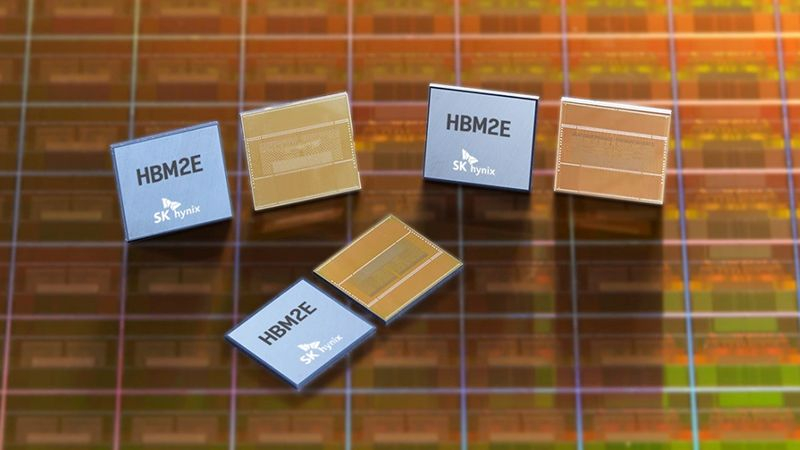

Квартальная отчётность SK hynix показала, что за предыдущие три месяца эта южнокорейская компания в пять с лишним раз увеличила объёмы выпуска памяти типа HBM, которая в своих различных разновидностях востребована в сегменте ускорителей вычислений для систем искусственного интеллекта. В текущем году SK hynix собирается увеличить объёмы производства HBM как минимум в два раза.

Источник изображения: SK hynix Об этом руководство SK hynix, как сообщает Business Korea, заявило после объявления итогов четвёртого квартала. В текущем году компания планирует более чем в два раза увеличить объёмы производства микросхем типа HBM по сравнению с прошлым годом. По оценкам аналитиков, по итогам текущего года операционная прибыль превысит $7,5 млрд, во многом благодаря высокому спросу на ускорители вычислений, которые используют память типа HBM. Если учесть, что за весь прошлый год компания выручила $24,5 млрд, то операционная прибыль в размере более $7,5 млрд в текущем году стала бы весьма достойным результатом. Прошлый квартал SK hynix впервые за четыре предыдущих периода завершила с операционной прибылью, но её величина не превысила $259 млн. Руководство SK hynix убеждено, что бум систем искусственного интеллекта позволит рынку памяти вырасти сильнее, чем это случилось в 2018 году. В текущем году рынок памяти точно будет расти, как убеждены представители компании. Ещё в прошлом квартале некоторые клиенты SK hynix начали увеличивать объёмы заказов, ожидая дальнейшего роста цен на память и рассчитывая приобрести их на более привлекательных условиях сейчас. Характерно, что в сегменте ПК и смартфонов спрос на память тоже начал расти. Уже в текущем полугодии спрос и предложение на рынке DRAM достигнут равновесия, по мнению руководства SK hynix, а на рынке NAND данное состояние будет достигнуто во втором полугодии. Рекорд по операционной прибыли SK hynix установила в 2018 году, получив более $15 млрд за период. Ожидается, что в текущем году компания получит операционную прибыль в размере $7,5 млрд, а по итогам следующего она увеличится до $11,2 млрд. В предвкушении подобной динамики SK hynix и собирается увеличить объёмы выпуска памяти типа HBM более чем в два раза в текущем году. Конкурирующая Samsung Electronics, к слову, намерена сделать примерно то же самое. Samsung кратно увеличивает инвестиции в расширение производства памяти типа HBM

24.01.2024 [12:56],

Алексей Разин

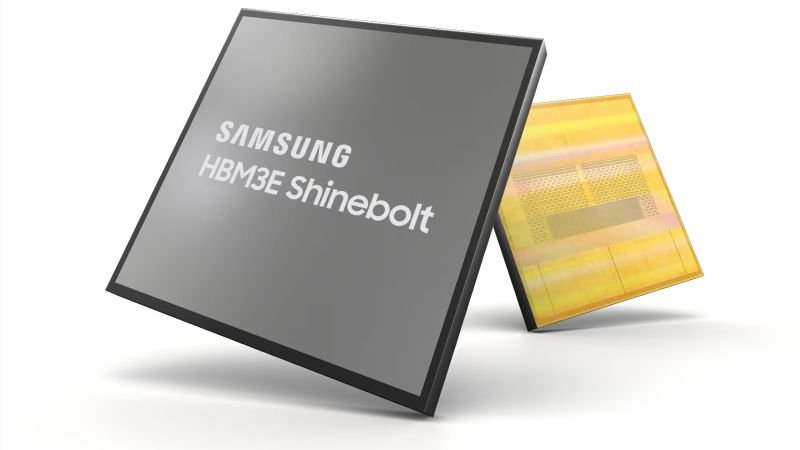

SK hynix считается старожилом рынка памяти типа HBM, поскольку начала разрабатывать её в сотрудничестве с NVIDIA ещё в 2013 году, но крупнейший производитель микросхем памяти в лице Samsung готов бросить ей вызов в данном сегменте. В этом году корейский гигант увеличит капитальные затраты на выпуск HBM более чем в два с половиной раза, в следующем году данная сумма останется на таком же уровне.

Источник изображения: Samsung Electronics К четвёртому кварталу текущего года, как отмечает Business Korea, компания Samsung Electronics собирается увеличить объёмы выпуска микросхем до 150–170 тысяч изделий в месяц. В текущем полугодии конкурирующая SK hynix начнёт выпускать микросхемы HBM3e по технологиям пятого поколения, и такая память найдёт применение в новейших ускорителях вычислений NVIDIA самое позднее в следующем году. Samsung свою память типа HBM3 четвёртого поколения выпускает с прошлого квартала, и стремится посоперничать с SK hynix за заказы NVIDIA на поставку HBM3e. Последняя из компаний уже завершила разработку HBM3e и сейчас проводит её сертификацию на соответствие требованиям NVIDIA. По некоторым оценкам, в прошлом квартале SK hynix впервые выручила от поставок HBM свыше $749 млн — для южнокорейской компании это важный психологический рубеж, поскольку он соответствует сумме в 1 трлн вон. Принято считать, что ёмкость рынка микросхем типа HBM в прошлом году приблизилась к $4 млрд, а компания SK hynix занимает на нём лидирующие позиции с долей около 20 %. Перед Samsung стоит задача поколебать позиции конкурента, поэтому она решительно вкладывается в расширение производства HBM. Продажи памяти HBM вырастут в 2,5 раза к 2025 году благодаря ИИ

23.01.2024 [11:54],

Алексей Разин

Аналитики TrendForce уже предрекали, что в натуральном выражении поставки памяти типа HBM вырастут более чем вдвое в текущем году. В свою очередь, представители Gartner ориентируются на денежный оборот этого сегмента рынка, и считают, что он удвоится в следующем году. Это будет означать, что выручка производителей памяти типа HBM вырастет с 2 до 4,98 млрд долларов — почти в два с половиной раза, если сравнивать с уровнем прошлого года.

Источник изображения: AMD Данный прогноз опубликовало тайваньское издание Business Times со ссылкой на данные Gartner. Уже в этом году на рынке появятся ускорители вычислений, использующие память типа HBM3e: компания NVIDIA представит H200 и B100, а компания AMD выведет на рынок ускорители Instinct MI300X. Поставщики памяти типа HBM3e уже готовы начать снабжать ею своих клиентов со второго квартала текущего года. Бурное развитие рынка и хорошая прибыль помогут Samsung Electronics и Micron Technology отыграть часть позиций в сегменте HBM у компании SK hynix, которая на правах старожила занимает доминирующее положение. Расширение конкуренции будет способствовать не только наращиванию объёмов поставок, но и снижению цен. Тайваньские производители в изготовлении HBM пока готовы участвовать опосредованно, хотя та же Nanya и имеет опыт выпуска такой памяти. Поставщик оборудования Licheng собирается наладить выпуск решений для тестирования и упаковки стеков памяти типа HBM, уже к концу текущего года соответствующее оборудование начнёт производиться. Компания Creative сотрудничает с TSMC и SK hynix с целью применения интерфейса GLink-2.5D, разработанного ею, при производстве микросхем памяти типа HBM3 в упаковке CoWoS. Интересуются сопутствующими технологиями и более мелкие компании. Память Micron типа HBM3E впечатлила клиентов, NVIDIA готовится её сертифицировать

28.09.2023 [08:24],

Алексей Разин

Южнокорейской компании SK hynix придётся отстаивать титул производителя самой быстрой в мире памяти типа HBM3E, поскольку этим летом компания Micron Technology объявила о разработке аналогичных микросхем со скоростью передачи информации более 1,2 Тбайт/с. Как поясняют представители американского производителя, образцы HBM3E этой марки сейчас проходят тестирование силами клиентов, а выручку от поставок серийных микросхем компания начнёт получать в следующем году.

Источник изображения: Micron Technology По имеющимся данным, память типа HBM3E в исполнении Micron обладает восьмиярусной компоновкой и объёмом 24 Гбайт на стек, при этом она выпускается по технологии 1β и обладает выдающимися показателями энергоэффективности. Во всяком случае, при том уровне быстродействия, что предлагает эта память в исполнении Micron, по словам представителей компании, она настолько экономичнее предложений конкурентов, что некоторые из получивших образцы клиентов просто не верят полученным ими результатам тестирования. Коммерческие поставки этих микросхем Micron начнёт в следующем году, а сейчас проводит процедуру сертификации этой продукции на соответствие требованиям NVIDIA. Если учесть, что память типа HBM (обобщённо) марки Samsung должна получить доступ к производственной инфраструктуре NVIDIA в этом году, то в следующем её поставщиками станут все три крупнейших производителя, включая Micron и SK hynix. Последняя в этом смысле является «старожилом» сегмента, но высокий спрос на ускорители NVIDIA явно обеспечит рынком сбыта продукцию конкурентов SK hynix. Едва выйдя на рынок памяти типа HBM3E, компания Micron уже в следующем году ожидает выручить от её реализации несколько сотен миллионов долларов США. Динамичное развитие этого сегмента рынка позволит Micron компенсировать слабый спрос на других направлениях. В следующем году компания вложит серьёзные средства в создание производственных линий по выпуску и упаковке микросхем HBM3E. Объёмы выпуска начнут наращиваться в начале следующего календарного года, и к концу августа выручка от реализации HBM3E уже достигнет значимых величин — тех самых сотен миллионов долларов США, по всей видимости. Китай разработает суверенную высокоскоростную память, похожую на HBM

31.08.2023 [10:38],

Алексей Разин

С сентября прошлого года американские санкции ограничивают поставку в Китай не только готовых компонентов типа тех же ускорителей вычислений, но и оборудования для производства передовых чипов. Китайские компании просто вынуждены искать возможности для локального выпуска многих полупроводниковых компонентов. Среди них числится и высокоскоростная память для ускорителей вычислений, которая сейчас исключительно импортируется.

Источник изображения: CXMT Для китайской полупроводниковой отрасли, как поясняет South China Morning Post, текущая ситуация на рынке не очень благоприятна. Основную часть микросхем памяти типа HBM, которая устанавливается на ускорители вычислений, по всему миру поставляют две южнокорейские компании SK hynix и Samsung Electronics. Некоторую часть памяти этого типа производит американская Micron Technology, которая в мае попала под санкции китайских властей, а потому операторы критически важной национальной инфраструктуры КНР теперь не имеют права использовать память Micron на своих объектах. По данным осведомлённых источников, китайские компании изучают возможность самостоятельного выпуска памяти, по своим свойствам приближённой к HBM. Главным кандидатом на обеспечение технологического суверенитета КНР в этой сфере является китайская компания ChangXin Memory Technologies (CXMT), считающаяся ведущим национальным производителем микросхем DRAM. По оценкам участников рынка, ей может потребоваться не менее четырёх лет, чтобы освоить выпуск памяти типа HBM или её аналогов для нужд китайского сектора систем искусственного интеллекта. Ограничения в сфере литографии, которые распространяются и на китайских производителей памяти, не слишком препятствуют выпуску HBM силами той же CXMT, но в Китае необходимо найти компанию, способную заниматься тестированием и упаковкой многоярусных чипов, к которым как раз и относится HBM всех поколений. Источники утверждают, что на роль такого технологического партнёра CXMT лучше всего годится местная компания Jiangsu Changjiang Electronics Technology. Самой CXMT сейчас доступны 17- и 19-нм техпроцессы, чего вполне достаточно для удовлетворения текущих потребностей китайской промышленности в микросхемах оперативной памяти. Спад на рынке DRAM закончился — выручка производителей оперативной памяти выросла на 20 % во втором квартале

28.08.2023 [21:32],

Сергей Сурабекянц

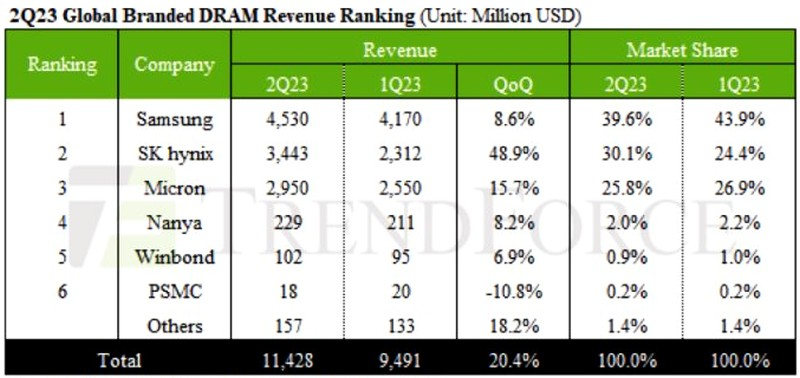

Растущий спрос на серверные системы для искусственного интеллекта привёл к росту поставок памяти HBM. В сочетании с волной наращивания запасов DDR5 на стороне клиента, второй квартал 2023 года показал рост поставок всех трёх основных крупнейших производителей оперативной памяти DRAM. Выручка индустрии за второй квартал достигла $11,43 млрд — это рост на 20,4 % по сравнению с первым кварталом и прекращение спада, продолжавшегося до этого три квартала подряд.

Источник изображения: unspalsh.com Наибольший рост квартальных поставок, более 35 %, продемонстрировала SK hynix. Поставки DDR5 и HBM с более высокой средней ценой продажи (ASP — Average Selling Price), значительно увеличились. В результате ASP выросла на 7-9 %, что привело к увеличению выручки за второй квартал 2023 года почти на 50 %. С доходом в $3,44 млрд SK hynix заняла второе место в отрасли, лидируя по темпам роста в этом секторе. Samsung, в отличие от SK hynix, показала падение ASP примерно на 7-9 %. Однако, благодаря наращиванию складских запасов клиентами и увеличению спроса на серверы искусственного интеллекта, объёмы поставок всё же немного увеличились, что привело к росту выручки за второй квартал на 8,6 % по сравнению с первым кварталом, достигнув $4,53 млрд и обеспечив компании лидирующую позицию по валовому доходу. Micron, занявшая третье место, немного задержалась с разработкой HBM. Тем не менее, поставки DDR5 составляли значительную долю, сохраняя ASP относительно стабильным. Выручка компании во втором квартале составила около $2,95 млрд, показав рост на 15,7 % по сравнению с первым кварталом. В целом, из-за продолжающегося снижения контрактных цен на различные продукты, поставщики продолжают сообщать об отрицательной рентабельности операционной прибыли. Во втором квартале 2023 года операционная рентабельность Samsung улучшилась с -24 % до -9 %. SK hynix продемонстрировала одновременный рост выручки и ASP, что повысило операционную рентабельность с -50 % до -2 %. Операционная рентабельность Micron также слегка улучшилась с -55,4 % до -36 %. Поставки Nanya снижаются уже более четыре квартала подряд. Однако благодаря заказам на телевизоры во втором квартале 2023 года выручка компании выросла примерно на 8,2 %. Выручка Winbond во втором квартале выросла на 6,9 %, в первую очередь благодаря объявлению тендеров в Китае и введённым в строй дополнительным мощностям, что обеспечило большую гибкость ценообразования и привело к увеличению заказов. PSMC в основном получает доход от потребительских продуктов DRAM собственного производства. Из-за низкого спроса и не самого современного техпроцесса, лишённого конкурентных ценовых преимуществ, выручка PSMC снизилась на 7,8 % по сравнению с первой четвертью года, сделав компанию единственным поставщиком, у которого наблюдался спад во втором квартале.

Источник изображения: Trendforce Эксперты полагают, что доходы индустрии DRAM продолжат расти в третьем квартале 2023 года. Планомерное сокращение производства поставщиками препятствует дальнейшему снижению цен. Ожидается, что убытки из-за падения цен уменьшатся, а рентабельность наконец сместится от убытков в сторону прибыли. Объёмы поставок памяти типа HBM в следующем году удвоятся, как считают аналитики TrendForce

10.08.2023 [08:26],

Алексей Разин

Специалисты TrendForce поделились собственными представлениями о тенденциях развития рынка памяти типа HBM как в этом, так и в следующем году. В этом году будет наблюдаться дефицит микросхем памяти данного типа, но в следующем объёмы поставок смогут вырасти на 105 % за счёт расширения производственных мощностей. При этом два южнокорейских производителя смогут увеличить свою долю рынка в ущерб Micron Technology.

Источник изображения: SK hynix Сейчас производители памяти типа HBM наращивают объёмы выпуска соответствующих микросхем, но линии по их упаковке в вертикальные стеки требуют от 9 до 12 месяцев на монтаж и настройку, поэтому существенного увеличения объёмов поставок готовой продукции в этой сфере не приходится ожидать ранее второго квартала следующего года. Формально, на рынке присутствуют до трёх поколений памяти одновременно: HBM/HBM2, HBM2e и HBM3. Последняя считается четвёртым поколением, и на подходе уже пятое поколение микросхем, именуемое HBM3e. Шестым же станет HBM4, над разработкой которой уже трудятся корейские компании. Если в 2022 году на долю HBM3 приходились всего 8 % мирового рынка, а HBM2e занимала внушительные 70 %, то в текущем году спрос на HBM3 со стороны производителей ускорителей вычислений позволит поднять долю этого поколения памяти до 39 %. При этом доля HBM2e снизится до 50 %. Ну, а в следующем году доля HBM3 вырастет до 60 %, а HBM2e будет занимать не более 25 % рынка. В совокупности с ростом цен это приведёт к существенному увеличению выручки производителей данных типов памяти. По итогам 2022 года компания SK hynix контролировала 50 % рынка HBM3, причём отчасти она могла благодарить за это компанию NVIDIA, которую снабжает данной памятью. Samsung Electronics довольствовалась 40 % рынка, а Micron — умеренными 10 %. Тем не менее, если в этом году SK hynix и Samsung будут стремиться к паритету на уровне 46–49 % рынка, то Micron придётся ужаться до 4–6 %. В следующем году доля последней может сократиться до 3–5 %, как считают аналитики TrendForce. Впрочем, эта американская компания сосредоточена на разработке памяти типа HBM3e, а потому может отыграться в будущем. Такую память, в частности, будут использовать представленные недавно NVIDIA ускорители вычислений GH200, поставки которых начнутся во втором квартале. Как считают эксперты, цены на микросхемы HBM2 и HBM2e могут снизиться по итогам текущего года, поскольку они в меньшей степени востребованы рынком, чем HBM3. Высокий спрос на последний тип памяти в сочетании с высокими ценами будет способствовать росту выручки производителей HBM на 127 % до $8,9 млрд по итогам следующего года. В натуральном выражении объёмы поставок памяти вырастут на 105 %. NVIDIA поручит Samsung упаковку чипов для ИИ-ускорителей и будет покупать у неё память HBM3

02.08.2023 [12:29],

Павел Котов

Samsung Electronics обеспечит компании NVIDIA поставку высокопроизводительных полупроводниковых компонентов и услуги по упаковке чипов. Сотрудничество с таким партнёром поможет корейскому электронному гиганту обеспечить себя заказами и от других технологических компаний.

Источник изображений: semiconductor.samsung.com Samsung и NVIDIA сейчас проводят технологическую проверку стеков памяти HBM3 (High Bandwidth Memory) от Samsung, а также качества услуг по упаковке чипов для графических процессоров американской компании, сообщает Korea Economic Daily со ссылкой на собственный источник из Сеула. По завершении работ Samsung будет осуществлять упаковку чипов H100, составляющих основу ускорителей NVIDIA для систем искусственного интеллекта, а также станет поставщиком стеков памяти HBM3 для этих ускорителей. Соглашение будет заключено в конце года. Упаковка — один из последних этапов производства полупроводников. Она предполагает размещение микросхемы на подложке из текстолита со всеми контактами и интерфейсами, необходимыми для работы чипа и его подключения к другим компонентам системы. NVIDIA традиционно полагалась на TSMC, которая производит упаковку чипов с использованием собственной технологии; память HBM3 для ускорителей выпускала SK hynix. Но в связи с высоким спросом на компоненты для ИИ, а также загруженностью линий TSMC американский производитель был вынужден искать альтернативное предложение, которое ей обеспечила Samsung. В рамках нового партнёрства корейская компания может получить заказ и на производство самих графических процессоров NVIDIA, но пока речь только о поставках памяти и упаковке чипов. Все больше технологических компаний могут начать обращаться в Samsung в связи с загруженностью упаковочных линий TSMC, утверждает источник издания.  Крупнейшие мировые полупроводниковые подрядчики в лице Samsung, TSMC и Intel жёстко конкурируют на рынке передовых технологий упаковки, позволяющих объединять разнородные компоненты или вертикально соединять несколько микросхем. В 2021 году мировой рынок этого сегмента составлял $37,4 млрд, а к 2027 году он может вырасти на 74 % до $65 млрд. Сегодня отрасль сосредоточен на технологии 2.5D, предполагающей симбиоз графических процессоров и памяти HBM, которая в 10 раз быстрее DRAM. Мировым лидером является TSMC, которая вот уже шесть лет работает над технологией 2.5D — недавно компания сообщила, что планирует инвестировать 90 млрд тайваньских долларов ($2,9 млрд) в новый завод по производству упаковки на Тайване. В 2021 году компания представила технологию 2.5D I-Cube: во II квартале 2024 года стартует массовое производство компонентов I-Cube4 с графическим процессором и четырьмя чипами HBM, а в III квартале настанет черёд I-Cube8 с восемью чипами HBM. Samsung же стремится сделать своей сильной стороной предложение упаковки «под ключ», способное привлечь крупные технологические компании. Корейский производитель начал оказывать услугу, охватывающую весь процесс выпуска полупроводников: поставки чипов памяти, упаковку и тестирование — это поможет компании стать привлекательной альтернативой TSMC в условиях интенсивного роста отрасли ИИ. Спрос на услугу «под ключ» будет расти, помогая клиентам экономить время и деньги, а не привлекать подрядчиков для каждой услуги. Кроме того, Samsung и её местный конкурент SK hynix планируют значительно расширить линии производства памяти типа HBM — к концу 2024 года они планируют вложить в это направление более 2 трлн вон ($1,56 млрд), что поможет более чем вдвое увеличить производственную мощность линий HBM. Пока рынок DRAM пытается выйти из пике, спрос на HBM продолжает демонстрировать положительную динамику: в 2022 году он был 181 млн Гбайт; в 2023 году может подскочить на 60 % до 290 млн Гбайт, а в 2024 году может вырасти ещё на 30 % в годовом исчислении, подсчитали аналитики TrendForce. Доля HBM в выручке рынка оперативной памяти вырастет в четыре раза к 2026 году

07.07.2023 [12:53],

Алексей Разин

По мнению многих аналитиков, индустрия памяти может быстрее выйти из текущего кризиса перепроизводства за счёт активно растущего спроса на микросхемы типа HBM со стороны производителей компонентов для систем искусственного интеллекта. Сейчас память данного типа определяет не более 5 % всей выручки в отрасли, но уже к 2026 году эта доля может вырасти до 20 %.

Источник изображения: SK hynix Такими прогнозами делятся с The Wall Street Journal аналитики SemiAnalysis. По их данным, микросхемы типа HBM в среднем в пять раз дороже стандартных DRAM, поэтому в показателях выручки они достаточно быстро смогут нарастить свой удельный вес, даже если динамика натуральных показателей будет изменяться умеренными темпами. По данным TrendForce, в прошлом году примерно половину рынка памяти типа HBM контролировала южнокорейская компания SK hynix, она являлась основным поставщиком соответствующих микросхем для нужд NVIDIA, которая лидирует в сегменте ускорителей вычислений для систем искусственного интеллекта. На долю Samsung Electronics приходилось 40 % сегмента, а поздно вступившая на рынок Micron Technology довольствовалась 10 %. На апрельской отчётной конференции руководство SK hynix заявило, что в 2023 году выручка компании от реализации микросхем HBM вырастет более чем на 50 % по сравнению с прошлым годом. Samsung тоже рассчитывает заработать на буме ИИ с точки зрения поставок микросхем памяти. Аналитики Citi добавили, что доля используемой в системах ИИ оперативной памяти к 2025 году вырастет с текущих 16 до 41 %, поэтому данный сегмент рынка начнёт существенно влиять на выручку поставщиков памяти. Впрочем, в краткосрочной перспективе данный фактор не способен исправить ситуацию с перепроизводством микросхем памяти, поэтому многие производители сталкиваются с существенными убытками и сокращают объёмы выпуска продукции до рекордно низких величин. Японцы в четыре раза ускорили память HBM — они просто выбросили из чипов «лишние» контакты

06.07.2023 [14:00],

Геннадий Детинич

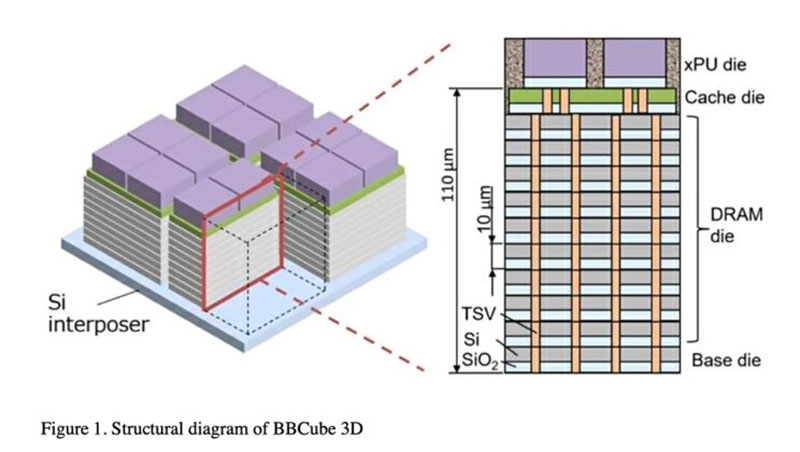

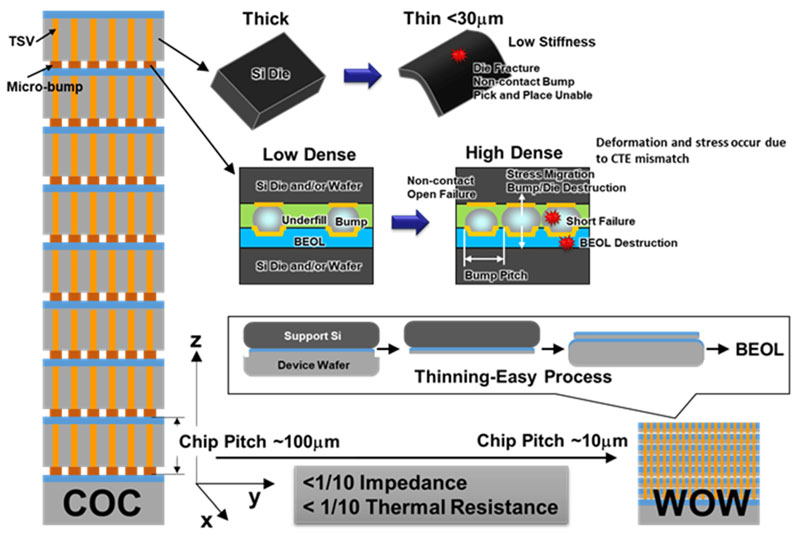

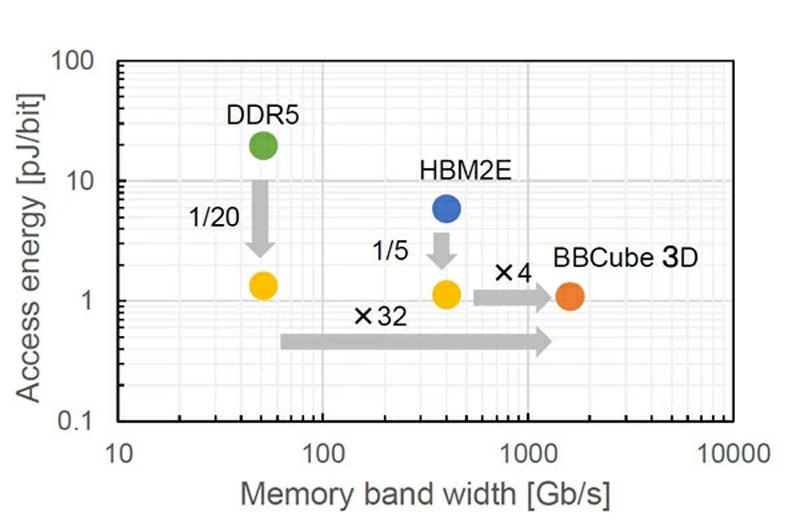

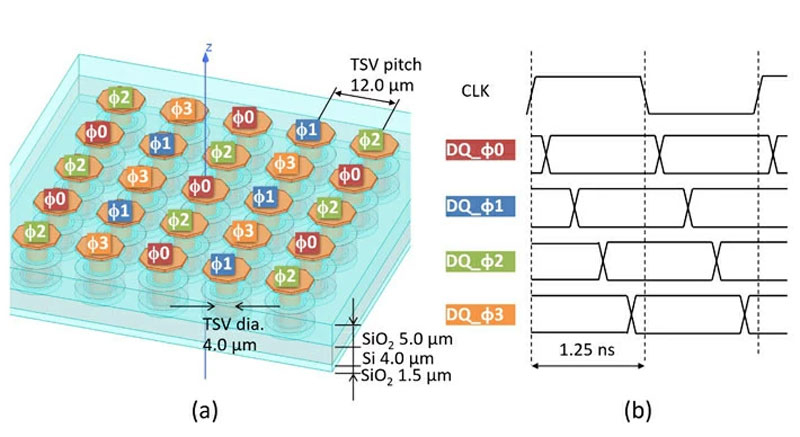

Ученые Токийского технологического института представили вариант стековой оперативной памяти, который в четыре раза быстрее памяти HBM2E и при этом потребляет в пять раз меньше энергии. Новый вариант памяти назвали Bumpless Build Cube 3D (BBCube) за отсутствие в его основе традиционных массивов шариковых контактов для послойной пайки кристаллов.

Источник изображений: Tokyo Institute of Technology Решение было представлено на симпозиуме VLSI IEEE 2023 в июне 2023 года. Японские исследователи не просто предложили концепцию, они представили детальное описание техпроцесса для изготовления такой памяти. Память HBM, как известно, помогает обойти ряд ограничений на работу с блоком ОЗУ специализированного, центрального и графического процессора. Это ограничения на доступный процессору объём оперативной памяти, что обходит стековая архитектура HBM, а также ограничения на пропускную способность, что тоже решается стеком и структурной организацией HBM. В то же время современный подход к сборке стеков HBM накладывает свои ограничения на возможности этой памяти. Каждый слой (кристалл DRAM) в стеке нельзя сделать тоньше определённой величины и нельзя увеличить количество межслойных контактов-шариков выше определённого значения. В противном случае это грозит механическими повреждениями и коротким замыканием. Проще говоря, увеличивает уровень брака, что никому не нужно.  Японцы предложили выбросить из техпроцесса сборки стека DRAM шарики-контакты. Это даст целый ряд преимуществ: кристаллы станут тоньше, поскольку уменьшатся механические напряжения в слоях, линии сквозных соединений TSVs станут короче (это позволит чипам лучше охлаждаться за счёт более высокой плотности TSVs на объём кристаллов — это будут своего рода тепловые трубки), стеки будут укрупняться, что позволит увеличить объём отдельных модулей до 64 Гбайт при использовании 16-Гбит кристаллов (в теории допустимо собирать до 40 кристаллов в стеке). Профессор Такаюки Охба (Takayuki Ohba), руководитель исследовательской группы, сказал: «BBCube 3D имеет потенциал для достижения пропускной способности в 1,6 терабайт в секунду, что в 30 раз выше, чем у DDR5 и в четыре раза выше, чем у HBM2E».  Проблему взаимных помех в сильно уплотнённых линиях TSVs-соединений предложено решить за счёт управления фазами сигналов в соседних линиях. Управляющий сигнал в определённой линии ввода-вывода никогда не возникнет, пока активны соседние линии.  Охба добавил: «Благодаря низкому тепловому сопротивлению и низкому импедансу BBCube, проблемы терморегулирования и питания, характерные для 3D-интеграции, могут быть сняты. В результате, предложенная технология может достичь потрясающей пропускной способности с энергией доступа к битам, которая составит 1/20 и 1/5 от DDR5 и HBM2E, соответственно». SK hynix захватит больше половины рынка памяти HBM в 2023 году благодаря ИИ-буму

18.04.2023 [13:13],

Владимир Фетисов

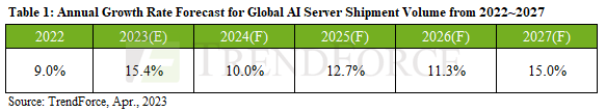

Высокий уровень спроса на ИИ-серверы стимулировал спрос на оперативную память с высокой пропускной способностью (HBM). По данным TrendForce, основными поставщиками памяти HBM в 2022 году стали SK hynix (50 % рынка), Samsung (40 % рынка) и Micron (10 % рынка). Аналитики считают, что по итогам нынешнего года южнокорейская SK hynix займёт больше половина глобального рынка HBM.

Источник изображения: SK hynix Во второй половине 2023 года начнётся производство серверных ускорителей NVIDIA H100 и AMD MI300 с памятью HBM3. В настоящее время только SK hynix запустила серийное производство памяти этого типа. Аналитики считают, что по итогам всего года это поможет южнокорейскому производителю увеличить долю рынка до 53 %. Ожидается, что Samsung и Micron начнут выпускать память HBM3 в конце этого или начале следующего года. По прогнозам аналитиков, доля этих компаний на рынке по итогам года составит 38 % и 9 % соответственно. Аналитики TrendForce прогнозируют, что объём поставок ИИ-серверов увеличится на 15,4 % в 2023 году. Более того, в период с 2023 по 2027 годы прогнозируется 12,2 % годовой рост поставок ИИ-серверов. Этому будет способствовать запуск сервисов и услуг на основе генеративных нейросетей. Ожидается, что спрос на ИИ-серверы будут поддерживать крупные поставщики облачных услуг, такие как Google, Amazon, Meta✴ и Microsoft, а также IT-гиганты, занимающиеся разработкой сервисов на основе ИИ, такие как Microsoft, Meta✴, Baidu, ByteDance и др.

Источник изображения: TrendForce В сообщении TrendForce отмечается, что рост спроса на ИИ-серверы стимулирует продажи серверной памяти DRAM, SSD и HBM. В то время как серверы общего назначения обычно имеют 500-600 Гбайт памяти DRAM, ИИ-серверы требуют значительно больших объёмов — в среднем 1,2-1,7 Тбайт памяти. Для твердотельных накопителей корпоративного уровня приоритет по-прежнему отдаётся памяти DRAM и HBM, но пока не наблюдается значительного толчка в плане увеличения ёмкости SSD. С точки зрения интерфейса, PCIe 5.0 является более предпочтительным, когда речь идёт об удовлетворении потребностей высокопроизводительных вычислений. Поскольку ИИ-серверы становятся более сложными, спрос на серверную память DRAM, SSD и HBM продолжит расти. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |