|

Опрос

|

реклама

Быстрый переход

SK hynix вынуждена искать внутренние кадровые резервы для увеличения объёмов выпуска памяти типа HBM

27.08.2023 [07:45],

Алексей Разин

Память типа HBM в своём актуальном поколении (HBM3) весьма востребована рынком, поскольку используется при изготовлении популярных ускорителей вычислений NVIDIA для систем искусственного интеллекта, а южнокорейская SK hynix как раз является главным партнёром NVIDIA в этой сфере. Для ряда технологических операций по выпуску HBM компании SK hynix придётся переквалифицировать часть собственных сотрудников.

Источник изображения: SK hynix Информация о соответствующей потребности появилась на уходящей неделе на страницах корейского ресурса Business Korea. Подразделение WLP компании SK hynix, которое специализируется на тестировании и упаковке микросхем памяти, недавно решило усилить штат специалистов по технологиям тестирования и упаковки за счёт сотрудников других подразделений компании, предложив кандидатам на релокацию программу профессиональной переподготовки. Речь, как подчёркивается, идёт не о рабочих, а об инженерных специалистах, поэтому их количество измеряется лишь десятками человек. По замыслу SK hynix, подобный кадровый манёвр позволит укрепить компетенции компании в сфере разработки новых передовых методов упаковки, позволив сохранить темпы технического прогресса в сфере разработки новых видов продукции в этом сегменте рынка. Буквально недавно компания заявила об удачной разработке самой быстрой памяти типа HBM3e в мире. Возможность оставаться лидером будет определяться наличием адекватного кадрового потенциала, поэтому искать таланты компания не стесняется и внутри своего штата. Объёмы поставок памяти типа HBM в следующем году удвоятся, как считают аналитики TrendForce

10.08.2023 [08:26],

Алексей Разин

Специалисты TrendForce поделились собственными представлениями о тенденциях развития рынка памяти типа HBM как в этом, так и в следующем году. В этом году будет наблюдаться дефицит микросхем памяти данного типа, но в следующем объёмы поставок смогут вырасти на 105 % за счёт расширения производственных мощностей. При этом два южнокорейских производителя смогут увеличить свою долю рынка в ущерб Micron Technology.

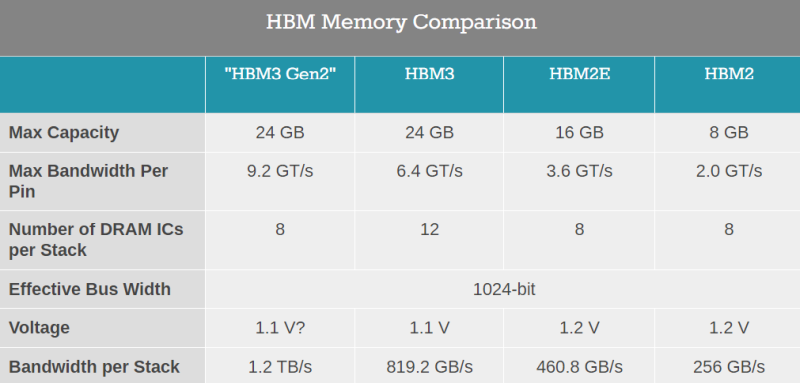

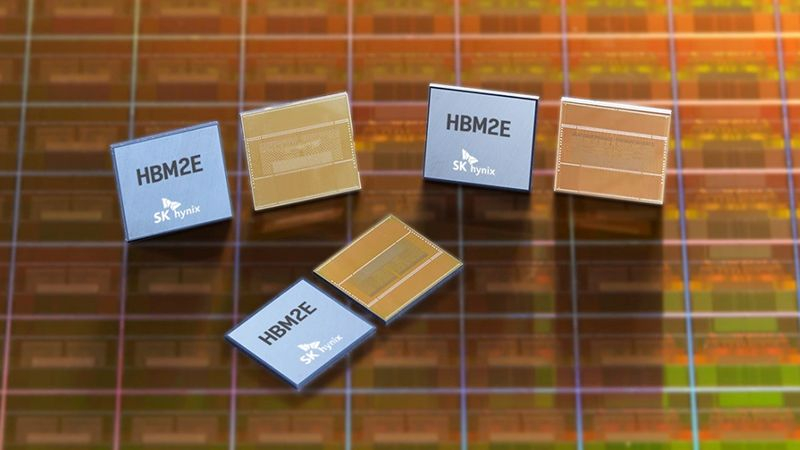

Источник изображения: SK hynix Сейчас производители памяти типа HBM наращивают объёмы выпуска соответствующих микросхем, но линии по их упаковке в вертикальные стеки требуют от 9 до 12 месяцев на монтаж и настройку, поэтому существенного увеличения объёмов поставок готовой продукции в этой сфере не приходится ожидать ранее второго квартала следующего года. Формально, на рынке присутствуют до трёх поколений памяти одновременно: HBM/HBM2, HBM2e и HBM3. Последняя считается четвёртым поколением, и на подходе уже пятое поколение микросхем, именуемое HBM3e. Шестым же станет HBM4, над разработкой которой уже трудятся корейские компании. Если в 2022 году на долю HBM3 приходились всего 8 % мирового рынка, а HBM2e занимала внушительные 70 %, то в текущем году спрос на HBM3 со стороны производителей ускорителей вычислений позволит поднять долю этого поколения памяти до 39 %. При этом доля HBM2e снизится до 50 %. Ну, а в следующем году доля HBM3 вырастет до 60 %, а HBM2e будет занимать не более 25 % рынка. В совокупности с ростом цен это приведёт к существенному увеличению выручки производителей данных типов памяти. По итогам 2022 года компания SK hynix контролировала 50 % рынка HBM3, причём отчасти она могла благодарить за это компанию NVIDIA, которую снабжает данной памятью. Samsung Electronics довольствовалась 40 % рынка, а Micron — умеренными 10 %. Тем не менее, если в этом году SK hynix и Samsung будут стремиться к паритету на уровне 46–49 % рынка, то Micron придётся ужаться до 4–6 %. В следующем году доля последней может сократиться до 3–5 %, как считают аналитики TrendForce. Впрочем, эта американская компания сосредоточена на разработке памяти типа HBM3e, а потому может отыграться в будущем. Такую память, в частности, будут использовать представленные недавно NVIDIA ускорители вычислений GH200, поставки которых начнутся во втором квартале. Как считают эксперты, цены на микросхемы HBM2 и HBM2e могут снизиться по итогам текущего года, поскольку они в меньшей степени востребованы рынком, чем HBM3. Высокий спрос на последний тип памяти в сочетании с высокими ценами будет способствовать росту выручки производителей HBM на 127 % до $8,9 млрд по итогам следующего года. В натуральном выражении объёмы поставок памяти вырастут на 105 %. Micron представила память HBM3 Gen2 с пропускной способностью 1,2 Тбайт/с — на 44 % быстрее обычной HBM3

26.07.2023 [19:37],

Сергей Сурабекянц

Сегодня Micron представила свои первые чипы памяти с высокой пропускной способностью HBM3, ориентированные на высокопроизводительные системы. Micron стала последним из крупных производителей памяти, освоивших производство HBM3. Стремясь наверстать упущенное, Micron сразу начнёт выпуск ускоренной версии памяти HBM3 Gen2. Массовое производство новых стеков памяти, предназначенных в первую очередь для центров обработки данных, стартует в начале 2024 года.

Источник изображений: Micron Стеки Micron HBM3 Gen2 ёмкостью 24 Гбайт созданы путём штабелирования восьми кристаллов памяти (8-Hi) ёмкостью 24 Гбит, изготовленных с использованием техпроцесса 1β. Для сравнения, SK hynix набирает свои 24-гигабайтные стеки из 16-гигабитных кристаллов в конфигурации 12-Hi. Таким образом, Micron может стать первым поставщиком, предлагающим чипы HBM3 ёмкостью 24 Гбайт в более типичной конфигурации 8-Hi. А в следующем году компания планирует представить 36-гигабайтные стеки HBM3 Gen2 с ещё большей ёмкостью. Теоретическая скорость передачи данных HBM3 Gen2 может достигать 9,2 ГТ/с (гигатрансфер в секунду), что на 44 % превышает базовую спецификацию HBM3, и на 15 % превосходит 8 ГТ/с — скорость конкурирующей памяти SK hynix HBM3E. Пиковая пропускная способность каждого стека HBM3 Gen2 составляет 1,2 Тбайт/с.  Micron заявляет, что использование её 24-гигабайтных стеков HBM3 Gen2 обеспечит пропускную способность 4,8 Тбайт/с в 4096-битных подсистемах памяти (четыре стека) и 7,2 Тбайт/с в 6096-битных (шесть стеков). Для сравнения: пиковая пропускная способность памяти у ускорителя NVIDIA H100 SXM составляет 3,35 Тбайт/с. Micron в своих новых стеках памяти увеличила количество сквозных соединений Through Silicon Via (TSV) в два раза по сравнению с продуктами HBM3 других поставщиков и сократила расстояние между кристаллами DRAM. Эти два изменения в упаковке уменьшили тепловое сопротивление чипов памяти и облегчили их охлаждение. Кроме того, увеличение количества TSV сулит и другие преимущества — рост пропускной способности, снижение задержек, повышение энергоэффективности и масштабируемости благодаря распараллеливанию передачи. Это также повышает надёжность, смягчая последствия сбоев за счёт перенаправления данных. Однако эти преимущества сопряжены с повышенной сложностью производства и потенциально более высоким уровнем брака. Как и другая память HBM3, стеки HBM3 Gen2 от Micron поддерживают коррекцию ошибок ECC Reed-Solomon, мягкое восстановление ячеек памяти, жёсткое восстановление ячеек памяти, а также автоматическую проверку ошибок и поддержку очистки. Помимо высоких частот, стеки Micron HBM3 Gen2 полностью совместимы с современным оборудованием, использующим HBM3. Micron планирует начать массовое производство своих 24-гигабайтных стеков HBM3 в первом квартале 2024 года, а серийный выпуск 36-гигабайтных стеков HBM3 должен стартовать во второй половине 2024 года. На сегодняшний день JEDEC ещё не утвердил спецификации для HBM3 со скоростью выше 6,4 ГТ/с, поэтому память Micron HBM3 Gen2, как и конкурирующая память SK hynix HBM3E на данный момент превышают требования стандарта. Но эксперты не сомневаются, что он будет скорректирован, расходясь в предположениях о новом наименовании. Micron также сообщила, что уже работает над памятью HBMNext. Это новое поколение памяти должно обеспечить полосу пропускания от 1,5 Тбайт/с до более чем 2 Тбайт/с на стек при ёмкости от 36 до 64 Гбайт. Доля HBM в выручке рынка оперативной памяти вырастет в четыре раза к 2026 году

07.07.2023 [12:53],

Алексей Разин

По мнению многих аналитиков, индустрия памяти может быстрее выйти из текущего кризиса перепроизводства за счёт активно растущего спроса на микросхемы типа HBM со стороны производителей компонентов для систем искусственного интеллекта. Сейчас память данного типа определяет не более 5 % всей выручки в отрасли, но уже к 2026 году эта доля может вырасти до 20 %.

Источник изображения: SK hynix Такими прогнозами делятся с The Wall Street Journal аналитики SemiAnalysis. По их данным, микросхемы типа HBM в среднем в пять раз дороже стандартных DRAM, поэтому в показателях выручки они достаточно быстро смогут нарастить свой удельный вес, даже если динамика натуральных показателей будет изменяться умеренными темпами. По данным TrendForce, в прошлом году примерно половину рынка памяти типа HBM контролировала южнокорейская компания SK hynix, она являлась основным поставщиком соответствующих микросхем для нужд NVIDIA, которая лидирует в сегменте ускорителей вычислений для систем искусственного интеллекта. На долю Samsung Electronics приходилось 40 % сегмента, а поздно вступившая на рынок Micron Technology довольствовалась 10 %. На апрельской отчётной конференции руководство SK hynix заявило, что в 2023 году выручка компании от реализации микросхем HBM вырастет более чем на 50 % по сравнению с прошлым годом. Samsung тоже рассчитывает заработать на буме ИИ с точки зрения поставок микросхем памяти. Аналитики Citi добавили, что доля используемой в системах ИИ оперативной памяти к 2025 году вырастет с текущих 16 до 41 %, поэтому данный сегмент рынка начнёт существенно влиять на выручку поставщиков памяти. Впрочем, в краткосрочной перспективе данный фактор не способен исправить ситуацию с перепроизводством микросхем памяти, поэтому многие производители сталкиваются с существенными убытками и сокращают объёмы выпуска продукции до рекордно низких величин. SK hynix запустила производство чипов DDR5 по пятому поколению 10-нм техпроцесса

30.05.2023 [14:33],

Матвей Филькин

SK hynix объявила сегодня о завершении разработки самой передовой в отрасли технологии изготовления памяти 1b нм — пятого поколения 10-нм технологического процесса. Вместе с Intel компания уже начала проверку новых модулей DDR5, предназначенных для платформ Intel Xeon Scalable. Новый техпроцесс 1b нм будет использоваться для производства как серверной, так и потребительской памяти DDR5, а позднее для HBM3E и других видов памяти. Поступить в массовое производство чипы DDR5, произведённые по технологии 1b нм, должны во второй половине года.  Источник изображений: SK hynix SK hynix ожидает, что с валидацией DDR5-памяти на базе 1b-нм технологического процесса проблем не возникнет. Согласно пресс-релизу, оперативная память DDR5 на новых чипах сразу обеспечит скорость передачи данных 6,4 Гбит/с, и это на 33 % лучше, чем у DDR5-продуктов прошлого поколения. Что ещё более важно, память DDR5, изготовленная по нормам 1b нм, будет потреблять на 20 % меньше энергии, чем более ранние продукты. Это связано с тем, что в техпроцессе используется материал с высокой диэлектрической проницаемостью, который снижает токи утечки и улучшает ёмкостные характеристики ячеек, отмечает компания. SK hynix также подтвердила, что техпроцесс нового поколения будет использоваться и для производства HBM3E-памяти. Он позволит поднять скорость обработки данных до 8 Гбит/с на контакт, что на 25 % лучше, чем у HBM3, и в 8 раз лучше, чем у памяти HBM первого поколения. Чипы для HBM3E должны поступить в массовое производство в 2024 году.  Компания подчеркнула, что разработка новейшей технологии 1b нм позволит компании обеспечить своих клиентов продуктами DRAM, обладающими как высокой производительностью, так и эффективностью. Это позволит ей и дальше удерживать лидерство среди производителей модулей памяти. Напомним, недавно о переходе на новую технологию производства памяти объявила Samsung. Компания заявила о запуске массового производства 16-гигабитных чипов оперативной памяти DDR5 на базе технологического процесса 12-нм класса. SK hynix представила первые в мире 12-слойные стеки памяти HBM3 объёмом 24 Гбайт

20.04.2023 [14:17],

Николай Хижняк

Компания SK hynix представила первые в индустрии стеки высокоскоростной памяти HBM3, состоящие из 12 микросхем. Они обладают объёмом 24 Гбайт. Производитель отмечает, что уже начал рассылать образцы новых стеков своим партнёрам для тестов.

Источник изображений: SK hynix «Компания разработала новые 24-гигабайтные чипы памяти HBM3, ёмкость которых на 50 % больше, чем у предыдущего продукта, чьи массовые поставки начались в июне прошлого года. Мы сможем начать поставки новых чипов памяти во второй половине текущего года и будем готовы обеспечить спрос на высокоскоростную память на фоне роста популярности технологий специальных чат-ботов на базе ИИ», — говорится в пресс-релизе производителя.  Для производства 12-слойных стеков памяти HBM3 объёмом 24 Гбайт компания SK hynix применяет технологию Advanced Mass Reflow Molded Underfill, представляющую собой метод объединения нескольких чипов памяти на одной подложке посредством спайки, а также технологию сквозных соединений Through Silicon Via (TSV). Она позволяет сократить толщину одного стека памяти на 40 % и в итоге получить чип такой же высоты, как и у 16-гигабайтных стеков HBM3. SK hynix представила первое поколение высокоскоростной памяти HBM в 2013 году. Эти микросхемы памяти чаще всего используются в системах для высокопроизводительных вычислений (HPC). Новейший стандарт памяти HBM3 считается наиболее оптимальным решением для быстрой обработки больших объёмов данных и поэтому пользуется высоким спросом со стороны ведущих технологических компаний. Оценка производительности новых 12-слойных стеков высокоскоростной памяти HBM3 объёмом 24 Гбайт продолжается. В то же время компания отмечает, что заинтересованные в новом продукте клиенты уже получили его образцы. |