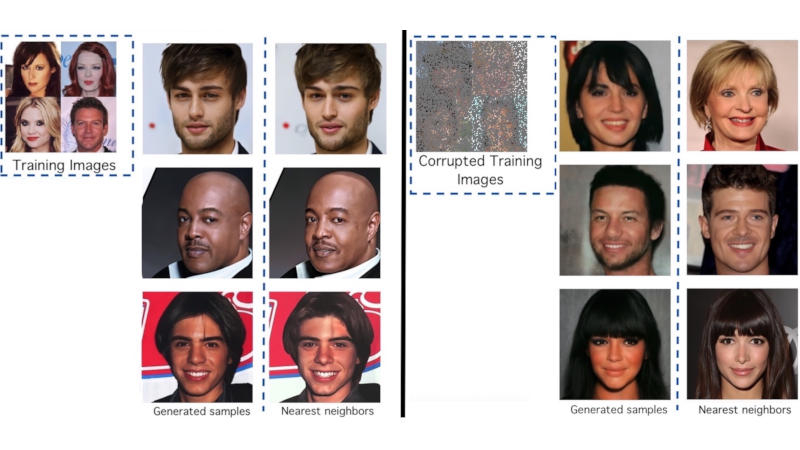

Модели искусственного интеллекта, которые генерируют картинки по текстовому описанию, при обучении на оригинальных изображениях могут их «запоминать», поднимая таким образом вопрос о нарушении авторских прав. Для защиты от претензий со стороны правообладателей была разработана система Ambient Diffusion для обучения моделей ИИ только на повреждённых данных.

Источник изображения: github.com/giannisdaras

Диффузионные модели — передовые алгоритмы машинного обучения, которые генерируют высококачественные объекты, постепенно добавляя шум в набор данных, а затем обращая этот процесс вспять. Как показали исследования, такие модели способны запоминать образцы из обучающего массива. Эта особенность может иметь неприятные последствия в аспектах конфиденциальности, безопасности и авторских прав. К примеру, если ИИ обучается работе с рентгеновскими снимками, он не должен запоминать изображения конкретных пациентов.

Чтобы избежать этих проблем, исследователи из Техасского университета в Остине и Калифорнийского университета в Беркли разработали фреймворк Ambient Diffusion для обучения диффузионных моделей ИИ только на изображениях, которые были повреждены до неузнаваемости — так практически обнуляется вероятность, что ИИ «запомнит» и воспроизведёт оригинальную работу.

Чтобы подтвердить свою гипотезу, учёные обучили модель ИИ на 3000 изображений знаменитостей из базы CelebA-HQ. При получении запроса эта модель начинала генерировать изображения, почти идентичные оригинальным. После этого исследователи переобучили модель, использовав 3000 изображений с сильными повреждениями — маскировке подверглись до 90 % пикселей. Тогда она начала генерировать реалистичные человеческие лица, которые сильно отличались от оригинальных. Исходные коды проекта его авторы опубликовали на GitHub.

Источник:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018

Подписаться

Подписаться