|

Опрос

|

реклама

Быстрый переход

Google раскрыла цену генерации видео в Veo 2 — в 64 000 раз дешевле «Мстителей»

24.02.2025 [14:44],

Владимир Фетисов

Компания Google без лишнего шума раскрыла стоимость использования своей новой генеративной нейросети Veo 2, которая предназначена для создания видео и была впервые анонсирована в декабре. Стоимость генерации видео с помощью ИИ-алгоритма составит $0,5 за секунду.

Источник изображения: Google Это означает, что минута сгенерированного с помощью Veo 2 видео будет стоить $30, а за час придётся заплатить $1800. В подразделении Google DeepMind, занимающемся разработками в сфере искусственного интеллекта, эти цифры сравнили с блокбастером Marvel «Мстители: Финал», производственный бюджет которого составил $356 млн, т.е. примерно $32 000 за секунду видео. Конечно, пользователи Veo 2 не обязательно будут использовать каждую секунду сгенерированного алгоритмом видео, за которую они заплатят. Кроме того, в обозримом будущем нейросеть вряд ли сможет создать что-то подобное блокбастерам Marvel. В сообщении Google сказано, что алгоритм может генерировать видео продолжительностью более двух минут. Отметим, что OpenAI недавно сделала доступным свой ИИ-генератор видео Sora для подписчиков ChatGPT Pro, которые платят $200 в месяц. В YouTube появился ИИ-генератор полноценных роликов по текстовому описанию — их можно будет публиковать в Shorts

13.02.2025 [22:57],

Владимир Фетисов

На платформе YouTube появилась новая функция на основе искусственного интеллекта. Она предназначена для генерации небольших роликов, которые пользователи могут публиковать в Shorts. Речь идёт об инструменте YouTube Dream Screen, который построен на базе Google Veo 2. Эта функция и раньше позволяла генерировать ролики на основе текстового описания, но прежде пользователи могли лишь задействовать их в качестве фона.

Источник изображения: Copilot Теперь же созданные с помощью Dream Screen видео можно публиковать в своём аккаунте в Shorts. Чтобы опробовать новые возможности пользователю нужно активировать камеру в Shorts, запустить функцию Dream Screen, открыть панель выбора медиафайлов и нажать на кнопку «Создать». После этого можно ввести текстовое описание будущего ролика, а также выбрать один из доступных стилей, объективов, кинематографических эффектов и указать продолжительность видео. По словам представителей YouTube, возможность публиковать сгенерированные ИИ ролики в Shorts на этой неделе появится у пользователей платформы из США, Канады, Австралии и Новой Зеландии. Позднее она также станет доступна в других странах, но более точные сроки озвучены не были. Это обновление стало несколько неожиданным, учитывая, что последняя версия нейросети Google Veo всё ещё находится в раннем доступе. По данным YouTube, интеграция нейросети с функцией Dream Screen позволит быстрее генерировать более «детальные и реалистичные» видео с учётом физики реального мира и естественных движений людей. При этом созданные с помощью ИИ видео будут помечаться, как видимыми визуальными метками, так и невидимыми водяными знаками Google SynthID, указывающими на то, что ролик создан или изменён с помощью нейросети. YouTube добавил в Shorts функцию Dream Screen — ИИ-генератор фонов для роликов

22.11.2024 [16:25],

Павел Котов

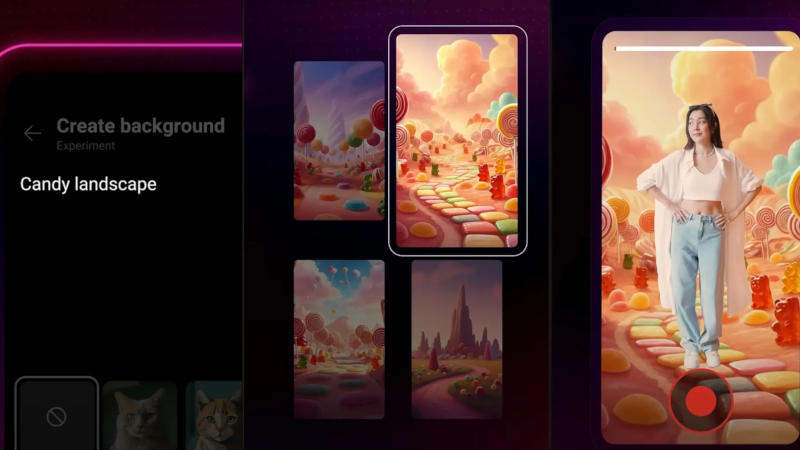

Администрация YouTube объявила, что в разделе коротких вертикальных роликов Shorts теперь доступна обновлённая функция Dream Screen — генерация динамических фоновых изображений с использованием искусственного интеллекта. Ранее функция Dream Screen позволяла генерировать в качестве фонов не видео, а неподвижные картинки.

Источник изображения: YouTube Новая возможность появилась благодаря интеграции модели для генерации видео Google DeepMind Veo — она позволяет создавать ролики с разрешением 1080p в разных кинематографических стилях. Чтобы запустить новую функцию, необходимо перейти в камеру Shorts, выбрать значок «Зелёный экран» и опцию Dream Screen — здесь можно ввести текстовый запрос, например, «пейзаж из конфет» или «волшебный лес и ручей»; после чего останется выбрать стиль анимации и нажать кнопку «Создать». Dream Screen создаст несколько видеофонов, из которых нужно выбрать один, после чего можно записывать видео с этим изображением позади себя. Новая функция пригодится, например, чтобы погрузить зрителя в атмосферу любимой книги или подготовить анимированное вступление к основному ролику. В перспективе YouTube планирует предоставить авторам возможность создавать 6-секундные видеоролики, полностью сгенерированные Dream Screen. Крупнейшая в мире платформа коротких видео TikTok также поддерживает создание фоновых изображений с помощью ИИ, но эти картинки пока статические. Воспользоваться обновлённым вариантом Dream Screen могут пользователи YouTube из США, Канады, Австралии и Новой Зеландии. Adobe интегрировала ИИ-генератор видео Firefly Video Model в редактор Premiere Pro

15.10.2024 [00:37],

Владимир Фетисов

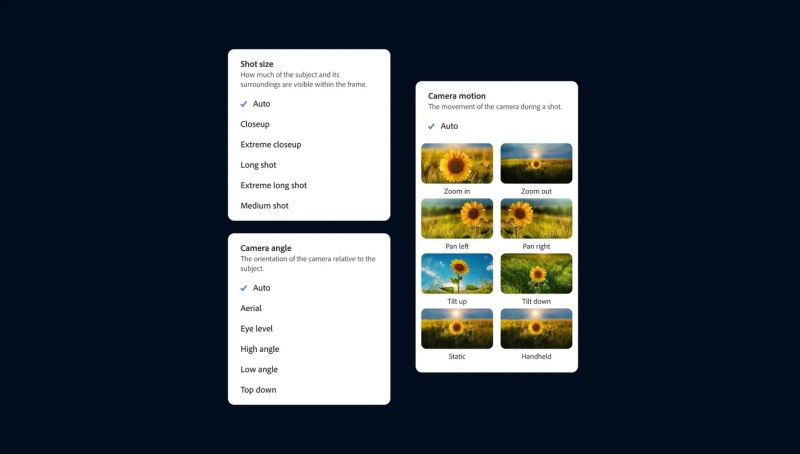

Компания Adobe официально представила новую генеративную нейросеть Firefly Video Model, которая предназначена для работы с видео и стала частью приложения Premiere Pro. С помощью этого инструмента пользователи смогут дополнять отснятый материал, а также создавать ролики на основе статичных изображений и текстовых подсказок.

Источник изображений: Adobe Функция Generative Extend на базе упомянутой нейросети в рамках бета-тестирования становится доступной пользователям Premiere Pro. Она позволит продлить видео на несколько секунд в начале, конце или каком-то другом отрезке ролика. Это может оказаться полезным, если в процессе монтажа нужно скорректировать мелкие недочёты, такие как смещение взгляда человека в кадре или лишние движения.  С помощью Generative Extend можно продлить ролик лишь на две секунды, поэтому он подходит только для внесения небольших изменений. Данный инструмент работает с разрешением 720p или 1080p с частотой 24 кадра в секунду. Функция также подходит для увеличения продолжительности аудио, но есть ограничения. Например, пользователь может продлить какой-либо звуковой эффект или окружающий шум до 10 секунд, но сделать это же с записями разговором или музыкальными композициями не удастся.  В веб-версии Firefly появились два новых инструмента генерации видео. Речь идёт о функциях Text-to-Video и Image-to-Video, которые, как можно понять из названия, позволяют создавать видео на основе текстовых подсказок и статических изображений. На данном этапе обе функции находятся на этапе ограниченного бета-тестирования, поэтому могут быть доступны не всем пользователям веб-версии Firefly. Text-to-Video работает аналогично другим ИИ-генераторам видео, таким как Sora от OpenAI. Пользователю нужно ввести текстовое описание желаемого результата и запустить процесс генерации ролика. Поддерживается имитация разных стилей, а сгенерированные ролики можно доработать с помощью набора «элементов управления камерой», которые позволяют имитировать такие вещи, как угол наклона камеры, движение и менять расстояние съёмки. Image-to-Video позволяет добавить к текстовому описанию статическое изображение, чтобы генерируемые ролики более точно соответствовали требованиям пользователя. Adobe предлагает использовать этот инструмент, в том числе, для пересъёмки отдельных фрагментов, генерируя новые видео на основе отдельных кадров из существующих роликов. Однако опубликованные примеры дают понять, что этот инструмент, по крайней мере на данном этапе, не позволит отказаться от пересъёмки, поскольку он не совсем точно воспроизводит все имеющиеся на изображении объекты. Ниже пример оригинального видео и ролика, сгенерированного на основе кадра из оригинала. Снимать длинные ролики с помощью этих инструментов не получится, по крайней мере на данном этапе. Функции Text-to-Video и Image-to-Video позволяют создавать видео продолжительностью 5 секунд в качестве 720p с частотой 24 кадра в секунду. Для сравнения, OpenAI утверждает, что её ИИ-генератор Sora может создавать видео длиной до минуты «при сохранении визуального качества и соблюдении подсказок пользователя». Однако этот алгоритм всё ещё недоступен широкому кругу пользователей, несмотря на то, что с момента его анонса прошло несколько месяцев. Для создания видео с помощью Text-to-Video, Image-to-Video и Generative Extend требуется около 90 секунд, но в Adobe сообщили о работе над «турборежимом» для сокращения времени генерации. В компании отметили, что созданные на основе Firefly Video Model инструменты «коммерчески безопасны», поскольку нейросеть обучается на контенте, который Adobe разрешено использовать. MiniMax представила бесплатный ИИ-генератор video-1, который превращает текст в видео за 2 минуты

02.09.2024 [19:03],

Владимир Фетисов

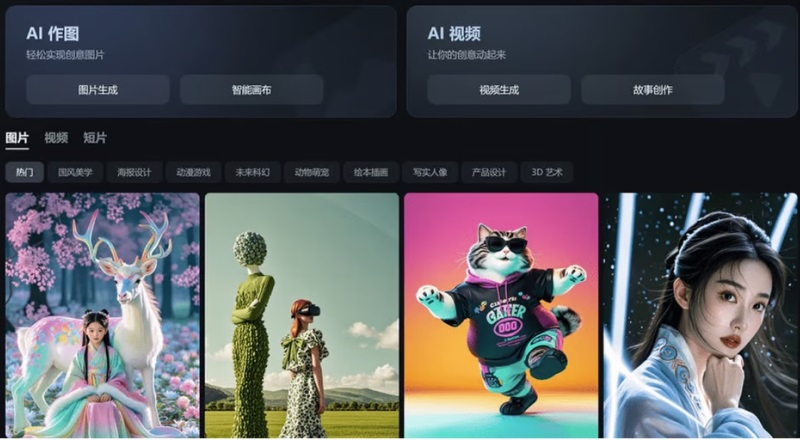

Китайский стартап MiniMax, работающий в сфере искусственного интеллекта, представил алгоритм video-1, который генерирует небольшие видеоклипы на основе текстовых подсказок. Генератор video-1 был представлен широкой публике на прошедшей несколько дней назад в Шанхае первой конференции разработчиков компании, а позднее стал доступен всем желающим на веб-сайте MiniMax.

Источник изображения: scmp.com С помощью video-1 пользователь может на основе текстового описания создавать видеоролики продолжительностью до 6 секунд. Процесс создания такого ролика занимает около 2 минут. Основатель MiniMax Ян Цзюньцзе (Yan Junjie) рассказал на презентации, что video-1 является первой версией алгоритма генерации видео по текстовым подсказкам, отметив, что в будущем нейросеть сможет создавать ролики на основе статических изображений, а также позволит редактировать уже созданные клипы. Появление video-1 отражает стремление китайских технологических компаний продвинуться в зарождающемся сегменте рынка ИИ. Генератор видео был представлен всего через несколько месяцев после анонса нейросети Sora компании OpenAI, которая также позволяет создавать видео по текстовым подсказкам. Что касается MiniMax, то компания была основана в декабре 2021 года и с тех пор она проделала немалую работу. Новый инструмент video-1 предлагается в рамках платформы MiniMax под названием Hailuo AI, которая ориентирована на потребительский рынок и уже предоставляет доступ к функциям генерации текстов и музыки с помощью нейросетей. Помимо MiniMax, разработкой ИИ-алгоритмов для генерации видео из текста занимаются и другие китайские компании. Пекинский стартап Shengshu AI в июле запустил собственный генератор видео из текста на китайском или английском языках под названием Vidu. Стартап Zhipu AI стоимостью более $1 млрд в том же месяце представил свой аналог Sora, который может создавать небольшие видео на основе текстовых подсказок или статических изображений. Владелец TikTok и Douyin, компания ByteDance, в прошлом месяце опубликовала в китайском App Store приложение Jimeng text-to-video для генерации видео из текста, а ещё ранее оно появилось в местных магазинах Android-приложений. Jimeng позволяет создать бесплатно 80 изображений или 26 видео, а для более активного взаимодействия с нейросетью предлагается оформить подписку за 69 юаней (около $10). В прошлом месяце компания Alibaba Group Holding объявила о разработке алгоритма для генерации видео под названием Tora, основанного на модели OpenSora. Отметим, что среди инвесторов MiniMax есть крупные IT-компании, такие как Alibaba, Tencent Holdings и miHoYo (создатель Genshin Impact). Очередной раунд финансирования прошёл весной и после его завершения рыночная стоимость MiniMax оценивалась более чем в $2 млрд. Stability AI представила генератор 4D-видео Stable Video 4D

25.07.2024 [01:21],

Владимир Фетисов

На фоне популярности генеративных нейросетей уже доступно множество ИИ-алгоритмов для создания видео, таких как Sora, Haiper и Luma AI. Разработчики из Stability AI представили нечто совершенно новое. Речь идёт о нейросети Stable Video 4D, которая опирается на существующую модель Stable Video Diffusion, позволяющую преобразовывать изображения в видео. Новый инструмент развивает эту концепцию, создавая из получаемых видеоданных несколько роликов с 8 разными перспективами.

Stable Diffusion 3 «Мы считаем, что Stable Video 4D будет использоваться в кинопроизводстве, играх, AR/VR и других сферах, где присутствует необходимость просмотра динамически движущихся 3D-объектов с произвольных ракурсов», — считает глава подразделения по 3D-исследованиям в Stability AI Варун Джампани (Varun Jampani). Это не первый случай, когда Stability AI выходит за пределы генерации двумерного видео. В марте компания анонсировала алгоритм Stable Video 3D, с помощью которого пользователи могут создавать короткие 3D-ролики на основе изображения или текстового описания. С запуском Stable Video 4D компания делает значительный шаг вперёд. Если понятие 3D или три измерения обычно понимается как тип изображения или видео с глубиной, то 4D, не добавляет ещё одно измерение. На самом деле 4D включает в себя ширину (x), высоту (y), глубину (z) и время (t). Это означает, что Stable Video 4D позволяет смотреть на движущиеся 3D-объекты с разных точек обзора и в разные моменты времени. «Ключевые аспекты, которые позволили создать Stable Video 4D, заключаются в том, что мы объединили сильные стороны наших ранее выпущенных моделей Stable Video Diffusion и Stable Video 3D, а также доработали их с помощью тщательно подобранного набора данных динамически движущихся 3D-объектов», — пояснил Джампани. Он также добавил, что Stable Video 4D является первым в своём роде алгоритмом, в котором одна нейросеть выполняет синтез изображения и генерацию видео. В уже существующих аналогах для решения этих задач используются отдельные нейросети. «Stable Video 4D полностью синтезирует восемь новых видео с нуля, используя для этого входное видео в качестве руководства. Нет никакой явной передачи информации о пикселях с входа на выход, вся эта передача информации осуществляется нейросетью неявно», — добавил Джампани. Он добавил, что на данный момент Stable Video 4D может обрабатывать видео с одним объектом длительностью несколько секунд с простым фоном. В дальнейшем разработчики планируют улучшить алгоритм, чтобы он мог использоваться для обработки более сложных видео. «Сбер» открыла для всех ИИ-генератор 6-секундных видео Kandinsky Video 1.1

28.05.2024 [21:12],

Владимир Фетисов

«Сбер» официально объявил о запуске бета-версии нейросети Kandinsky Video 1.1, которая способна создавать полноценные видео продолжительностью 6 секунд на основе текстового описания или статического изображения. Оценить возможности алгоритма можно на платформе fusionbrain.ai и в Telegram-боте Kandinsky.

Источник изображения: fusionbrain.ai Нейросеть генерирует непрерывную сцену с движением объектов и фона продолжительностью до шести секунд на скорости 8 кадров в секунду или 32 кадра в секунду. Поддерживается генерация роликов в форматах 16:9, 9:16 и 1:1. Обновлённый алгоритм способен создавать ролики не только по текстовому описанию, но и на основе статического изображения. За счёт этого пользователи имеют больше возможностей для реализации своих творческих задумок. В дополнение к этому пользователь может контролировать динамику генерируемого видео путём изменения параметра «motion score». «Сегодня мы сделали ещё один шаг в будущее видеотворчества. Теперь каждый пользователь Kandinsky Video может воплотить свои идеи и выразить их в видеоформате. С момента запуска первой версии нейросети прошло менее года, и за это время наша команда значительно улучшила такие показатели, как качество и скорость генерации полноценных видеороликов, открывая тем самым безграничные горизонты для креатива», — прокомментировал запуск нового алгоритма Андрей Белевцев, старший вице-президент, руководитель блока «Техническое развитие» Сбербанка. Google представила ИИ Veo для создания реалистичных видео — Full HD и больше минуты

14.05.2024 [23:46],

Владимир Фетисов

Около трёх месяцев прошло с тех пор как OpenAI представила генеративную нейросеть Sora, которая может создавать реалистичное видео по текстовому описанию. Теперь у Google есть чем ответить: в рамках конференции Google I/O была анонсирована нейросеть Veo. Алгоритм может генерировать «высококачественные» видеоролики с разрешением Full HD продолжительностью более минуты с применением разных визуальных и кинематографических стилей.

Источник изображения: Google В пресс-релизе Google сказано, что алгоритм Veo обладает «продвинутым пониманием естественного языка», что позволяет ИИ-модели понимать кинематографические термины, такие как «таймлапс» или «съёмка пейзажа с воздуха». Пользователи могут добиться желаемого результата с помощью не только текстовых подсказок, но также «скормить» ИИ изображения или видео, получая в конечном счёте «последовательные и целостные» ролики, в которых на протяжении всего времени движения людей, животных и объектов выглядят реалистично. Генеральный директор ИИ-подразделения Google DeppMind Демис Хассабис (Demis Hassabis) заявил, что пользователи могут корректировать генерируемые ролики с помощью дополнительных подсказок. Кроме того, Google изучает возможность интеграции дополнительных функций, которые позволят Veo создавать раскадровки и более продолжительные видео. Несмотря на сегодняшний анонс Veo, обычным пользователям придётся какое-то время подождать, прежде чем алгоритм станет общедоступным. На данном этапе Google приглашает к тестированию предварительной версии нейросети ограниченно количество создателей контента. Компания хочет поэкспериментировать с Veo, чтобы определить, каким образом следует осуществлять поддержку авторов контента и развивать сотрудничество с ними, давая творческим людям право голоса в разработке ИИ-технологий Google. Некоторые функций Veo в ближайшие несколько недель станут доступны ограниченному числу пользователей сервиса VideoFX, которые подадут заявки на участие в тестировании предварительной версии алгоритма. В будущем Google намерена также добавить некоторые функции Veo в YouTube Shorts. Microsoft показала нейросеть, которая делает говорящие что угодно дипфейки по одному фото

19.04.2024 [07:03],

Владимир Фетисов

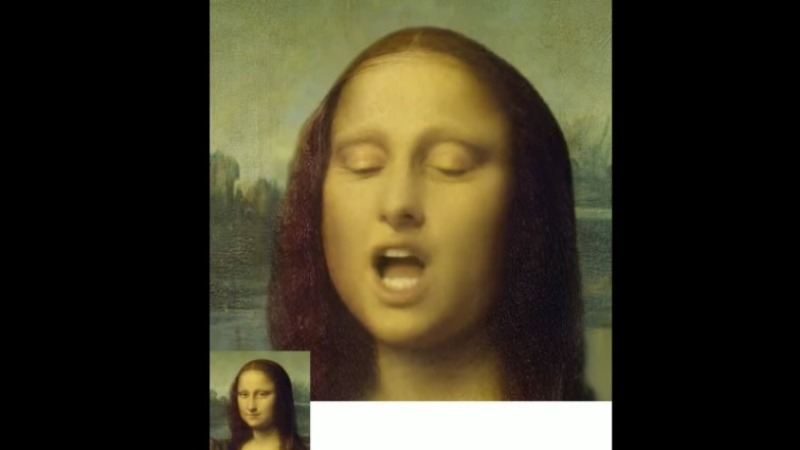

За последние пару лет генеративные нейросети преодолели важный этап развития, став более мощными и способными создавать по текстовому описанию не только изображения, но и видео. Новый алгоритм VASA-1 от Microsoft, вероятно, сумеет удивить многих, поскольку для его работы вообще не нужно описание. Достаточно предоставить одно изображение человека и аудиодорожку, на основе которых нейросеть сгенерирует видео говорящего человека с широким спектром эмоций и естественной мимикой.

Источник изображения: Microsoft Результат работы VASA-1 выглядит очень естественно и правдоподобно. Всего из одного снимка лица и записи голоса алгоритм создаёт реалистичное видео, на котором запечатлённый на снимке человек буквально «оживает», а его мимика, движения губ и головы выглядят вполне натурально. Поскольку созданные с помощью VASA-1 видео с ходу сложно отличить от реальных, уже высказываются опасения по поводу того, что алгоритм может использоваться злоумышленниками для создания фейков. Что касается самой нейросети, то главным её отличием от других подобных алгоритмов является наличие целостной модели генерации лицевой мимики и движений головы. Специалисты Microsoft провели обширную исследовательскую работу, включая оценку ряда новых метрик. В результате они установили, что новый алгоритм значительно превосходит представленные ранее аналоги по многим параметрам. «Наш метод не только обеспечивает генерацию видео высокого качества с реалистичной мимикой лица и движениями головы, но также поддерживает функцию онлайн-генерации видео 512×512 точек с частотой 40 кадров в секунду с незначительной начальной задержкой. Это открывает путь к взаимодействию в реальном времени с реалистичными аватарами, имитирующими поведение человека во время разговора», — говорится в сообщении Microsoft. Другими словами, нейросеть может создавать качественные фейковые видео на основе всего одного изображения. Поэтому не удивительно, что Microsoft называет VASA-1 «исследовательской демонстрацией» и не планирует выводить его на коммерческий рынок, по крайней мере, в ближайшее время. OpenAI сделает ИИ-генератор видео Sora общедоступным позднее в этом году

13.03.2024 [18:10],

Сергей Сурабекянц

В феврале OpenAI впервые продемонстрировала нейросеть Sora, способную генерировать реалистичные видео из текстовых описаний. Пока этот инструмент доступен лишь для художников, дизайнеров и кинематографистов. Сегодня технический директор OpenAI Мира Мурати (Mira Murati) сообщила, что Sora станет доступна широкой публике «позднее в этом году». Мурати пообещала, что к способности Sora создавать видео добавится генерация звукового сопровождения, что сделает ролики ещё более реалистичными.

Источник изображения: OpenAI Сейчас OpenAI работает над возможностью редактирования контента в видеороликах Sora, поскольку инструменты искусственного интеллекта не всегда создают точные изображения. «Мы пытаемся выяснить, как использовать эту технологию в качестве инструмента, с помощью которого люди смогут редактировать медиаконтент», — рассказала Мурати. Мурати уклонилась от ответа на вопрос, какие данные OpenAI использовала для обучения Sora. «Я не собираюсь вдаваться в подробности использованных данных, но это были общедоступные или лицензированные данные», — заявила она. Мурати не подтвердила и не опровергла использование видео с YouTube, Facebook✴ и Instagram✴. Она отметила, что Sora использует контент фотохостинга Shutterstock, с которым у OpenAI заключено партнёрское соглашение. Мурати рассказала, что на сегодняшний день Sora отличается от других моделей ИИ повышенными требованиями к вычислительным ресурсам. OpenAI работает над тем, чтобы сделать этот инструмент «доступным по той же цене», что и модель DALL-Eдля преобразования текста в изображение. Опасения в обществе по поводу инструментов генеративного ИИ и их способности создавать дезинформацию усиливаются. По словам Мурати, Sora не сможет создавать изображения общественных деятелей, как и DALL-E. Видео от Sora также будут включать водяные знаки, но они не являются идеальной защитой и могут быть удалены из видео при помощи ИИ или традиционных технологий. Люди не смогли отличить созданные нейросетью OpenAI Sora видео от настоящих

10.03.2024 [20:05],

Владимир Фетисов

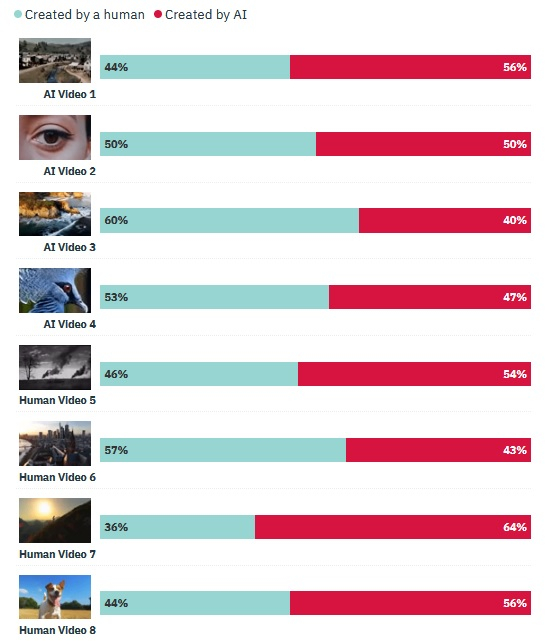

Несколько недель назад компания Open AI представила нейросеть Sora, способную по текстовому описанию генерировать реалистичное видео продолжительностью до одной минуты с разрешением 1920 × 1080 пикселей. Теперь же компания HarrisX провела опрос, предлагая взрослым американцам отличить сгенерированное ИИ видео от настоящего. Оказалось, что большая часть респондентов ошиблась в 5 из 8 предлагаемых в рамках опроса роликов.

Источник изображения: Mariia Shalabaieva / unsplash.com В опросе, который проходил в период с 1 по 4 марта в США, участвовали более 1000 американцев. Авторы исследования сгенерировали четыре высококачественных ролика с помощью нейросети Sora, а также выбрали четыре небольших видео, которые были сняты на камеру в реальном мире. Респондентам в случайном порядке показывали эти видео, а их цель была определить, снят ролик человеком или его сгенерировал ИИ. Мнения участников опроса разделились, но при этом в 5 из 8 случаев большая часть респондентов дала неверный ответ. Это исследование указывает на то, что создаваемый с помощью генеративных нейросетей контент становится всё более реалистичным и отличить его от реального всё труднее. Именно поэтому в разных странах стали чаще звучать призывы к властям о необходимости законодательного регулирования этого сегмента. В числе прочего предлагается обязать пользователей нейросетей помечать генерируемый контент соответствующим образом, чтобы он не вводил других в заблуждение и не мог стать источником дезинформации.

Источник изображения: variety.com Алгоритм Sora ещё недоступен широкой публике, но уже сейчас он вызывает серьёзную тревогу в обществе, особенно в индустрии развлечений, где развитие технологий генерации видео влечёт массу негативных последствий, например, для киностудий. Более того, всё чаще поднимается вопрос о том, что подобные Sora алгоритмы могут использоваться для создания фейковых видео с участием политиков и знаменитостей, что может привести к самым непредсказуемым последствиям. «Сбер» представил нейросеть Kandinsky Video — она генерирует 8-секундные видео по текстовому описанию

22.11.2023 [14:06],

Владимир Фетисов

«Сбер» представил нейросеть Kandinsky Video, способную создавать небольшие ролики по текстовому описанию. Алгоритм генерирует видеоряд продолжительностью до 8 секунд с частотой 30 кадров в секунду. Новинка была презентована в рамках конференции AI Journey первым заместителем председателя правления «Сбербанка» Александром Ведяхиным.

Источник изображения: sberbank.com Архитектура Kandinsky Video включает в себя два основных блока. Первый блок отвечает за генерацию ключевых кадров, используемых для создания структуры сюжета видео, а второй — генерирует интерполяционные кадры, за счёт чего достигается плавность движения в финальном ролике. Оба блока построены на базе модели синтеза изображений по текстовым описаниям Kandinsky 3.0. В конечном счёте алгоритм создаёт видео с движением как объекта, так и фона. Это отличает сгенерированные нейросетью видео от анимационных роликов, в которых динамика достигается за счёт моделирования полёта камеры относительно статичной сцены. В настоящее время Kandinsky Video может создавать видео с разрешением 512 × 512 пикселей и разным соотношением сторон. Для обучения алгоритма использовался датасет из более чем 300 тыс. пар «текст-видео». Сам же процесс генерации ролика занимает до 3 минут. Отмечается, что ранее некоторые пользователи нейросети Kandinsky 2.2 в тестовом режиме получили доступ к функции создания анимационных роликов. Всего одного запроса достаточно для генерации видео продолжительностью до 4 секунд с выбранными эффектами анимации, частотой 24 кадра в секунду и разрешением 640 × 640 пикселей. Пользователи новой версии Kandinsky 3.0 также могут генерировать ролики по текстовому описанию в режиме анимации. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |