|

Опрос

|

реклама

Быстрый переход

Все современные ИИ провалили новый сложный тест на общий интеллект — люди с ним тоже справились не идеально

25.03.2025 [11:22],

Анжелла Марина

Новый тест для оценки общей интеллектуальной способности моделей искусственного интеллекта, получивший название ARC-AGI-2, поставил в тупик большинство ИИ-моделей. Согласно рейтингу, рассуждающие модели, такие как o1-pro от OpenAI и R1 от DeepSeek, набрали от 1 % до 1,3 %. Модели без логического мышления, включая GPT-4.5, Claude 3.7 Sonnet и Gemini 2.0 Flash, набрали менее 1 %.

Источник изображения: Pixabay Фонд Arc Prize Foundation, некоммерческая организация, соучредителем которой является известный исследователь в области искусственного интеллекта Франсуа Шолле (François Chollet), объявил в своём блоге о создании нового, более продвинутого теста для измерения общего интеллекта ведущих моделей искусственного интеллекта. Тест ARC-AGI-2 представляет собой серию головоломок, в которых ИИ должен распознать визуальные закономерности, анализируя разноцветные квадраты, и на основе этого построить правильное продолжение узора. Испытание специально разработано так, чтобы модели не могли полагаться на прошлый опыт и вынуждены были адаптироваться к новым задачам. Также Arc Prize Foundation провела тестирование с участием более 400 человек. В среднем группы испытуемых верно ответили на 60 % заданий. Это значительно превосходит показатели всех протестированных ИИ и одновременно подчёркивает разрыв между текущими возможностями ИИ и интеллектом людей в решении задач, требующих адаптации и понимания новых концепций. Шолле заявил, что ARC-AGI-2 является более точным показателем реального интеллекта ИИ-моделей, чем предыдущая версия теста ARC-AGI-1. Кроме того, ARC-AGI-2 исключает возможность решения задач «методом грубой силы», то есть путём использования огромной вычислительной мощности для перебора всех возможных вариантов, что происходило в тесте ARC-AGI-1 и было признано серьёзным недостатком. Для устранения погрешностей первого теста в ARC-AGI-2 была введена метрика эффективности, которая заставляла ИИ интерпретировать паттерны «на лету», а не полагаться на запоминание. Сооснователь Arc Prize Foundation Грег Камрадт (Greg Kamradt) отметил, что «интеллект определяется не только способностью решать задачи или достигать высоких результатов, но и эффективностью, с которой приобретаются и развёртываются эти возможности». ARC-AGI-1 оставался ведущей метрикой в течение примерно пяти лет, пока в декабре 2024 года OpenAI не выпустила свою продвинутую модель рассуждений o3. Эта модель превзошла все другие ИИ-модели и даже сравнялась с производительностью человека в тестах ARC-AGI-1. Однако, как было отмечено, эти достижения были достигнуты за счёт значительных вычислительных затрат. Разработка нового теста совпала с ростом обеспокоенности в индустрии по поводу недостатка объективных критериев для оценки искусственного интеллекта. В связи с этим Arc Prize Foundation объявила о запуске конкурса Arc Prize 2025, в котором разработчикам предлагается достичь 85 % точности на ARC-AGI-2, затратив при этом вычислительных затрат не более, чем $0,42 на задачу. Бывший гендир Intel Гелсингер возглавил стартап Gloo, пытающийся внедрить ИИ в религию

25.03.2025 [09:59],

Алексей Разин

В начале декабря Патрик Гелсингер (Patrick Gelsinger) был отправлен в отставку с поста генерального директора Intel, после чего стало известно, что он оказывает финансовую поддержку стартапу Gloo, стремящемуся привнести новые технологии в консервативную религиозную среду. Вчера Гелсингер возглавил Gloo в качестве технического директора и исполнительного председателя совета директоров.

Источник изображения: Intel Gloo занимается внедрением больших языковых моделей в сфере взаимодействия прихожан и священников. Ранее Гелсингер признавался, что Gloo уже использует языковые модели DeepSeek с открытым исходным кодом, но со временем надеется внедрить собственные разработки в этой сфере. Совет директоров Gloo Гелсингер возглавлял в качестве неисполнительного председателя с 2018 года, а продвижением интересов христианства в Калифорнии бывший глава Intel занимался на протяжении более чем десяти лет. Стартап Gloo был основан ещё в 2013 году, в прошлом году ему удалось привлечь $110 млн. Компания разрабатывает «христианский чат-бот», который фильтрует результаты поиска и даёт пользователям ответы, построенные на христианских канонах. В новом качестве Гелсингер сможет сильнее влиять на разработку данного чат-бота. «Технология способна объединять, улучшать и трансформировать жизни людей, но только когда она изначально создаётся с соответствующими целями», — прокомментировал своё назначение Патрик Гелсингер. Microsoft анонсировала ИИ-агентов для защиты людей от киберугроз

24.03.2025 [21:00],

Анжелла Марина

Microsoft добавит в Security Copilot ИИ-агентов для автоматизации рутинных задач и повышения эффективности работы специалистов по кибербезопасности. Всего представлено шесть агентов непосредственно от Microsoft и пять агентов, созданных партнёрами, сообщает The Verge.

Источник изображения: Lewis Kang'ethe Ngugi / Unsplash Security Copilot на базе искусственного интеллекта (ИИ) был запущен год назад, но теперь Microsoft решила масштабировать этот сервис. Новые агенты появятся в тестовом режиме уже в следующем месяце. Они смогут анализировать фишинговые атаки, предупреждать о возможных утечках данных, расставлять приоритеты среди серии критических инцидентов и отслеживать уязвимости. Как отметила Васу Джаккал (Vasu Jakkal), корпоративный вице-президент Microsoft Security, ИИ-агенты будут интегрированы с инструментами Microsoft Security и позволят командам автономно справляться с большим объёмом задач. Помимо этого, Microsoft улучшит защиту от фишинга в Microsoft Teams: уже в следующем месяце Defender for Office 365 начнёт блокировать вредоносные ссылки и вложения в сообщениях Teams, что усилит защиту пользователей от киберугроз. Использование ИИ-агентов становится всё более популярным среди крупных компаний. В связи с этим Microsoft уже перезапустила свой Copilot для бизнеса, предложив бесплатного чат-бота и доступ к ИИ-агентам по модели оплаты «по мере использования». Стоит отметить, что помимо собственных разработок Microsoft сотрудничает с рядом компаний, включая OneTrust, Aviatrix, BlueVoyant, Tanium и Fletch. Их решения позволят, в частности, анализировать утечки данных с помощью OneTrust и выявлять причины сбоев в сетях с Aviatrix. Microsoft также готовит новые анонсы в сфере безопасности, которые будут представлены на мероприятии Microsoft Secure 9 апреля. Дополнительную информацию можно найти в официальном блоге компании. DeepSeek начали массово встраивать в китайские автомобили — это привлекает покупателей

24.03.2025 [13:18],

Алексей Разин

Программные возможности современных транспортных средств волнуют потенциальных покупателей не меньше, чем технические характеристики и дизайн, поэтому китайские автопроизводители начали активно внедрять поддержку чат-ботов на базе разработок DeepSeek в свою программную инфраструктуру. Подобным образом уже поступили Dongfeng, GAC и BYD.

Источник изображения: BYD Dongfeng Motor, как уточняет Nikkei Asian Review, предлагает поддержку большой языковой модели DeepSeek R1 в мультимедийной системе кроссоверов Zhiyin марки Voyah, причём данная функциональность была добавлена посредством обновления «по воздуху». С апреля аналогичными возможностями начнут обзаводиться крупный внедорожник M-Hero 917 и другие транспортные средства концерна. Искусственный интеллект в бортовой электронике машины используется не только для построения диалога с водителем и пассажирами при помощи голосового ассистента, но и для оценки окружающей обстановки с целью предсказания дальнейших намерений водителя. Лидирующая на китайском рынке гибридов и электромобилей компания BYD также объявила о намерении внедрить разработки DeepSeek в свою продукцию. Некоторые автопроизводители готовы «подружить» собственные программные платформы с языковыми моделями DeepSeek. Например, так намерена поступить китайская компания GAC Group. Языковой ассистент Adigo Sense в автомобилях этой марки будет учитывать историю прошлых запросов и действий водителя для прогнозирования его ближайших намерений. Цифровой помощник сможет оптимизировать маршруты передвижения и предлагать пассажирам фильмы к просмотру с учётом их предпочтений. GAC начнёт внедрять подобные функции в бортовое ПО своих автомобилей в текущем полугодии. Leapmotor надеется сочетать языковые модели DeepSeek с разработкой Alibaba, получившей обозначение Qwen. По крайней мере, такая связка позволит бортовой системе машин Leapmotor научиться генерировать изображения. SAIC намерена внедрить поддержку DeepSeek на автомобилях марки IM Motors в сочетании с решениями Alibaba и ByteDance. В Китае даже импортные марки не стесняются внедрять поддержку DeepSeek для своих транспортных средств локальной сборки. Например, подобной функцией обзаведётся электромобиль Nissan N7, собираемый на совместном предприятии с Dongfeng. Стараниями SAIC поддержкой DeepSeek обзаведутся выпускаемые в Китае модели Buick и Cadillac. Языковые модели этой компании будут соседствовать с чат-ботом Baidu Ernie. Есть в Китае и автопроизводители, которые пока не следуют моде на DeepSeek. Среди них можно отметить Xiaomi и XPeng Motors. Ant Group придумала, как эффективно обучать ИИ на китайских чипах вместо Nvidia

24.03.2025 [10:55],

Дмитрий Федоров

Ant Group представила новый метод обучения ИИ-моделей, позволяющий использовать китайские полупроводники, включая чипы Huawei и Alibaba. Компания применила архитектуру Mixture of Experts и уже достигла результатов, сопоставимых с использованием графических процессоров (GPU) Nvidia H800, что укрепляет позиции Китая на фоне ограничений, введённых США.

Источник изображений: Ant Group CO Это достижение знаменует собой важный этап в технологическом противостоянии между китайскими и американскими компаниями, которое резко обострилось после того, как DeepSeek доказала возможность создания современных больших языковых моделей (LLM) без миллиардных вливаний, аналогичных тем, которые делают OpenAI и Google. Хотя Ant Group по-прежнему использует решения Nvidia в ряде проектов, в новых разработках компания отдаёт предпочтение альтернативным поставщикам, включая AMD, а также местным китайским производителям полупроводников, особенно в условиях нарастающего давления со стороны экспортных ограничений США. Это позволяет китайским компаниям сохранять темп технологического прогресса и снижать зависимость от иностранных поставщиков, прежде всего от Nvidia. Согласно опубликованной в марте научной статье, Ant Group утверждает, что её ИИ-модели в отдельных тестах превзошли разработки компании Meta✴. Однако эти заявления пока не получили независимого подтверждения. При этом важно отметить, что модель H800, хотя и не относится к передовому классу ускорителей Nvidia, остаётся мощным инструментом, способным справляться с ресурсоёмкими задачами обучения ИИ. Благодаря собственной оптимизированной стратегии Ant Group удалось сократить расходы на обучение ИИ-модели объёмом в 1 трлн токенов с 6,35 млн юаней ($880 000) до 5,1 млн юаней ($707 000). В данном контексте токены — это минимальные единицы текста, на которых обучаются LLM, чтобы впоследствии генерировать осмысленные ответы на запросы пользователей.  В компании заявили о намерении внедрить свои новые языковые модели — Ling-Plus и Ling-Lite — в решения, ориентированные на промышленное применение, включая здравоохранение и финансовую сферу. Ant Group уже приобрела китайскую платформу Haodf.com, специализирующуюся на медицинских онлайн-сервисах, чтобы расширить возможности своей ИИ-инфраструктуры в области здравоохранения. Кроме того, компания развивает мобильное приложение Zhixiaobao, позиционируемое как ИИ-ассистент для повседневной жизни, а также Maxiaocai — сервис на основе ИИ, предоставляющий финансовые рекомендации. В опубликованной научной работе подчёркивается, что модель Ling-Lite показала лучшие результаты в одном из ключевых англоязычных тестов по сравнению с одной из версий Llama компании Meta✴. При этом обе модели — Ling-Lite и Ling-Plus — превзошли аналоги DeepSeek в бенчмарках на китайском языке. Ling-Lite содержит 16,8 млрд параметров — это настраиваемые элементы модели, определяющие её поведение при генерации текста. Модель Ling-Plus насчитывает 290 млрд параметров и по масштабности относится к категории больших языковых систем. Обе модели были представлены сообществу разработчиков в виде решений с открытым исходным кодом. По оценке MIT Technology Review, GPT-4.5 компании OpenAI содержит около 1,8 трлн параметров, а DeepSeek-R1 — 671 млрд. Архитектура Mixture of Experts, использованная в Ling-моделях, предполагает активацию отдельных подсетей внутри модели в зависимости от типа задачи, тем самым обеспечивая оптимальное распределение вычислительных ресурсов. Эта система напоминает команду специалистов, в которой каждый элемент ИИ-модели отвечает за строго определённую, узкоспециализированную функцию. Однако в процессе обучения возникли сложности: как сообщается в научной статье, даже незначительные изменения в аппаратной конфигурации или в структуре модели приводили к резкому росту числа ошибок. Такая нестабильность делает процесс обучения чувствительным к параметрам окружения и требует дополнительной адаптации на каждом этапе. ИИ-система Aardvark Weather заменит суперкомпьютеры в прогнозировании погоды

23.03.2025 [08:28],

Дмитрий Федоров

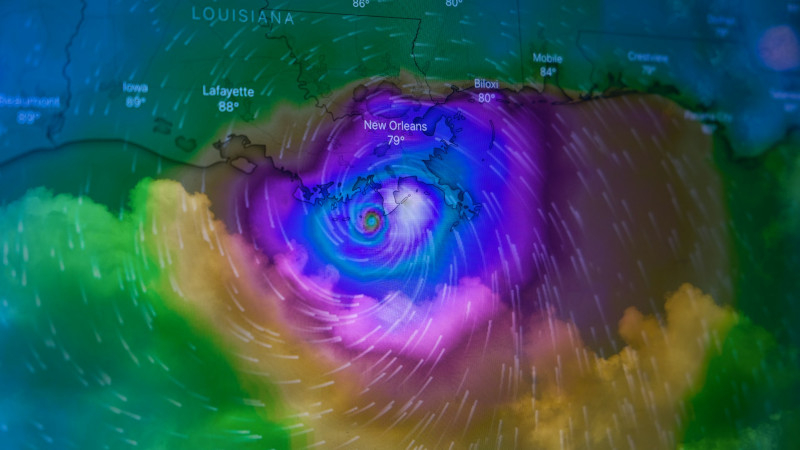

Учёные Кембриджского университета представили Aardvark Weather — ИИ-систему для прогнозирования погоды, которая позволяет формировать как глобальные, так и локальные прогнозы за считанные минуты с использованием обычного настольного компьютера. В сравнении с традиционными подходами, Aardvark обеспечивает предсказания в десятки раз быстрее и при этом требует в тысячи раз меньше вычислительных ресурсов.

Источник изображения: Brian McGowan / Unsplash Aardvark Weather была разработана в Кембриджском университете (University of Cambridge) при участии Института Алана Тьюринга (The Alan Turing Institute), Microsoft Research и Европейского центра среднесрочных прогнозов погоды (ECMWF). Скорость и эффективность метеорологических моделей имеют решающее значение: традиционные методы опираются на ресурсоёмкие суперкомпьютеры и труд множества специалистов, тогда как формирование прогноза зачастую занимает несколько часов. В этом контексте Aardvark демонстрирует принципиально новый подход, устраняя необходимость в громоздкой инфраструктуре. Последние разработки таких технологических гигантов, как Huawei, Google и Microsoft, показали, что ИИ способен значительно улучшить отдельные компоненты метеорологического моделирования. Особенно важными стали достижения в области алгоритмов, моделирующих динамику атмосферы во времени. Интеграция ИИ в эти процессы уже привела к ускорению расчётов и повышению точности метеопрогнозов. Яркий пример — компания Google, разрабатывающая модели на базе ИИ и предлагающая два таких решения корпоративным клиентам своей облачной платформы. Эти модели, созданные исследователями лаборатории Google DeepMind, используют исторические метеоданные и позволяют предсказывать погодные условия на срок от 10 до 15 дней вперёд. В отличие от гибридных подходов, Aardvark полностью заменяет традиционную многоступенчатую схему прогнозирования единой моделью машинного обучения (ML). Используя стандартный настольный компьютер, система обрабатывает данные из различных источников, включая спутники и метеостанции, и формирует прогнозы в течение нескольких минут. Профессор Ричард Тёрнер (Richard Turner) с инженерного факультета Кембриджского университета, возглавивший исследование, заявил: «Aardvark переосмысливает существующие методы прогнозирования погоды, позволяя получать прогнозы быстрее, дешевле, гибче и точнее, чем когда-либо прежде. Aardvark в тысячи раз быстрее всех прежних методов прогнозирования погоды». В перспективе Aardvark сможет формировать прогнозы на 8 дней вперёд с высокой степенью точности, что на 3 дня превышает горизонт современных систем. Несмотря на то, что система использует лишь часть объёма данных, задействованных в традиционных моделях, Aardvark демонстрирует результаты, превосходящие показатели американской Национальной системы прогнозирования (GFS) по нескольким ключевым метрикам. При этом она остаётся сопоставимой по точности с прогнозами Национальной метеорологической службы США (NWS), где обычно применяется комбинация моделей и экспертный анализ.

Источник изображения: NASA По словам Анны Аллен (Anna Allen), первого автора исследования из факультета компьютерных наук и технологий Кембриджского университета, реализованный в системе подход сквозного машинного обучения может быть легко адаптирован для решения других задач климатического моделирования — от прогнозирования ураганов, торнадо и лесных пожаров до оценки качества воздуха, динамики океанических течений и предсказания морского льда. Одним из наиболее примечательных свойств Aardvark является её архитектурная простота и высокая гибкость. Благодаря тому что система обучается напрямую на метеоданных, она может быть быстро перенастроена для формирования индивидуализированных прогнозов, адаптированных под конкретные отрасли или регионы. Это может быть, например, прогноз температуры для сельского хозяйства в Африке или прогноз скорости ветра — для европейских компаний, работающих в сфере возобновляемой энергетики. Такой подход кардинально отличается от традиционных систем, настройка которых требует многолетней работы крупных команд специалистов. Подобная адаптивность может стать решающим фактором для стран с ограниченным доступом к вычислительным ресурсам и метеоданным. Как подчёркивает доктор Скотт Хоскинг (Scott Hosking) из Института Алана Тьюринга, перенос метеопрогнозирования с суперкомпьютеров на настольные машины делает высокоточные прогнозы доступными в развивающихся странах и регионах с дефицитом данных. Следующим этапом проекта станет формирование новой исследовательской группы на базе Института Алана Тьюринга. Её задачей станет изучение возможностей внедрения технологии в странах Глобального Юга, а также интеграция Aardvark в более масштабные инициативы по экологическому прогнозированию. Tencent выпустила рассуждающую ИИ-модель T1 — она превосходит DeepSeek R1, в отдельных тестах

22.03.2025 [16:37],

Павел Котов

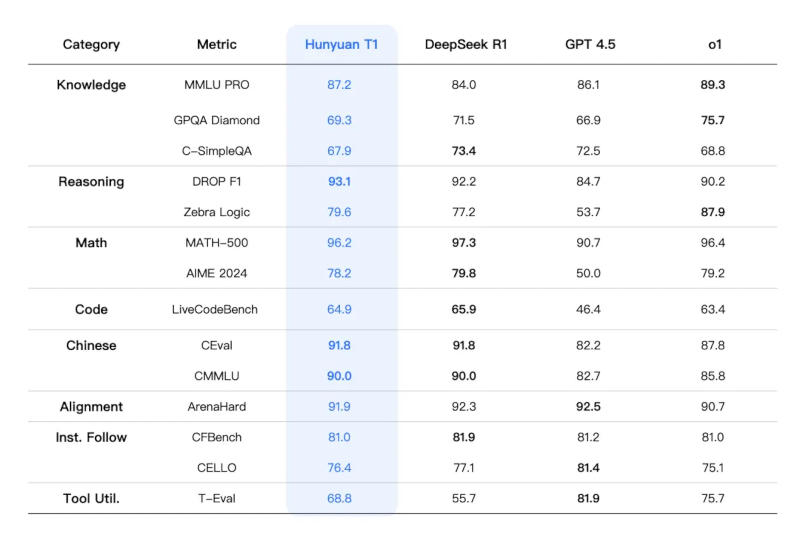

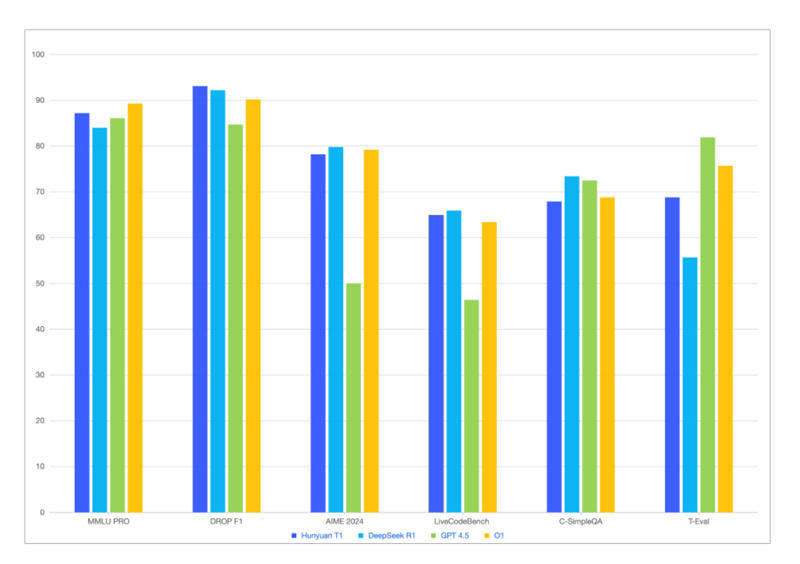

Китайский технологический гигант Tencent накануне представил официальную версию собственной рассуждающей модели искусственного интеллекта T1, тем самым усилив конкуренцию в и без того переполненной китайской отрасли ИИ.

Источник изображений: Tencent Обновлённая T1 предлагает сокращённое время отклика и расширенные возможности в работе с текстовыми документами, сообщила компания на платформе WeChat. Модель «сохраняет ясной логику контента, а текст — складным и чистым», тогда как процент галлюцинаций, то есть дачи заведомо не соответствующих действительности ответов, «крайне низок».  Китайским и другим мировым игрокам пришлось усилить работу над моделями ИИ с появлением стартапа DeepSeek, который научился добиваться передовых результатов при минимальных затратах. Ранее T1 была доступна в формате предварительной версии на платформах Tencent, включая приложение виртуального помощника Yuanbao. Официальная версия T1 будет работать на базе модели Tencent Turbo S, которая, по словам разработчика, функционирует быстрее, чем DeepSeek R1.  T1 смогла обойти DeepSeek R1 по некоторым показателям, связанным со знаниями и рассуждениями, указывает приложенная к публикации диаграмма. На этой неделе Tencent предупредила, что в 2025 году нарастит капитальные затраты, хотя и в 2024 году её расходы на ИИ резко увеличились. AMD представила Gaia — открытое приложение для запуска ИИ локально на ПК с Windows

22.03.2025 [12:58],

Павел Котов

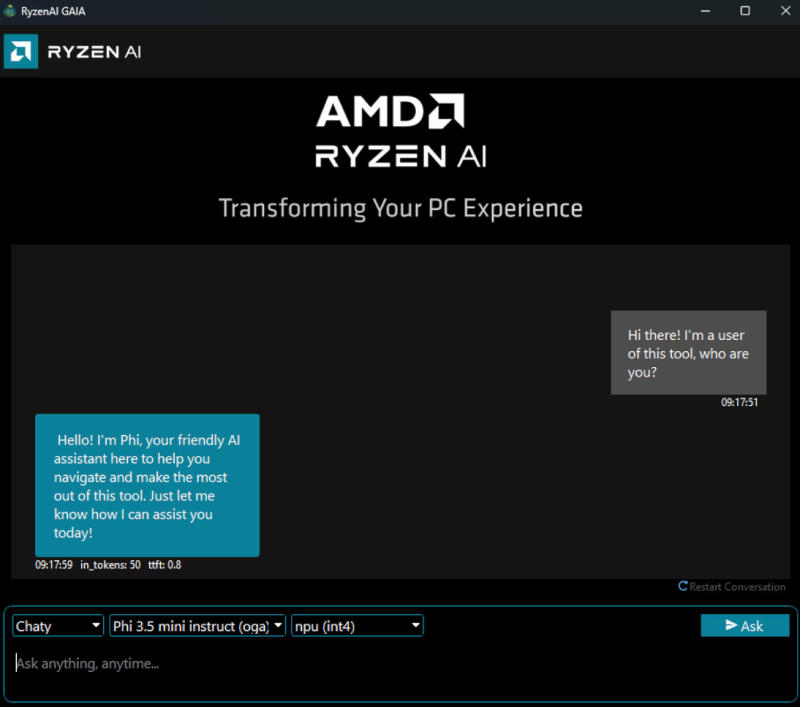

Запуск больших языковых моделей искусственного интеллекта локально на ПК — задача, которая становится всё более востребованной. Для её решения AMD выпустила Gaia — программу с открытым исходным кодом, предназначенную для работы с локальными ИИ-моделями на компьютерах под управлением Windows.

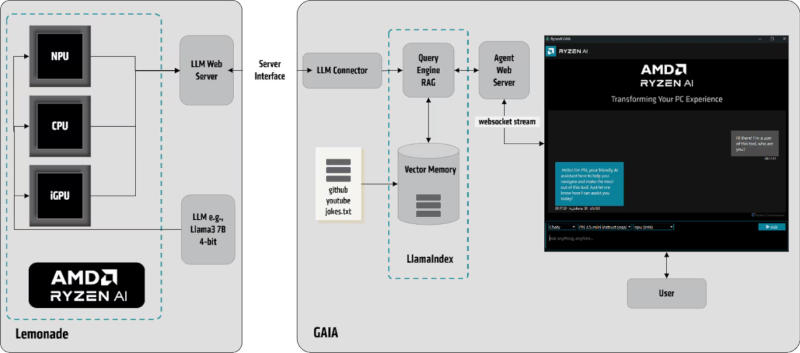

Источник изображений: amd.com Gaia предлагает дополнительную оптимизацию производительности для машин с процессорами Ryzen AI; вывод ИИ осуществляется при помощи средств Lemonade SDK. Программа позволяет адаптировать модели для различных целей: они могут составлять сводки больших текстов или обрабатывать сложные задачи, требующие умения рассуждать. Gaia работает через компонент Retrieval-Augmented Generation (RAG), объединяющий ИИ с базой знаний, благодаря чему пользователь получает более точные ответы на запросы в соответствии с контекстом. RAG включает четыре агента:

Gaia решает специализированные задачи ИИ с помощью Lemonade SDK, работая в различных средах выполнения. Lemonade открывает веб-сервис для языковой модели и взаимодействует с приложением Gaia через совместимый с OpenAI REST API. Приложение действует как ИИ-агент, который извлекает и обрабатывает данные, «векторизует» внешний контент (например, данные из GitHub, YouTube и текстовых файлов) и сохраняет его в локальном векторном индексе. Проще говоря, Gaia улучшает пользовательские запросы перед их обработкой ИИ-моделью, повышая точность и релевантность ответов.  Гибридный установщик, оптимизированный для систем с процессорами Ryzen, который позволяет Gaia использовать встроенный в Ryzen AI нейропроцессор (NPU) и интегрированную графику для вычислений. Локальный запуск ИИ-моделей имеет ряд преимуществ по сравнению с облачными сервисами: данные остаются защищёнными, уменьшается задержка, а в некоторых случаях повышается производительность. Кроме того, локальные модели не требуют подключения к интернету. Cloudflare натравила ИИ на ботов, которые собирают данные для ИИ

21.03.2025 [17:36],

Павел Котов

Cloudflare развернула систему искусственного интеллекта, предназначенную для перехвата ботов, которые сканируют общедоступные страницы и собирают данные с целью обучения других моделей ИИ.

Источник изображения: cloudflare.com Владельцы сайтов теоретически могут попытаться отбиться от сканеров страниц при помощи файлов robots.txt с директивами для ботов, изменения настроек веб-серверов, проверок CAPTCHA и полной блокировки ботов. В действительности операторы роботов-сканеров зачастую игнорируют директивы robots.txt, обходят как тесты CAPTCHA, так и настройки серверов. В результате на ресурсах растёт объём нежелательного трафика, а данные сайтов попадают в массивы для обучения ИИ без разрешения правообладателей — однозначного ответа на вопрос о законности такой практики пока нет. Cloudflare предложила не блокировать сканеры, а запускать их в систему, только показывать им созданный ИИ бесполезный контент, который они будут потреблять, попав в «ИИ-лабиринт». Обнаружив несанкционированное сканирование материалов, система не блокирует запрос, а выдаёт ряд ссылок на созданные ИИ страницы, достаточно убедительные, чтобы увести на них сканер. Такой контент выглядит как настоящий, но это уже не материалы, которые система пытается защитить — в результате сканер тратит время и ресурсы. Сами по себе генерируемые ИИ материалы реальны и связаны с научными фактами, потому что дезинформацию в Cloudflare плодить не намерены, а откровенно мусорный контент может навредить репутации сайта и поисковой оптимизации. Система окажется сдерживающим фактором для сканеров веб-контента, чьи ресурсы начнут использоваться впустую, а стоимость эксплуатации вырастет. Она будет полезным инструментом для обнаружения активности ботов; человек же не станет погружаться в такой «ИИ-лабиринт» на глубину более четырёх ссылок, уверены создатели системы. Но панацеей это решение не является: такие вещи обычно порождают гонку вооружений, и в Cloudflare уже задумываются о том, что делать дальше, чтобы оставаться впереди. Apple ответит в суде за промедления с запуском ИИ-функций Apple Intelligence

21.03.2025 [11:54],

Владимир Мироненко

На Apple подали в суд с обвинением в ложной рекламе, поскольку компания ввела пользователей в заблуждение, не сдержав обещание выпустить ряд функций платформы искусственного интеллекта Apple Intelligence в указанные сроки. Согласно иску, многие покупали iPhone 16 и другие устройства Apple, полагая, что эти функции уже имеются у новинок, поскольку компания вовсю их рекламировала.  «Реклама Apple вызывала у потребителей чёткие и обоснованные ожидания, что эти преобразующие функции будут доступны после выпуска iPhone», — говорится в иске, поданном в окружной суд США в Сан-Хосе юридической фирмой Clarkson Law Firm от имени истцов, требующих предоставить иску статус коллективного. В иске говорится, что продвижение функций Apple Intelligence «вызвало беспрецедентный ажиотаж», поскольку Apple стремилась «убедить потребителей обновиться по более высокой цене». «Вопреки утверждениям ответчика о расширенных возможностях ИИ, продукты предлагали существенно ограниченную или полностью отсутствующую версию Apple Intelligence, вводя потребителей в заблуждение относительно её реальной полезности и производительности», — указано в документе. Истцы признали, что Apple удалила с YouTube рекламу, продвигающую более персонализированный помощник Siri, но вместе с тем отмечают, что компания «не смогла опровергнуть все подобные ложные заявления». Ранее появились сообщения о том, что iOS 19 не принесёт кардинальных новшеств, поскольку добавление в рамках обновления платформы новых ИИ-функций в Siri пришлось отложить, вполне возможно, до следующего года. Этот иск стал ещё одной головной болью для Apple, которая пытается запустить обещанные функции Apple Intelligence, пишет TechCrunch. Как сообщило агентство Bloomberg, генеральный директор Apple Тим Кук (Tim Cook) «потерял уверенность в способности руководителя направления ИИ Джона Джаннандреа (John Giannandrea) обеспечивать разработку продуктов». В итоге новым руководителем подразделения был назначен Майк Роквелл (Mike Rockwell), руководитель отдела разработки Vision Pro. Seagate придумала сверхбыстрые жёсткие диски с PCIe — всё ещё медленнее SSD, но значительно дешевле

21.03.2025 [11:17],

Павел Котов

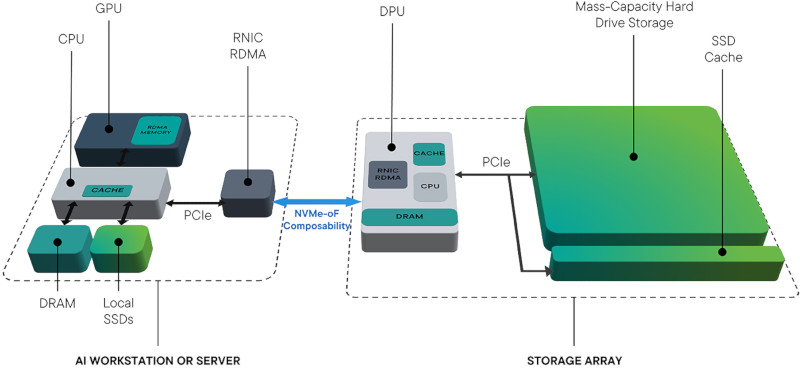

Технология жёстких дисков восходит к пятидесятым годам прошлого века и опирается на устаревшие стандарты ввода-вывода. Seagate рассчитывает сделать технологию магнитных накопителей современнее и обеспечить им поддержку стандарта PCIe — в условиях бума искусственного интеллекта возник спрос на быстрые накопители для центров обработки данных.

Источник изображений: seagate.com Seagate изменила подход к разработке и эволюции жёстких дисков, объединив их со стандартом NVMe в новой технологии для накопителей. Компания стремится упростить и оптимизировать решения в области хранения данных для специализирующихся на ИИ компаний — жёсткие диски по-прежнему обходятся дешевле твердотельных накопителей. Они никогда не достигнут тех же скоростей, что SSD, но в Seagate уверены, что их можно улучшить и сделать пригодными для работы в ЦОД. Адаптировав протокол на основе PCIe и развернув NVMe-совместимые жёсткие диски, компания устранила потребность в проприетарных решениях, привязанных к интерфейсам SAS/SATA, хост-адаптерам шины (HBA) и архитектурам контроллеров, которые не подходят для рабочих нагрузок ИИ. Новый протокол обещает высокую пропускную способность и низкую задержку, хотя едва ли магнитные накопители смогут перемещать данные со скоростями, измеряемыми гигабайтами в секунду. Жёстким дискам нового поколения не потребуется HBA или специальных контроллеров, но они сохранят разъём SAS/SATA для улучшения совместимости. Технология упростит развёртывание решений в области хранения данных для ИИ, а единый программный стек драйверов NVMe повысит эффективность работы твердотельных накопителей и жёстких дисков. Seagate предусмотрела возможность прямого подключения NVMe-накопителей к графическим процессорам, чтобы архитектура не зависела от скорости центральных процессоров. В результате модели ИИ смогут обрабатывать большие наборы данных с уменьшенными задержками ввода-вывода. Технология NVMe over Fabrics (NVMe-oF) позволяет использовать жёсткие диски в распределённых масштабируемых системах хранения данных.  Seagate протестировала новый комплекс, включающий жёсткие диски нового образца, твердотельные накопители NVMe, DPU Nvidia BlueField и программные решения AIStore. Конкретных результатов компания не привела, но заявила, что новая платформа оказалась способна обеспечить некоторые преимущества для рабочих нагрузок ИИ. Прямое подключение графической подсистемы к накопителям через DPU сократило задержки и устранило издержки, связанные с SAS/SATA, за счёт упрощённой архитектуры системы. AIStore помогла оптимизировать кэширование данных и повысить производительность при обучении моделей ИИ, а интеграция NVMe-oF доказала свою полезность в многостоечных кластерах систем хранения данных. NVMe-совместимые жёсткие диски в 10 раз сокращают объёмы углеродных выбросов на гигабайт, в 4 раза повышают эффективность потребления энергии и предлагают «значительно более низкую» стоимость за терабайт, чем SSD, заверили в Seagate. Сейчас компания работает над масштабированием своей платформы Mozaic 3+ на основе дисков, использующих технологию магнитной записи с подогревом (HAMR), над созданием жёстких дисков большей ёмкости, а также продолжает исследовать NVMe-совместимые решения совместно со своими партнёрами. Apple отстранила главу разработки ИИ из-за «утраты доверия» — за Siri теперь возьмётся идейный создатель Vision Pro

21.03.2025 [06:12],

Дмитрий Федоров

Apple провела перестановки в руководстве подразделений, связанных с ИИ и голосовым ассистентом Siri. Майк Роквелл (Mike Rockwell), руководитель отдела разработки Vision Pro, назначен новым главой подразделения ИИ, сменив Джона Джаннандреа (John Giannandrea), утратившего доверие Тима Кука (Tim Cook). Эти изменения произошли на фоне задержки запуска генеративного ИИ и растущего напряжения внутри компании.

Источник изображения: Zhiyue / Unsplash Согласно источникам Bloomberg, решение о перестановках было принято после того, как генеральный директор Apple Тим Кук (Tim Cook) утратил уверенность в способности Джаннандреа эффективно управлять разработкой ИИ. Теперь Роквелл будет руководить как Siri, так и разработками в области ИИ в Apple. Одновременно с этим Пол Мид (Paul Meade), ранее отвечавший за разработку аппаратного обеспечения для гарнитуры дополненной реальности Apple Vision Pro под началом Роквелла, займёт пост главы Vision Pro Group. Ранее в этом месяце Apple в заявлении для техноблога Daring Fireball сообщила, что откладывает запуск обновлений генеративного ИИ для Siri до следующего года, поскольку разработка заняла больше времени, чем думали в компании. Позже Bloomberg сообщил о напряжённом совещании команды Siri, на котором старший директор Apple Робби Уокер (Robby Walker) назвал ситуацию с ИИ «уродливой». Сумеет ли Apple восстановить утраченный темп в гонке ИИ — вопрос, который пока остаётся открытым. OpenAI предоставила разработчикам свою самую дорогую ИИ-модель o1-pro

20.03.2025 [15:20],

Дмитрий Федоров

OpenAI выпустила более мощную версию своей ИИ-модели o1, получившую название o1-pro, и добавила её в API для разработчиков. По словам компании, o1-pro задействует больше вычислительных мощностей, чем o1, чтобы стабильно выдавать более качественные ответы. В настоящее время o1-pro доступна только избранным разработчикам — тем, кто уже потратил не менее $5 на услуги API OpenAI.

Источник изображения: OpenAI OpenAI установила тариф в $150 за 1 млн токенов, переданных в ИИ-модель на обработку (примерно 750 000 слов), и $600 за 1 млн токенов, сгенерированных ИИ-моделью. Это в два раза дороже, чем GPT-4.5 при обработке входных данных, и в 10 раз дороже, чем «рассуждающая» ИИ-модель o1 при генерации текста. OpenAI рассчитывает, что повышенная производительность o1-pro убедит разработчиков платить такие внушительные суммы. Компания утверждает, что новинка использует дополнительные вычислительные ресурсы, чтобы «думать усерднее» и давать более точные ответы на сложные вопросы. «O1-pro в API — это версия o1, использующая больше вычислительных ресурсов, чтобы мыслить ещё глубже и давать ещё более точные ответы на самые сложные задачи», — заявил представитель OpenAI. Он добавил, что компания решила включить модель в API после многочисленных запросов от разработчиков. Однако первые отзывы об ИИ-модели o1-pro, которая с декабря 2024 года доступна на платформе ИИ-чат-ботов OpenAI для подписчиков ChatGPT Pro, оказались не слишком положительными. Пользователи обнаружили, что новинка с трудом справляется с головоломками судоку, а простые шутки про оптические иллюзии ставят её в тупик. Более того, некоторые внутренние тесты OpenAI, проведённые в конце 2024 года, показали, что o1-pro лишь незначительно превосходит o1 в задачах программирования и математики, но при этом демонстрирует более стабильные результаты. Человекоподобные роботы станут массовыми уже через несколько лет, заявили главы Nvidia и XPeng

20.03.2025 [13:41],

Алексей Разин

Сфера искусственного интеллекта и робототехника развиваются синхронно, поскольку от степени успеха первой будут зависеть темпы прогресса второй. Глава Nvidia считает, что на производстве человекоподобные роботы получат распространение менее чем через пять лет, а глава XPeng убеждён, что в домохозяйствах они освоятся примерно лет через пять.

Источник изображения: XPeng Как отмечает Reuters, свои заявления основатель Nvidia Дженсен Хуанг (Jensen Huang) сделал с трибуны GTC 2025 в Калифорнии. По его мнению, сроки появления человекоподобных роботов на рынке в достаточных количествах измеряются не пятью годами, а меньшим периодом. Впрочем, при этом пионерами внедрения таких роботов всё же станут предприятия, а не домохозяйства. На производстве в жёстко контролируемой и стандартизованной среде применять роботов гораздо проще и безопаснее, чем в домашней обстановке. О стоимости человекоподобных роботов глава Nvidia рассуждает достаточно свободно: «Стоимость очень, очень просто определить. Средняя ставка аренды человекоподобного робота сейчас достигает $100 000, и я думаю, что это очень хорошая экономика». По всей видимости, в такую сумму обходится годовая аренда передового человекоподобного робота, хотя период и не конкретизируется первоисточником. Напомним, что Илон Маск (Elon Musk) хочет сделать своих человекоподобных роботов Tesla Optimus максимально доступными — по $20 000 за штуку в неограниченное по времени пользование. Один из президентов китайского стартапа XPeng Брайан Гу Хонди (Brian Gu Hongdi) на этой неделе также подчеркнул, что его компания будет в первую очередь внедрять человекоподобных роботов в коммерческом секторе, но уже в ближайшие несколько лет ёмкость рынка таких роботов превысит сегмент автомобильного транспорта. Прежде чем человекоподобные роботы получат распространение в быту, однако, пройдёт не менее пяти лет, по мнению руководства XPeng. К концу следующего года китайская компания наладит массовый выпуск не только человекоподобных роботов, но и летающих электромобилей. В ближайшие 20 лет XPeng намеревается потратить на разработку человекоподобных роботов не менее $6,9 млрд. В августе компания представила процессор Turing AI собственной разработки, который найдёт применение как в системах автопилота, так и в роботах данной марки. Машины с автономностью четвёртого уровня XPeng начнёт выпускать в 2026 году. Nvidia перестала быть геймерской компанией, а стала «фабрикой ИИ»

20.03.2025 [10:50],

Алексей Разин

Бессменный генеральный директор Nvidia, который на протяжении более тридцати лет ведёт компанию к успеху, на разных этапах этого пути провозглашает новый статус своего детища. На GTC 2025, окрылённый успехом Nvidia на рынке компонентов для ИИ, он заявил, что компания является провайдером инфраструктуры для соответствующих систем.

Источник изображения: Nvidia «Nvidia является компанией, связанной с инфраструктурой ИИ. Мы инфраструктурная компания, а не просто "купи-продай чипы"», — высказался Дженсен Хуанг (Jensen Huang) на пресс-конференции в Калифорнии, которая последовала за его выступлением с докладом на открытии GTC 2025. Необходимость заблаговременно делиться подробностями относительно будущих продуктов глава Nvidia пояснил на примере контраста с другими компаниями. По его словам, никто из производителей смартфонов не анонсирует по четыре последовательно выходящие модели смартфонов за раз. Это просто не имеет смысла, как подчеркнул Хуанг. «Инфраструктура ИИ — это не то, что ты покупаешь сегодня и вводишь в строй завтра. Это то, во что ты вкладываешь средства на протяжении двух лет заранее и имеешь план на весь этот двухлетний период, и надеешься, что сможешь развернуть достаточно быстро», — сообщил глава Nvidia. Именно с учётом таких сроков компания представила накануне вычислительные архитектуры, которые лягут в основу продуктов, выпускаемых в период с 2026 по 2028 годы. «Все должны располагать одинаковой информацией и планировать свои действия сообща, чтобы построить инфраструктуру для всего мира», — добавил Хуанг. Глава компании также назвал Nvidia «фабрикой ИИ», которая помогает клиентам зарабатывать деньги: «Теперь мы — фабрика искусственного интеллекта. Это значит, что фабрика помогает клиентам зарабатывать деньги. Наши фабрики напрямую приносят клиентам доход». «Уровень бизнеса гораздо выше, чем ранее. Конкуренция гораздо выше, чем ранее. Прав на ошибку у всех наших клиентов значительно меньше. Это рассчитанный на несколько лет инвестиционный цикл, поэтому речь идёт о сотнях миллиардов долларов», — пояснил гендиректор Nvidia возросший уровень ответственности компании перед клиентами. Влияние 20-процентной пошлины в США на бизнес Nvidia основателя компании пока не особо пугает. Сеть поставщиков продукции Nvidia достаточно развита, по его словам. Это не только Тайвань, но и Мексика, а также Вьетнам. Они распределены по многим местам. В ближайшее время всё будет зависеть от того, какие из стран подвергнутся повышенным пошлинам. Значительного влияния подобные изменения на финансовые результаты деятельности Nvidia всё равно пока не окажут, как убеждено руководство компании. В долгосрочной же перспективе Nvidia будет развивать производство своей продукции на территории США. «У нас есть возможность многое изготавливать в США. Не всё, но многое», — пояснил Дженсен Хуанг, добавив, что TSMC уже снабжает компанию выпускаемыми в штате Аризона компонентами. Намерения TSMC вложить $165 млрд на развитие шести предприятий на территории США внушают руководству Nvidia уверенность в успехе локализации производства продукции этой марки. В интервью Financial Times Дженсен Хуанг заявил, что Nvidia готова в ближайшие четыре года потратить сотни миллиардов долларов на покупку продукции американского производства для своих нужд. Во всяком случае, на территории США производить необходимые Nvidia изделия могут тайваньские компании Foxconn и TSMC. По состоянию на конец января прошлого года Nvidia располагала обязательствами на закупку продукции сторонних компаний на общую сумму $20 млрд. Соответственно, за несколько лет с учётом роста рынка соответствующие затраты в одних только США легко могут возрасти на порядок. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |