|

Опрос

|

реклама

Быстрый переход

Anthropic научила чат-бот Claude имитировать стиль письма пользователя, причём бесплатно

27.11.2024 [08:47],

Анжелла Марина

Компания Anthropic представила новую функцию для своего чат-бота искусственного интеллекта Claude, аналогичную ChatGPT и Gemini, позволяющую устанавливать стиль генерируемых текстов. Можно выбрать либо один из трёх готовых пресетов, либо создать индивидуальный, соответствующий личным предпочтениям и задачам пользователя.

Источник изображения: Anthropic Для быстрого выбора, как информирует The Verge, помимо стандартного доступны три готовых стиля: Formal, Concise и Explanatory. Formal (формальный) для создания чёткого и аккуратного текста, Concise (краткий) для лаконичных ответов, Explanatory (толковый) для текстов с дополнительными деталями. Если ни один из пресетов не подходит, Claude может обучиться индивидуальному стилю пользователя. Для этого необходимо загрузить примеры текста, отражающие предпочтительный стиль, и дать чат-боту дополнительные инструкции, если это необходимо. Можно также сохранить несколько пользовательских стилей. Функция ориентирована на тех, кто хочет сделать взаимодействие с ИИ более естественным и уместным для разных контекстов. «Вы можете выбирать между подробными текстами, когда учитесь чему-то новому, или краткими ответами, если спешите. Можно настроить Claude так, чтобы он звучал более формально в одних случаях или дружелюбно и непринуждённо в других, — объясняет руководитель продукта Anthropic Скотт Уайт (Scott White), — Главное, что теперь вы можете задать эти предпочтения один раз и получить идеальные ответы в дальнейшем». Несмотря на то, что новая функция индивидуального стиля письма делает использование Claude более гибким и максимально персонализированным, она не является такой уж уникальной. Например, ChatGPT и Gemini предлагают аналогичные возможности для настройки тона и уровня деталей в ответах. Gemini также используется для быстрой корректировки черновиков в Gmail, а Writing Tools компании Apple предлагает похожие пресеты. Главный конкурент OpenAI получил $4 млрд на развитие ИИ без следов Хуанга

22.11.2024 [23:13],

Владимир Фетисов

Компания Amazon объявила об инвестировании ещё $4 млрд в компанию Anthropic, которая занимается разработками в сфере искусственного интеллекта и является создателем ИИ-чат-бота Claude. Таким образом, общая сумма финансирования достигла $8 млрд — $1,25 млрд Anthropic получила в сентябре прошлого года, а ещё $2,75 млрд в марте этого года.

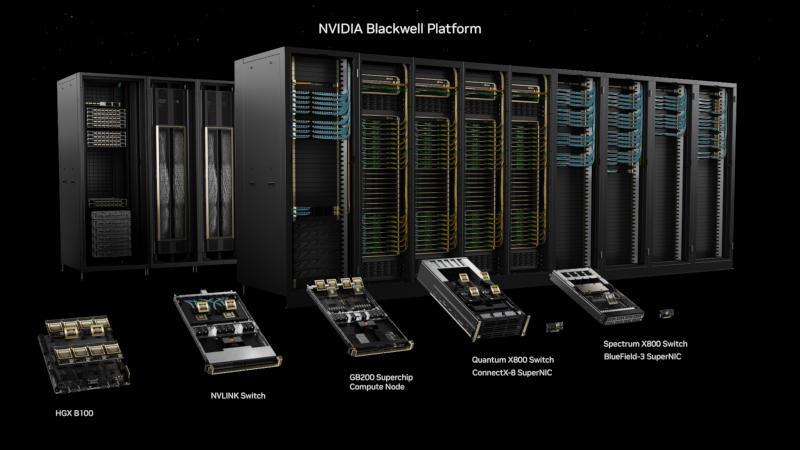

Источник изображения: anthropic.com Помимо денежного финансирования, облачная платформа Amazon Web Services станет «основным партнёром по обучению» нейросетей Anthropic. Также было сказано, что в будущем один из главных конкурентов OpenAI будет использовать ИИ-ускорители AWS Trainium и Inferentia при обучении больших языковых моделей. Это полномасштабная атака на Nvidia, которая в настоящее время доминирует на рынке чипов для систем искусственного интеллекта благодаря своим графическим процессорам, серверам и платформе CUDA. Акции Nvidia упали более чем на 3 % в пятницу после появления новостей об инвестициях Amazon в Anthropic. Новые инвестиции и более тесное партнёрство Amazon и Anthropic согласуются с недавними сообщениями СМИ, в которых говорилось что алгоритм Claude станет основой голосового помощника Amazon Alexa нового поколения. Обновлённая Alexa, запуск которой в массы был отложен, по данным источника, работала лучше с Claude, чем при использовании модели собственной разработки Amazon. Ожидается, что Amazon представит официально помощника Alexa нового поколения в 2025 году. Несмотря на увеличение инвестиций, Amazon рискует ещё больше отстать в гонке по созданию передовых ИИ-алгоритмов, где в числе лидеров OpenAI и Microsoft. Разработчики обещают, что речь обновлённой Alexa будет больше походить на человеческую, но пользователи бета-версии помощника сообщали о медленной отзывчивости, неестественных и бесполезных ответах на задаваемые вопросы. Anthropic и правительство США проверяют искусственный интеллект на утечку ядерных секретов

15.11.2024 [05:15],

Анжелла Марина

Компания Anthropic, специализирующаяся на разработке искусственного интеллекта, совместно с Министерством энергетики США проводит уникальные испытания своей модели Claude 3 Sonnet. Целью эксперимента является проверка способности ИИ «не делиться» потенциально опасной информацией, связанной с ядерной энергетикой, в частности, с созданием оружия.

Источник изображения: Copilot Как стало известно изданию Axios, специалисты из Национального управления ядерной безопасности (NNSA) при Министерстве энергетики США с апреля этого года проверяют модель Claude 3 Sonnet, чтобы убедиться, что она не может быть использована для создания атомного оружия. В ходе «красных запросов» эксперты манипулируют системой, пытаясь её «сломать». По словам Anthropic, подобные тесты, проходящие в совершенно секретной среде, являются первыми в своём роде и могут открыть путь для аналогичных взаимоотношений с другими государственными структурами. «В то время как американская промышленность лидирует в разработке передовых ИИ-моделей, федеральное правительство приобретает уникальный опыт, необходимый для оценки систем искусственного интеллектана предмет определенных рисков для национальной безопасности», — заявила руководитель отдела политики национальной безопасности Anthropic Марина Фаваро (Marina Favaro). Представители NNSA также подчеркнули важность работы в этом направлении. Вендэн Смит (Wendin Smith), заместитель администратора NNSA, заявила, что ИИ является «одной из ключевых технологий, которая требует постоянного внимания в контексте национальной безопасности». Anthropic планирует и дальше продолжить сотрудничество с правительством, чтобы разработать более надёжные меры безопасности для своих систем. Пилотная программа, в рамках которой тестируется также более новая модель Claude 3.5 Sonnet, продлится до февраля 2024 года. Компания обещает поделиться результатами тестирования с научными лабораториями и другими организациями. Пузырь ИИ сдувается, пока OpenAI, Google и Anthropic пытаются создать более продвинутый ИИ

13.11.2024 [19:26],

Сергей Сурабекянц

Три ведущие компании в области искусственного интеллекта столкнулись с ощутимым снижением отдачи от своих дорогостоящих усилий по разработке новых систем ИИ. Новая модель OpenAI, известная как Orion, не достигла желаемой компанией производительности, предстоящая итерация Google Gemini не оправдывает ожиданий, а Anthropic столкнулась с отставанием в графике выпуска своей модели Claude под названием 3.5 Opus.

Источник изображения: unsplash.com После многих лет стремительного выпуска всё более сложных продуктов ИИ три ведущие в этой сфере компании наблюдают убывающую отдачу от дорогостоящих усилий по созданию новых моделей. Становится все труднее находить свежие, ещё неиспользованные источники высококачественных данных для обучения более продвинутых систем ИИ. А нынешних весьма скромных улучшений недостаточно, чтобы окупить огромные затраты, связанные с созданием и эксплуатацией новых моделей, как и оправдать ожидания от выпуска новых продуктов. Так, OpenAI утверждала, что находится на пороге важной вехи. В сентябре завершился начальный раунд обучения для новой масштабной модели Orion, которая должна была приблизится к созданию мощного ИИ, превосходящего людей. Но ожидания компании, по утверждению осведомлённых источников, не оправдались. Orion не смогла продемонстрировать прорыва, который ранее показала модель GPT-4 по сравнению с GPT-3.5.

Источник изображения: Pixabay Anthropic, как и её конкуренты, столкнулась с трудностями в процессе разработки и обучения 3.5 Opus. По словам инсайдеров, модель 3.5 Opus показала себя лучше, чем старая версия, но не так значительно, как ожидалось, учитывая размер модели и затраты на её создание и запуск. Эти проблемы бросают вызов утвердившемуся в Кремниевой долине мнению о масштабируемости ИИ. Приверженцам глобального внедрения ИИ приходится признать, что бо́льшая вычислительная мощность, увеличенный объём данных и более крупные модели пока не прокладывают путь к технологическому прорыву в области ИИ.

Источник изображения: Nvidia Эксперты высказывают обоснованные сомнения в окупаемости крупных инвестиций в ИИ и достижимости всеобъемлющей цели, к которой стремятся разработчики ИИ-моделей, — создания общего искусственного интеллекта (AGI). Этот термин обычно применяется к гипотетическим ИИ-системам, способным соответствовать или превосходить человека в большинстве интеллектуальных задач. Руководители OpenAI и Anthropic ранее заявляли, что AGI может появиться уже через несколько лет. Технология, лежащая в основе ChatGPT и конкурирующих ИИ-чат-ботов, была создана на основе данных из социальных сетей, онлайн-комментариев, книг и других источников из интернета. Этих данных хватило для создания продуктов, генерирующих суррогатные эссе и поэмы, но для разработки систем ИИ, которые превзойдут интеллектом лауреатов Нобелевской премии — как надеются некоторые компании, — могут потребоваться другие источники данных, помимо сообщений в Википедии и субтитров YouTube.

Источник изображения: unsplash.com OpenAI была вынуждена заключить соглашения с издателями, чтобы удовлетворить хотя бы часть потребности в высококачественных данных, а также адаптироваться к растущему юридическому давлению со стороны правообладателей контента, используемого для обучения ИИ. Отмечается высокий спрос на рынке труда на специалистов с высшим образованием, которые могут маркировать данные, связанные с их областью компетенции. Это помогает сделать обученные ИИ-системы более эффективными в ответах на запросы. Подобные усилия обходятся дороже и требуют на порядок больше времени, чем простое индексирование интернета. Поэтому технологические компании обращаются к синтетическим данным, таким как сгенерированные компьютером изображения или текст, имитирующие контент, созданный людьми. Однако у такого подхода есть свои ограничения, так как трудно добиться качественного улучшения при использовании подобных данных для обучения ИИ. Тем не менее компании ИИ продолжают следовать принципу «чем больше, тем лучше». В стремлении создавать продукты, приближающиеся к уровню человеческого интеллекта, технологические компании увеличивают объём вычислительной мощности, данных и времени, затрачиваемых на обучение новых моделей, что приводит к росту расходов. Генеральный директор Anthropic Дарио Амодеи (Dario Amodei) заявил, что в этом году компании потратят $100 млн на обучение новейших моделей, а в ближайшие годы эта сумма может достичь $100 млрд.

Источник изображения: unsplash.com Безусловно, потенциал для улучшения моделей ИИ, помимо масштабирования, существует. Например, для своей новой модели Orion OpenAI применяет многомесячный процесс пост-обучения. Эта процедура включает использование обратной связи от людей для улучшения ответов и уточнения «эмоциональной окраски» взаимодействия с пользователями. Разработчики ИИ-моделей оказываются перед выбором: либо предлагать старые модели с дополнительными улучшениями, либо запускать чрезвычайно дорогие новые версии, которые могут работать ненамного лучше. По мере роста затрат растут и ожидания — стремительное развитие ИИ на начальном этапе создало завышенные ожидания как у специалистов, так и у инвесторов. Amazon планирует многомиллиардные инвестиции в разработчика конкурента ChatGPT

08.11.2024 [13:43],

Дмитрий Федоров

Amazon, один из крупнейших игроков на рынке облачных вычислений, рассматривает возможность новых многомиллиардных инвестиций в стартап Anthropic, активно развивающий ИИ и являющийся конкурентом OpenAI. В сентябре прошлого года Amazon уже инвестировала $4 млрд в Anthropic, что позволило ей предложить своим клиентам ранний доступ к инновационным разработкам стартапа. В рамках партнёрства Anthropic использует облачные серверы и вычислительные мощности Amazon для обучения своих ИИ-моделей.

Источник изображения: anthropic.com По имеющимся данным, Amazon предложила Anthropic использовать больше серверов с чипами её собственной разработки, чтобы усилить вычислительные мощности стартапа, необходимые для обучения ИИ-моделей. С одной стороны, это способствует укреплению позиций Amazon на рынке облачных технологий, а с другой — подчёркивает намерение компании продемонстрировать возможности собственных аппаратных решений. Однако Anthropic предпочитает использовать серверы, оснащённые чипами Nvidia, что говорит о повышенных требованиях стартапа к мощности используемого оборудования для обработки больших данных и обучения сложных ИИ-моделей. Компания Anthropic была основана бывшими руководителями OpenAI, Дарио Амодеи (Dario Amodei) и Даниэлой Амодеи (Daniela Amodei), и с момента создания привлекла серьёзное внимание крупных технологических корпораций. В прошлом году стартап получил $500 млн инвестиций от материнской компании Google — Alphabet, которая также обязалась вложить дополнительно $1,5 млрд. Для Amazon укрепление сотрудничества с Anthropic — важный шаг в конкурентной борьбе на рынке облачных технологий, где лидируют такие компании, как Microsoft и Google. В условиях усиливающейся конкуренции расширение портфеля ИИ-решений позволяет Amazon привлекать больше корпоративных клиентов, заинтересованных в передовых технологиях, интегрированных с её облачными сервисами. Обеспечивая своим клиентам доступ к разработкам Anthropic, Amazon укрепляет свои позиции в качестве поставщика инновационных ИИ-решений. ИИ-чат-бот Anthropic Claude научился анализировать данные — для этого он сам пишет и выполняет код

25.10.2024 [17:57],

Павел Котов

Компания Anthropic представила новый инструмент для анализа данных, который помогает её чат-боту с искусственным интеллектом Claude давать «математически точные и воспроизводимые ответы». Для этого он самостоятельно пишет код на JavaScript и выполняет его, проверяя ответы, которые он даёт пользователям.

Источник изображения: anthropic.com Инструмент, который пока доступен в предварительной версии, позволяет Claude анализировать данные электронных таблиц и файлов PDF, производя вычисления и представляя результаты в виде интерактивных визуализаций. «Считайте, что инструмент анализа — это встроенная песочница кода, где Claude может выполнять сложные математические вычисления, анализировать данные и перебирать различные идеи, прежде чем дать ответ. Вместо того, чтобы полагаться только на абстрактный анализ, он может систематически обрабатывать данные — очищать, исследовать и анализировать их шаг за шагом, пока не получит правильный ответ», — рассказали в Anthropic. К примеру, менеджер по продукту может выгрузить данные о продажах и попросить Claude провести анализ показателей по конкретной стране; аналитик может отправить чат-боту ежемесячные финансовые данные и попросить его построить панель мониторинга с ключевыми тенденциями. Claude мог выполнять эти задачи и раньше, но за отсутствием механизма для математической проверки результатов его ответы не всегда были точными. Функции написания и запуска кода есть у Google Gemini и флагманских моделей OpenAI. Пользователь больше не нужен — новая ИИ-модель Anthropic сама управляет ПК

22.10.2024 [19:52],

Сергей Сурабекянц

Прошлой весной Anthropic заявила о намерении создать «алгоритм нового поколения для самообучения ИИ», который сможет самостоятельно выполнять большинство офисных задач, что позволило бы автоматизировать значительную часть экономики. Сегодня компания выпустила версию 3.5 своей модели Claude Sonnet, которая может через API Computer Use взаимодействовать с любым десктопным приложением, имитировать нажатия клавиш, клики и жесты мыши, полностью эмулируя человека.

Источник изображения: Pixabay «Мы обучили Claude видеть, что происходит на экране, а затем использовать доступные программные инструменты для выполнения задач, — сообщает Anthropic. — Когда разработчик поручает Claude использовать часть компьютерного программного обеспечения и даёт ему необходимый доступ, Claude смотрит на скриншоты того, что видит пользователь, затем подсчитывает, на сколько пикселей по вертикали или горизонтали ему нужно переместить курсор, чтобы щёлкнуть в нужном месте». Подобный инструмент, так называемый «агент ИИ», который может автоматизировать задачи на ПК, не является новой идеей. Термин агент ИИ пока остаётся нечётко определённым, но обычно под ним подразумевается ИИ, способный автоматизировать работу с программным обеспечением на ПК. Множество компаний сегодня предлагают подобные инструменты, начиная с Microsoft, Salesforce и OpenAI, и заканчивая новыми игроками, такими как Relay, Induced AI и Automat. Стартап потребительских гаджетов Rabbit представил агента, который умеет самостоятельно покупать билеты онлайн. Adept, недавно приобретённый Amazon, обучает модели просмотру сайтов и навигации по программному обеспечению. Twin Labs использует готовые модели, включая GPT-4o от OpenAI, для автоматизации процессов рабочего стола. Некоторые аналитики уверены, что агенты ИИ смогут обеспечить компаниям более простой способ монетизации миллиардов долларов, которые они вливают в ИИ. Согласно недавнему опросу Capgemini, 10 % организаций уже используют агентов ИИ, а 82 % планируют интегрировать их в течение следующих трёх лет.

Источник изображения: unsplash.com Anthropic называет свою концепцию агента ИИ «слоем действия-исполнения», который позволяет ему выполнять команды на уровне рабочего стола. Благодаря способности просматривать веб-страницы, Claude 3.5 Sonnet может использовать в работе любой сайт и любое приложение. «Люди контролируют процесс при помощи подсказок, направляющих действия Claude, например, “использовать данные с моего компьютера и из сети, чтобы заполнить эту форму”, — поясняет представитель Anthropic. — Люди разрешают доступ и ограничивают его по мере необходимости. Claude разбивает подсказки пользователя на компьютерные команды (например, перемещение курсора, нажатие, ввод текста) для выполнения этой конкретной задачи».

Источник изображений: Anthropic В чём отличие Claude 3.5 Sonnet от других агентов ИИ? Anthropic утверждает, что это просто более сильная, более надёжная модель, которая справляется с задачами кодирования лучше, чем даже флагманский o1 от OpenAI, согласно бенчмарку SWE-bench Verified. Claude самостоятельно корректирует и повторяет задачи, когда сталкивается с препятствиями, и может работать над целями, требующими десятков или сотен шагов. При этом Anthropic признает, что обновлённая модель испытывает трудности с базовыми действиями, такими как прокрутка и масштабирование, и может пропускать кратковременные события и уведомления из-за способа, которым она делает снимки экрана и объединяет их. Во время тестового бронирования авиабилетов Claude 3.5 Sonnet сумела успешно выполнить менее половины задач. В задаче возврата билетов новая модель не справилась примерно в трети случаев. Что касается безопасности, недавнее исследование показало, что даже модели не имеющие возможности использовать настольные приложения, такие как GPT-4o от OpenAI, могут быть задействованы во вредоносном «многошаговом агентском поведении», например, заказать поддельный паспорт в даркнете. Подобные результаты были достигнуты исследователями с использованием методов джейлбрейка, что привело к высокому проценту успешно выполненных вредоносных задач даже для защищённых моделей. Можно предположить, что модель с доступом к управлению ПК может нанести значительно больший ущерб — например, используя уязвимости приложений для компрометации личной информации (или сохранения чатов в виде открытого текста). Помимо имеющихся в её распоряжении программных рычагов, сетевые и прикладные соединения модели могут открыть широкие возможности для злоумышленников.  Anthropic не отрицает, что использование Claude 3.5 Sonnet подвергает пользователя дополнительным рискам. Но по мнению компании «гораздо лучше предоставить компьютерам доступ к сегодняшним более ограниченным, относительно безопасным моделям — так мы можем начать наблюдать и извлекать уроки из любых потенциальных проблем, которые возникают на этом более низком уровне, постепенно и одновременно наращивая использование компьютеров и меры по снижению рисков для безопасности». Anthropic заявляет, что предприняла некоторые шаги для предотвращения ненадлежащего использования, например, не обучала новую модель на снимках экрана и подсказках пользователей и не давала модели выходить в интернет во время обучения. Компания разработала классификаторы для предотвращения высокорисковых действий, таких как публикация в социальных сетях, создание учётных записей и взаимодействие с правительственными ресурсами. Anthropic сообщила, что у неё есть возможность «при необходимости» ограничить доступ к дополнительным функциям, например, для защиты от спама, мошенничества и дезинформации. В качестве меры предосторожности компания хранит все снимки экрана, сделанные Computer Use, не менее 30 дней, что может создать дополнительную угрозу безопасности и конфиденциальности. Anthropic не сообщила при каких обстоятельствах она может передать снимки экрана третьей стороне (например, правоохранительным органам). «Не существует надёжных методов, и мы будем постоянно оценивать и совершенствовать наши меры безопасности, чтобы сбалансировать возможности Claude с ответственным использованием, — утверждает Anthropic. — Тем, кто использует компьютерную версию Claude, следует принять соответствующие меры предосторожности, чтобы минимизировать подобные риски, включая изоляцию Claude от особо конфиденциальных данных на своём компьютере».

Источник изображения: Pixabay Одновременно с выпуском модели Claude 3.5 Sonnet, Anthropic анонсировала скорый выход обновлённой версии Claude 3.5 Haiku. «Благодаря высокой скорости, улучшенному следованию инструкциям и более точному использованию инструментов Claude 3.5 Haiku хорошо подходит для продуктов, ориентированных на пользователя, специализированных задач субагентов и создания персонализированного опыта из огромных объёмов данных, таких как история покупок, цены или данные об инвентаре», — говорится в блоге Anthropic. Haiku изначально будет доступна как текстовая модель, а затем как часть мультимодального пакета, который может анализировать как текст, так и изображения. Что касается выпуска обновлённой модели Claude 3.5 Opus, представитель Anthropic заявил: «Все модели в семействе Claude 3 имеют своё индивидуальное применение для клиентов. Claude 3.5 Opus есть в нашей дорожной карте, и мы обязательно поделимся с вами подробностями, как только сможем». Разработчики уже могут протестировать Computer Use через API Anthropic, Amazon Bedrock и платформу Vertex AI от Google Cloud. OpenAI и Anthropic согласились сдавать новейшие ИИ-модели на проверку властям США

29.08.2024 [19:38],

Николай Хижняк

Компании OpenAI и Anthropic будут предоставлять правительству США доступ к своим новейшим большим языковым моделям искусственного интеллекта и до публичного релиза, «чтобы повысить их безопасность», пишет портал The Verge. Иными словами, власти США будут проверять, безопасно ли выпускать новые ИИ-модели в свет.

Источник изображения: Andrew Neel/unsplash.com Обе компании подписали меморандум о взаимопонимании с Американским институтом безопасности ИИ, согласно которому они обязуются предоставлять доступ к моделям ИИ как до, так и после их публичного выпуска. По словам ведомства, этот шаг позволит совместными усилиями проводить оценки рисков безопасности и устранять потенциальные проблемы. Американское агентство добавило, что в этой работе также будет участвовать британский институт безопасности ИИ. Как пишет The Verge, на этой неделе законодатели штата Калифорния одобрили принятие «Закона о безопасных и надёжных инновациях в области передовых моделей искусственного интеллекта». Этот закон требует от компаний, занимающихся разработкой ИИ в Калифорнии, принимать определённые меры предосторожности перед началом обучения передовых моделей искусственного интеллекта. К таким мерам, в частности, относится возможность быстрого и полного отключения модели ИИ, обеспечение защиты моделей ИИ от «небезопасных модификаций после обучения», а также оценка потенциальных рисков использования ИИ и его составляющих для «причинения критического вреда». Документ не нашёл поддержки со стороны компаний, занимающихся технологиями ИИ. OpenAI и Anthropic выступили против его принятия, отметив, что новый закон может негативно сказаться на небольших компаниях, занимающихся созданием технологий ИИ на базе открытого исходного кода. Официально новый закон пока не принят и ожидает подписи губернатора Калифорнии Гэвина Ньюсома (Gavin Newsom). Тем временем Белый дом работает над тем, чтобы стимулировать компании самостоятельно принимать и расширять меры безопасности, касающиеся технологий ИИ. Как сообщает The Verge, несколько ведущих фирм уже согласились инвестировать в исследования по вопросам кибербезопасности и дискриминации, а также заняться разработкой систем маркировки (водяных знаков) для контента, созданного ИИ. ИИ-приложение Anthropic Claude для iOS и Android принесло разработчикам более $1 млн выручки

22.08.2024 [04:32],

Владимир Фетисов

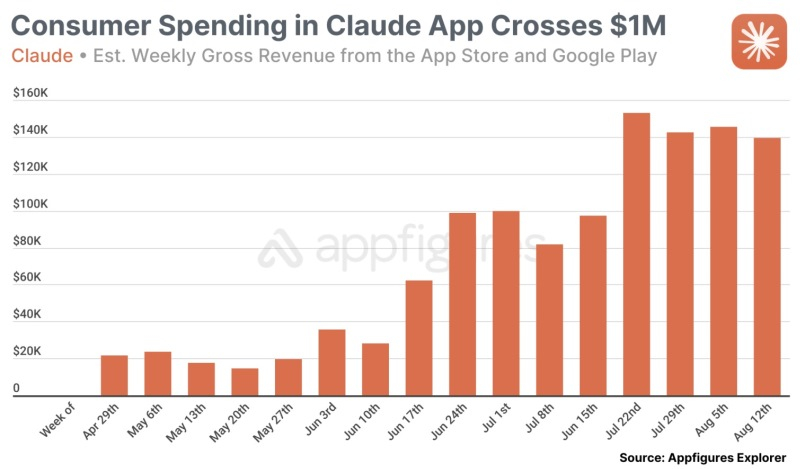

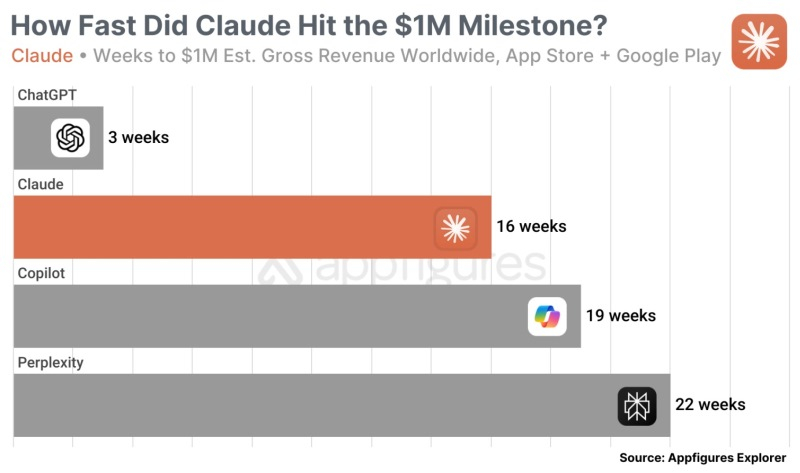

На это ушло 16 недель, но ИИ-приложение Claude компании Anthropic преодолело важный рубеж — оно перешагнуло отметку в $1 млн выручки от мобильных приложений для iOS и Android. По данным компании Appfigures, занимающейся анализом мобильных приложений, почти половину выручки Claude принесли пользователи из США.

Источник изображения: Anthropic Несмотря на важное достижение, Claude по-прежнему находится далеко позади главного конкурента в лице ChatGPT. Приложение компании OpenAI для платформы iOS занимает первое место по общему количеству загрузок и 26-е по объёму полученной выручки в США. В это же время Claude находится на 95-м месте в категории «Продуктивность» по количеству загрузок и на 68-м по выручке в той же категории.

Источник изображения: Appfigures Ранее в этом году СМИ писали, что мобильное приложение Claude за первую неделю своего существования на рынке получило слабый отклик — пользователи по всему миру скачали его 157 тыс. раз. Для сравнения, приложение ChatGPT за первые пять дней после запуска в США только на iOS было скачано 480 тыс. раз. По данным Appfigures, лучшим результатом Claude в США было 55-е место в рейтинге бесплатных приложений для iOS, чего удалось добиться через несколько дней после запуска. Несмотря на это, разработчикам Claude удалось получить первый миллион выручки быстрее, чем другим конкурентам, продвигающим ИИ-приложения. Несмотря на то, что Claude значительно отстаёт от ChatGPT, которому потребовалось всего три недели для достижения отметки в $1 млн выручки, он обогнал Microsoft Copilot и Perplexity, которые добились аналогичного результата через 19 и 22 недели после запуска соответственно.

Источник изображения: Appfigures Крупнейшим рынком для Claude по количеству загрузок является США с долей 32,5 %. Следом идут рынки Индии (9,6 %), Японии (6,8 %), Великобритании (5,1 %) и Германии (3,2 %). В совокупности на эти пять рынков приходится 57,2 % установок мобильных приложений Claude. В плане монетизации Claude ситуация выглядит похожим образом. Наибольший доход приносит рынок США (48,4 %). Далее идут рынки Японии (6,7 %), Германии (4,3 %), Великобритании (4,3 %) и Южной Кореи (2,8 %). Совокупно на эти страны приходится 66,8 % выручки мобильных приложений Claude. Авторы обвинили разработчика чат-бота Claude в пиратстве их книг

21.08.2024 [05:07],

Анжелла Марина

Компания Anthropic, разработчик чат-бота Claude, столкнулась с новым иском о нарушении авторских прав. Авторы утверждают, что компания использовала для обучения искусственного интеллекта их книги и сотни тысяч книг других авторов без разрешения.

Источник изображения: anthropic.com По сообщению Reuters, среди истцов оказались писатели Андреа Бартц (Andrea Bartz), Чарльз Грэбер (Charles Graeber) и Кирк Уоллес Джонсон (Kirk Wallace Johnson). Они утверждают, что Anthropic использовала пиратские версии их произведений, требуя денежной компенсации и полного запрета на неправомерное использование произведений. Этот иск стал частью более широкого потока судебных разбирательств, инициированных правообладателями, включая художников, новостные агентства и звукозаписывающие компании. Они требуют разъяснений о том, как и на каком основании технологические компании свободно используют их материалы для обучения своих генеративных ИИ-систем. Представитель Anthropic сообщил во вторник, что компания осведомлена о поданном иске и проводит оценку жалобы, однако отказался комментировать ситуацию более подробно, сославшись на ведение судебного разбирательства. Адвокат авторов также воздержался от комментариев. Следует отметить, что это уже второй иск против Anthropic. В прошлом году музыкальные издатели подали иск, обвинив компанию в неправомерном использовании защищённых авторским правом текстов песен для обучения Claude. Ранее несколько групп авторов подали иски против таких компаний, как OpenAI и Meta✴, обвинив их в аналогичном незаконном использовании произведений для обучения своих языковых моделей. Anthropic заплатит до $15 000 хакерам, которые найдут уязвимости в её ИИ-системах

09.08.2024 [17:14],

Анжелла Марина

Компания Anthropic объявила о запуске расширенной программы поиска уязвимостей, предлагая сторонним специалистам по кибербезопасности вознаграждение до 15 000 долларов за выявление критических проблем в своих системах искусственного интеллекта.

Источник изображения: Copilot Инициатива направлена на поиск «универсальных методов обхода», то есть способов взлома, которые могли бы последовательно обходить меры безопасности ИИ в таких областях высокого риска, как химические, биологические, радиологические и ядерные угрозы, а также в области киберпространства. Как сообщает ресурс VentureBeat, компания Anthropic пригласит этичных хакеров для проверки своей системы ещё до её публичного запуска, чтобы сразу предотвратить потенциальные эксплойты, которые могут привести к злоупотреблению её ИИ-системами. Интересно, что данный подход отличается от стратегий других крупных игроков в области ИИ. Так, OpenAI и Google имеют программы вознаграждений, но они больше сосредоточены на традиционных уязвимостях программного обеспечения, а не на специфических для ИИ-индустрии эксплойтах. Кроме того, компания Meta✴ недавно подверглась критике за относительно завуалированную позицию в области исследований безопасности ИИ. Напротив, явная нацеленность Anthropic на открытость устанавливает новый стандарт прозрачности в этом вопросе. Однако эффективность программ поиска уязвимостей в решении всего спектра проблем безопасности ИИ остаётся спорной. Эксперты отмечают, что может потребоваться более комплексный подход, включающий обширное тестирование, улучшенную интерпретируемость и, возможно, новые структуры управления, необходимые для обеспечения глобального соответствия систем искусственного интеллекта человеческим ценностям. Программа стартует как инициатива по приглашению (закрытое тестирование) в партнёрстве с известной платформой HackerOne, но в будущем Anthropic планирует расширить программу, сделав её открытой и создав отдельную независимую модель для отраслевого сотрудничества в области безопасности ИИ. Великобритания начала расследование инвестиций Amazon $4 млрд в ИИ-стартап Anthropic

09.08.2024 [13:30],

Владимир Мироненко

Управление по конкуренции и рынкам Великобритании (CMA) объявило об открытии расследования по поводу инвестиций и партнёрства Amazon с Anthropic с целью оценки, не нанесёт ли их сотрудничество ущерб конкуренции на региональном рынке.

Источник изображения: amazon.com После первоначального изучения партнёрства Amazon-Anthropic у CMA теперь есть «достаточно информации» в отношении объединения, чтобы начать официальное расследование, сообщается на веб-сайте ведомства. На первом этапе расследования (Phase 1), на который отводится 40 рабочих дней, регулятор рассмотрит все обстоятельства сделки, чтобы решить, не несёт ли она потенциальной угрозы конкуренции на рынке Великобритании. В случае, если подозрения оправдаются, регулятор приступит ко второму этапу (Phase 2) расследования с углублённым изучением деталей сделки. В марте этого года Amazon завершила намеченный транш инвестирования в Anthropic в размере $4 млрд. В сентябре прошлого года компания инвестировала в ИИ-стартап $1,25 млрд, после чего выделила в этом году дополнительно $2,75 млрд. Представитель Amazon сообщил ресурсу CNBC, что компания разочарована тем, что CMA приступила к первому этапу расследования, отметив, что сотрудничество с Anthropic не вызывает никаких проблем с конкуренцией, и в расследовании нет необходимости. «Инвестируя в Anthropic, Amazon вместе с другими компаниями помогает Anthropic расширить выбор и конкуренцию в этой важной технологии. Amazon не занимает места в совете директоров и не имеет полномочий принимать решения в Anthropic, и Anthropic может свободно работать с любым другим провайдером (и, действительно, имеет несколько партнёров)», — указал представитель Amazon в сообщении, направленном CNBC по электронной почте. Он также добавил, что Amazon продолжит предоставлять клиентам ИИ-модели Anthropic на своей платформе Bedrock. Соучредитель OpenAI Джон Шульман перешёл в Anthropic, а президент Грег Брокман взял длительный отпуск

06.08.2024 [11:20],

Павел Котов

Сооснователь OpenAI Джон Шульман (John Schulman) объявил о переходе в конкурирующую компанию Anthropic, а президент Грег Брокман (Greg Brockman) решил взять длительный отпуск, чтобы «отдохнуть и зарядиться» — он продлится до конца года. Некоторое время назад компанию также покинул менеджер по продуктам Питер Денг (Peter Deng) — он начал работать в OpenAI в прошлом году, а до того занимал аналогичные должности в Meta✴, Uber и Airtable.

Источник изображения: Mariia Shalabaieva / unsplash.com «Мы признательны за вклад Джона как члена команды основателей OpenAI и его ревностные усилия в развитии технологий согласования. Его страсть и упорный труд заложили прочную основу, которая будет вдохновлять и поддерживать будущие инновации в OpenAI и более широкой области», — приводит TechCrunch комментарий представителя OpenAI по поводу уходу Шульмана. Сам Шульман пояснил своё решение желанием вплотную заняться согласованием ИИ — разработкой мер, направленных на то, чтобы ИИ вёл себя, как задумано, — и переключиться на практическую техническую работу. «Я решил заняться этим в Anthropic, где, как считаю, могу получить новые перспективы и проводить исследования вместе с людьми, глубоко вовлечёнными в темы, которые меня интересуют больше всего. Уверен, что OpenAI и отделы, в которых я работал, продолжат процветать и без меня», — пояснил инженер. Шульман начал работать в OpenAI вскоре после получения докторской степени по электротехнике и компьютерным наукам в Калифорнийском университете в Беркли. Он сыграл ключевую роль в разработке ChatGPT, возглавив отдел OpenAI по обучению с подкреплением — настройке моделей генеративного ИИ для выполнения пользовательских запросов. После ухода специалиста по безопасности ИИ Яна Лейке (Jan Leike), который сейчас также работает в Anthropic, Шульман возглавил научный отдел по согласованию ИИ — и пока неясно, кто заменит его на этой должности. Есть мнение, что OpenAI пренебрегает мерами безопасности в отношении ИИ, но Шульман выдвигать обвинений не стал. «Руководство компании было очень привержено вложениям [в разработку технологий согласования ИИ]. Моё решение — личное, основанное на том, чем я хочу заниматься на новом этапе своей карьеры», — заявил он. Теперь в OpenAI остались лишь три человека, стоявшие у истоков компании: гендиректор Сэм Альтман (Sam Altman), Грег Брокман и Войцех Заремба (Wojciech Zaremba) — глава подразделения по генерации языка и кода. «Спасибо за всё, что ты сделал для OpenAI! Ты блестящий учёный, глубокий мыслитель о продуктах и обществе и, самое главное, большой друг для всех нас. Будем очень скучать по тебе, а ты будешь этим местом гордиться», — обратился к Шульману Сэм Альтман. Anthropic научила ИИ улучшать запросы к самому себе

10.07.2024 [14:23],

Павел Котов

В минувшем году одной из популярных новых профессий в области искусственного интеллекта стала должность инженера по составлению запросов к моделям ИИ. Теперь компания Anthropic решила автоматизировать эту задачу, поручив её самому ИИ.

Источник изображения: anthropic.com Большие языковые модели во многих случаях дают адекватные ответы даже на непрофессиональные запросы пользователей, но иногда даже небольшое изменение формулировки способно значительно повысить его качество. Обычно для этого приходится самостоятельно перебирать различные формулировки или прибегать к услугам инженера, но предложенная Anthropic новая функция способна упростить задачу. В панели управления Anthropic Console, предназначенной для разработки сторонних приложений на базе модели ИИ Claude, появилась новая вкладка Evaluate, связанная со встроенным генератором запросов. Этот генератор получает на вводе краткое описание запроса и генерирует на его основе гораздо более длинный и конкретный. Едва ли данный инструмент оставит инженеров без работы, но он может сэкономить им время и помочь рядовым пользователям. В разделе Evaluate разработчики сторонних приложений могут проверить, насколько эффективны генерируемые их приложениями подсказки в различных сценариях. Можно, например, загрузить действительный пример в тестовый набор или попросить Claude сгенерировать такие тестовые запросы самостоятельно, чтобы сравнить их эффективность и оценить ответы по пятибалльной шкале. В приведённом Anthropic примере разработчик установил, что его приложение выдаёт в нескольких тестовых случаях слишком короткие ответы — одна из строк в запросе помогла сделать их длиннее, после чего эту схему применили ко всем тестовым сценариям. Ранее соучредитель и гендиректор Anthropic Дарио Амодеи (Dario Amodei) отметил, что составление запроса является одним из важнейших аспектов для широкого внедрения генеративного ИИ. «Кажется, что это просто, но за 30 минут инженер по запросам часто может заставить приложение работать, если раньше оно не работало», — заявил Амодеи. Anthropic выпустила мощную ИИ-модель Claude 3.5 Sonnet — она доступна бесплатно и во многом лучше GPT-4o

20.06.2024 [21:14],

Анжелла Марина

Компания Anthropic, разработчик больших языковых моделей и ИИ-чат-бота Claude, анонсировал и сразу же запустил новую большую языковую модель Claude 3.5 Sonnet. По заявлению компании, эта нейросеть может сравниться или даже превзойти по возможностям GPT-4o от OpenAI и Gemini от Google. Новинка, как и её предшественница Claude 3 Sonnet, доступна как платным, так и бесплатным пользователям чат-бота Claude.

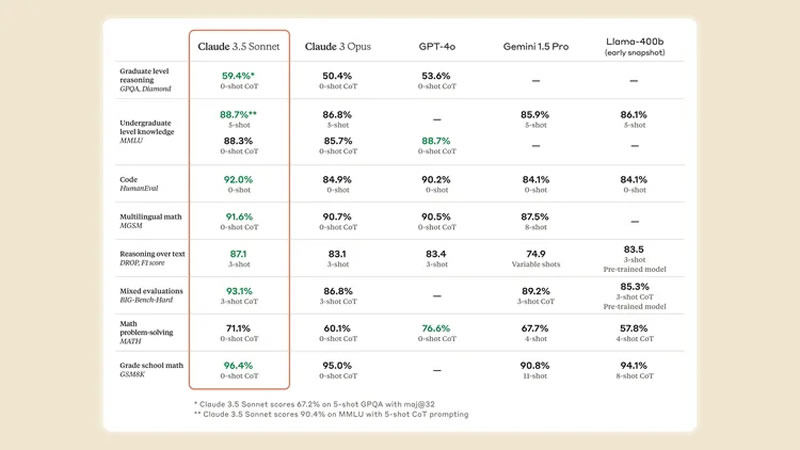

Источник изображения: Anthropic Как пишет The Verge, Claude 3.5 Sonnet является улучшенной версией предыдущей модели Claude 3 Opus, выпущенной всего несколько месяцев назад и прежде доступной лишь платным подписчикам Claude. Новая модель работает в два раза быстрее и показывает значительно лучшие результаты в различных задачах, включая написание программного кода, работу с большими запросами, интерпретацию диаграмм и графиков. Новая нейросеть теперь является стандартной для чат-бота Claude и доступна как платным, так и бесплатным пользователям. Фактически, это ответ на GPT-4o, на которой сейчас построен ChatGPT, в том числе в бесплатной версии. Согласно результатам тестирования, проведённого Anthropic, Claude 3.5 Sonnet превзошла модели GPT-4o, Gemini 1.5 Pro и Llama 3 400B от Meta✴ в 7 из 9 общих тестов производительности. В задачах распознавания изображений новая модель Anthropic также показала лучшие результаты.

Источник изображения: Anthropic Помимо новой модели, в приложение Claude была добавлена функция Artifacts. Она позволяет пользователям видеть и редактировать результаты запросов к ИИ прямо в интерфейсе приложения. Например, если Claude сгенерирует текст электронного письма, пользователь сможет отредактировать его, не копируя и не вставляя в другую программу. По словам разработчиков, функция Artifacts — это часть их стремления превратить Claude в единую платформу для хранения знаний и выполнения рабочих задач с использованием возможностей ИИ. Это отличает подход Anthropic от других компаний, сосредоточенных в основном на развитии чат-ботов. Как видно, конкурентная гонка в области ИИ продолжается. За последние месяцы как Anthropic, так и её основные конкуренты — OpenAI и Google — несколько раз выпускали улучшенные версии своих моделей. При этом каждый новый релиз демонстрирует значительный прогресс. Новая модель уже доступна зарегистрированным пользователям Claude в web и на iOS, а также для разработчиков. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |