|

Опрос

|

реклама

Быстрый переход

SK hynix и Samsung рассказали про память HBM4E: до 20 ярусов и 64 Гбайт в одном стеке

20.03.2025 [14:21],

Алексей Разин

Поскольку компания SK hynix уже созналась в начале поставок образцов микросхем памяти типа HBM4, было бы странно сохранять в тайне их характеристики. Представителям Computer Base удалось обобщить всю опубликованную в последние дни информацию о планах ведущих игроков рынка в сфере производства HBM4, и характеристики этой памяти интригуют.

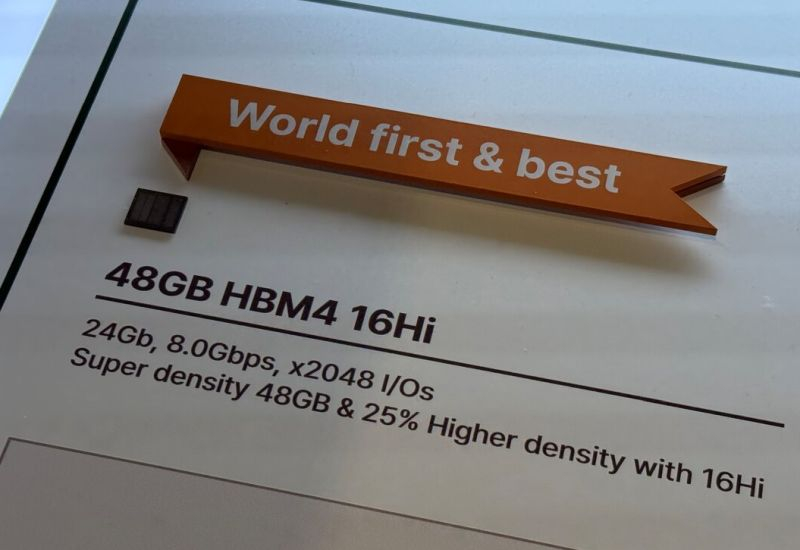

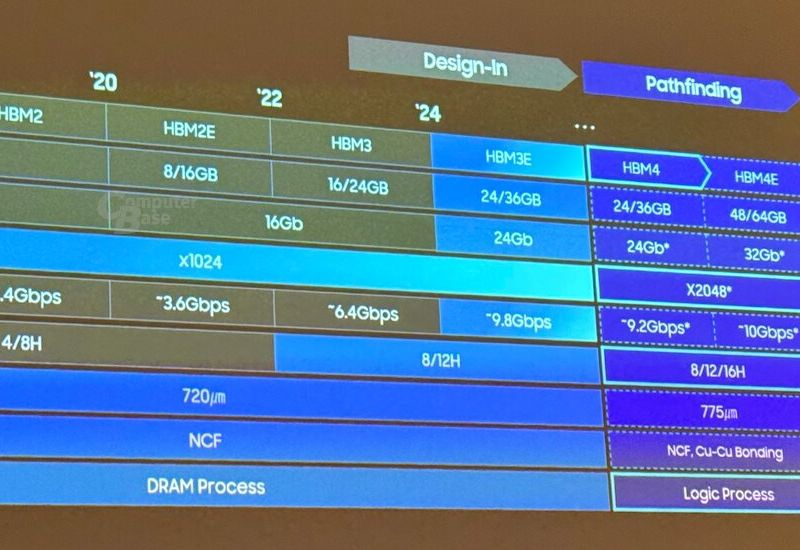

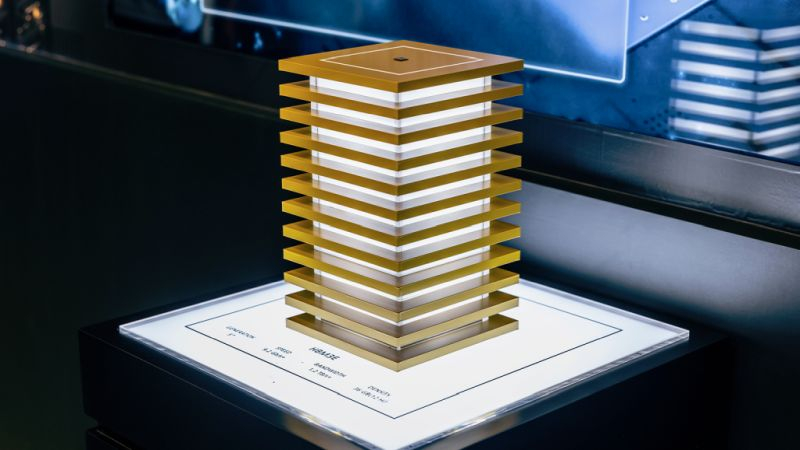

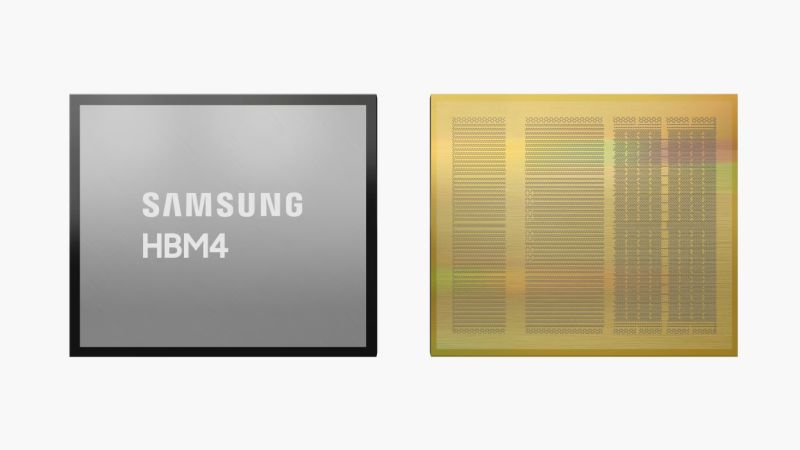

Источник изображения: ComputerBase.de Хотя SK hynix вчера объявила о начале поставки 12-ярусных стеков HBM4 объёмом 36 Гбайт со скоростью 8 Гбит/с. Но предельными эти показатели, конечно, не будут. Предсказуемо высота стеков сначала увеличится до 16 штук, а в перспективе достигнет и 20 штук, но последняя характеристика с высокой вероятностью будет присуща уже преемнице HBM4. SK hynix намерена предлагать 16-ярусные стеки HBM4 объёмом 48 Гбайт. Пропускной способностью в 8 Гбит/с тоже никто ограничиваться не собирается, поскольку та же Samsung Electronics намеревается поднять её до 9,2 Гбит/с.

Источник изображения: ComputerBase.de В эти дни отметилась даже американская Micron Technology, лаконично заявив, что в больших количествах начнёт выпускать память типа HBM4 в 2026 году. Samsung попутно поясняет, что в 16-ярусном исполнении намерена предлагать и HBM4, и HBM4E, но если в первом случае предельный объём стека ограничится 36 Гбайт, то во втором он достигнет 64 Гбайт. Одновременно с 9,2 до 10 Гбит/с вырастет и пропускная способность памяти. При выпуске HBM4 и HBM4E, как поясняет Samsung, будет использоваться более сложная литография, присущая технологиям выпуска логических компонентов. Скорее всего, она потребуется для выпуска базового кристалла стека. SK hynix начала поставлять образцы памяти HBM4 — 12 ярусов, 36 Гбайт и 2 Тбайт/с

19.03.2025 [09:47],

Алексей Разин

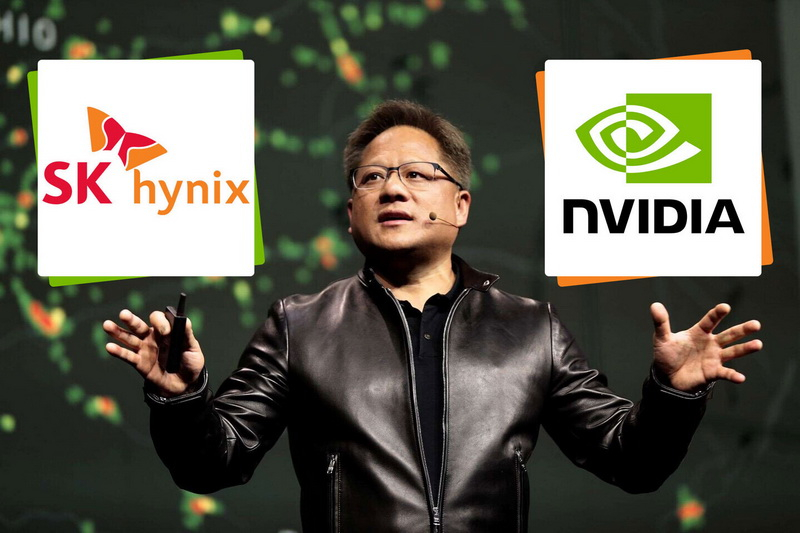

Южнокорейская компания SK hynix за счёт своих контрактов на поставку микросхем памяти HBM разных поколений для нужд Nvidia сильно нарастила свою выручку и прибыль, а также заняла половину рынка в соответствующем сегменте. Не желая сбавлять темп, она на этой неделе заявила о досрочном начале поставок клиентам образцов HBM4.

Источник изображения: SK hynix Как уточняется в пресс-релизе, речь идёт о 12-ярусных стеках HBM4, массовое производство которых будет запущено во второй половине текущего года. Примечательно, что SK hynix упоминает о «крупных клиентах» во множественном числе, говоря о начале отгрузки соответствующих образцов HBM4 для изучения ими. Подчёркивается, что поставки образцов начались раньше, чем планировалось изначально. Сертификация данной памяти клиентами скоро должна начаться. Ко второму полугодию всё должно быть готово для начала массового производства HBM4. Пропускная способность на уровне 2 Тбайт/с открывает перед пользователями HBM4 новые возможности в скоростной обработке данных, увеличивая скорость на 60 % по сравнению с HBM3E. Один стек, состоящий из 12 ярусов, позволяет хранить до 36 Гбайт информации. Усовершенствованная технология упаковки MR-MUF позволяет улучшать теплопроводные свойства стека памяти, как поясняет SK hynix. Сторонние источники накануне сообщили, что SK hynix удалось стать исключительным поставщиком 12-ярусных чипов HBM3E для производства ускорителей Nvidia семейства Blackwell Ultra. Впрочем, Micron Technology тоже претендует на благосклонность Nvidia, поскольку свои 12-ярусные чипы HBM3E американский производитель завершил разрабатывать ещё в сентябре 2024 года. SK hynix добилась 70-% выхода годной продукции при тестовом выпуске передовой 12-слойной HBM4

27.02.2025 [12:36],

Алексей Разин

Южнокорейская SK hynix захватила примерно половину мирового рынка памяти класса HBM, и уступать свою дролю конкурентам она не собирается, а потому активно осваивает производство микросхем поколения HBM4. Свежие сообщения из Южной Кореи указывают, что на стадии тестирования удалось добиться 70-процентного уровня выхода годной продукции при выпуске 12-слойных микросхем HBM4.

Источник изображения: SK hynix Об этом сообщило южнокорейское издание ETNews, которое подобный показатель качества продукции считает весьма высоким для предварительной стадии подготовки чипов HBM4 к производству. В конце прошлого года предыдущий этап тестового производства HBM4 демонстрировал уровень выхода годной продукции в 60 %. Отчасти быстрый прогресс в качестве изделий обеспечивается использованием пятого поколения 10-нм техпроцесса (1b) для выпуска кристаллов DRAM, формирующих стек HBM4. Данный техпроцесс уже применяется и при выпуске кристаллов памяти для HBM3E. Ожидается, что поставки образцов HBM4 для нужд Nvidia компания SK hynix начнёт в июне текущего года, а к концу третьего квартала они достигнут серийных масштабов. Благодаря этому Nvidia сможет представить свои ускорители поколения Rubin с памятью HBM4 уже во второй половине текущего года. Конкурирующая Micron Technology выпуск HBM4 в массовых объёмах рассчитывает освоить не ранее 2026 года. Samsung надеется сделать это до конца текущего года, но ей приписывают проблемы с высоким уровнем брака продукции. Операционная прибыль SK hynix взлетела в 23 раза и впервые позволила обойти Samsung

23.01.2025 [07:02],

Алексей Разин

Южнокорейская компания SK hynix остаётся ведущим поставщиком памяти класса HBM, это позволило ей по итогам прошлого квартала не только увеличить выручку на 75 % до $13,7 млрд, но и поднять операционную прибыль в 23 раза до $5,6 млрд. Это позволило SK hynix впервые в истории обойти по операционной прибыли компанию Samsung Electronics, которая остаётся крупнейшим производителем памяти.

Источник изображения: SK hynix Последовательно выручка SK hynix выросла на 12 %, а операционная прибыль увеличилась на 15 % до рекордных $5,6 млрд. Ожидания аналитиков по выручке оказались выше, но операционная прибыль превысила прогнозы. К слову, это не помогло курсу акций SK hynix, которые подешевели примерно на 3 % после публикации отчёта, поскольку инвесторов огорчили прогнозы по спросу на микросхемы памяти в сегментах смартфонов и ПК. В текущем квартале поставки микросхем типа DRAM и NAND сократятся последовательно на величину от 10 до 20 %. Кроме того, представители SK hynix не ожидают улучшения ситуации со спросом на память в этих сегментах ранее второй половины текущего года. К тому времени, как ожидается, появится спрос на устройства с функциями искусственного интеллекта. Пока же на рынке ПК и смартфонов до сих пор наблюдается коррекция складских запасов. Неопределённости в прогнозах на текущий год добавляют геополитические факторы и стремление властей некоторых стран к торговому протекционизму. При этом с начала текущего года курс акций SK hynix вырос на 30 %, поэтому публикация квартальной отчётности вызвала небольшую коррекцию. Выручка компании от реализации DRAM в прошлом квартале на 40 % определялась реализацией микросхем HBM. В текущем году объёмы продаж HBM производитель намеревается увеличить в два раза, как минимум, а в прошлом они увеличились более чем в четыре раза. При этом в связи с опережающим ростом спроса будет сохраняться дефицит памяти данного типа. Капитальные затраты SK hynix в этом году немного вырастут, она готова потратить $15 млрд на расширение своих предприятий в Южной Корее и $3,9 млрд на строительство предприятия по упаковке памяти и исследовательского центра в США. Поставлять HBM4 в 16-ярусном исполнении компания начнёт во второй половине следующего года, но уже сейчас ведёт переговоры с потенциальными клиентами. Китайские конкуренты, по словам представителей SK hynix, будут испытывать проблемы с разработкой передовой памяти из-за экспортных ограничений США. К поставкам 12-ярусных чипов HBM3E компания уже приступила в прошлом квартале. Более чёткое представление о потребностях рынка в памяти HBM на 2026 год у руководства SK hynix появится в текущем полугодии. SK hynix поставит первые образцы HBM4 для Nvidia уже в июне

16.01.2025 [14:04],

Алексей Разин

Год едва начался, а осведомлённые источники уже сообщают о дальнейших планах SK hynix расширять ассортимент предлагаемой памяти для ускорителей вычислений. В июне текущего года эта южнокорейская компания намеревается начать поставки образцов HBM4 для нужд Nvidia, а к концу третьего квартала готовится развернуть серийное производство такой памяти.

Источник изображения: SK hynix Как уже отмечалось, взятые на себя SK hynix обязательства ускорить внедрение HBM4 примерно на полгода позволили Nvidia сдвинуть сроки анонса ускорителей вычислений семейства Rubin, которым нужна такая память в 12-ярусном исполнении, с 2026 года на вторую половину текущего. Цифровые проекты чипов HBM4 у специалистов SK hynix были готовы уже к концу прошлого квартала, и теперь они приступают к плотному взаимодействию с коллегами из Nvidia по вопросу внедрения HBM4 в массовое производство. Каждый ускоритель Rubin потребует по восемь стеков HBM4, а более поздняя версия Rubin Ultra будет использовать 12 стеков HBM4. Конкурирующая Samsung Electronics постарается завершить разработку HBM4 к середине текущего года, причём рассчитывает выпускать чипы DRAM для соответствующих стеков по более продвинутой технологии 10-нм класса, чем это собираются сделать SK hynix и Micron. Последняя намеревается наладить выпуск HBM4 только в 2026 году. В случае с выпуском HBM3E для нужд Nvidia лидером рынка остаётся SK hynix, но конкуренты постараются хоть в чём-то её опередить для получения выгодных заказов от крупнейшего разработчика ускорителей вычислений. Samsung ускорит выпуск HBM4 на полгода, потому что Nvidia представит ИИ-чипы Rubin в третьем квартале

13.01.2025 [13:39],

Алексей Разин

Недавние откровения руководства SK hynix позволили понять, что компания якобы по собственной инициативе ускорила разработку HBM4, но южнокорейские СМИ сегодня пояснили, что Nvidia как минимум не возражала против этого, поскольку собирается представить ускорители Rubin с памятью данного типа уже в третьем квартале. Samsung также ускорилась, и теперь готовится завершить подготовку HBM4 к массовому производству в текущем полугодии.

Источник изображения: Samsung Electronics Первоначально планировалось, что в первой половине текущего года Samsung наконец-то приступит к отгрузке микросхем HBM3E для нужд Nvidia, а во втором полугодии представит HBM4, но теперь последний этап планируется ускорить почти на шесть месяцев. По меньшей мере, это позволит в случае необходимости обеспечить Nvidia вторым источником поставок памяти типа HBM4 к моменту анонса ускорителей семейства Rubin в третьем квартале. Изначально Nvidia рассчитывала представить Rubin в 2026 году, но теперь при наличии доступа к памяти типа HBM4 может ускориться. Как отмечалось ранее, одной из особенностей памяти типа HBM4 является наличие базового кристалла, чьи функциональные особенности подгоняются под нужды конкретного заказчика. Samsung такие кристаллы для HBM4 рассчитывает выпускать собственными силами по 4-нм технологии, тогда как SK hynix будет зависеть в этой сфере от TSMC. Впрочем, это даёт SK hynix возможность получить от TSMC сразу 3-нм базовые кристаллы, тогда как Samsung будет зависеть от успехов своего контрактного подразделения в освоении передовых техпроцессов. SK hynix разрабатывает память HBM4 быстрее, чем просила Nvidia

11.01.2025 [01:19],

Николай Хижняк

Разработка высокопроизводительной памяти HBM4 компанией SK hynix идёт быстрее, чем об этом просил главный потребитель такой памяти, компания Nvidia. Об этом в разговоре с журналистами заявил председатель SK Group Чей Тэ Вон (Chey Tae-won), пишет южнокорейское издание The Elec.

Источник изображения: SK hynix Председатель SK Group рассказал, что встретился с генеральным директором Nvidia Дженсеном Хуангом (Jensen Huang) в кулуарах международной выставки электроники CES 2025 и поделился последними достижениями в области разработки памяти HBM4. SK hynix, являющаяся самым ценным активом SK Group, занимается разработкой и производством микросхем памяти. Ранее сообщалось, что скорость разработки нового поколения чипов памяти HBM для задач, связанных с искусственным интеллектом, не удовлетворила руководство Nvidia, с которой SK hynix поддерживает тесное сотрудничество. После этого компания пообещала ускорить процесс. Во время пресс-конференции на стенде SK Group в Лас-Вегасе председатель SK Group Чей Тэ Вон заявил, что сейчас разработка новой памяти HBM4 ведётся ещё быстрее, чем того требовала Nvidia. Однако он добавил, что в будущем ситуация может измениться. Чей Тэ Вон также отметил, что обсудил с Хуангом последние достижения Nvidia в области разработки новой платформы Cosmos, предназначенной для создания человекоподобных роботов, презентация которой состоялась ранее на этой неделе. По словам председателя SK Group, глава Nvidia подчеркнул, что Южная Корея обладает сильными позициями в производственной сфере и большим опытом в этой области. SK hynix в настоящее время является основным поставщиком памяти HBM для Nvidia, которая использует её в своих ускорителях искусственного интеллекта. Samsung ускорила разработку HBM4, чтобы опередить SK hynix

06.01.2025 [10:29],

Алексей Разин

Память семейства HBM оказалась востребована в сегменте ускорителей вычислений для систем искусственного интеллекта, и немногочисленные поставщики стараются укрепить свои позиции в этом прибыльном сегменте рынка. Samsung очевидным образом отстала от SK hynix в этой сфере, но постарается наверстать упущенное в рамках подготовки к массовому выпуску микросхем типа HBM4.  По крайней мере, на это указывает публикация южнокорейского ресурса The Chosun Daily, который ссылается на источники, знакомые с планами Samsung Electronics. По имеющейся информации, Samsung уже завершила разработку базовых кристаллов для HBM4, и поручила их производство по 4-нм технологии собственному контрактному подразделению. Тем самым Samsung надеется быстрее получить готовые образцы микросхем HBM4 и направить их потенциальным клиентам, которые в итоге могут переметнуться от SK hynix в случае успеха инициативы. Характерной особенностью стеков HBM4 является наличие у них базового кристалла с логикой, функции которой могут отличаться от клиента к клиенту. Необходимость подобной адаптации в сочетании с ориентацией на снижение энергопотребления вынуждает SK hynix поручить производство таких базовых кристаллов тайваньской TSMC. Первоначально считалось, что они для SK hynix будут выпускаться по 5-нм технологии, и на этом фоне решение Samsung применить в аналогичных целях свой 4-нм техпроцесс выглядело более выигрышным, но некоторое время назад появилась информация о намерениях SK hynix заказать TSMC выпуск базовых кристаллов по более совершенной 3-нм технологии. По замыслу Samsung, выпуск базовых кристаллов собственными силами позволит компании быстрее реагировать на запросы клиентов, поэтому компания рассчитывает на укрепление своих рыночных позиций после выхода на рынок своих микросхем типа HBM4. Во-вторых, Samsung рассчитывает использовать для производства кристаллов DRAM в стеке более совершенный техпроцесс 10-нм класса шестого поколения, тогда как SK hynix приписывается 10-нм техпроцесс пятого поколения. Плотно скомпонованные в стеке, насчитывающем до 16 ярусов, микросхемы могут выделять существенное количество тепла, поэтому техпроцесс их изготовления обретает особую важность. Наконец, Samsung при производстве HBM4 рассчитывает внедрить как более прогрессивный гибридный метод формирования межслойных соединений с использованием меди, так и более современную технологию упаковки чипов TC-NCF. К массовому производству HBM4 компания намеревается приступить в этом году. Память HBM4E от Micron получит кастомизируемый базовый кристалл

23.12.2024 [13:43],

Алексей Разин

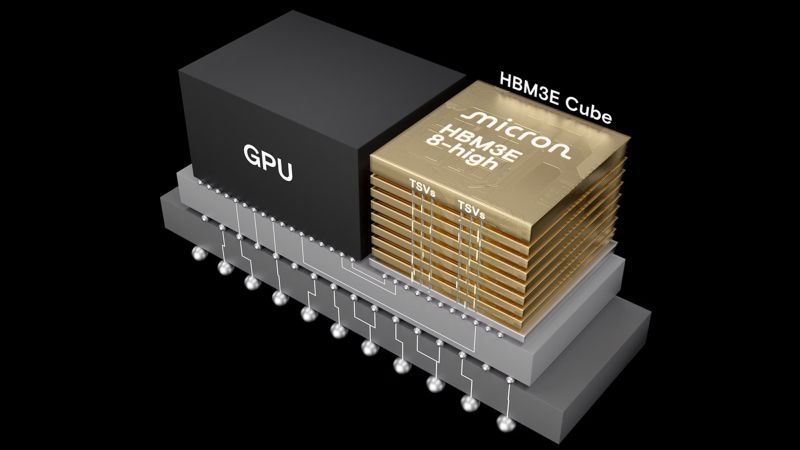

Квартальное отчётное мероприятие Micron Technology на прошлой неделе позволило руководству американской компании поделиться более подробными планами по развитию ассортимента продукции. Если в 2026 году Micron приступит к производству микросхем памяти типа HBM4, то позднее собирается наладить выпуск HBM4E, главной особенностью которой станет кастомизируемый базовый кристалл.

Источник изображения: Micron Technology Данная часть стека памяти лежит в его основе и содержит базовую логику, необходимую для работы с расположенными выше микросхемами памяти. Micron собирается наделять базовый кристалл HBM4E тем набором функций, который интересен конкретным крупным заказчикам. Насколько велика будет степень свободы Micron в этой сфере, заранее сказать сложно, но очевидно, что стандарты JEDEC будут определять какие-то рамки. Чисто технически Micron сможет добавлять поддержку новых интерфейсов, увеличивать объём кеша, добавлять шифрование данных и всё в таком духе. Как подчеркнул глава Micron на прошлой неделе, «HBM4E обеспечит сдвиг парадигмы в бизнесе по производству памяти, поскольку предложит опцию кастомизации базового кристалла с логикой для определённых клиентов, используя передовой производственный процесс TSMC». По словам генерального директора Санджея Мехротры (Sanjay Mehrotra), подобные возможности индивидуализации улучшат финансовые показатели компании Micron. Если же вернуться к более близкой HBM4, то непосредственно микросхемы памяти для стеков этого типа Micron намерена выпускать с помощью своего техпроцесса 10-нм класса пятого поколения (1β), тогда как конкурирующие SK hynix и Samsung присматриваются к более современной технологии 10-нм класса шестого поколения. Наличие 2048-разрядной шины позволит HBM4 обеспечить скорость передачи информации до 6,4 гигатранзакций в секунду. Массовое производство HBM4 компания рассчитывает развернуть в 2026 календарном году. Сейчас Micron уже активно поставляет 8-ярусные стеки HBM3E для ускорителей Nvidia Blackwell, 12-ярусные проходят тестирование клиентами и получают самые лестные отзывы, по словам руководства компании. SK hynix не сможет выпускать память HBM4 для Nvidia без помощи TSMC

04.12.2024 [12:13],

Алексей Разин

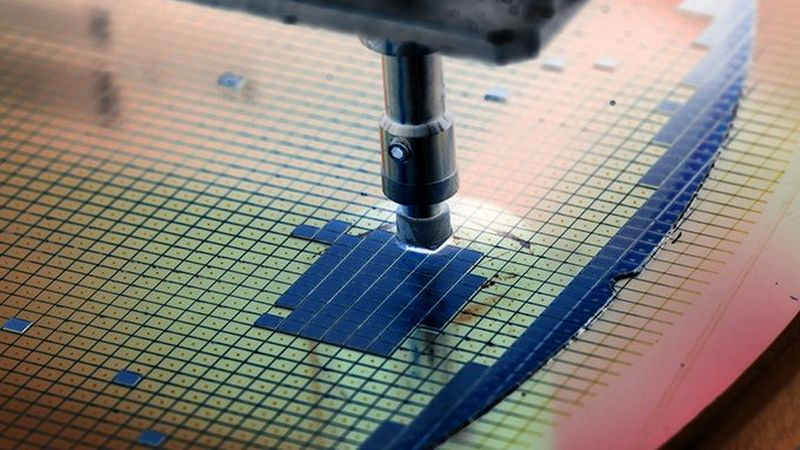

Принято считать, что для производства микросхем памяти в целом используются менее дорогостоящие литографические технологии, но современная память становится более сложной по своей компоновке, а потому при её выпуске востребована продвинутая литография. SK hynix намерена привлечь TSMC к производству стеков HBM4 с использованием 3-нм техпроцесса со второй половины 2025 года.

Источник изображения: SK hynix Об этом сообщает издание The Korea Economic Daily со ссылкой на осведомлённые источники. Передовой техпроцесс потребуется для производства базового кристалла для кастомных HBM4, которые будут выпускаться специально для Nvidia. В базовом кристалле располагается логика и на его основе формируется вертикальный стек. Первоначально SK hynix рассчитывала выпускать этот кристалл по 5-нм технологии, но в ходе переговоров с TSMC и крупными клиентами обеих компаний было принято решение об использовании более продвинутого 3-нм техпроцесса для этих целей. Память типа HBM4 корейский поставщик надеется начать отгружать для нужд Nvidia во второй половине 2025 года. Как ожидается, прототип микросхемы HBM4 на базе 3-нм основания будет продемонстрирован SK hynix в марте следующего года. Получаемые сейчас Nvidia от TSMC графические процессоры выпускаются по 4-нм технологии. По некоторым оценкам, перевод базового чипа HBM4 на 3-нм технологию производства позволит поднять быстродействие памяти на 20–30 % относительно 5-нм варианта. SK hynix контролирует примерно половину мирового рынка HBM, основную часть своей продукции данного типа она поставляет для нужд Nvidia. Конкурирующая Samsung не может сертифицировать свою HBM3E для использования в продукции Nvidia, а ещё она собирается использовать при производстве HBM4 лишь 4-нм базовые кристаллы. Память типа HBM4 уже относится к шестому поколению данных микросхем. В свою очередь, базовые кристаллы для стандартных стеков HBM4 и HBM4E, которые будут получать все прочие клиенты SK hynix кроме Nvidia, будут выпускаться по 12-нм техпроцессу, также силами TSMC. Базовые кристаллы для HBM3E корейская компания выпускает самостоятельно, но в свете перехода к HBM4 решила углубить сотрудничество с TSMC в данной сфере. Утверждается, что по просьбе Nvidia компания SK hynix ускорила разработку и процесс подготовки к массовому производству микросхем HBM4. Ранее она собиралась наладить выпуск HBM4 в начале 2026 года, а теперь готова сделать это примерно на полгода раньше. Тем временем, памятью типа HBM4 интересуется и компания Tesla, она пока выбирает между продукцией SK hynix и Samsung Electronics. Samsung поборется за рынок ИИ-памяти с помощью полузаказных HBM4

12.11.2024 [11:55],

Алексей Разин

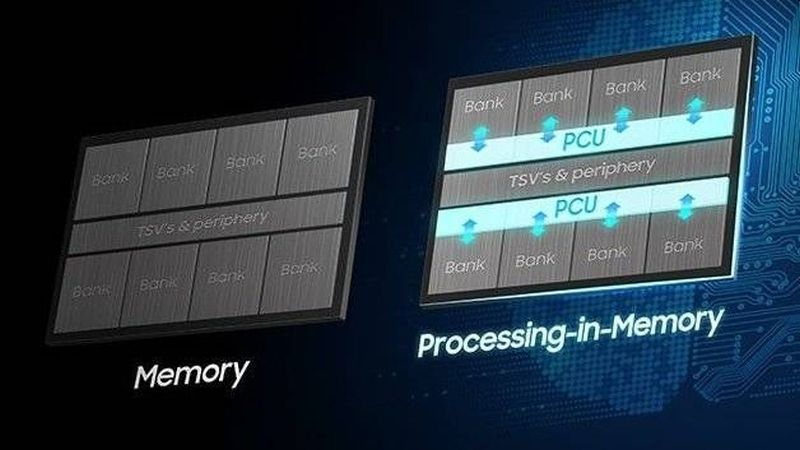

Попытки Samsung Electronics отвоевать у SK hynix приличную часть рынка микросхем памяти типа HBM пока не увенчались успехом, но первая из компаний делает ставку на адаптацию микросхем HBM4 под нужды конкретных заказчиков, которую начнёт осуществлять со следующего года, если верить южнокорейским СМИ.

Источник изображения: Samsung Members Источники сообщают, что разработка полузаказных вариантов HBM4 для крупных клиентов Samsung уже началась, а к их массовому производству компания приступит до конца 2025 года. Первыми клиентами Samsung на данном направлении могут стать Microsoft и Meta✴ Platforms, которые занимаются разработкой собственных ускорителей вычислений, а потому нуждаются в более эффективной памяти. Базовая HBM4, как ожидается, увеличит скорость передачи информации относительно HBM3E на 66 % до 2 Тбайт/с, а предельная ёмкость увеличится на треть до 48 Гбайт на стек. Samsung может оснастить свои микросхемы HBM4 не только собственными нейронными сопроцессорами для ускорения операций, связанных с работой систем искусственного интеллекта, но и дополнительными вычислительными блоками, адаптированными под потребность конкретных заказчиков. Данная особенность памяти поколения HBM4 и станет главным полем сражения конкурирующих производителей. Обычную HBM4 универсального типа Samsung тоже надеется начать выпускать до конца следующего года. Партнёром компании в этой сфере довольно неожиданно станет один из конкурентов — тайваньская TSMC, которая оказывает услуги по упаковке чипов с передовыми вариантами компоновки. SK hynix ускорит создание памяти HBM4, потому что об этом попросил глава Nvidia

04.11.2024 [18:29],

Николай Хижняк

SK hynix ускорит выпуск нового поколения чипов памяти HBM для задач, связанных с работой ИИ, после того, как глава компании Nvidia Дженсен Хуанг (Jensen Huang) спросил южнокорейского поставщика микросхем о возможности начать поставки образцов новой памяти на шесть месяцев раньше изначально запланированного срока. Решение свидетельствует о сохраняющемся мировом спросе на передовые полупроводники, пишет Bloomberg.

Источник изображения: TechPowerUp Хуанг поднял вопрос о будущей высокопроизводительной памяти HBM4 в ходе встречи с председателем SK Group Чеем Тэ Воном (Chey Tae-won), о чём сам южнокорейский бизнесмен сообщил в кулуарах саммита SK AI по вопросам технологий ИИ в понедельник, пишет издание. Чей считает, что Хуанг преуспел в качестве лидера отчасти благодаря своему акценту на скорости внедрения новых решений на рынок. Ранее SK hynix сообщила, что придерживается графика и планирует начать поставки памяти HBM4 своим клиентам во второй половине 2025 года. Эти планы она в очередной раз подтвердила в рамках финансового отчёта в октябре. Южнокорейская компания является ключевым поставщиком микросхем памяти HBM, которые используются в составе специальных ИИ-ускорителей Nvidia. Как пишет Bloomberg, судьба поставок памяти HBM4 в 2025 году зависит от того, сможет ли южнокорейский производитель чипов вовремя завершить сложный процесс квалификации микросхем со стороны Nvidia. Однако по словам топ-менеджера SK Group, «обе стороны находятся на одной волне» по вопросу графика выпуска HBM4. Как сообщается, в то же время сама Nvidia пока не может удовлетворить спрос на достаточное количество ИИ-чипов. По словам Чея, обе компании работают над тем, чтобы решить проблему сохраняющегося дефицита поставок. SK hynix в понедельник также раскрыла некоторые дополнительные подробности о дорожной карте своих будущих продуктов. Производитель микросхем планирует выпустить 16-слойные чипы памяти HBM3E в начале 2025 года, а также выпустить микросхемы HBM5 и HBM5E в 2028–2030 годах. В прошлом месяце компания отчиталась о рекордном квартальной выручке и сообщила о планах начать поставки своих самых передовых на данный момент 12-слойных чипов памяти HBM3E в четвёртом квартале этого года. Компания Samsung Electronics, которая изо всех сил пытается догнать SK hynix в сегменте производства ИИ-чипов, заявила, что планирует массовое производство микросхем памяти HBM4 во второй половине следующего года. Samsung рассчитывает, что её продукты HBM4 помогут конкурировать с SK hynix в поставках для Nvidia. Samsung объединит усилия с TSMC при выпуске памяти типа HBM4

06.09.2024 [10:44],

Алексей Разин

Samsung Electronics располагает собственными мощностями по выпуску логических элементов памяти HBM, но в рамках производства HBM4 она решила объединить усилия с TSMC, являющейся крупнейшим контрактным производителем полупроводниковых компонентов. Так Samsung рассчитывает увеличить охват рынка при реализации HBM4.

Источник изображения: Samsung Electronics Многие игроки отрасли настаивают, что на рынке HBM в дальнейшем усилится тенденция к адаптации микросхем памяти данного типа к потребностям конкретных клиентов. Осознавая это, Samsung собирается скооперироваться с TSMC в части выпуска логических компонентов для микросхем HBM4, а также расширения возможностей по интеграции памяти с компонентами сторонних заказчиков, которые пользуются услугами TSMC. В контрактном сегменте TSMC и Samsung являются прямыми конкурентами, но это не помешало южнокорейскому гиганту согласиться на сотрудничество. В начале месяца, как отмечает Business Korea, представители Samsung объявили о подготовке более 20 микросхем HBM, адаптированных к потребностям конкретных заказчиков. А вчера представители TSMC на отраслевой конференции на Тайване признались, что компания ведёт разработку безбуферной памяти HBM4 в сотрудничестве с Samsung. Буфер у микросхем HBM традиционно отвечает за более стабильное электропитание, но отказ от него позволяет улучшить энергетическую эффективность на 40 % и снизить задержки при передаче информации на 10 %. Samsung намеревается перейти на безбуферную компоновку при выпуске HBM4 с конца 2025 года. При этом компания будет часть микросхем HBM4 производить самостоятельно, но одновременно сотрудничать в данной сфере с TSMC. SK hynix обещает увеличить производительность HBM в 30 раз

20.08.2024 [13:53],

Алексей Разин

Южнокорейская компания SK hynix является крупнейшим поставщиком памяти типа HBM, по размеру чистой прибыли она среди соотечественников уже уступает только Samsung Electronics, а потому заинтересована в сохранении технологического лидерства в этой сфере. Представители SK hynix недавно признались, что компания намерена увеличить производительность HBM в 30 раз от текущего уровня.

Источник изображения: SK hynix Соответствующее заявление, как отмечает Business Korea, сделал на этой неделе вице-президент компании Рю Сон Су (Ryu Seong-su), выступавший на отраслевом форуме в южнокорейской столице. SK hynix собирается разработать память семейства HBM, которая по уровню быстродействия смогла бы превзойти существующие образцы в 30 раз. «Мы собираемся разрабатывать продукты, которые будут быстрее нынешней HBM в 20 или 30 раз, концентрируясь на выводе на рынок дифференцированных продуктов», — пояснил Рю Сон Су. Компании, входящие в так называемую «великолепную семёрку» (Apple, Microsoft, Alphabet (Google), Amazon, Nvidia, Meta✴ Platforms и Tesla), часто обращаются к SK hynix с просьбой адаптировать поставляемую память HBM под их нужды. Чтобы удовлетворить эти запросы, SK hynix требуется огромное количество инженерных ресурсов, по словам представителя компании, но она собирается развиваться в этом направлении. Уже в рамках семейства HBM4 этот производитель намеревается предлагать клиентам адаптированные под их потребности варианты памяти. При этом SK hynix стремится к самостоятельному формированию отраслевых стандартов в данной сфере, а не следовать предложенным другими компаниями решениям. Кастомизация памяти станет существенным фактором, меняющим ход развития всей полупроводниковой отрасли, как считают в SK hynix. К выпуску микросхем HBM4 компания Samsung будет готова в следующем году

19.08.2024 [08:55],

Алексей Разин

Потерпев определённые неудачи на поприще поставок HBM3E для нужд Nvidia, южнокорейская компания Samsung Electronics старается наверстать упущенное при подготовке к массовому выпуску памяти типа HBM4. Уже к концу этого года она будет располагать цифровыми проектами соответствующих чипов, а массовое производство 12-слойных стеков HBM4 должна наладить до конца следующего.

Источник изображения: Samsung Electronics По крайней мере, так описывает планы Samsung южнокорейское издание The Elec. Рассчитывать на формальный анонс HBM4 в исполнении Samsung в этом случае приходится в привязке к весне 2025 года, поскольку от создания цифрового проекта до начала выпуска первых образцов продукции обычно проходит от трёх до четырёх месяцев. Скорее всего, Samsung сможет приступить к поставкам образцов HBM4 своим клиентам в течение следующего года. По данным источника, Samsung намеревается наладить выпуск логической части чипа HBM4 с использованием своего 4-нм техпроцесса, а микросхемы памяти в стеке будут производиться по техпроцессу 10-нм класса шестого поколения (1c). Конкурирующая SK hynix собирается наладить выпуск 12-слойной памяти HBM4 во второй половине следующего года, логическую часть она будет производить по 5-нм или 12-нм технологии силами TSMC, а вот микросхемы памяти в стеке она будет выпускать самостоятельно, но пока не определилась с конкретной ступенью 10-нм техпроцесса (1b или 1c). Компании Samsung для подготовки к выпуску чипов HBM4 с использованием технологии 1c придётся вложиться в оснащение профильных производственных линий. Установка оборудования начнётся в середине следующего года, массовое производство планируется развернуть уже в 2026 году. К тому времени AMD и Nvidia выпустят свои ускорители вычислений Instinct MI400 и Rubin, которые будут оснащаться памятью типа HBM4. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |