|

Опрос

|

реклама

Быстрый переход

SK hynix не сомневается, что высокий спрос на память сохранится до середины следующего года

08.08.2024 [09:02],

Алексей Разин

Бум систем искусственного интеллекта воодушевил производителей памяти семейства HBM, а ведущие позиции на этом рынке сейчас занимает южнокорейская SK hynix. Руководство этой компании выражает уверенность, что высокий спрос на микросхемы памяти сохранится как минимум до середины следующего года. В дальнейшем он тоже может оставаться высоким, но для подобных прогнозов у компании просто нет достаточных данных.

Источник изображения: SK hynix По словам издания Korean Economic Daily, соответствующие заявления генеральный директор SK hynix Квак Но Чун (Kwak Noh-jung) на собрании с участием сотрудников компании сделал в минувшую среду. «Оживление на рынке памяти сохранится до конца первой половины следующего года. Спрос на HBM способствовал возникновению перелома в отрасли по производству памяти», — буквально заявил руководитель SK hynix. Во втором квартале операционная прибыль компании достигла шестилетнего максимума в размере $3,96 млрд, норма операционной прибыли выросла до рекордных 33 %, а выручка выросла в годовом сравнении на 124,7 % до $11,86 млрд. Помимо активного наращивания производственных мощностей для выпуска HBM, компания SK hynix намеревается своевременно осваивать новые типы продукции. Наладить выпуск 12-слойных микросхем типа HBM4 этот южнокорейский производитель рассчитывает во второй половине следующего года. Глава SK hynix не стал торопиться с прогнозами на вторую половину следующего года с точки зрения сохранения высокой динамики спроса, но в компании это объясняют не наличием причин сомневаться в её сохранении, а просто в отдалённости этого периода для обеспечения достоверного прогнозирования. JEDEC определилась с предварительным стандартом памяти HBM4

13.07.2024 [06:54],

Анжелла Марина

Ассоциация JEDEC опубликовала предварительную спецификацию памяти HBM4 четвёртого поколения, которая обещает значительное увеличение объёма и пропускной способности для систем искусственного интеллекта и высокопроизводительных вычислений.

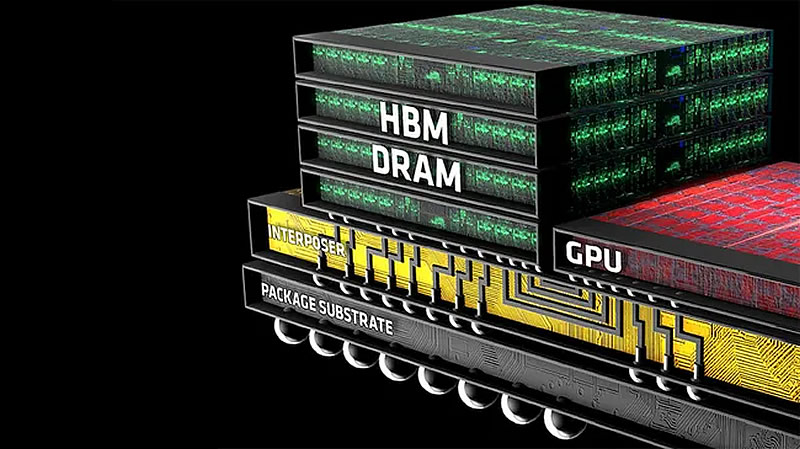

Источник изображения: AMD JEDEC представила спецификацию памяти HBM4 (High-Bandwidth Memory) нового поколения, приближаясь к завершению разработки нового стандарта DRAM, сообщает Tom's Hardware. Согласно опубликованным данным, HBM4 будет поддерживать 2048-битный интерфейс на стек, хотя и с более низкой скоростью передачи данных по сравнению с HBM3E. Кроме того, новый стандарт предусматривает более широкий диапазон слоёв памяти, что позволит лучше адаптировать её для различных типов приложений. Новый стандарт HBM4 будет поддерживать стеки объёмом 24 Гбайт и 32 Гбайт, а также предложит конфигурации для 4-, 8-, 12- и 16-слойных стеков с вертикальными межсоединениями TSV. Комитет JEDEC предварительно согласовал скоростные режимы до 6,4 Гт/с, но при этом ведутся дискуссии о возможности достижения ещё более высокой скорости передачи данных. 16-слойный стек на основе 32-гигабитных чипов сможет обеспечить ёмкость 64 Гбайт, то есть в этом случае процессор с четырьмя модулями памяти сможет поддерживать 256 Гбайт памяти с пиковой пропускной способностью 6,56 Тбайт/с при использовании 8192-битного интерфейса. Несмотря на то, что HBM4 будет иметь удвоенное количество каналов на стек по сравнению с HBM3 и больший физический размер для обеспечения совместимости, один контроллер сможет работать как с HBM3, так и с HBM4. Однако для размещения различных формфакторов потребуются разные подложки. Интересно, что JEDEC не упомянула о возможности интеграции памяти HBM4 непосредственно в процессоры, что, пожалуй, является наиболее интригующим аспектом нового типа памяти. Ранее компании SK hynix и TSMC объявили о сотрудничестве в разработке базовых кристаллов HBM4, а несколько позднее на Европейском симпозиуме 2024, TSMC подтвердила, что будет использовать свои технологические процессы 12FFC+ (12-нм класс) и N5 (5-нм класс) для производства этих кристаллов. Процесс N5 от TSMC позволяет интегрировать больше логики и функций, с шагом межсоединений от 9 до 6 микрон, что критически важно для интеграции на кристалле. Процесс 12FFC+, основанный на 16-нм FinFET-технологии TSMC, обеспечит производство экономически эффективных базовых кристаллов, соединяющих память с хост-процессорами с помощью кремниевых подложек. Отметим, что HBM4 в первую очередь разработана для потребностей генеративного искусственного интеллекта и высокопроизводительных вычислений, которые требуют обработки очень больших объёмов данных и выполнения сложных вычислений. Поэтому маловероятно, что мы увидим HBM4 в клиентских приложениях, таких как GPU. Компания SK hynix рассчитывает наладить выпуск HBM4 в 2026 году. В составе Samsung создана специальная команда по разработке памяти HBM

05.07.2024 [08:18],

Алексей Разин

В мае этого года бывший глава всего полупроводникового бизнеса Samsung Кюн Ки Хён (Kyung Kye-hyun) был назначен руководителем исследовательского подразделения компании, и теперь по его инициативе разработкой перспективных технологий в сфере производства HBM будет заниматься отдельная команда специалистов.

Источник изображения: Samsung Electronics Как отмечает Business Korea, в сферу ответственности подразделения HBM Development Team войдёт создание более эффективных вариантов HBM3 и HBM3E, а также разработка перспективной памяти типа HBM4. Ранее Samsung уже создала рабочую группу по повышению конкурентоспособности компании на рынке HBM, и теперь её участники вольются к более крупный коллектив новой команды. С 2015 года разработкой HBM в структуре Samsung Electronics занимались специалисты подразделения, отвечающего за выпуск памяти. В феврале этого года южнокорейский гигант доложил об успехах в создании образцов 12-ярусного стека HBM3E, который может обладать объёмом 36 Гбайт. Теперь разработкой HBM и сопутствующих технологий будет заниматься команда в составе подразделения Device Solutions. Компания остро нуждается в повышении своей конкурентоспособности на рынке HBM, поскольку сейчас Samsung является крупнейшим производителем микросхем памяти, но конкретно на прибыльном и быстро растущем рынке HBM компания уступает SK hynix. Samsung собралась устанавливать память HBM4 прямо на кристаллы GPU

17.06.2024 [22:30],

Анжелла Марина

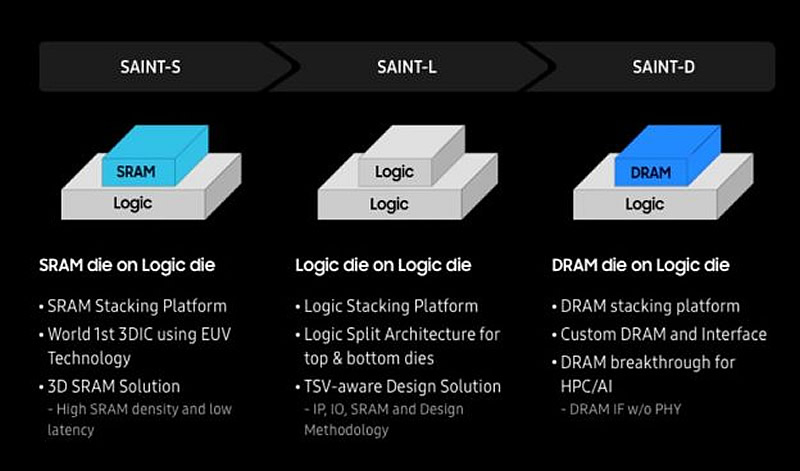

Компания Samsung объявила о планах предложить клиентам своего контрактного производства чипов передовую технологию пространственной компоновки. Проще говоря, Samsung сможет выпускать чипы, состоящие из нескольких кристаллов, уложенных один на другой. Это позволит Samsung лучше конкурировать с крупнейшим контрактным производителем чипов — TSMC.

Источник изображения: Kedglobal.com Как сообщает The Korea Economic Daily, на недавно прошедшем форуме Samsung Foundry в Сан-Хосе компания анонсировала запуск услуги по 3D-упаковке с применением стеков HBM (High Bandwidth Memory). В настоящее время память HBM в основном использует 2.5D-технологию, то есть размещается в непосредственной близости от микросхемы GPU или другого чипа на общей кремниевой подложке. Однако Samsung готова устанавливать стеки HBM непосредственно на кристаллы процессоров. Это обеспечит ещё более высокую скорость передачи данных и уменьшит задержки, поскольку позволит отказаться от пересылки данных через подложку. Ожидается, что 3D-упаковка появится на рынке для HBM четвёртого поколения, которое также называют HBM4. Данная память начнёт активно применяться в 2025–2026 годах. Интересно, что анонс Samsung последовал после презентации генерального директора NVIDIA Дженсена Хуанга (Jensen Huang) на выставке Computex 2024, где он представил Rubin — архитектуру ускорителей вычислений следующего поколения, которая как раз будет использовать памяти HBM4. Samsung планирует предлагать 3D-упаковку с HBM4 «под ключ», то есть интегрировать на чипы стеки памяти собственного производства. Отдел Samsung, отвечающий за передовую упаковку, будет устанавливать стеки HBM, произведенные в подразделении Samsung по выпуску памяти, с графическими процессорами, изготовленными подразделением контрактного производства. Компания называет свою новую технологию упаковки SAINT-D, сокращенно от Samsung Advanced Interconnection Technology-D. «3D-упаковка снижает энергопотребление и задержку обработки, улучшая качество электрических сигналов полупроводниковых чипов», — заявил представитель Samsung Electronics. Услуги по 3D-упаковке HBM4 «под ключ» планируется запустить в 2027 году.

Источник изображения: Trendforce.com В связи с растущим спросом на высокопроизводительные чипы HBM, по прогнозам, в 2025 году на память данного типа придётся 30 % от всего рынка DRAM в следующем году против 21 % в 2024 году. Nvidia представила амбициозный план выпуска новых GPU и CPU: суперчип Vera Rubin с HBM4 выйдет в 2026 году

02.06.2024 [22:39],

Анжелла Марина

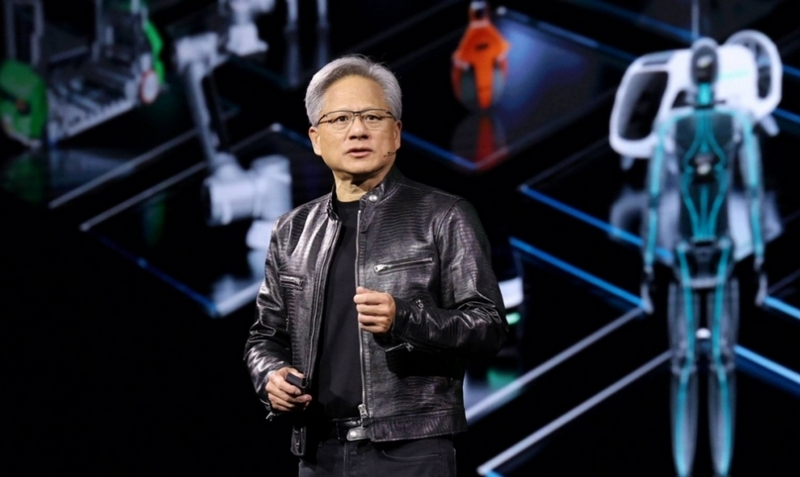

Глава Nvidia во время презентации на Computex 2024 представил план по выпуску новых продуктов на следующие три года. Он включает новейшие графические и центральные процессоры, а также другие чипы и интерфейсы для ИИ и машинного обучения. Согласно плану, компания намерена ежегодно выпускать флагманские решения, работающие на пределе доступных производственных техпроцессов.

Источник изображений: Nvidia На конференции Computex 2024 глава Nvidia Дженсен Хуанг (Jensen Huang) раскрыл подробности о планах компании компании для продуктов, предназначенных для центров обработки данных, на следующие три года. Планы впечатляют — Nvidia намерена выпускать новые флагманские решения для дата-центров каждый год, постоянно наращивая их производительность и функциональность. Уже в следующем, 2025 году ожидается выход графического процессора Blackwell Ultra, который является преемником нынешнего флагмана Blackwell. Новинка будет оснащена памятью HBM3e с 12 кристаллами в стеке, что позволит увеличить объем на 50 % по сравнению с Blackwell, у которого память с 8 кристаллами. В 2026 году Nvidia планирует сделать сразу несколько крупных анонсов. Во-первых, будет представлен новый графический чип Rubin с памятью HBM4. Во-вторых, появится центральный процессор Vera, который придёт на смену нынешнему Grace. Таким образом, флагманское решение 2026 года получит название Vera Rubin — это будет суперчип, связка GPU+CPU, аналогично актуальному Grace Hopper. Кроме того, пропускная способность запатентованной Nvidia технологии интерконнекта NVLink будет удвоена до 3,6 Тбит/с (NVLink 6 против NVLink 5). На 2027 год запланирован выход улучшенной версии Rubin Ultra с HBM4 с 12 кристаллами в стеке вместо 8. Как подчёркивает Хуанг, Nvidia намерена выжимать максимум из доступных на данный момент производственных техпроцессов, чтобы каждый год выводить на рынок новые флагманские решения, работающие на пределе возможного. По словам Дженсена Хуанга, именно такая стратегия непрерывного совершенствования позволит компании сохранять лидерство в сфере решений для дата-центров. Samsung расширит штат исследовательского центра в Японии, чтобы преуспеть в разработке HBM4

30.05.2024 [14:45],

Алексей Разин

По мере распространения вычислительных компонентов со сложной пространственной компоновкой всё большее значение обретает не столько литография, сколько технологии упаковки чипов, и компания Samsung Electronics это прекрасно осознаёт. Её японский исследовательский центр в Йокогаме расширит штат относительно первоначальных целевых показателей.

Источник изображения: Samsung Electronics Строящийся исследовательский центр Samsung в Японии должен упростить взаимодействие корейских специалистов с японскими коллегами, представляющими интересы производителей материалов и оборудования для упаковки чипов. На площади примерно 6600 кв.м должны разместиться более 100 специалистов, они начнут свою работу в 2025 году. Компания собирается увеличить количество персонала, привлечённого к строительству исследовательского центра, а также специалистов по кадрам и финансам. На строительство центра будет потрачено около $260 млн, до половины суммы готовы покрыть своими субсидиями власти Японии. Деньги будут выделены из целевого фонда «Post-5G», который предназначен для финансирования перспективных технологий. Помимо близости поставщиков материалов и оборудования, на выбор места для исследовательского центра Samsung повлияла и возможность сотрудничества с местными университетами. Помимо разработки упаковки для микросхем памяти HBM4, в этом центре будут создаваться и решения для сетей 5G. TSMC будет выпускать основания для стеков HBM4 по 12- и 5-нм техпроцессам

17.05.2024 [17:58],

Николай Хижняк

Компания TSMC на конференции European Technology Symposium 2024 поделилась свежими деталями о ходе разработки чипов-оснований для высокопроизводительной памяти HBM4. Одной из ключевых особенностей новой технологии памяти станет переход с 1024-битного на 2048-битный интерфейс. Однако реализация этого потребует применения более передовых технологий упаковки, по сравнению с теми, что используются сейчас для производства и интеграции памяти HBM.

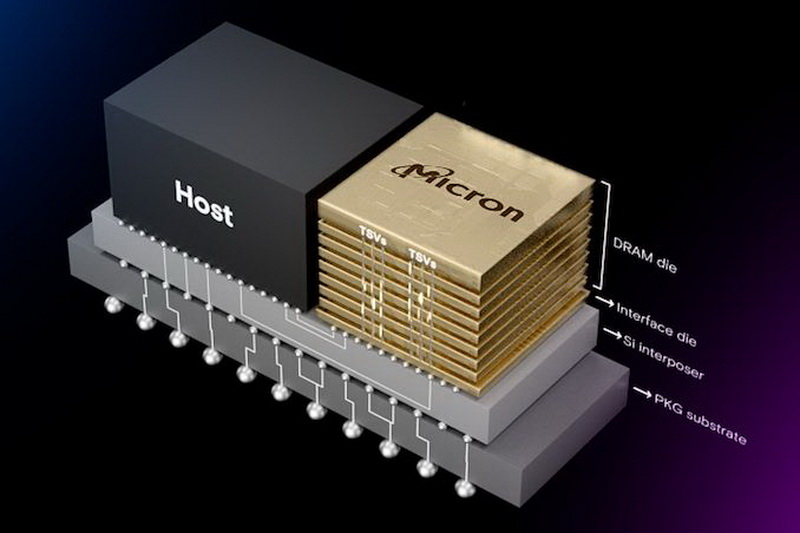

Источник изображения: TSMC В рамках своей презентации TSMC поделилась свежими деталями о чипах, которые лягут в основание стеков памяти HBM4. Компания собирается использовать для выпуска базовых чипов сразу два своих техпроцесса — N12FFC+ (12 нм) и N5 (5 нм). Каждый обладает своими достоинствами, но оба будут служить одной цели — интеграции высокоскоростной памяти HBM четвёртого поколения в состав будущих ИИ- и HPC-процессоров. «Мы сотрудничаем с ключевыми партнёрами в разработке HBM-памяти (Micron, Samsung, SK Hynix) над передовыми узлами для полной интеграции стека HBM4. Базовый кристалл на основе экономичного техпроцесса N12FFC+ обеспечит прирост производительности HBM4, а базовый кристалл на основе N5 позволит размещать больше логических компонентов на чипе и снизить энергопотребление памяти», — отмечает компания. Базовый кристалл памяти HBM4, изготовленный по технологии TSMC N12FFC+ (12-нм FinFet Compact Plus), будет использоваться для установки стеков памяти HBM4 на кремниевый переходник рядом с SoC. В TSMC отмечают, что N12FFC+ позволяет создавать стеки памяти в конфигурациях 12-Hi (двенадцать ярусов, 48 Гбайт) и 16-Hi (шестнадцать ярусов, 64 Гбайт) с пропускной способностью каждого стека более 2 Тбайт/с. Базовые кристаллы HBM4 на техпроцессе N12FFC+ будут применяться для производства «систем в корпусе» (system-in-package, SiP) с использованием передовых технологий упаковки TSMC CoWoS-L или CoWoS-R. По данным TSMC, в настоящее время HBM4 может достигать скорости передачи данных до 6 ГТ/с при токе 14 мА. «Мы также оптимизируем свои технологии упаковки CoWoS-L и CoWoS-R для HBM4. Они подразумевают использование более восьми уровней интерконнекта, чтобы обеспечить маршрутизацию более чем 2000 соединений в составе HBM4 с должной целостностью сигнала», — сообщила TSMC Компания TSMC сотрудничает с EDA-партнёрами Cadence, Synopsys и Ansys над вопросами обеспечения целостности передачи сигналов, тепловой точности и снижения электромагнитных помех (EMI) в новых базовых кристаллах HBM4. В качестве более продвинутой альтернативы TSMC сможет предложить для своих клиентов техпроцесс N5 для производства оснований для стеков памяти HBM4. Этот узел позволит размещать в составе стека HBM4 ещё больше логических компонентов, снизить энергопотребление памяти и ещё сильнее повысить её производительность. Но, возможно, самым важным преимуществом N5 является то, что он позволяет добиться очень малого шага межсоединений в составе HBM4, порядка 6–9 микрон. В свою очередь это позволит интегрировать кристаллы памяти HBM4 прямо поверх логических микросхем. Это должно увеличить производительность и пропускную способность памяти, что окажется полезным при производстве ИИ-чипов. SK hynix ускоренными темпами выведет на рынок память HBM4E в 2026 году

14.05.2024 [09:23],

Алексей Разин

Новейшая HBM3E относится к пятому поколению памяти HBM, а ведущий поставщик в лице SK hynix уже сейчас рассматривает возможность вывода на рынок памяти седьмого поколения HBM4E к 2026 году. Это на год быстрее, чем планировалось ранее, а в дальнейшем шаг между выходами поколений HBM будет сокращён с двух лет до одного года.

Источник изображения: SK hynix По крайней мере, об этом сообщает ресурс The Elec со ссылкой на собственные источники, знакомые с планами компании. Первоначально SK hynix в 2026 году рассчитывала вывести на рынок только шестое поколение памяти (HBM4), а седьмое представить не ранее 2027 года. Теперь выход на рынок HBM4E решено ускорить на год. SK hynix будет выпускать микросхемы HBM4E с использованием техпроцесса 10-нм класса, плотность каждой достигнет 32 Гбит. Правда, пока у специалистов SK hynix даже нет уверенности, какой высоты будут стеки памяти HBM4E, и какие технологии будут использоваться для формирования вертикальных межслойных соединений. По некоторым данным, HBM4E сможет увеличить скорость передачи информации на 40 % по сравнению c HBM4, а вот от намерений по внедрению гибридных связей при выпуске памяти последнего типа SK hynix вынуждена отказаться, хотя в прошлом году о соответствующих намерениях заявляла. Конкурирующая Samsung Electronics намеревается освоить массовый выпуск HBM4 в 2026 году, поэтому нельзя исключать, что активность SK hynix на этом направлении заставит корейского гиганта ускориться. Как считают отдельные источники, являясь крупнейшим потребителем памяти HBM, компания Nvidia буквально сталкивает лбами её производителей в надежде получить более выгодные для себя условия закупок. SK hynix и TSMC будут сотрудничать в рамках производства HBM4

19.04.2024 [08:25],

Алексей Разин

В конце этой рабочей недели южнокорейская компания SK hynix сообщила о подписании меморандума о взаимопонимании с тайваньской компанией TSMC в сфере сотрудничества в рамках производства памяти HBM следующего поколения, коей является HBM4. Корейская компания освоит её массовое производство в 2026 году, и это позволит ей сохранить лидерские позиции на этом рынке.

Источник изображения: SK hynix По данным TrendForce, в этом году SK hynix сможет сохранить за собой 52,5 % рынка микросхем типа HBM, ещё 42,4 % достанутся Samsung Electronics, а Micron Technology будет довольствоваться оставшимися 5,1 %. В настоящее время SK hynix является крупнейшим поставщиком микросхем HBM3 для нужд Nvidia и собирается в ближайшие месяцы начать поставки более совершенной памяти типа HBM3E. Следующим этапом станет выпуск HBM4, который начнётся ориентировочно в 2026 году, и сейчас SK hynix пытается заручиться поддержкой TSMC в этом вопросе. Дело в том, что TSMC остаётся единственной компанией, способной упаковывать память HBM и ускорители вычислений Nvidia по методу CoWoS, а потому SK hynix в эволюции своей памяти зависит от тайваньского партнёра. Из выделенных на текущий год капитальных затрат в диапазоне от $28 до $32 млрд компания TSMC намеревается до десяти процентов потратить на расширение мощностей по упаковке чипов и памяти. Именно их нехватка считается одной из причин дефицита ускорителей вычислений Nvidia для систем искусственного интеллекта. В прошлом году на долю HBM приходилось не более 8,4 % выручки в сегменте DRAM, но по итогам текущего эта доля вырастет до 20,1 %. TSMC и SK hynix объединились для совместного производства памяти HBM4

10.02.2024 [12:58],

Павел Котов

Стандарт HBM4, как ожидается, благодаря 2048-битному интерфейсу значительно увеличит пропускную способность памяти, что благотворно скажется на работе ИИ-ускорителей и компонентов высокопроизводительных вычислений (HPC). Но эта технология потребует многочисленных изменений в механизмах интеграции памяти, а значит, и более тесного сотрудничества между производителями памяти и производителями логики. Поэтому TSMC и SK hynix сформировали альянс для совместного производства HBM4.

Источник изображения: skhynix.com Новая организация получила название AI Semiconductor Alliance — инициатива поможет TSMC и SK hynix объединить свои сильные стороны и согласовать действия по принципу «стратегии единой команды», пишет Maeil Business News Korea. TSMC возьмёт на себя проработку «некоторых процессов HBM4» — вероятно, имеется в виду выпуск кристаллов с использованием одной из своих передовых технологий, которых нет в арсенале SK hynix. По неподтвержденной информации, речь идёт о нормах 12 нм; ранее также стало известно, что SK hynix и NVIDIA работают над технологией, которая позволит размещать память HBM прямо на графических процессорах без подложки. TSMC одновременно является членом сообщества 3DFabric Memory Alliance вместе со всеми тремя производителями HBM: Micron, Samsung и SK hynix. С последней тайваньский подрядчик также сотрудничает в области разработки упаковки CoWoS для HBM3 и HBM4, совместной оптимизации технологий проектирования (DTCO) HBM и даже чиплетного интерфейса UCIe для HBM. Тесное сотрудничество TSMC и SK hynix позволит гарантировать, что память HBM3E и HBM4 от SK hynix будет работать с чипами производства TSMC. Это важно, поскольку SK hynix лидирует на рынке HBM, а TSMC — крупнейший в мире полупроводниковый подрядчик. Корейское издание обмолвилось, что альянс также направлен на создание «единого фронта против Samsung Electronics» — это конкурент одновременно и для TSMC, и для SK hynix, но, возможно, не стоит излишне доверять таким заявлениям. И правда, трудно представить, чтобы TSMC намеренно ограничила совместимость своей упаковки только продукцией SK hynix — вероятно, в действительности тайваньский подрядчик будет просто плотнее сотрудничать с SK hynix, чем с Samsung. SK hynix запустит массовое производство памяти HBM4 в 2026 году

02.02.2024 [23:18],

Николай Хижняк

Южнокорейская компания SK hynix объявила, что приступит к массовому производству оперативной памяти с высокой пропускной способностью следующего поколения — HBM4 — к 2026 году. Ранее компания сообщила, что начнёт разработку HBM4 уже в этом году.

Источник изображения: Wccftech До этого момента о планах по разработке и внедрению памяти HBM4 высказывались только компании Micron и Samsung. Оба производителя планируют выпустить новое поколение памяти где-то в 2025–2026 годах. Теперь и SK hynix более точно определилась с планом по своему будущему продукту. Со стремительным развитием ИИ-технологий на рынке возрастает спрос на более высокопроизводительные решения, необходимые для решения этих задач. Память типа HBM сыграла значительную роль в развитии этой сферы и является важным компонентом в производстве передовых специализированных ускорителей ИИ-вычислений. И на данный момент SK hynix является главным поставщиком самой скоростной HBM — памяти HBM3E — для ИИ-ускорителей. На мероприятии SEMICON Korea 2024 вице-президент SK hynix Ким Чун Хван (Kim Chun-hwan) сообщил о намерении компании начать массовое производство памяти HBM4 к 2026 году. Он добавил, что новое поколение памяти будет способствовать стремительному росту рынка устройств для искусственного интеллекта. В то же время он отметил, что индустрия производства памяти HBM сталкивается с огромным спросом. Поэтому компании очень важно создать решения, которые позволили бы обеспечить бесперебойную поставку такого типа памяти. По мнению топ-менеджера SK hynix, к 2025 году рынок памяти HBM вырастет до 40 %, поэтому компании необходимо заранее подготовился к тому, чтобы извлечь из этого максимальную выгоду. Согласно недавно опубликованной аналитиками TrendForce сборной диаграммы с планами по выпуску продуктов различных производителей, организация JEDEC планирует принять окончательные характеристики памяти HBM4 во второй половине 2024 или начале 2025 года. Пока известно, что новая память будет выпускаться в стеках объёмом до 36 Гбайт, а первые образцы ожидаются в 2026 году. На данный момент неизвестно, какие именно ИИ-ускорители будут использовать новый тип памяти. Предполагается, что одними из первых таких продуктов могут стать решения NVIDIA, которые компания выпустит после специализированных ИИ-ускорителей Blackwell, поскольку последние будут использовать память HBM3E. Память HBM4 дебютирует только в 2026 году, а ещё через год появятся 16-слойные стеки

27.11.2023 [12:07],

Алексей Разин

До сих пор единственным поставщиком микросхем HBM3 для нужд NVIDIA оставалась южнокорейская компания SK hynix, но в случае с HBM3e конкурирующая Micron Technology начала снабжать NVIDIA образцами своей продукции к концу июля, поэтому борьба за место на рынке в этом сегменте памяти будет ожесточённой. К 2026 году на рынок будет готова выйти память типа HBM4, которая годом позднее увеличит количество слоёв с 12 до 16 штук.

Источник изображения: SK hynix Ближайшая перспектива в эволюции памяти типа HBM3e, как поясняет TrendForce — это выход 8-слойных микросхем, которые к первому кварталу следующего года должны пройти сертификацию NVIDIA и прочих клиентов, а затем перейти в фазу серийного производства. Micron Technology в этой сфере слегка опережает SK hynix, предоставив свои образцы для тестирования на пару недель раньше, а вот Samsung успела сделать это только к началу октября. Память типа HBM3e способна обеспечить скорость передачи информации от 8 до 9,2 Гбит/с, восьмислойные микросхемы объёмом 24 Гбайт будут выпускаться по техпроцессам класса 1-альфа (Samsung) или 1-бета (SK hynix и Micron). Их серийное производство к середине следующего года наладят все три компании, но две последних рассчитывают это сделать к началу второго квартала. Во многом этот график будет определять ритмичность выхода новых ускорителей вычислений NVIDIA. В следующем году компания наладит поставки ускорителей H200 с шестью микросхемами HBM3e, до конца того же года выйдут ускорители B100 уже с восемью микросхемами HBM3e. Попутно будут выпускаться гибридные решения с центральными процессорами с Arm-совместимой архитектурой, именуемые GH200 и GB200. Конкурирующая компания AMD, по данным TrendForce, в 2024 году сосредоточится на использовании памяти типа HBM3 в семействе ускорителей Instinct MI300, а переход на HBM3e прибережёт для более поздних Instinct MI350. Тестирование памяти на совместимость в этом случае начнётся во второй половине 2024 года, а фактические поставки микросхем HBM3e для AMD стартуют не ранее первого квартала 2025 года. Представленные во второй половине прошлого года ускорители Intel Habana Gaudi 2 ограничиваются использованием шести стеков HBM2e, преемники серии Gaudi 3 к середине следующего года увеличат количество стеков до 8 штук, но останутся верны использованию микросхем HBM2e. Память типа HBM4 будет представлена только в 2026 году, она предложит использование 12-нм подложки, которая будет изготавливаться контрактными производителями. Количество слоёв в одном стеке памяти будет варьироваться между 12 и 16 штуками, причём микросхемы последнего типа появятся на рынке не ранее 2027 года. Впрочем, Samsung Electronics демонстрирует намерения представить HBM4 уже в 2025 году, наверстав упущенное по сравнению с предыдущими поколениями микросхем памяти этого класса. В ближайшие годы сформируется и тренд на индивидуализацию дизайна решений с использованием памяти типа HBM. В частности, некоторые разработчики рассматривают возможность интеграции чипов такой памяти непосредственно на кристаллы с вычислительными ядрами. По крайней мере, NVIDIA подобные намерения уже приписываются, и именно в отношении микросхем типа HBM4. Samsung намерена выпустить память HBM4 в 2025 году

12.10.2023 [13:11],

Алексей Разин

В 2016 году корейская компания Samsung Electronics первой в отрасли выпустила на рынок микросхемы памяти HBM первого поколения для применения в сегменте высокопроизводительных вычислений. Через год появилась 8-слойная память типа HBM2, позже вышли микросхемы HBM2E и HBM3, а память типа HBM4 компания рассчитывает представить в 2025 году.

Источник изображения: Samsung Electronics Как сообщается в корпоративном блоге компании, при выпуске микросхем типа HBM4 будут применяться инновации, направленные на улучшение термодинамических свойств этого вида продукции — проще говоря, будут применены решения для лучшего отвода тепла. При сборке стеков памяти будет применяться непроводящая полимерная плёнка, дополнительно механически защищающая монтируемые друг на друга чипы. Метод гибридного медного соединения будет сочетать медные проводники с плёночным оксидным изолятором вместо традиционного припоя. Кроме того, как признаются представители Samsung Electronics, в начале 2023 года компания создала подразделение, курирующее передовые методы упаковки чипов. Своим клиентам южнокорейский гигант будет готов предложить услуги по тестированию и упаковке чипов с использованием методов 2.5D и 3D, которые могут быть востребованы разработчиками компонентов для высокопроизводительных вычислений и систем искусственного интеллекта. К числу своих технологических достижений Samsung также относит выпуск микросхем оперативной памяти типа DDR5, позволяющих создавать модули памяти объёмом 128 Гбайт, а также освоение 12-нм техпроцесса в данной сфере. В дальнейшем компания рассчитывает использовать для выпуска микросхем памяти литографические нормы тоньше 10 нм. В сфере высокопроизводительных вычислений может найти достойное применение и технология HBM-PIM, предусматривающая выполнение определённой части вычислений непосредственно силами самой микросхемы памяти. Быстродействие при этом удаётся повысить до 12 раз по сравнению с традиционной архитектурой микросхем памяти. Помимо HBM, такая архитектура будет внедряться и на микросхемах памяти, работающих с протоколом CXL. Представленные недавно модули оперативной памяти LPCAMM, по словам представителей Samsung, можно будет применять не только в ноутбуках, но и в серверных системах, где их высокая плотность позволит увеличить объём используемой оперативной памяти без дополнительной потребности в занимаемых площадях. Такие модули памяти будет занимать на 60 % меньше места по сравнению с SO-DIMM, а производительность при этом вырастает на величину до 50 %. Энергетическая эффективность таких модулей памяти выше на 70 %. |