|

Опрос

|

реклама

Быстрый переход

StabilityAI представила улучшенную ИИ-модель для генерации изображений Stable Diffusion 3.5

23.10.2024 [05:06],

Анжелла Марина

Компания StabilityAI представила новую версию ИИ-модели для генерации изображений Stable Diffusion 3.5 с улучшенным реализмом, точностью и стилизацией. По сообщению Tom's Guide, модель бесплатна для некоммерческого использования, включая научные исследования, а также для малых и средних предприятий с доходом до $1 млн.

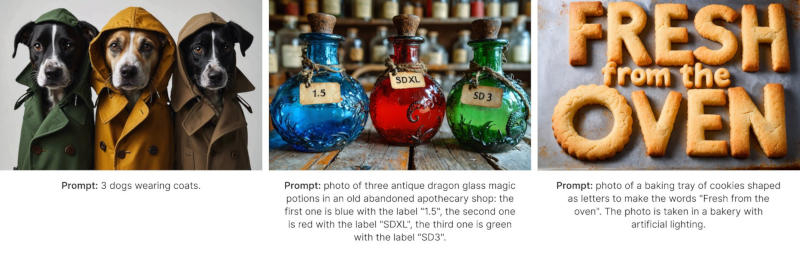

Источник изображения: StabilityAI Как и предыдущая версия SD3, Stable Diffusion 3.5 доступен в трёх конфигурациях: Large (8B), Large Turbo (8B) и Medium (2,6B). Все конфигурации оптимизированы для работы на обычном пользовательском оборудовании и их можно настраивать. В своём пресс-релизе StabilityAI признала, что модель Stable Diffusion 3 Medium, выпущенная в июне, не полностью соответствовала стандартам и ожиданиям сообщества. «После того как мы выслушали ценные отзывы, вместо быстрого исправления мы решили уделить время разработке версии, которая продвигает нашу миссию по трансформации визуальных медиа», — сказали в компании. Новые модели ориентированы на возможность гибкой настройки, высокую производительность и разнообразие результатов. Поддерживаются стилистические настройки, включая фотографию и живопись. Для указания определённого стиля можно также использовать хештеги, например, boho, impressionism или modern. Ещё можно выделять ключевые слова в запросе для получения более реалистичных изображений. Модель Stable Diffusion 3.5 Large лидирует на рынке по лучшему соответствию запросам и качеству изображений. Модель Turbo имеет минимальное время вывода результатов. Medium превосходит другие модели в плане баланса между качеством изображений и соответствия запросам, что делает её, по утверждению компании, самым эффективным выбором для создания контента. Все три конфигурации свободно доступны по лицензии Stability AI Community License. Для использования в коммерческих целях потребуется лицензия Enterprise License. Stability AI представила Stable Fast 3D — ИИ-инструмент для быстрого создания 3D-изображений

02.08.2024 [19:29],

Анжелла Марина

Компания Stability AI, разработчик в области искусственного интеллекта, создала на основе генеративного ИИ технологию, которая позволяет молниеносно генерировать 3D-изображения. Если раньше требовалось мощное оборудование и сложное программирование, то теперь модель Stable Fast 3D, состоящая из двух миллиардов параметров, способна генерировать на основе текста или референса яркие, фотореалистичные изображения всего за полсекунды, сообщает VentureBeat.

Источник изображения: Stability.ai По заявлению компании, технология знаменует собой значительный прорыв в области 3D-моделирования, сокращая время обработки изображений. «Это в 1200 раз быстрее, чем наша предыдущая модель Stable Video 3D, выпущенная в марте, которой требовалось до 10 минут для создания только одного 3D-объекта», — отмечают представители Stability AI. Stable Fast 3D обещает стать мощным инструментом для различных отраслей, включая дизайн, архитектуру, розничную торговлю, виртуальную реальность и разработку игр. В его основе лежит технология TripoSR, разработанная в сотрудничестве с компанией Trip AI, специализирующейся на 3D-моделировании.

Источник изображения: Stability.ai В исследовательской статье, опубликованной Stability AI, подробно описываются методы, используемые новой моделью для быстрой реконструкции высококачественных 3D-сеток из обычных 2D-изображений. Суть метода заключается в увеличении скорости генерации конечного результата без потери качества. При этом технология использует усовершенствованную нейронную сеть-трансформер для создания объёмных изображений в высоком разрешении без значительного увеличения вычислительной мощности, что позволяет уменьшать артефакты и получать более детализированные 3D-модели. Кроме того, Stable Fast 3D использует инновационный подход к оценке освещения и материалов. ИИ-модель может определить глобальные значения, например шероховатость, жидкость или металл, используя метод вероятности, который улучшает качество изображения. Технология также позволяет объединять несколько элементов, необходимых для 3D-изображения, включая сетку, текстуры и свойства материалов, в компактный, готовый к использованию 3D-актив. Интересно, что Stability AI продолжает активно расширять границы использования генеративного ИИ, переходя от 2D к 4D. Компания, начавшая свой путь с генерации изображений по тексту — Stable Diffusion, уже в ноябре 2023 года выпустила Stable 3D. В марте этого года дебютировала с технологией Stable Video 3D с возможностью базового панорамирования камеры для просмотра изображений и улучшенным качеством генерации 3D-изображений. А буквально на прошлой неделе анонсировала технологию Stable Video 4D, которая добавляет измерение времени к генерации коротких 3D-видео. Модель Stable Fast 3D доступна через чат-бота Stable Assistant от Stability AI, API Stability AI, а также по лицензии научно-исследовательского сообщества Hugging Face. Stability AI сменила руководство и привлекла 80 млн долларов инвестиций

26.06.2024 [18:16],

Сергей Сурабекянц

Стартап в области искусственного интеллекта Stability AI в последнее время столкнулся с растущими затратами и текучкой кадров. Сегодня компания объявила о назначении генеральным директором Према Аккараджу (Prem Akkaraju). Должность председателя правления занял крупный инвестор Шон Паркер (Sean Parker). Сообщается, что в общей сложности Stability AI удалось привлечь финансирование в размере $80 млн.

Источник изображения: stability.ai «Компания находится в идеальном положении, чтобы возглавить реальную конвергенцию генеративного искусственного интеллекта и студийного контента», — говорится в заявлении Аккараджу, который вместе с Паркером войдёт в совет директоров. Назначение нового руководителя Stability AI положило конец многомесячному хаосу в некогда популярном стартапе. В марте соучредитель и первый генеральный директор компании Эмад Мостак (Emad Mostaque) подал в отставку из-за ухода ключевых сотрудников и акционеров, и сокращения денежных резервов. После его увольнения ключевой инвестор Coatue Management вышел из совета директоров, но после назначения нового руководителя возобновил своё участие в инвестициях. Кроме Coatue Management в новом раунде финансирования приняли участие такие инвесторы, как Lightspeed Venture Partners, Greycroft, миллиардер Эрик Шмидт (Eric Schmidt), а также Аккараджу и Паркер. Временные генеральные директора Шань Вонг (Shan Wong) и Кристиан Лафорте (Christian Laforte) останутся в Stability AI в качестве главного операционного директора и технического директора соответственно. Stability AI в конце 2022 года привлекла $101 млн венчурного капитала благодаря разработанному её сотрудниками популярному ИИ-инструменту для генерации изображений Stable Diffusion. Затем компания столкнулась с целым рядом управленческих и юридических проблем, включая иск от Getty Images. В отличие от конкурирующих компаний, Stability AI долгое время не удавалось привлечь дополнительное финансирование. Представлен ИИ-генератор изображений Stable Diffusion Medium, которому достаточно видеокарты с 5 Гбайт памяти

12.06.2024 [18:22],

Павел Котов

Компания Stability AI представила модель искусственного интеллекта Stable Diffusion Medium, предназначенную для генерации изображений по текстовому описанию. Её старшая версия Stable Diffusion 3 была анонсирована ещё в феврале, а в апреле она заработала через API.

Источник изображений: Stability AI Stable Diffusion Medium задумана как модель меньшего размера — очень мощная, но способная работать на потребительских видеокартах. Уменьшенный вариант Stable Diffusion 3 станет привлекательным вариантом для пользователей и организаций с ограниченными ресурсами, которым необходимо запустить высокоэффективную систему генерации изображений. Испробовать новую нейросеть пока можно через API, на сервере Stable Artisan через Discord; веса модели также доступны для некоммерческого использования на Hugging Face.  С выходом новой нейросети представленная ранее большая модель переименовывается в Stable Diffusion 3 (SD3) Large — она имеет 8 млрд параметров, тогда как у новой SD3 Medium только 2 млрд параметров, зато она может работать на домашних видеокартах, выдвигая системное требование в 5 Гбайт видеопамяти. Раньше для моделей Stable Diffusion требовались исключительно передовые модели Nvidia, но и сейчас рекомендуются всё-таки видеокарты с 16 Гбайт памяти.  При относительно скромных требованиях к ресурсам SD3 Medium предлагает широкие возможности, сопоставимые по ряду функций со старшей SD3 Large: фотореализм, типографику, понимание естественного языка и пространственного расположения элементов на изображении, высокую детализацию на мегапиксель и высокую адаптируемость с возможностью тонкой настройки. В MIT придумали, как в 30 раз ускорить генерацию изображений с помощью ИИ

24.03.2024 [14:00],

Владимир Чижевский

Исследователи из Массачусетского технологического института (MIT) смогли заметно ускорить создание изображений по текстовым описаниям с помощью генеративного искусственного интеллекта. Новый метод позволяет генерировать изображения высокой чёткости в 30 раз быстрее существующих.

Источник изображения: pixabay.com Обычно в генеративных ИИ применяется техника так называемой «диффузии», когда создаётся максимально размытая картинка, а затем она детализируется до окончательного результата, максимально соответствующего тому, что ИИ может выдать в ответ на запрос пользователя. Диффузия занимает довольно много времени, поэтому исследователи MIT поставили цель её ускорить. Исследователи из Лаборатории компьютерных наук и искусственного интеллекта MIT свели генерацию изображений к единственному проходу, а новый метод назвали «дистилляцией с согласованным распределением» (distribution matching distillation). Очевидно, что генерация картинки в один проход заметно быстрее, чем за типичные для диффузионных моделей 30–50 шагов. Так, на современном оборудовании Stable Diffusion 1.5 создаёт изображение за 1,5 секунды, в то время как новая модель на основе DMD справляется за 0,05 секунды. Это не первая попытка дистилляции диффузионных моделей для ускорения генерации изображений. В Instaflow и LCM пытались применить похожий подход, но результаты не впечатляли. Компания Stability AI также пыталась ускорить диффузионные модели и добилась некоторых успехов, выпустив Stable Diffusion Turbo, создающую картинку с разрешением до 1 мегапикселя за один проход, однако сгенерированные в несколько проходов изображения всё равно получались заметно лучше. ИИ-ускоритель Intel Gaudi2 оказался на 55 % быстрее Nvidia H100 в тестах Stable Diffusion 3, но есть нюанс

12.03.2024 [18:34],

Сергей Сурабекянц

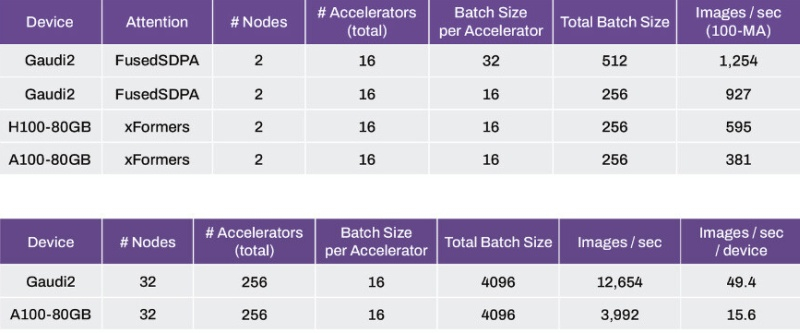

Компания Stability AI, разработчик популярной модели генеративного ИИ Stable Diffusion, сравнила производительность модели Stable Diffusion 3 на популярных ускорителях вычислений для центров обработки данных, включая Nvidia H100 Hopper, A100 Ampere и Intel Gaudi2. По утверждению Stability AI, Intel Gaudi2 продемонстрировал производительность примерно на 56 % выше, чем Nvidia H100.

Источник изображения: Intel В отличие от H100, который представляет собой суперскалярный графический процессор с тензорными CUDA-ядрами, Gaudi2 специально спроектирован для ускорения генеративного ИИ и больших языковых моделей (LLM). В тестах приняли участие пары кластеров, которые в сумме обеспечивали по 16 тех или ускорителей, а проводились тесты с постоянным размером батча (число тренировочных объектов) в 16 на каждый ускоритель (всего 256). Системы на Intel Gaudi2 оказались способны генерировать 927 изображений в секунду по сравнению с 595 изображениями для ускорителей H100 и 381 изображением в секунду для массива A100.

Источник изображения: Stability AI При увеличении количества кластеров до 32, а числа ускорителей до 256 и размере батча 16 на ускоритель (общий размер 4096), массив Gaudi2 генерирует 12 654 изображения в секунду или 49,4 изображения в секунду на ускоритель, по сравнению с 3992 изображениями в секунду или 15,6 изображениями в секунду на устройство у массива A100 Ampere.

Источник изображения: Nvidia Необходимо отметить, что производительность ускорителей ИИ измерялась с использованием фреймворка PyTorch, а в случае применения оптимизации TensorRT чипы A100 создают изображения до 40 % быстрее, чем Gaudi2. Тем не менее, исследователи Stability AI ожидают, что при дальнейшей оптимизации Gaudi2 превзойдёт A100. Компания полагает, что более быстрый интерконнект и больший объем памяти (96 Гбайт) делают решения Intel вполне конкурентоспособными и планирует использовать ускорители Gaudi2 в Stability Cloud.

Источник изображения: techpowerup.com По сообщению Stability AI, в более ранних тестах модели Stable Diffusion XL с использованием фреймворка PyTorch ускоритель Intel Gaudi2 генерирует при 30 шагах изображение размером 1024 × 1024 за 3,2 секунды по сравнению с 3,6 секунды для PyTorch на Nvidia A100 и 2,7 секунды при использовании оптимизации TensorRT на Nvidia А100. Анонсирована Stable Diffusion 3.0 — ИИ для рисования сменил архитектуру и научился писать

23.02.2024 [00:39],

Андрей Созинов

Компания Stability AI выпустила предварительную версию Stable Diffusion 3.0 — флагманской модели искусственного интеллекта следующего поколения для генерации изображений по текстовому описанию. Stable Diffusion 3.0 будет доступна в разных версиях на базе нейросетей размером от 800 млн до 8 млрд параметров.

Источник изображений: Stable Diffusion 3.0 В течение последнего года компания Stability AI постоянно совершенствовала и выпускала несколько нейросетей, каждая из которых показывала растущий уровень сложности и качества. Выпуск SDXL в июле значительно улучшил базовую модель Stable Diffusion, и теперь компания собирается пойти значительно дальше. Новая модель Stable Diffusion 3.0 призвана обеспечить улучшенное качество изображения и лучшую производительность при создании изображений из сложных подсказок. Новая нейросеть обеспечит значительно лучшую типографику, чем предыдущие версии Stable Diffusion, обеспечивая более точное написание текста внутри сгенерированных изображений. В прошлом типографика была слабой стороной Stable Diffusion, собственно, как и многих других ИИ-художников. Stable Diffusion 3.0 — это не просто новая версия модели прежней Stability AI, ведь она основана на новой архитектуре. «Stable Diffusion 3 – это диффузионная модель-трансформер, архитектура нового типа, которая аналогична той, что используется в представленной недавно модели OpenAI Sora, — рассказал VentureBeat Эмад Мостак (Emad Mostaque), генеральный директор Stability AI. — Это настоящий преемник оригинальной Stable Diffusion».  Stability AI экспериментирует с несколькими типами подходов к созданию изображений. Ранее в этом месяце компания выпустила предварительную версию Stable Cascade, которая использует архитектуру Würstchen для повышения производительности и точности. Stable Diffusion 3.0 использует другой подход, используя диффузионные модели-трансформеры. «Раньше у Stable Diffusion не было трансформера», — сказал Мостак. Трансформеры лежат в основе большей части современных нейросетей, запустивших революцию в области искусственного интеллекта. Они широко используются в качестве основы моделей генерации текста. Генерация изображений в основном находилась в сфере диффузионных моделей. В исследовательской работе, в которой подробно описываются диффузионные трансформеры (DiT), объясняется, что это новая архитектура для диффузионных моделей, которая заменяет широко используемую магистраль U-Net трансформером, работающим на скрытых участках изображения. Применение DiT позволяет более эффективно использовать вычислительные мощности и превосходить другие подходы к диффузной генерации изображений. Еще одна важная инновация, которой пользуется Stable Diffusion 3.0 — это согласование потоков. В исследовательской работе по сопоставлению потоков объясняется, что это новый метод обучения нейросетей с помощью «непрерывных нормализующих потоков» (Conditional Flow Matching — CNF) для моделирования сложных распределений данных. По мнению исследователей, использование CFM с оптимальными путями транспортировки приводит к более быстрому обучению, более эффективному отбору образцов и повышению производительности по сравнению с диффузионными путями.  Улучшенная типографика в Stable Diffusion 3.0 является результатом нескольких улучшений, которые Stability AI встроил в новую модель. Как пояснил Мостак, качественная генерация текстов на изображения стала возможной благодаря использованию диффузионной модели-трансформера и дополнительных кодировщиков текста. С помощью Stable Diffusion 3.0 стало возможным генерировать на изображениях полные предложения со связным стилем написания текста. Хотя Stable Diffusion 3.0 изначально демонстрируется как технология искусственного интеллекта для преобразования текста в изображение, она станет основой для гораздо большего. В последние месяцы Stability AI также создаст нейросети для создания 3D-изображений и видео. «Мы создаем открытые модели, которые можно использовать где угодно и адаптировать к любым потребностям, — сказал Мостак. — Это серия моделей разных размеров, которая послужит основой для разработки наших визуальных моделей следующего поколения, включая видео, 3D и многое другое». В популярных материалах для обучения нейросетей нашли изображения сексуального насилия над детьми

20.12.2023 [22:46],

Сергей Сурабекянц

Исследователи из Стэнфорда обнаружили, что популярный набор данных LAION-5B, используемый для обучения моделей генеративного искусственного интеллекта, и применявшийся для Stable Diffusion и Google Imagen, включает в себя сотни ссылок на материалы сексуального насилия над детьми (Child Sexual Abuse Material — CSAM). Установлено, что LAION-5B включал по меньшей мере 1679 нелегальных изображений, взятых из постов в социальных сетях и популярных сайтов для взрослых.

Источник изображения: LAION Исследователи начали изучение набора данных LAION в сентябре 2023 года, стремясь выяснить, используются ли там материалы с сексуальным насилием над детьми. С этой целью хеши или идентификаторы изображений отправлялись на платформы обнаружения CSAM, такие как PhotoDNA, и в Канадский центр защиты детей. Исследователи из Стэнфорда отметили, что наличие CSAM в наборе данных для обучения ИИ не обязательно негативно повлияет на результаты обученных моделей. Тем не менее, всегда есть вероятность, что модель использует что-то из незаконных материалов при генерации изображений. «Наличие повторяющихся идентичных случаев CSAM также является проблематичным, особенно из-за увеличения вероятности получения изображений конкретных жертв», — говорится в отчёте. LAION, некоммерческая организация, которая управляет набором данных, сообщила, что придерживается политики «нулевой терпимости» к вредоносному контенту и временно удалит наборы данных из Сети. Согласно сайту LAION, набор данных не является непосредственно репозиторием изображений. Он представляет собой результат индексирования ресурсов интернета и содержит ссылки на изображения и замещающий текст. Stability AI сообщила, что внутренние правила компании запрещают неправомерное использование её платформ. Компания утверждает, что при обучении своих моделей на наборе данных LAION-5B, она использовала лишь часть материалов, которые отбирались в том числе и с учётом безопасности. Эксперты полагают, что будет сложно полностью удалить проблемный контент из моделей ИИ, обученных на нём. Они рекомендуют подождать, чтобы модели, обученные на LAION-5B, такие как Stable Diffusion 1.5, «устарели, а распространение прекратилось там, где это возможно». Google выпустила новую версию Imagen, но не раскрыла, на каком наборе данных она обучалась. Генеральные прокуроры США призвали Конгресс создать комитет для расследования влияния ИИ на эксплуатацию детей и запретить создание CSAM, генерируемого ИИ. Стартап Stability AI начал поиск покупателя на фоне финансовых трудностей и давления инвесторов

02.12.2023 [07:50],

Дмитрий Федоров

Британский стартап в области ИИ — Stability AI, известный своим генератором изображений Stable Diffusion, ведёт переговоры с потенциальными покупателями бизнеса. Инициатива по продаже возникла на фоне возрастающего давления со стороны инвесторов, в частности Coatue Management, которые выражают обеспокоенность финансовым состоянием компании.

Источник изображения: stability.ai Стартап Stability AI, расположенный в Лондоне и известный своей генеративной ИИ-моделью Stable Diffusion, в последние недели активно ищет покупателя. Это происходит на фоне усиливающегося давления со стороны инвесторов, особенно со стороны Coatue Management, которая требует отставки главы компании, Эмада Мостака (Emad Mostaque). Требование Coatue Management об отставке Мостака последовало спустя год после того, как они помогли привлечь финансирование для Stability AI, оценив стартап в $1 млрд. Stability AI провела предварительные переговоры с несколькими потенциальными покупателями, но источники, близкие к ситуации, предупреждают, что до заключения сделки ещё далеко и процесс может быть остановлен в любой момент. В то же время представитель Stability AI подчеркнул, что компания сосредоточена на разработке новых продуктов в области ИИ, включая модель генерации видео Stable Video Diffusion, и не стремится к продаже. В августе доходы стартапа составили $1,2 млн, тогда как в текущем месяце ожидается их увеличение до $3 млн. Однако ежемесячные расходы компании на оплату счетов и зарплат достигают $8 млн. В октябре прошлого года стартап привлёк инвестиции в размере примерно $50 млн от корпорации Intel, направленные на дальнейшее развитие бизнеса. Отношения между Stability AI и её инвесторами остаются напряжёнными. Генеральный партнёр Coatue Management, Шри Вишванат (Sri Vishwanath), покинул пост директора в результате инвестиций Intel в Stability, так как Coatue Management владеет значительным пакетом акций конкурента Intel — компании AMD. Партнёр из Lightspeed Venture Partners также ушёл с поста наблюдателя в совете директоров стартапа. Intel, в свою очередь, в сентябре назвала Stability AI «якорным клиентом» для своего нового суперкомпьютера, ориентированного на ИИ. Согласно двум источникам, знакомым с условиями сделки, инвестиции Intel были частично обусловлены использованием процессоров Intel в вычислениях Stability AI. Представлен ИИ-генератор коротких видео Stable Video Diffusion

22.11.2023 [10:52],

Павел Котов

Компания Stability AI представила генеративную модель искусственного интеллекта Stable Video Diffusion, предназначенную для создания видеороликов по текстовому описанию. В её основу легла модель Stable Diffusion, которая генерирует статические изображения на основе текстовых запросов.

Источник изображения: stability.ai Исходный код Stable Video Diffusion разработчик опубликовал на GitHub, а необходимые для локального запуска модели веса доступны для скачивания на платформе Hugging Face. Компания также опубликовала исследовательский материал, в котором подробно изложила информацию о технических возможностях модели. Stable Video Diffusion свободно адаптируется для различных задач, например, её можно настроить для генерации видео по одному изображению в качестве образца. Она станет базовой платформой для целого семейства производных моделей, которые будут выходить позже — компания намеревается выстроить целую экосистему. В обозримом будущем Stability AI предложит возможность генерировать видео по текстовому описанию в веб-интерфейсе — чтобы оказаться в числе первых пользователей сервиса, нужно оформить заявку на включение в список ожидания. Stable Video Diffusion выпущена в виде двух моделей преобразования изображений в видео — они генерируют 14 (SVD) и 25 (SVD-XT) кадров видео с настраиваемой частотой от 3 до 30 кадров в секунду. Сейчас проект находится на ранней стадии, и в своём теперешнем виде модель не предназначается для создания полнофункциональных или коммерческих приложений — пока это исключительно научный проект, о работе которого собираются отзывы. В будущем, конечно, планируется выпуск полной версии Stable Video Diffusion. Представлен ИИ-генератор музыки Stable Audio, который творит по текстовым описаниям

13.09.2023 [22:10],

Сергей Сурабекянц

Stability AI, разработавшая технологию искусственного интеллекта Stable Diffusion для преобразования текста в изображение, объявила о публичном релизе нейросети Stable Audio для генерации коротких аудиоклипов на основе текстовых описаний. Stable Audio базируется на тех же основных методах работы ИИ, которые используются Stable Diffusion при создании изображений.

Источник изображения: Pixabay «Stability AI наиболее известен своей работой с изображениями, но теперь мы запускаем наш первый продукт для создания музыки и аудио, который называется Stable Audio, — рассказал вице-президент по звуку в Stability AI Эд Ньютон-Рекс (Ed Newton-Rex). — Идея очень проста: вы описываете музыку или аудио, которые хотите услышать, в тексте, и наша система генерирует их для вас». Эд не новичок в мире компьютерной музыки: в 2011 году он создал стартап Jukedeck, который в 2019 был куплен TikTok. Однако технология, лежащая в основе Stable Audio, уходит корнями не в Jukedeck, а во внутреннюю исследовательскую студию Stability AI по созданию музыки под названием Harmonai, созданную Заком Эвансом (Zach Evans). Эванс объяснил, что текстовая модель использует технику, известную как предварительная подготовка аудиоконтрастного языка (CLAP). Модель Stable Audio имеет около 1,2 миллиарда параметров, что примерно соответствует исходной версии Stable Diffusion для генерации изображений. Возможность генерировать базовые звуковые дорожки с помощью технологии не является чем-то новым. В прошлом использовался метод так называемой символьной генерации, которая обычно используется при работе с форматом MIDI (цифровой интерфейс музыкальных инструментов). Генеративные возможности ИИ Stable Audio позволяют пользователям создавать новую музыку, выходящую за рамки повторяющихся последовательностей нот, характерных для MIDI и символьной генерации.

Источник изображения: Atomic Heart Stable Audio работает напрямую с необработанными аудиосэмплами для обеспечения более высокого качества вывода. Модель обучалась на более чем 800 000 фрагментах лицензионной музыки из аудиотеки AudioSparks. «Одна из самых сложных задач при создании текстовых моделей — получение аудиоданных, которые не только являются высококачественным звуком, но и имеют соответствующие метаданные» — пояснил Эванс. Одна из распространённых задач, которые пользователи ставят перед моделями генерации изображений — стилизация под конкретного художника. Однако в случае Stable Audio пользователи не смогут обратиться к ИИ с подобным запросом — по мнению создателей Stable Audio, большинство музыкантов скорее захотят проявить больше творчества. Модель Stable Audio будет доступна как бесплатно, так и по тарифному плану Pro за $12 в месяц. Бесплатная версия позволяет создавать 20 треков в месяц продолжительностью до 20 секунд, а версия Pro увеличивает число треков до 500, а время их звучания до 90 секунд. Ещё последняя позволяет коммерческое использование произведений. В рамках запуска Stable Audio Stability AI также выпустит руководство по текстовым подсказкам. Stability AI представила Stable Doodle — ИИ, который превращает эскизы в полноценные рисунки

13.07.2023 [17:03],

Павел Котов

Ответственный за ИИ-генератор изображений Stable Diffusion стартап Stability AI представил сервис Stable Doodle, способный превращать эскизы в полноценные детализированные изображения.

Источник изображения: stability.ai Платформой для сервиса Stable Doodle стала модель Stable Diffusion XL — она анализирует контуры эскиза и генерирует его «визуально приятное» художественное воплощение. Испытать новый инструмент можно на платформе ClipDrop, которую Stability AI в минувшем марте приобрела вместе со стартапом Init ML, созданным бывшими работниками Google. Разработчик признал, что это не первый инструмент, предлагающий создание детализированных художественных изображений по примитивным эскизам, но отметил, что Stable Doodle работает быстрее аналогов и обеспечивает более качественный результат. Ещё одним компонентом, обеспечивающим работу инструмента, стал модуль T2I-Adapter, который анализирует входящее изображение и транслирует результат на генеративную ИИ-модель. В качестве дополнительного средства Stable Doodle позволяет оставить текстовое описание для исходного эскиза. Stable Diffusion XL также позволяет выбирать стиль изображения на выходе: «Фотография», «Аниме», «Оригами», «Трёхмерная модель» — всего 14 вариантов. В Stability AI рассказали, что Stable Doodle окажется полезным инструментом для дизайнеров или иллюстраторов и поможет им сэкономить время. При этом в компании предупредили, что качество изображения на выходе зависит от числа деталей на исходном эскизе, информативности подсказки и сложности поставленной задачи. Нейросеть Stable Diffusion научили генерировать нормальные человеческие пальцы

23.06.2023 [15:42],

Павел Котов

Компания Stability AI представила (но впоследствии удалила анонс из блога) обновлённую версию нейросети для генерации изображений по текстовому описанию Stable Diffusion — она получила название SDXL 0.9. По сравнению с предшествующей новая версия обещает создание более качественных и детализированных фотореалистичных картинок.

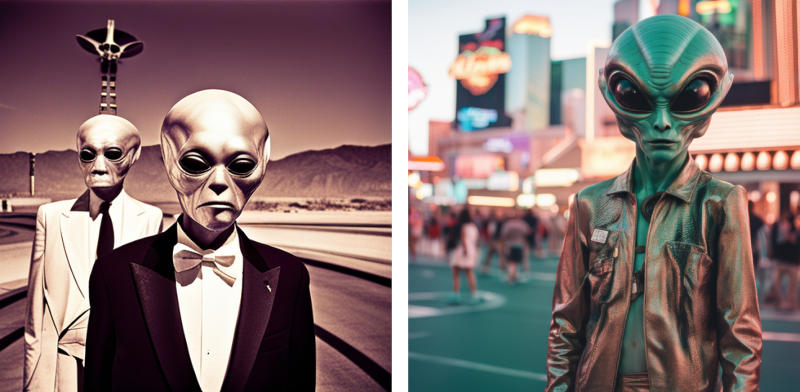

Изображения по описанию: «Инопланетяне гуляют среди нас в Лас-Вегасе, найденная плёночная фотография». Слева — работа Stable Diffusion XL, справа — SDXL 0.9. Источник изображений: stability.ai Разработчик охарактеризовал новую модель искусственного интеллекта как «прорыв в творческих вариантах применения генеративного ИИ изображений». Своё заявление в Stability AI подкрепили парными примерами картинок, созданных моделью Stable Diffusion XL и новой SDXL 0.9: фотореалистичные изображения волка, инопланетянина в Лас-Вегасе, а также человеческой руки с кофейным стаканчиком — во всех случаях новая версия модели предлагает более детализированные и правдоподобные картинки.

«Волк в Национальном парке Йосемити, документальная съёмка природы» В Stability AI добавили, что успеха удалось добиться за счёт значительно увеличения количества параметров обновлённой модели. Подчёркивается, что SDXL 0.9, как и все предшествующие платформы, можно запустить на домашнем компьютере. Системные требования включают 16 Гбайт оперативной памяти и видеокарту NVIDIA серии GeForce RTX 20 и выше с 8 Гбайт памяти на борту. Поддерживаются Windows 10/11 и Linux.

«Рука с маникюром держит кофе навынос, рассвет в пастельных тонах, пляж, Instagram✴ и плёночная фотография» Обновлённая модель в ближайшее время станет доступной в веб-сервисе Stability AI Clipdrop, а также в приложении DreamStudio. На середину июля намечен выход SDXL 1.0 с открытым исходным кодом. Stability AI выпустила StableStudio — открытое веб-приложение для генерации изображений с помощью ИИ

19.05.2023 [12:01],

Павел Котов

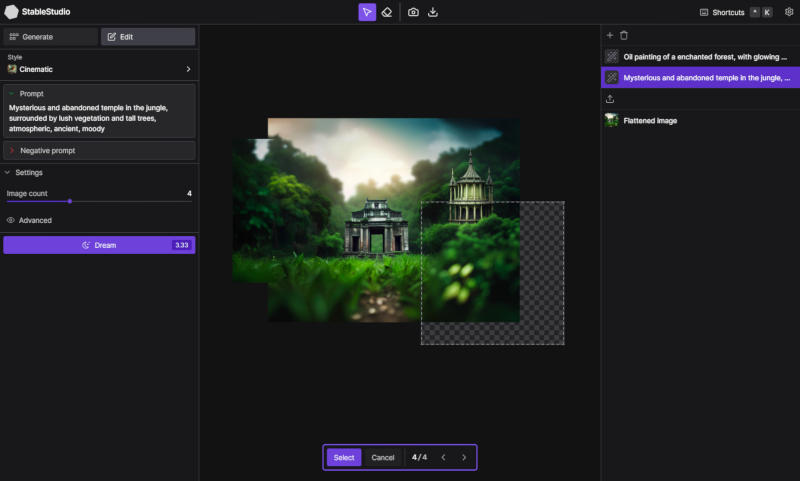

Специализирующийся на технологиях искусственного интеллекта стартап Stability AI объявил о выходе StableStudio — открытого пользовательского интерфейса (веб-приложения) для работы с нейросетью Stable Diffusion, генерирующей изображения по текстовому описанию. Фактически это открытая версия платформы DreamStudio.

Источник изображения: github.com/Stability-AI Первоначально DreamStudio разрабатывалась как интерфейс для работы с генеративной арт-моделью Disco Diffusion от Google, но с появлением у Stability AI собственной нейросети Stable Diffusion проект стал полноценным конкурентом Midjourney и NightCafe. Отличия коммерческой DreamStudio и открытой StableStudio минимальны — в последней нет специфических для Stability функций учётных записей, таких как управление лицевым счётом и вызовы API. На смену серверному API пришли подключаемые модули. В Stability AI подчеркнули, что DreamStudio остаётся основным продуктом, а StableStudio будет обновляться «по возможности». Для работы с StableStudio пользователю нужно установить Node.js и Yarn, после чего он сможет клонировать репозиторий, запустить необходимые команды и начать использовать StableStudio. Для подключения стандартного плагина Stability API необходим API-ключ, который можно получить в аккаунте DreamStudio. Подробнее процесс описан на странице StableStudio на Github. Компания активно выпускает проекты с открытым кодом: различные версии Stable Diffusion публиковались с момента выхода в августе прошлого года, а месяц назад был выпущен набор больших языковых моделей StableLM. Глава Stability AI Эмад Мостак (Emad Mostaque) неоднократно говорил о важности этого направления для повышения общественного доверия к отрасли ИИ. Зарабатывать же компания планирует за счёт разработки индивидуальных версий DreamStudio для корпоративных клиентов. ИИ-модель смогла нарисовать котёнка на мощностях всего одного смартфона

24.02.2023 [15:08],

Павел Котов

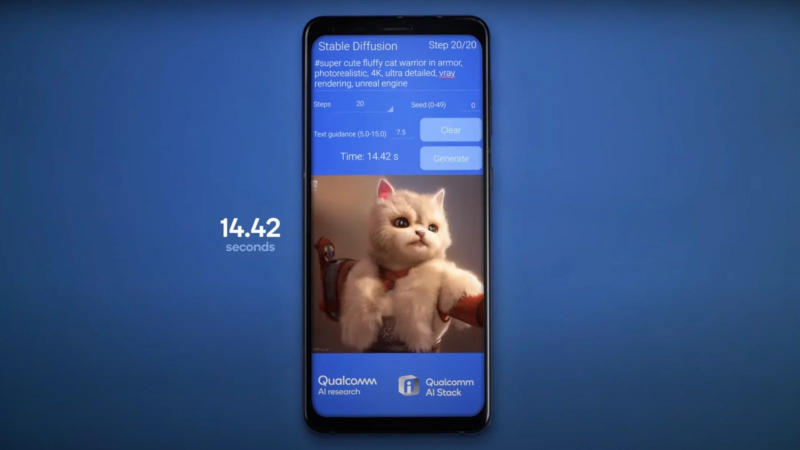

Для работы генеративных ИИ-моделей, например, создающих изображения по текстовому описанию, обычно требуется ПК с мощной видеокартой или даже ресурсы целого ЦОД. Но в Qualcomm нашли способ запустить модель Stable Diffusion на Android-телефоне Samsung Galaxy S23 с процессором Snapdragon 8 Gen 2.

Источник изображения: Qualcomm На демонстрации Stable Diffusion поставили задачу создать изображение «супермилого пушистого кота-воина в доспехах». Запущенная на телефоне ИИ-модель справилась с задачей за 14,42 с, то есть близко ко времени, которое показывают десктопы. Для оптимизации ПО под мобильный процессор было применено «квантование» данных — их округление до заданных значений. За счёт этого удалось повысить производительность модели, снизить потребление ресурсов оперативной памяти и потребление энергии. При работе на телефоне ИИ-модель выдаёт изображения в разрешении 512 × 512 пикселей — столько же, сколько предполагает и стандартная версия Stable Diffusion. Трудно переоценить возможность запуска мощной ИИ-модели локально на телефоне без необходимости открывать веб-сайт или запускать приложение, которое задействует сторонние вычислительные ресурсы. В Qualcomm отметили, что существует множество вариантов использования Stable Diffusion: создание и редактирование изображений, копирование стилей, масштабирование и многое другое. Компания собирается перенести на устройства с процессорами Snapdragon 8 Gen 2 и другие генеративные ИИ-модели. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |