⇣ Содержание

|

Опрос

|

реклама

Самое интересное в новостях

Думать самим — или разумом ИИ?

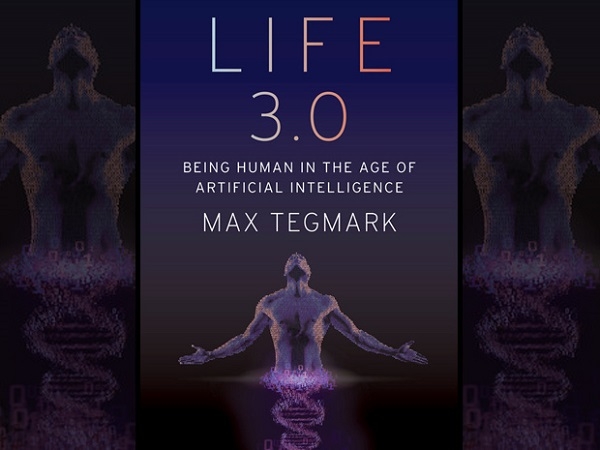

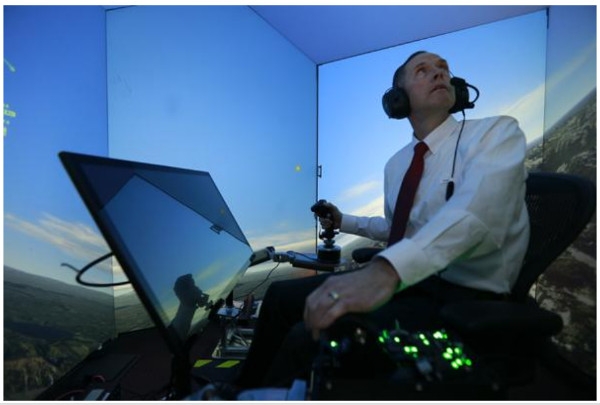

⇡#«Жизнь 3.0» и «Карта маршрутов»Случилось так, что два известных в своих областях человека независимо и практически одновременно опубликовали две исследовательские работы, дающие диаметрально противоположные, по сути, взгляды на одну и ту же большую проблему. Собственно проблему можно сформулировать словами «искусственный интеллект как угроза существованию человечества», а суть принципиально разных к ней подходов у данных авторов сводится к следующему.  Макс Тегмарк наиболее известен в мире как физик-теоретик. Кроме того, он активно занимается общественной деятельностью и несколько лет назад стал сооснователем института «Будущее жизни» в Кембридже, штат Массачусетс, США (девиз института: «Технологии как никогда раньше дают жизни потенциал к процветанию... или же к самоуничтожению. Давайте же сделаем так, чтобы разница зависела от нас!»). Теперь же в своей новой книге «Жизнь 3.0: быть человеком в эпоху искусственного интеллекта» (Max Tegmark, "Life 3.0: Being Human in the Age of Artificial Intelligence", Knopf: 2017) Тегмарк подробно анализирует одну из наиболее существенных особенностей в развитии новейших технологий – стремительную эволюцию систем ИИ. Главным итогом анализов ученого здесь становится вывод, что очевидные риски данного процесса уже сейчас требуют от нас серьезнейших размышлений и очень аккуратных действий. Если, конечно, у людей имеется понимание того, что наше «космическое предназначение» совсем не в том, чтобы по ходу прогресса оказаться выброшенными на обочину истории...  Другая работа, оценивающая «угрозы ИИ» с абсолютно иных позиций, – это аналитическое эссе от профессора-правоведа Райана Кало, опубликованное под названием «Политика в области искусственного интеллекта: карта маршрутов». За последние годы Кало как профессиональный юрист, активно занимающийся проблемами на стыке инфотехнологий и права, заслужил в США авторитет «ведущего эксперта по законам роботехники». Существенно подкрепили этот статус профессора такие, в частности, факты. В период президентства Обамы именно Кало устроил и провел в Белом доме первый семинар по политике в области ИИ. После чего он же организовал аналогичные семинары для Национальной академии наук и для NSF, Национального научного фонда США, раздающего исследователям гранты, а затем – ещё и для спецслужбы DHS, то есть Департамента безопасности отечества. И вот теперь в свежем эссе про «Карту маршрутов ИИ» Райан Кало развернуто подытоживает свои исследования и популярно объясняет, о чем в действительности «следует беспокоиться политикам в отношении искусственного интеллекта». В частности, здесь всячески раскритикованы аргументы таких пророков катастроф и несчастий, как Илон Маск и Ник Бострём, Стивен Хокинг и уже упомянутый Макс Тегмарк. Реальное же беспокойство у тех, кто принимает решения, должно вызывать, по мнению Кало, недостаточное финансирование наиболее перспективных ИИ-проектов. Недостаточное по той причине, что необходимые средства и ценные человеческие мозги интенсивно отвлекаются на предотвращение несуществующих угроз, придумываемых фантазерами... ⇡#Сверхразум машин и заблуждения людейХотя разговоры о тех великих опасностях и рисках, которые несут с собой умные машины человечеству, ведутся уже не менее полутора сотен лет, на уровень особого накала подобные дебаты вышли в нынешнем десятилетии. И причина тому для всех, в общем-то, понятна – компьютерные системы искусственного интеллекта стали эволюционировать как никогда успешно. Причем не просто быстрыми, а очевидно ускоряющимися темпами.  Не то чтобы поворотным рубежом, но весьма заметным стимулом для разворачивания широких общественных дискуссий вокруг этой темы стала пара резонансных публикаций 2014 года – одна краткая и лаконичная, а другая объемная и обстоятельная. Что касается второй – книги оксфордского философа Ника Бострёма «Суперинтеллект» (Nick Bostrom, "Superintelligence"), то о ее базовых идеях, очевидно повлиявших на формирование позиции знаменитых ИТ-предпринимателей вроде Илона Маска и Билла Гейтса, логично говорить вместе с рассказом о заявлениях и деятельности этих людей. То есть чуть позже. Ну а здесь удобнее сосредоточиться на другом тексте 2014 года – совсем коротеньком, но отнюдь не менее значительном. Речь идет об опубликованном в Интернете открытом письме-призыве, получившем название «Преодолевая благодушие относительно сверхразумных машин» и подписанном группой известнейших в мире ученых-интеллектуалов: физиками-теоретиками Стивеном Хокингом и Максом Тегмарком, нобелевским лауреатом Фрэнком Вильчеком и специалистом по системам ИИ Стюартом Расселлом ("Transcending Complacency on Superintelligent Machines", by Stephen Hawking, Max Tegmark, Stuart Russell, Frank Wilczek). Есть все основания говорить, что новейшая книга Тегмарка «Жизнь 3.0» – это, по сути дела, развернутое обоснование, развитие и подтверждение жизненными примерами тех тезисов, что были сформулированы им и коллегами в кратком манифесте трехлетней давности. Написано же там – в вольном пересказе – примерно следующее. ⇡#Воспользоваться преимуществами, избегая рисковНа фоне многочисленных фантастических блокбастеров Голливуда у людей заметна тенденция не замечать опасность или вообще игнорировать идею прихода высокоразумных машин – просто как крайне далекую от жизни научную фантастику. Однако делать так было бы большой ошибкой. Ибо это потенциально может стать нашей наихудшей ошибкой за всю историю человечества.  Исследования в области искусственного интеллекта прогрессируют ныне чрезвычайно быстро. Недавно достигнутые вехи, такие как самоуправляемые автомобили, абсолютные победы компьютеров над человеком в шахматы и другие сложные игры-стратегии, цифровые персональные помощники с собственной речью, слухом и зрением – всё это лишь симптомы той гонки вооружений в ИТ-сфере, которая подпитывается небывало мощными инвестициями и выстраивается на постоянно набирающем зрелость теоретическом фундаменте. Так что нынешние достижения, скорее всего, станут выглядеть весьма скромно и бледно в сравнении с тем, что принесут грядущие десятилетия. Наши бесспорные успехи в создании ИИ могут стать величайшим событием человеческой цивилизации за всю её историю. Ибо потенциальные преимущества и блага здесь огромны – от прекращения всех войн до искоренения болезней и бедности. Но, к великому сожалению, это же величайшее достижение может также стать еще и последним значительным событием в нашей истории – если мы не научимся избегать уже понятных гигантских рисков. В терминах ближайшего времени, например, милитаристы многих стран мира всерьез рассматривают применение автономных систем оружия (также известных как роботы-киллеры), которые самостоятельно будут выбирать и уничтожать свои цели, включая и людей. И хотя ООН и правозащитные организации выступают за договор, тотально запрещающий такого рода вооружения, никаких барьеров для разработки этих вещей реально не существует. В терминах промежуточных целей столь же недалекого будущего, системы ИИ способны трансформировать нашу экономику не только для того, чтобы принести значительно большее благосостояние и богатство для всех, но и наоборот – чтобы очень существенно перераспределить эти богатства и ценности в ущерб большинству. Если же заглянуть в будущее еще чуть подальше, то там нет никаких фундаментальных пределов для того, что могло бы быть достигнуто на пути развития ИИ. Если формулировать иначе, нет никакого физического закона, который препятствовал бы сборке и организации частиц материи для выполнения вычислений и решения задач еще более продвинутых, нежели те, которые выполняются конфигурациями частиц в мозгах человеческих. В этих условиях возможен взрывной переход в возрастании мощи ИИ, причем машины со сверхчеловеческим интеллектом смогут неоднократно улучшать свою конструкцию и дальше – в исторической точке «сингулярности» сначала сравнявшись с разумом человека, а затем стремительно наращивая отрыв.  Сегодня, когда программы ИИ превосходят людей-профессионалов и в трейдинге на биржах, и в сложных играх-стратегиях, уже вполне можно представить такие технологии, которые способны перехитрить наши финансовые рынки, обогнать в изобретательности ученых и программистов, превзойти в манипуляциях массами всех политических лидеров человечества. И наконец, создать такие системы оружия, даже принцип работы которых мы понять уже не способны. На сегодняшний день у человечества есть специалисты, так или иначе активно занимающиеся разработкой ИИ по всем из перечисленных направлений. Но если краткосрочные эффекты в области ИИ зависят от того, кто управляет этими системами, то долгосрочные эффекты воздействия будут зависеть от того, можно ли нам будет вообще этими системами управлять... Итак, подводя итог и взирая на перспективы возможного будущего, сотканного из подобных невычислимых заранее преимуществ и рисков, можно было бы подумать, что ведущие эксперты в данной области наверняка делают всё возможное, чтобы обеспечить для нас наилучший выход из ситуации. Так ведь?.. Нет, не так. Если бы, скажем, превосходящая нас во всем инопланетная цивилизация прислала нам текстовое сообщение с такими примерно словами: «Мы прибудем к вам через несколько десятилетий», неужели же единственной нашей реакцией был бы такой ответ: «А, ну да, хорошо, тогда позвоните, когда сюда доберетесь, мы оставим включенными огни»? Увы, по сути это именно то, что происходит у нас сейчас с ИИ. Хотя мы уже вплотную подходим к наилучшим или наихудшим вещам, которые только могут произойти с человечеством, чрезвычайно мало серьезных исследований посвящено изучению этих проблем... Все мы – не только ученые, промышленники, политики и генералы – должны задаться вопросом: а что же мы можем сделать ныне для повышения наших шансов – дабы воспользоваться преимуществами и избежать рисков? ⇡#Слушать сведущих скептиков?За время, прошедшее с момента публикации манифеста ученых-интеллектуалов, к деятельности по «повышению наших шансов» в грядущей ИИ-революции активно подключились несколько весьма знаменитых и влиятельных людей. В первую очередь тут можно назвать имена Илона Маска, возглавляющего множество успешных компаний и ИТ-проектов, и Билла Гейтса. Последний хотя и давно отошел уже от дел в Microsoft, однако руководит самым крупным на этой планете благотворительным фондом, то есть вполне способен оказывать солидную финансовую поддержку исследованиям и инициативам в необходимых для человечества гуманитарных направлениях.  Тут же, впрочем, следует подчеркнуть и то, что влиятельных деятелей такого масштаба, как Маск или Гейтс, в лагере «ИИ-озабоченных» (назовем это так) пока что совсем немного. Ибо основная масса народа, как обычно, занимает безразлично-выжидательную позицию, ну а те люди, от решений и действий которых реально что-то здесь зависит, пока что озабочены куда более насущными вопросами. Вроде обеспечения научно-технического превосходства над врагами и конкурентами, привлечения инвестиций или управления финансовыми потоками, ну и так далее... Что же касается гипотетических угроз человечеству со стороны сверхразумного ИИ, то к данной теме отношение у таких людей скорее сдержанно-скептическое, а среди некоторых встречается и агрессивно-негативное. Выразителем же мнения скептического большинства вполне можно считать уже упомянутого профессора Райана Кало, который в своей новой работе «про карту маршрутов» пишет об этих вещах буквально следующее: Лично моя точка зрения такова, что ИИ не представляет никакой экзистенциальной угрозы для человечества, по крайней мере в сколь-нибудь обозримом будущем. Предприниматель Илон Маск, физик Стивен Хокинг и другие знаменитые личности очевидно верят в то, что ИИ – это величайшая для нас угроза на сегодняшний день. Наиболее частые цитаты на данный счет берутся из работы [шведско-]британского спекулятивного философа по имени Ник Бострём. В своей книге «Суперинтеллект» Бострём пытается продемонстрировать, что мы уже на пути к созданию такого ИИ, который значительно превосходит человеческий разум и в то же время с высокой вероятностью способен развернуться против своих создателей. Некоторые считают, что главная причина, по которой пророчества о неминуемом ИИ-апокалипсисе по большей части исходят от группы таких лиц, как Илон Маск, Стивен Хокинг и Ник Бострём, на самом деле проста. Все эти люди не имеют никакого формального образования в данной области... То есть логика аргумента тут совершенно ясна: опасаются ИИ-катастрофы люди в этом деле необразованные, всю глубину и сложность предмета просто не понимающие. Справедливости ради надо отметить, что и сам Кало, будучи профессиональным юристом, с готовностью признает, что не имеет формального образования в области систем искусственного интеллекта. Однако для подкрепления своих аргументов он постоянно цитирует мнения действительно авторитетных ИИ-специалистов.  Конкретно в данном случае привлекается широко растиражированная цитата из доводов Яна Лекуна (Yann LeCun), пионера особо эффективных алгоритмов глубокого обучения, последние годы возглавляющего ИИ-подразделение в мегакорпорации Facebook✴. Как и многие другие светила ИИ, Лекун убежден, что, даже если бы мы и смогли в конечном итоге создать искусственный сверхразум, все равно нет никаких причин полагать, будто он станет склоняться к мировому господству – до тех пор, пока это стремление по каким-то причинам не запрограммируем в систему мы сами. Как сформулировал это Лекун, «у компьютеров нет тестостерона»… В этом убойном аргументе как бы само собой подразумевается, что науке о разуме человеческом уже всё отлично известно — и про механизмы, толкающие людей к доминированию вообще, и про биохимическую роль гормона тестостерона в этом деле, в частности. Однако всем (даже неспециалистам), кто хоть что-то знает о реальных успехах науки в познании загадок человеческого разума, отлично известно, что на самом деле никакой ясности с этими вещами у нас пока и близко нет. Вне зависимости от того, как данная картина рисуется ИИ-авторитетами. ⇡#Или знать реальное положение дел?Реальная история научно-технических достижений человечества такова, что о чудовищных последствиях своих опаснейших затей – от отравляющих газов, напалма или противопехотных мин и вплоть до атомной бомбы – политики и ученые начинали всерьез задумываться лишь после того, как погибало гигантское количество невинных людей. В истории с приходом в нашу жизнь продвинутого ИИ ситуация впервые складывается так, что потенциальные риски понятны заранее и есть время для действий, упреждающих угрозу. Илон Маск, в частности, энергично подключился к этой деятельности примерно в том же 2014 году, когда в публичных выступлениях уподобил безответственных и особо напористых разработчиков ИИ тем людям, которые вызывают демонов, полагая, что смогут ими управлять. В 2015-м он присоединился к группе ИИ-специалистов, ученых и ИТ-бизнесменов, которые подписали коллективное открытое письмо, предупреждающее политиков и общество о реальности роботов-киллеров и о рисках затеваемой ныне гонки вооружений на основе систем ИИ.  Не ограничиваясь только словами, Маск оказывает финансовую поддержку проектам, предусматривающим разработку новых технологий ИИ на основе открытых исходных кодов. По его убеждению, это помешает поставить важную для всех технологию под контроль компаний-монополистов и обеспечит обществу более объективную картину происходящего. Тема контроля и осведомленности со стороны общества – это и непременный пункт в нынешних публичных выступлениях предпринимателя. В июле 2017-го, в частности, выступая на большом съезде губернаторов США, Маск особо подчеркнул, что намечающиеся реакции властей на ИИ-угрозы в обычной манере – то есть путем подготовки всяких регулирующих правил в ответ на уже случившиеся несчастья – окажутся слишком запоздалыми и неэффективными мерами. В данном случае, по его убеждению, властям надо действовать с упреждением, а первым шагом для правительств стало бы понимание того реального положения дел, которое уже имеется в нынешних исследованиях. «А вот как только такая осведомленность появится, люди будут в высшей степени напуганы, – сказал Маск. – Причем именно такая реакция окажется правильной, естественной и необходимой ...» В новостных публикациях СМИ, рассказывающих об этом и других похожих выступлениях Илона Маска, почему-то предпочитают не приводить конкретные примеры того, что именно тут имеется в виду. Хотя вполне жизненных примеров на данный счет известно достаточно, и один из них, в частности, выглядит так. В июне 2016 года группа ученых Университета Цинциннатти, работающая в сотрудничестве с Исследовательской лабораторией ВВС США (AFRL), с гордостью продемонстрировала новую систему искусственного интеллекта ALPHA для автономных роботов-истребителей. Система оказалась настолько хороша, что во всех боях на авиасимуляторах она уверенно побеждает летчиков-людей не только на равноценных самолетах, но и в заведомо невыгодных условиях – с меньшим запасом ракет или с худшей скоростью и маневренностью.  Для итоговых тестирований «Альфы» был привлечен настоящий ас, полковник американских ВВС Джин Ли (Gene Lee), имеющий огромный опыт военного летчика-истребителя и инструктора по воздушным боям. Во всех боях против программы, как летчик ни старался, ему так ни разу и не удалосьуничтожить противника. Системе ALPHA, напротив, каждый раз удавалось сбить его самолет. Пораженный ас, которому уже доводилось испытывать множество авиасимуляторов, признал: «Это наиболее агрессивная, тонко реагирующая, динамичная и серьезная система ИИ из всех, которые я когда-либо видел». Что касается технических аспектов программы, то ALPHA построена на основе «генетического нечеткого дерева», являющегося одним из подвидов в семействе алгоритмов нечеткой логики. Наилучший из всех алгоритм отыскивается тут путем их состязаний и скрещиваний друг с другом. А древовидная структура системы позволяет разбивать большие задачи на множество мелких, быстро отыскивая наилучшие решения с высоким уровнем грануляции. Есть некоторая ирония в том, что полковник Ли сам помогал отбирать лучшие версии для скрещивания разных алгоритмов. Об итогах же собственных контактов с конечным результатом такой ИИ-эволюции он сказал так: Я поражен тем, насколько умно и чутко данная система реагирует на ситуацию. Выглядит это так, словно она заранее знает о моих намерениях, мгновенно реагируя на любые мои маневры в полете и на пуски ракет. ALPHA знала, как парировать любой удар из всех, что я делал. И она мгновенно переходила от обороны к атаке – как это и требуется в бою... После этих испытаний я вернулся домой в состоянии полного физического изнеможения и морального опустошения. Интеллект тут хоть и искусственный, конечно, но это уже совершенно реальный вызов человеку...  ⇡#Между «Терминатором» и «Сингулярностью»В аналитическо-скептическом эссе Райана Кало, конечно же, имеется развернутый «ответ ИИ-специалистов» на все неубедительные для них примеры подобного рода. По их мнению, столь очевидные технологические успехи вовсе не ведут к появлению искусственного Сверхразума. Они уверены, что на самом деле просто не существует никакого маршрута к возникновению такого машинного интеллекта, который превосходил бы наш собственный во всех контекстах или областях жизнедеятельности. Да, конечно, машина, специально заточенная под конкретные задачи, может обыграть любого человека – даже чемпиона мира – хоть в шахматы, хоть в го, хоть в воздушный бой на авиасимуляторе. Но во всей нынешней литературе по машинному обучению, по методам быстрого поиска или по любым другим аспектам ИИ нет абсолютно ничего такого, что указывало бы на подходы к моделированию интеллекта в его полном объеме. Даже интеллекта какого-нибудь низшего млекопитающего, не говоря уже о человеческом разуме. Иначе говоря, раз у разработчиков таких знаний нет, то самостоятельно сверхразумный универсальный ИИ появиться просто не может... Что же касается возражений оппонентов на такого рода доводы, то их аргументы по двум основным линиям – о роботах-убийцах и точке интеллектуального превосходства машин – звучат примерно так. Когда сегодня люди бьют тревогу и выступают за полное запрещение роботов-убийц, называя их гигантской опасностью для самого существования человечества, то речь тут идет об угрозе абсолютно реальной – без всяких фантастических пока что сценариев с «восстанием машин». Великая опасность заключается в том, что автономные системы оружия не только существенно снижают психологический порог для начала войны, но и одновременно снимают вопрос об ответственности: кто теперь должен отвечать за преступные убийства невинных людей — начальник технопарка? программист алгоритмов? изготовитель машины? или, может, сам робот?  По этим причинам — настаивают сторонники разоружения — именно сейчас, пока еще не поздно, надо особым международным договором полностью запретить разработку и развертывание таких систем вооружений, где решение об атаке принимает не человек, а машина. Что же касается стремительно прогрессирующего интеллекта машин, то уже сейчас нас в изобилии окружают компьютеры, которые превосходят человека в шахматах и прочих играх, в вождении самолета и автомобиля, в финансовом трейдинге и медицинской диагностике, в распознавании лиц, речи и рукописного текста. Причем список этот с каждым днем становится все длиннее и длиннее. Если же одна линия роста неуклонно идет вверх, а другая линия все время остается по сути горизонтальной, то они с неизбежностью где-то пересекутся, если еще не пересеклись. В общих чертах уже даже ясно, когда примерно это должно произойти. Тот момент, когда компьютеры станут писать программы лучше, чем люди, станет и моментом истории, когда скорость технологического прогресса сместится от скорости человеческой мысли и человеческих коммуникаций к скорости работы компьютерных чипов. Это неуклонно приближающееся и по сути неизбежное событие обычно принято называть «технологической сингулярностью». После данной точки кривая развития будет направляться уже совершенно новой – нечеловеческой – динамикой. Соответственно, будущее наше становится для нас радикально непредсказуемым. Можно, конечно, благодушно полагать, что всякий разум, который превзойдет нас в своих возможностях, в общих чертах будет примерно таким же, как наш, – просто соображать будет значительно быстрее. Но есть тут один очень существенный и тревожный момент. Практически всё, что мы ценим как люди (любовь, счастье, даже личное выживание), имеет для нас такую важность из-за вполне конкретной эволюционной истории. Это история, которую мы разделяем с прочими высшими животными. Но не с «Жизнью 3.0» – то есть с компьютерными программами типа искусственного интеллекта. Иначе говоря, нет никаких причин считать, будто разумные машины станут разделять наши ценности. По той же логике, впрочем, нет и причин считать, что они станут к нам враждебны. Враждебность по природе своей — тоже эмоция животного. Однако с очень, очень большой вероятностью машины могут оказаться абсолютно к нам безразличны. Мы вполне можем представлять для них примерно то же, чем для нас являются мошки на ветровом стекле мчащейся машины.  Наглядности ради можно привести и еще более близкую аналогию. Достаточно посмотреть на горилл, которым поневоле приходится состязаться за ресурсы с наиболее разумными существами на этой планете. Причина, по которой гориллы как вид неуклонно вымирают, отнюдь не в том, что люди в целом к ним враждебны. Вовсе нет. Человек «просто» преобразует окружающую среду под свои нужды – таким образом, что она становится все более и более непригодна для выживания горилл... ⇡#Выбор путиНа протяжении всего обсуждения проблем с приходом в нашу жизнь продвинутых систем ИИ одна тема непременно оказывается как бы сквозной и присутствующей во всех аспектах – тема контроля. Кто и как контролирует ситуацию? Вполне очевидно, что людям как виду хотелось бы сохранить свои преимущества перед ИИ, то есть и впредь продолжать оставаться в роли принимающих решения и отдающих приказы, а не послушных исполнителей. Большая проблема – даже беда – заключается в том, что именно сегодня делается очень много шагов прямо в противоположном направлении. С каждым годом на машины-компьютеры вообще и на системы ИИ в частности возлагается все больше и больше функций по непрерывной слежке за людьми и по управлению их действиями... Об этой гранд-проблеме не раз содержательно высказывался Кори Доктороу – известный фантаст-футуролог, публицист и общественный деятель. В качестве финала имеет смысл привести здесь краткую компиляцию его основных тезисов по данному поводу. В той или иной форме они непременно всплывают и в аргументах множества других умных людей. С каждым годом человек все больше и больше погружает себя в мир компьютеров. Уже сегодня мы не только постоянно работаем и общаемся с компьютерами/смартфонами, отчего они знают все о том, что и когда мы делаем, с кем контактируем, что смотрим или где бываем. Те, кто ездят на автомобилях, перемещаются, по сути, внутри самоходного компьютера. Те, кто живет или работает в современных зданиях с автоматикой, управляющей освещением и кондиционированием воздуха, обитают фактически внутри домов-компьютеров. Более того, все больше разных компьютерных имплантов встраивается внутрь человеческого организма – для замены или улучшения работы жизненно важных органов.  И вот на всем этом фоне естественного слияния миров человека и компьютера уже довольно давно обозначилась одна серьезнейшая проблема. Поначалу ее воспринимали как раздражающую бытовую мелочь – когда DVD-плеер, скажем, не позволял владельцам проматывать рекламу в начале фильма. Или отказывался воспроизводить фильм с диска, имеющего «не тот» код географического региона. Ну а затем, по мере того, как наши компьютеры становились все умнее, запреты начали нарастать как снежный ком. Теперь сплошь и рядом встречаются ситуации, когда компьютер не дает хозяину зайти на «неправильный» веб-сайт, скачать «не те» программы или файлы, установить «не ту» операционную систему и тому подобные уже отнюдь не мелочи. Попутно происходит и еще одна очень нехорошая вещь. Мало того, что техническими хитростями «обходить» все эти запреты хозяевам аппаратов становится все более сложно и хлопотно, так еще и госвласти принимают неумные законы, которые не только запрещают владельцам компьютеров распоряжаться своими собственными вещами, но и объявляют преступлением «хакинг» в самом широком смысле. Хакинг как любую деятельность, связанную с изготовлением, распространением и применением средств, позволяющих делать с компьютерами то, что надо их владельцам, а не то, что им прикажут некие «инстанции» (коррумпированные, жадные, лживые – перечень тут длинный)... Суть же проблемы такова, что именно сейчас человечество со своими компьютерами оказалось на развилке двух очень разных дорог. Одна ведет нас в светлое будущее тех научно-фантастических романов, где благодаря техническому прогрессу и мудрости своих лидеров человечество сумело, наконец, решить все глобальные проблемы. И с помощью компьютеров мы начали наконец-то жить по-людски. Но в этом сценарии принципиально важно, чтобы всякий компьютер, когда он получает команду от человека, реагировал бы лишь единственным образом: «Задание понял, приступаю к выполнению» (или в особо серьезных ситуациях для гарантии может переспросить: «Вы точно уверены?»). А вот вторая дорога совершенно определенно ведет нас к катастрофе. Ну какое будущее может быть у мира, где компьютеры на каждом шагу могут заявить своим хозяевам: «Извините, а вот это делать вам запрещено!» — и при этом беспрекословно выполняют любые команды незримой «высшей инстанции» или просто непрерывно шпионят за владельцами-людьми? Вопрос в финале, ясное дело, чисто риторический. Но почему-то именно это будущее нам очень упорно пытаются навязать... # # # Дополнительное чтение в тему:

⇣ Содержание

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

|

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |